∑ ∑

Anuncio

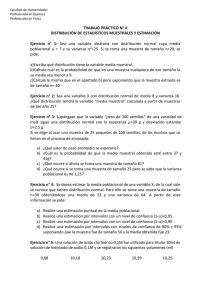

Modelos lineales en Biología, 5ª Curso de Ciencias Biológicas Clase 28/10/04 Estimación y estimadores: Distribuciones asociadas al muestreo Referencias: Cualquiera de los textos incluidos en la bibliografía recomendada En este tema se aplicarán algunos de los conceptos relativos a probabilidad que se han visto hasta ahora, pues se trata de encontrar funciones de los datos procedentes de una muestra que sirvan para estimar algunos de los parámetros poblacionales más importantes. 1.- Estadísticos y estimadores. Definimos Estadístico como cualquier función de los datos de una muestra. Cada valor de una función definida a partir de las medidas de una muestra depende de la muestra que en cada caso se haya elegido. Si la muestra es aleatoria, cualquier estadístico es una variable aleatoria y como tal, tendrá una distribución. Dedicaremos este tema a hablar de las distribuciones de algunos estadísticos muy usados en experimentación. Frecuentemente nos interesa conocer algún dato de una población, por ejemplo: ¿qué proporción de personas votará una determinada opción política?, o ¿Cuál es la talla media de esta comunidad?. En muchas ocasiones el dato que pretendemos conocer es, además, algún parámetro de una distribución. Por ejemplo, respecto de la opción política, podemos considerar toda la población dividida en dos grupos: los que votan la opción en estudio y los que no lo votan; podemos representar la situación mediante una variable aleatoria que tomará los valores 1, si eligen la opción de interés, y 0 si no la eligen. Esta situación quedará modelada por la distribución binaria, cuyo único parámetro es la proporción p que queremos conocer. Se tratará de elegir una muestra y encontrar la función de la muestra que mejor estime el dato poblacional requerido. Definimos Estimador como cualquier estadístico que sirva para evaluar un dato poblacional a partir de los de una muestra. Todos los estimadores son variables aleatorias y siguen algún modelo de distribución, comentaremos los más importantes a lo largo del tema. Representaremos con la letra griega θ un parámetro poblacional genérico, con el mismo símbolo con circunflejo, su estimador: θˆ . El estimador de la proporción p es p̂ ; el de la media µ es µ̂ ;y el de la varianza σ2 es σˆ 2 . Existen varios procedimientos para determinar estimadores, algunos de ellos son: el de analogía, el de máxima verosimilitud, el de mínimos cuadrados y otros. Nosotros definiremos estimadores por analogía: tomaremos como estimador de un parámetro poblacional su propia definición aplicada a la muestra: Estimador de una proporción: La proporción se estima en la muestra contando el numero de individuos que presenten la característica que se estudie y dividiéndolo entre el tamaño de la muestra: n Sea una muestra de tamaño n, y de ellos n a presentan la característica en estudio, entonces p̂ = a n Estimación de una media: utilizaremos la media muestral como estimación de la poblacional. Sea una muestra de tamaño n y una característica cuantitativa X cuyas medidas en los individuos de la n muestra han resultado ser x1 , x2 ,....,x n , entonces µˆ = x = ∑x i i =1 n Estimación de una varianza: se utiliza la cuasivarianza muestral para estimar la varianza poblacional: n σˆ 2 = s 2 = ∑(x i =1 − x) 2 i n −1 Estimación de parámetros, pág 1 En ocasiones observaremos el parámetro p como la media de una distribución binaria: puesto que la variable aleatoria solo puede tomar los valores 1 (acierto) y 0 (fallo), el número de aciertos es también la suma de todos los valores de la variable observados en la muestra, y al dividir la suma de todas las observaciones entre el número de ellas, tendremos la media muestral. El parámetro λ de una Poisson es su media, por lo que para estimarlo también podremos considerarlo como una media. 2.- Propiedades de los estimadores: Insesgadez: la principal característica que debe cumplir un estimador es que estime lo que realmente se pretende estimar, o sea, al repetir muchas veces la estimación, se obtenga como promedio un valor muy próximo al que se desea estimar: E( θˆ )=θ . Un estimador que cumpla esta propiedad se dice que es insesgado, en caso contrario se le denomina sesgado. • La media muestral es un estimador insesgado de la media poblacional, pues E(x) = µ . • La varianza muestral no es un estimador insesgado de la varianza poblacional, ya que: n −1 2 σ , por ese motivo se usa como estimador de la varianza poblacional la cuasivarianza n que sí es insesgado. E(s 2 ) = Eficiencia: todo estimador es una variable aleatoria, y, como tal, tendrá una media y una varianza, un estimador es tanto más eficiente cuento menor sea su varianza, pues la variabilidad implica poca seguridad en que la estimación sea correcta, desde ese punto de vista, lo ideal sería que la variabilidad fuese nula. La eficiencia siempre se define en relación a otro estimador del mismo parámetro, un estimador es más eficiente que otro si tiene menos varianza. Existe un valor mínimo de la varianza de un estimador insesgado, es la denominada cota de Frèchet-Cramer-Rao, si un estimador insesgado alcanza esta cota, decimos que es eficiente. Suficiencia: un estimador es suficiente si contiene toda la información muestral relativa al parámetro que se desea estimar. La media muestral es un estimador suficiente, pues se usan todos los datos de la muestra en su cálculo. Conocida la media muestral, el disponer de todos los datos de la muestra no mejora mi información referente a la media poblacional. Consistencia: un estimador es consistente si la probabilidad de encontrar valores estimados distintos a los que se desea estimar es muy baja (por poco que se diferencien los valores estimados de los que se pretenden estimar) cuando el tamaño de la muestra es muy grande. Los estimadores basados en una media muestral son insesgados, eficientes y suficientes. 3.- Distribuciones en el muestreo: a) Distribución de la media muestral: a.1) Variable aleatoria X es una Normal (µ µ ; σ 2). Extraida una muestra de tamaño n, con las observaciones x1 , x2 ,...xn . Al considerar todas las posibles muestras, cada observación toma los valores de la variable aleatoria X y su misma densidad, la suma de n variables aleatorias Normales, todas ellas con la misma media y varianza es una variable aleatoria Normal, cuya media es nµ y cuya varianza es nσ2, portanto, aplicando las propiedades de la esperanza matemática, podemos comprobar que la media X sigue una distribución de media µ y varianza σ2/n. . Además, al ser Normal la población de la que se extrae la muestra, la media muestral sigue también una distribución Normal: Si Xà N(µ;σ2)⇒ X à N(µ;σ2/n) − Al tipificar la media muestral: Z = X− µ σ2 n → N(0;1) Estimación de parámetros, pág 2 Con frecuencia no se conoce la varianza poblacional, entonces se estima con la cuasivarianza poblacional, pero al tipificar, lo que se obtiene no es lo mismo que antes: t = X −µ → t(n − 1) s2 n Cuando los datos proceden de una variable Normal , la media de todas las medias muestrales sigue una distribución Normal, si se tipifica con la desviación típica poblacional, la media tipificada sigue una Normal (0;1). Pero si se tipifica con la cuasidesviación típica, sigue una distribución t de Student con n-1 grados de libertad . a.2) La variable aleatoria X No es una Normal: Entonces la distribución de la media muestral depende de la distribución de la variable original. No obstante, para muestras grandes : n>30 (Teorema Central del Límite), se puede asegurar que la distribución de la media muestral es muy aproximadamente una Normal de media la de X y de varianza la de X dividido por el tamaño muestral. Si la varianza muestral es desconocida NO SE PUEDE UTILIZAR LA DISTRIBUCIÓN t, pues falla el supuesto de Normalidad, por ello se comete menos error utilizando la distribución Normal y tomando MUESTRAS DE TAMAÑO SUPERIOR A 60. b) Distribución del estimador del parámetro p de una distribución binaria: Si de una distribución binaria tomamos una muestra de tamaño n y contamos el número de aciertos, na, el cociente na/n estima la proporción de aciertos en la población. Considerando la variable aleatoria número de aciertos observados en la muestra de tamaño n, esta variable , si la extracción fue independiente, sigue una distribución binomial, de parámetros n y p: na à b(n;p) También se puede considerar que los valores posibles de la variable aleatoria de partida (binaria con media p y varianza pq) son 0 y 1, por lo tanto las observaciones muestrales solo tendrán estos valores, la suma de todas las observaciones muestrales coincide con el número de aciertos y por lo tanto, na/n puede ser considerado como una media, por lo que según el Teorema Central del Límite (T.C.L.) , si la muestra es grande: X à N(µ;σ2/n)=N(p; pq/n) c) Distribución del estimador del parámetro σ2 de una distribución Normal: Si X es una variable aleatoria N(µ;σ2) y desconocemos la media y la varianza poblacional, podemos estimar ésta con la cuasivarianza poblacional: 2 n 1 n 2 x −x (n − 1)s2 sigue una distribución Chi( xi − x ) , se puede demostrar que el estadístico ∑ i = ∑ σ n − 1 i= 1 σ2 i =1 cuadrado con n-1 grados de libertad. Esto significa que al tipificar respecto de la varianza poblacional, cada sumando es el cuadrado de una N(0;1) , y la suma de todos ellos una Chi-cuadrado, pero todos los sumandos no son independientes, ya que la suma de todas las observaciones ha de ser tal que se obtenga la media x observada. Si fijamos este valor de la media muestral y dejamos que varíen libremente las observaciones, solo hemos de calcular n-1, pues la última viene obligada. Por lo tanto, el número de grados de libertad de la distribución Chi-cuadrado es n-1 (el mismo número que se utiliza como denominador del cálculo del estimador de la varianza). s2 = d) Distribución del cociente de las los estimadores de las varianzas de dos distribuciones Normales independientes: (n −1)s 2 sigue una σ2 distribución Chi cuadrado con n-1 g.l., calculado cada uno de ellos en su respectiva muestra, el estadístico: En ocasiones hay que comparar las varianzas de dos distribuciones Normales, como el estadístico Estimación de parámetros, pág 3 ( n1 − 1) s12 σ 12 (n1 − 1) (n2 − 1) s22 σ 22 ( n2 − 1) s12 = σ12 s22 sigue una distribución F de Snedecor con n1-1 y n2-1 grados de libertad respectivamente. σ 22 4.- Estimación por punto y por intervalo: Cuando realizamos una estimación de un parámetro aplicando el estimador correspondiente, damos un valor como estimación del parámetro poblacional, entonces decimos que hemos realizado una estimación por punto. Con frecuencia hay que plantearse qué tan segura es esa estimación: ¿Qué probabilidad hay de que el valor que se ha dado como estimación coincida con lo que realmente se desea estimar?. Supongamos el caso de una distribución binaria cuyo parámetro p sea realmente 0.4, que por el momento es desconocido y tomamos una muestra de tamaño, n=5, ¿qué probabilidad hay de que se obtenga na=2 para que el p estimado sea 0.4? 5 P(X = 2) = 0.4 2 0.6 3 = 0,3456 2 Esto nos dice que en solo 34.5 de cada cien veces que tomásemos esta muestra estimaremos correctamente el parámetro poblacional (en más del 65% de los casos realizaremos una estimación incorrecta). ¿Qué decir si la variable de partida fuese contínua?. Por ello una estimación por punto es poco informativa de la calidad de esa estimación y se prefiere dar un intervalo de valores entre los cuales esperamos esté incluido el valor estimado con una cierta probabilidad, es la estimación por intervalo. Para realizar una estimación por intervalo es preciso conocer la distribución del estimador que se usa y, a partir de ella, construir un intervalo de confianza. Veámoslo con un ejemplo: a) Estimación por intervalo de la media de una variable Normal . Realizar una estimación por intervalo es encontrar los extremos a y b de un intervalo que esperamos contenga la media poblacional con una probabilidad que nosotros fijamos de antemano y que denominamos, nivel de confianza, sea este nivel 1α, entonces será : P(a < µ ≤ b) =1-α Nosotros sabemos que si la variable de partida es Normal, la media muestral es una Normal de media la poblacional y varianza la poblacional dividida por el tamaño muestral: − X à N(µ;σ /n) ⇒ Z = 2 X− µ σ2 n → N(0;1) Se puede encontrar dos valores: a y b tales que la probabilidad de que Z tome valores comprendidos entre ellos sea un valor dado 1-α, P(a<Z≤b) = 1-α . En realidad hay infinidad de posibles valores a y b y por eso se suelen tomar tales que la probabilidad de que Z sea menor que a sea igual a la probabilidad de que Z sea mayor que b, y ambas probabilidades igual a α/2 Como al distribución Normal es simétrica respecto de su media, en el caso de una N(0;1), dos abcisas a y b que delimiten colas de igual probabilidad verifican que |a| =| b|, por lo que solo hay que buscar el cuantil zα /2 de la Normal(0;1) Estimación de parámetros, pág 4 α/2 Entonces: P( − zα / < x −µ σ2 n α/2 ≤ zα ) = 1 − α , quitando denominadores dentro del paréntesis: σ2 σ2 P −zα / 2 < x − µ ≤ zα / 2 = 1 − α , restando x : n n σ2 σ2 P − x − zα / 2 < − µ ≤ −x + zα / 2 = 1 − α , cambiando el signo y el sentido de la desigualdad dentro del n n paréntesis: σ2 σ2 P x − zα / 2 < µ ≤ x + zα / 2 =1 −α n n Supongamos una variable aleatoria de la que sabemos que sigue una distribución Normal, de media desconocida y varianza conocida =4. Para estimar la media poblacional tomamos una muestra de tamaño 10 y calculamos la media muestral , que resulta ser 30. La estimación por punto será x =30. σ2 σ2 Por lo tanto, el intervalo buscado es: x − zα / 2 < µ ≤ x + zα / 2 n n Para este ejemplo, si se desea que 1-α =0.90, el cuantil buscado es el que deja a su derecha un área de 0.05, para que su simétrico deje un área a su izquierda de 0.05. En las tablas de la Normal(0;1), podemos encontrar que el cuantil buscado es 1.64, por lo que : σ2 σ2 4 4 I1−α = x − zα /2 < µ ≤ x + zα / 2 = 30 − 1.64 ; 30 +1.64 = ( 28.963;31.037 ) n n 10 10 Podemos afirmar que la media poblacional es un valor comprendido entre 28.963 y 31.037 con un grado de confianza del 90%. Estimación de parámetros, pág 5 Nótese que se habla de confianza en lugar de probabilidad: una vez tomada la muestra, todos los datos requeridos para construir el intervalo son conocidos y podemos construirlo. Este intervalo ya ha sido fijado y contendrá o no a la media poblacional. Solo podemos afirmar que de repetir el proceso muchas veces, tendríamos que, en promedio, 90 de cada 100 de los intervalos que así se constuyan contendrán a la media poblacional, y "confiamos" en que este sea uno de esos 90. Si la varianza poblacional fuese desconocida, todo sería semejante, cambiando varianza poblacional por cuasivarianza muestral y la distribución Normal por una t de Student con n-1 grados de libertad. Para el ejemplo actual, si 4 es la cuasidesviación típica: s2 s2 4 4 I1 −α = x − t ( n −1 ) ,α / 2 < µ ≤ x + t (n −1) α / 2 = 30 − 1.833 ; 30 +1.833 = ( 28.841;31.159) n n 10 10 Lógicamente, cuando valor de la varianza estimada coincide con la varianza poblacional (desconocida), al desconocer la varianza poblacional se obtiene un intervalo más amplio para tener la misma confianza de recubrir la media, pues el grado de desconocimiento es mayor. b) Estimación por intervalo de la media de una variable que no sabemos si sigue una ley Normal. En este caso solo podemos tomar muestras grandes y aplicar el T.C.L.. Si la varianza poblacional es conocida, el tamaño muestral solo debe ser superior a 30, mientras que si la varianza poblacional es desconocida, el tamaño ha de ser superior a 60. En ambos casos se debe usar la distribución Normal y no la t , ya que por no cumplirse el supuesto de normalidad, el error cometido al utilizar la t de Student es superior al que se comente manteniendo la Normal. Los resultados son solo aproximados, tanto más cuanto mayor sea la muestra: σ2 σ2 I1−α ≈ x − zα / 2 < µ ≤ x + zα / 2 n n I1−α ≈ x − zα / 2 s2 s2 < µ ≤ x + zα / 2 n n con n >30 con n >60 c) Estimación por intervalo del parámetro p de una distribución binaria: Si se toma una muestra de tamaño n de una distribución binaria de parámetro p desconocido, podemos contar el número de aciertos de la muestra para estimar p. Esta cantidad es una variable aleatoria que sigue una distribución binomial de parámetros n conocido y p desconocido. Si se supone que la estimación por punto de p es una buena aproximación de su valor poblacional, se podrá calcular las probabilidades asociados a los distintos valores de los posibles x de una distribución ˆ y sumar P(X=0)+P(X=1)+.... hasta encontrar una tal que la suma esté lo más próximo posible a α /2, supongamos b(n;p) que esta sea xa . Del mismo modo se puede proceder por el extremo superior: P(X=n)+P(X=n-1)+.... hasta encontrar un xb que haga que la suma sea lo más próximo posible a α /2,entonces, como: p̂ = n a / n , el intervalo será: xa xb ; ) aunque, como la probabilidad es discreta, el nivel 1-α deseado casi nunca se alcanza exactamente. Este n n procedimiento tiene una objeción grave y es que para construir una estimación del parámetro poblacional ha de hacer uso de este parámetro, que es desconocido y se utiliza el valor de p estimado. Otro procedimiento consiste en determinar los valores p1 y p2 del siguiente modo: p1 es la proporción que se ha de utilizar en una distribución binomial b(n ; p1) para que la probabilidad de obtener na o más aciertos sea 1-α /2 y p2 es la proporción que se ha de utilizar en una distribución binomial b(n ; p2) para que la probabilidad de obtener na o menos aciertos sea α /2 pq En el caso de que el tamaño muestral sea grande, se puede usar la aproximación de la Normal: p̂ → N p; , el intervalo n de confianza será: I1 −α = ( pq , el inconveniente es que el intervalo para p vuelve a quedar en función de p, por eso se suele sustituir los n p y q de dentro de la raíz por sus estimaciones muestrales: p = pˆ ± z α / 2 Estimación de parámetros, pág 6 ˆˆ pq n Esta fórmula solo es aplicable si el tamaño muestral es tal que tanto el número de "aciertos" como el de "fallos" sean mayor que 20. Además habría que incluir una corrección por continuidad debida al hecho de aproximar una distribución discreta (con valores para probabilidades puntuales) por una contínua, en la que la probabilidad asociada a un solo punto es nula. En el caso de que no se alcance este tamaño de muestra, se puede calcular el intervalo a partir de la fórmula inicial: p = pˆ ± z α / 2 p(1 − p) n En la que se ha sustituido q por 1− p, como el resto de cantidades son conocidas, tenemos una ecuación irracional en p, que se resuelve aislando el término irracional, elevando al cuadrado: p = pˆ ± z α / 2 2 pq = zα / 2 n y resolviendo la ecuación de segundo grado que se obtiene. Las raices de dicha ecuación son los extremos del intervalo pedido. Existen otras expresiones para la estimación por intervalo de proporciones, que no se verán aquí, (ver Martín Andrés, 1994). (p − pˆ )2 d) Estimación por intervalo de una varianza de una variable aleatoria Normal En el caso de la varianza, si la variable de la que se toma la muestra sigue una distribución Normal N(µ ; σ2 ) sabemos que el (n −1)s 2 estadístico sigue una distribución Chi-cuadrado con n-1 g.l., puesto que esta distribución toma valores a partir de σ2 cero y no es simétrica, tendremos que determinar a partir de las tablas de esta distribución los cuantiles χ21-α/2 y χ2α/2 que dejan a su derecha un área 1-α/2 y α/2, respectivamente, entonces: (n − 1)s 2 P χ12−α / 2 < < χα2 / 2 = 1 − α al despejar la varianza poblacional hay que invertir los signos de la desigualdad, y 2 σ ( n −1 ) s 2 ( n −1 ) s 2 el intervalo de confianza es: I1−α = ; χ2 χ12−α / 2 α/2 Estimación de parámetros, pág 7

![( ) ( )2 ( )[ ] ( )ξ ( ) PQ](http://s2.studylib.es/store/data/006099496_1-61f82d8b006ba0985f60bbb263d08047-300x300.png)