Facultad de Filosofía y Letras, UNAM

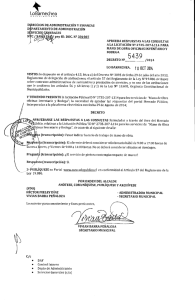

Anuncio