ENE-FEB 2007

Anuncio

• Análisis de ROI

• POJOs y

Frameworks Ligeros

• Evaluación de

Arquitecturas

Software Guru CONOCIMIENTO EN PRÁCTICA

Año 03 No.01 • Enero-Febrero 2007 • www.softwareguru.com.mx

ESPECIAL

Desarrollo de

Software en

Universidades

[ ENTREVISTAS ]

Desde Creanimax

Bill Plympton

René Castillo

Ernesto Gálvez

Desarrollo de

Videojuegos

¿Por dónde comenzar?

México, $65.00

Noticias • Eventos • Fundamentos • UML • Infraestructura • Reflexiones

[ Novedades ]

WCF

// CONTENIDO

directorio

Dirección Editorial

Pedro Galván

Dirección de Operaciones

Mara Ruvalcaba

Coordinación Editorial

Susana Tamayo

Asesoría Editorial

Edgardo Domínguez

Arte y Diseño

Dafne Ortega

Oscar Sámano

Consejo Editorial

Francisco Camargo, Ralf Eder, Raúl Trejo,

Guillermo Rodríguez, ITESM-CEM;

Hanna Oktaba, UNAM-AMCIS;

Luis Cuellar, Softtek;

Luis Vinicio León, e-Quallity - ITESO.

Editorial

Quizá muchos de ustedes se vean sorprendidos con la portada de esta edición,

la número13 de SG, la primera del año que

apenas comienza. Y es que para abrir este

2007, decidimos enfocarnos en un tema

que está de moda: los videojuegos. Al

igual que todos los temas que abordamos,

hemos buscado hacerlo desde la perspectiva no de usuarios, sino de creadores. Por

otra parte, escoger este tema nos permitió tomarnos algunas libertades no sólo

en el diseño, sino también en los contenidos. Consideramos que este número

tiene un buen balance de temas y niveles

de profundidad. Tenemos desde artículos

amigables que van dirigidos al público en

general, hasta los muy clavados que son

para nuestros fieles gurús. Tal vez por

error llegue a haber algunos despistados

que tomen esta revista pensando que encontrarán información sobre los últimos

juegos y consolas. Al principio se llevarán

una desilusión, pero estamos seguros que

se les pasará cuando descubran que aquí

hay información para aprender a desarrollar sus propios juegos.

Además del desarrollo de videojuegos,

tenemos un artículo especial que recalca

la importancia y necesidad de los centros

de desarrollo de software en las universidades. Consideramos que estos centros

son vitales para generar los profesionistas de software que necesitamos. Com-

02

ENE-FEB 2007

plementamos todo esto con las opiniones

de nuestros columnistas, que ya son parte fundamental del contenido; echaremos

un vistazo por Windows Communication

Foundation, que es uno de los pilares de

Windows Vista; veremos cómo determinar el ROI de un esfuerzo de mejora de

procesos, y también conoceremos sobre

los famosos POJOs. Vale la pena hacer un

paréntesis para mencionar que durante

todo el tiempo que estuvimos haciendo

este número, cada que se mencionaba

el término POJO, Susana no podía evitar

pensar en cierta ave de color amarillo.

Mientras editábamos los textos de este

número, llegamos a la conclusión de que

tienen un dejo de nostalgia, porque la mayoría de los colaboradores que participaron,

hacen referencias al pasado, a su juventud.

En realidad, queremos llegar tanto a los jóvenes que apenas comienzan como a todos

aquellos que crecieron mirando la evolución

de un mundo que hoy nos ha rebasado.

Equipo Editorial

FE DE ERRATAS:

Queremos pedir una disculpa porque en el número

anterior Jorge Palacios escribió el reportaje del Cluster

FidSoftware y no apareció su crédito; por otra parte, el

subtítulo en la columna de Hanna Oktaba debió decir:

International Process Research Consortium (IPRC).

Colaboradores

Ariel García, Sergio Orozco,

Luis Daniel Soto, Jaime Sánchez,

Marco A. Dorantes, Jorge Palacios, Joaquín

Arellano, Carlos Gutiérrez, Oscar Guillén,

Angélica Su, Alfredo Calvo, Ixcoatl Pérez, Omar

Gómez, Ana Vázquez, Mario Gutiérrez, Haarón

González, Charlie Macías, Emilio Osorio,

Consuelo Jiménez, Joel Villagrana.

Ilustración de Portada

www.tollhaus.com.mx

Ventas

Claudia Perea

Marketing

Natalia Sánchez

Circulación y Subscripciones

Daniel Velázquez

Contacto

info@softwareguru.com.mx

+52 55 5239 5502

SG Software Guru es una publicación bimestral editada por Brainworx S.A. de C.V., Malinche no. 6, Col.

El Parque, C.P. 53398, Naucalpan, México. Prohibida

la reproducción total o parcial del contenido sin previo

aviso por escrito de los editores. Todos los artículos son

responsabilidad de sus propios autores y no necesariamente reflejan el punto de vista de la editorial. Reserva

de Derechos al Uso Exclusivo: 04-2004-090212091400102. Certificado de licitud de título: 12999. Certificado

de licitud de contenido:10572. ISSN: 1870-0888. Registro Postal: PP15-5106. Se imprimió en diciembre de

2006 en Litográfica Roma. Distribuido por Rrecca Comercializadora y Sepomex.

www.softwareguru.com.mx

24

contenido

ene-feb 2007

EN PORTADA

Desarrollo de Videojuegos

Nuestro artículo de portada en esta ocasión,

abarca desde los primeros pasos hacia la

creación de videojuegos hasta un amplio

panorama de esta industria y la oportunidad

que representa para nuestro país.

Productos

LO QUE VIENE

12

IBM Rational SDP, Apache Axis 2, JBoss

Seam y Unity3D NOVEDADES

14

Windows Communication Foundation

Especial

Centros de Desarrollo de

Software en Universidades Columnas

Tejiendo Nuestra Red 08

por Hanna Oktaba y Ana Váquez

Cátedra y Más

por Mario Gutiérrez

46

Mejora Continua

por Luis Cuellar

10

Tierra Libre

por Emilio Osorio

48

Tendencias en Software

por Luis Daniel Soto

44

16

Prácticas

MEJORA DE PROCESOS Análisis de ROI

36

La mejora de procesos requiere una inversión

significativa de recursos. Alfredo Calvo y Angélica

Su nos explican cómo estimar el ROI.

DISEÑO

POJOs y Frameworks Ligeros

38

Ixcoatl Pérez nos muestra cómo combinar POJOs

con frameworks como Spring e Hibernate, para

desarrollar aplicaciones empresariales.

ARQUITECTURA

40

Evaluación de Arquitectura de Software

Omar Gómez nos enseña a evaluar arquitecturas

para determinar si cumplen con los requerimientos.

En Cada Número

20

Entrevista

Bill Plympton, René Castillo, Ernesto Gálvez

www.softwareguru.com.mx

Noticias y Eventos

CLÚSTERS

UML

Fundamentos

INFRAESTRUCTURA

REFLEXIONES

04

06

42

50

52

56

ENE-FEB 2007

03

// NOTICIAS

Oracle Open World

Del 22 al 26 de octubre, los más innovadores desarrollos

en tecnología, aplicaciones y soluciones desfilaron por el

Centro Moscone de San Francisco, California, durante el

Oracle OpenWorld 2006.

En un imponente ambiente de alrededor de 41 mil participantes de todo el mundo, se llevaron a cabo más de 1,400

sesiones en torno a las principales aplicaciones de Oracle, 400 demos en vivo de desarrolladores, conferencias

a cargo de importantes usuarios y ejecutivos de Oracle, y

una Expo con más de 300 expositores. Durante el evento,

como noticia principal y sorpresa para muchos, Oracle

anunció que dará soporte total a estándares abiertos, por

medio del programa llamado Unbreakable Linux.

Lanzamiento de Windows Vista

El pasado 29 de noviembre se realizó la presentación de Windows Vista y Office 2007, dedicada a los desarrolladores de

software y profesionales de TI. Dicho evento se realizó en el

World Trade Center de la Ciudad de México, y resaltó por su

magnitud y variedad. La gran sorpresa fue que la conferencia

de arranque la impartió Jesús Ramírez, Director Técnico de la

Selección Sub 17 de futbol, actuales campeones mundiales.

Su plática estuvo enfocada en el poder de la mente cuando

se aplica de manera correcta, y en la importancia del trabajo

en equipo. Posteriormente se llevaron a cabo sesiones para

ahondar en los distintos detalles de esta nueva versión, y el

nuevo modelo de desarrollo de aplicaciones que introduce.

Toman Protesta los Miembros de

la Mesa Directiva de la ANIEI

El pasado 12 de diciembre, en las instalaciones de la Rectoría de la UAM, se llevó a cabo la toma de protesta de los

miembros de la Mesa Directiva de la Asociación Nacional

de Instituciones de Educación en Informática (ANIEI). Para

su periodo 2006 - 2008, la Lic. Ma. de Lourdes Sánchez, por

segunda ocasión, estará a cargo de la presidencia de esta

asociación. La ANIEI ha fungido como pieza fundamental

en la vinculación Industria-Academia-Gobierno, ya que entre sus principales objetivos está el ejecutar la estrategia

2 del programa PROSOFT, enfocada en diseñar el modelo

paracurricular de Desarrollador de Software, Ingeniero de

Software, Arquitecto, y Administrador en Proyectos, así

como adecuar los modelos educativos relacionados con la

informática, tareas clave para el esperado crecimiento de la

industria de software en México.

04

ENE-FEB 2007

www.softwareguru.com.mx

// EVENTOS

13 al 16 Febrero 2007

27 Febrero al 2 Marzo 2007

Congreso Nacional de Software Libre

Facultad de Ingeniería UNAM, Cd. de México

Info: www.consol.org.mx

Email: consol@consol.org.mx

Expo Comm 2007, Von Conference & Expo, Expo Móvil

Centro Banamex, Cd. de México

Info: www.expocomm.com.mx

Tel: (55) 1087-1650 ext. 1160

Email: marcela@ejkrause.com

27 Febrero 2007

22 al 24 Marzo 2007

Select

Centro Banamex, Cd. de México

Info: www.select.com.mx

Tel: (55) 5256 1426

Email: liliana.garcia@select.com.mx

Centro de Investigación en Matemáticas (CIMAT)

Hotel Real de Minas, Guanajuato, Gto.

Info: www.cimat.mx/Sitios/seissigma

Email: seissigma@cimat.mx

CONSOL 2007

Tendencias 2007

Softtek, Única Empresa Privada que

Opera dos Centros CMMI5 y uno CMM5

en América Latina

Softtek concluyó con éxito la valoración en CMMI 5 de sus Centros de

Entrega de Servicio Near Shore en Aguascalientes y México D. F. Estos

se suman al Centro en Monterrey, que fue evaluado CMM 5 en 2004.

Blanca Treviño, Presidente y CEO de Softtek comentó: “El contar con

una red de Centros certificados en los más altos niveles de CMM,

proporciona cuantiosos beneficios a nuestros clientes en función de

productividad, eficiencia en costos y certeza de resultados.” Softtek

ha sido pionero en la implementación de prácticas de ingeniería de software en América Latina, y en los servicios de Near Shore outsourcing.

Hoy en día, la empresa cuenta con 7 Centros, 4 de ellos en México, 2 en

Brasil, y uno más en España, a los que se sumará un nuevo Centro en

Asia que iniciará operaciones hacia finales de 2007.

IMSS, Primer Organismo de Gobierno

en Alcanzar la Evaluación CMMI

La Coordinación de Tecnología para la incorporación y Recaudación del Seguro Social (CTIRSS) fue acreditada con el nivel

3 de capacidad y nivel 2 de madurez de CMMI. La CTIRSS,

a cargo del Lic. Marco Rojano, quien forma parte del equipo del Lic. Igor Rosette, Director de Innovación y Desarrollo

Tecnológico del IMSS, se ha convertido en la primera unidad

de gobierno en México y una de las 50 a nivel mundial en obtener dicha evaluación. Esto representa una recompensa al

esfuerzo de más de 3 años de trabajo de un área conformada

por más 60 personas, quienes además de desarrollar y mantener en operación más de 50 aplicaciones que soportan los

procesos de incorporación y recaudación de todo el Instituto, se pusieron como meta el hacer crecer una organización

de clase mundial.

www.softwareguru.com.mx

Linux World Conference & Expo

III Simposio Metodología Seis Sigma

TI-M, Primera Empresa en el Norte

de México en Obtener CMMI Nivel 3

TI-M (anteriormente TI Móvil) fue acreditado bajo el nivel 3

de CMMI. La implementación y evaluación fueron posibles

gracias al apoyo de consultores de It Era. El proceso de

implementación tuvo una duración total de dos años, y el

grupo evaluador fue dirigido por el SCAMPI Lead Appraiser

Carlos Galván.

TI-M se ha destacado por minimizar el riesgo en el portafolio

de proyectos de TI y maximizar el rendimiento de las inversiones de clientes como Ternium-Hylsa, Sigma Alimentos,

Ipsos Bimsa, entre otros.

GULEV Congreso Internacional de Software

Libre 2006

Del 7 al 9 de diciembre se llevó a cabo la VI edición del GULEV

Congreso Internacional de Software Libre, en Cancún, Quintana

Roo. Este año se contó con la presencia de algunas de las más

importantes figuras del Software Libre como Miguel de Icaza

(Novell) quien ha iniciado proyectos como GNOME y Mono,

Rasmus Lerdorf creador de PHP uno de los lenguajes de programación más populares en el mundo, Bruce Momjian creador de

PostgreSQL un potente gestor de Bases de Datos, Bdale Garbee

(HP) y por primera vez en un evento en latinoamerica, Guido Van

Rossum, creador del lenguaje Python.

El evento fue un éxito, y se anunció que próximamente habrá

muy gratas sorpresas alrededor del evento de Software Libre

con mayor tradición en México.

ENE-FEB 2007

05

// REPORTAJE

/* CLÚSTERS */

Teraloc

De Morelos para Todo México

Por Jorge Palacios

Teraloc es una integradora de empresas del área de Tecnología de Información, que está basada en la ciudad de Cuernavaca, Morelos y

opera desde 2003. Principalmente se enfoca a desarrollar y comercializar productos de sus asociados para la gestión publica, apoyándose

en diferentes herramientas y distintas metodologías en las que se trabaja la administración de proyectos, ITIL, PSP/TSP.

Teraloc cuenta con 6 socios, que son:

•Synerware - Especializada en el software para agencias automotrices.

•Morelos Web - Dedicada al desarrollo y hosting de paginas web

para el Estado de Morelos.

•Victec - Enfocados al desarrollo de aplicaciones de referenciación

geográfica.

•AE Sistemas - Desarrolla aplicaciones administrativas dando servicios a la medida de las necesidades del cliente.

•Pineda y Asociados especializados en metodologías para BPM.

•AFRM procesos - que se dedica al modelado de procesos.

La unión de estas seis empresas, da como resultado, Teraloc, que

como ya explicamos, es una integradora de empresas de TI en el estado de Morelos. Estas forman parte de la Asociación de la Industria

del Software en Morelos, que es la AISAC. Teraloc surge con el objetivo de crear un corredor tecnológico en esta zona, estableciéndolo

como la integradora y la Asociación de Intelsoft.

¿Por qué Teraloc?

El vocablo Teraloc proviene de la combinación del prefijo Tera, que

se refiere a cantidad 1x1012, como se entiende en Megabytes, Gigabytes y Terabytes, y Loc, que se refiere a las siglas utilizadas para

referirse a líneas de código (lines of code). Este nombre se debe a

que el enfoque inicial estaba orientado a la maquila de desarrollo

de software. Sin embargo, la experiencia ha hecho ver a Teraloc,

que es mejor enfocarse en segmentos de mayor valor, y por eso ha

decidido enfocarse en la gestión y automatización de procesos de

negocio (BPM), y metodologías de administración de proyectos y

desarrollo de software.

Como ya mencionamos, Teraloc nació hace cuatro años, al parejo

del programa ProSoft. Desde un inicio han contado con el apoyo de

dicho programa, y han aprovechado los recursos provenientes de

este fondo para dirigirlos principalmente al área de capacitación.

De hecho, Teraloc fue la primera compañía del estado de Morelos

en firmar un convenio con Prosoft, siendo la primera entidad para

el desarrollo del impulso del software.

Pero las habilidades del personal no son todo. También se necesitan procesos maduros y repetibles, y clientes interesados en adquirir tus productos y servicios. Fue por eso que desde un inicio, Teraloc definió un plan de

desarrollo estratégico, que además de la capacitación, consideraba otros

aspectos como la definición de procesos, y la generación de demanda.

Los resultados de tales esfuerzos han sido, sin duda positivos, dando como resultado que la oferta de valor de Teraloc sea más competitiva en términos de calidad y precio. Adicionalmente, Teraloc provee

soluciones para la comunidad, tales como apertura de empleos y

soluciones a nivel gubernamental.

Mercado meta

Teraloc tiene bien definido cual es su mercado meta, el cual está

compuesto de:

•Empresas medianas y grandes que necesiten redefinir y/o automatizar sus procesos internos y externos a través de diversas tecnologías de información para dar un soporte adecuado en la toma de

decisiones.

•Micro y pequeña empresa agrupada.

•Gobierno en sus 3 niveles.

Principales logros

Entre los logros más recientes de Teraloc y sus empresas asociadas,

podemos resaltar los siguientes:

•Selección de Syner IP para el programa de aceleración Techba en

Austin, Texas.

•Creación de la cátedra AISAC en el ITESM Campus Ciudad de México

y Santa Fe.

•Definición del Modelo APTI de TeraLOC para la administración de

proyectos de TI y su adopción en la AISAC.

•Plataforma e-learning para capacitación a distancia vía web.

•Integración de IT Learning en el consejo de educación a distancia de

la Secretaría de Economía.

Para mayor información, visita www.teraloc.com.

La primera etapa en el desarrollo de Teraloc, estuvo enfocada en

la generación y formación de recursos humanos. Teraloc desde el

principio se ha manejado con un enfoque académico en la formación de gente, generando confianza a través de cursos de capacitación donde reciben certificaciones conjuntas. De acuerdo

con la gente de Teraloc, esto ha sido la base para establecer lazos

de comunicación y, que la integradora siga funcionando y dando

grandes resultados.

06

ENE-FEB 2007

www.softwareguru.com.mx

// COLUMNA

/*TEJIENDO NUESTRA RED*/

Lo Que Pasó en Luxemburgo

Avances de MoProSoft en el WG24

La Dra. Hanna Oktaba es profesora de la UNAM a nivel licenciatura y posgrado. Sus áreas de interés son Ingeniería de Software, Tecnología Orientada a Objetos, Modelos de Procesos de Software y Mejora de Procesos. Es fundadora de la AMCIS. Actualmente es miembro de

International Process Research Group (IPRC). También es Directora Técnica del proyecto COMPETISOFT.

E

n esta ocasión voy a contarles sobre la

segunda participación de la Delegación

Mexicana en una reunión del ISO/IEC JTC1

SC7 WG24, cuyo nombre es “Software Life

Cycle Profiles and Guidelines for use in Very

Small Enterprises (VSE)”.

Ya en el número de julio-agosto 2006, platicamos sobre la primera participación de la

Delegación en la ciudad de Bangkok, donde

nuestra norma mexicana basada en MoProSoft y EvalProSoft fue presentada y se seleccionó, de entre varios documentos similares

de otros países como base para los trabajos

del grupo. En esa primera reunión, la Delegación Mexicana se comprometió a realizar la

traducción de MoProSoft al inglés; realizado

en un grupo de trabajo que integra el NYCE

(el organismo que emitió la norma), y que se

entregó a través de la Dirección General de

Normas, al responsable del WG24.

La Delegación en esta ocasión estuvo integrada por Francisco López Lira, Ana Vázquez

y yo, que somos miembros de la AMCIS y

hemos trabajado en diversos proyectos relacionados con la norma. El objetivo fue incluir

en los productos del WG24 la mayor cantidad de elementos de MoProSoft. La reunión

se llevó a cabo en Luxemburgo del 2 al 6 de

octubre, y asistieron delegados de Bélgica,

Luxemburgo, Finlandia, Canadá, Irlanda, Estados Unidos, Tailandia, Sudáfrica y Australia, siendo ésta, la primera participación de

los dos últimos.

El objetivo de dicha sesión fue definir el conjunto de actividades que las VSE implementarán en su primer ciclo de mejora, y que en

adelante, llamaremos “primer perfil”. Las actividades realizadas fueron las siguientes:

•Presentación de las cuatro partes de la

norma MoProSoft.

•Selección de los procesos de MoProSoft

que integrarán el primer perfil.

•Selección de las actividades de estos procesos que integrarán el primer perfil.

08

ENE-FEB 2007

Después de hacer un análisis de los objetivos

de cada uno de los procesos, así como los

costos y beneficios asociados, los procesos

seleccionados fueron los que se encuentran

en la categoría de Operación: Administración

de Proyectos Específicos (APE) y, Desarrollo

y Mantenimiento de Software (DMS).

Los participantes se dividieron en dos grupos para analizar las actividades de cada

uno de estos procesos, y seleccionar las que

consideraban indispensables para el primer

perfil. Nuestro papel consistió principalmente, en explicarles el “porqué” de algunos elementos que tiene el modelo y su relación con

la práctica que conocemos.

Posteriormente, se realizó una discusión

conjunta de ambos grupos para generar

consenso. Cabe aclarar que no contaban con

el “acordeón”, de la versión “coloreada” por

niveles de capacidades.

En general, las actividades seleccionadas del

proceso de Administración de Proyectos Específicos fueron las que corresponden al nivel de

capacidad 1, y de Desarrollo y Mantenimiento

de Software de los niveles 1 y 2. Dicho de otra

forma, del proceso APE se eligió la planeación,

registro y control de los principales parámetros

de administración de proyectos como costo,

tiempo y riesgo, mientras que del DMS se escogieron las actividades de Especificación de

Requerimientos, Análisis y Diseño, Construcción, Integración y Pruebas, con sus respectivas verificaciones y validaciones.

En adición, se incluyeron algunas actividades para controlar los cambios y las versiones de los productos, subsanando así la

ausencia del proceso de Conocimiento de la

Organización en este primer perfil.

¿Nada nuevo? En realidad no, ya que estas

buenas prácticas están contenidas en otros

estándares como el ISO/IEC 12207, además

de ser conocidas por buena parte de la industria. Lo que sí pretende aportar el WG24,

son herramientas de diversos tipos para

ayudar en la implementación de estas prácticas en las VSE, como son la secuencia de

actividades, roles, descripciones de productos, formatos, etcétera.

La próxima reunión será en mayo de 2007,

en San Petersburgo. Para entonces se espera que el delegado de Finlandia, Timo Varkoi,

experto en el estándar ISO/IEC 12207, tenga el mapeo de MoProSoft hacia esa norma,

que este primer perfil haya sido revisado o

probado en los países de origen de los delegados, y que los documentos del grupo tengan un número ISO/IEC asignado.

El trabajo va para largo. Ya nos dimos cuenta

que con dos reuniones de trabajo al año no

se puede avanzar mucho. El objetivo es generar una secuencia de 3 a 4 perfiles, cada

vez más amplios, no necesariamente correspondientes a niveles de capacidades o de

madurez, que sirvan de guía a las empresas.

El perfil final incluirá a MoProSoft completo.

Y de Luxemburgo... lo que les podemos contar

es que es un país con historia milenaria. Su número de habitantes no rebasa a la delegación

más pequeña del DF, no tiene fronteras; es por

supuesto muy limpio, y tiene la parte antigua

con castillos y callejones como de cuento de

hadas. Sin embargo, es un país fundador de la

Unión Europea, un país que hace competencia

a Suiza en el área bancaria y, que a la vez, está

preocupado por apoyar e innovar a sus pequeñas empresas. Nuestros anfitriones fueron del

Centre de Recherche Public Henri Tudor, el cual

desde hace veinte años se dedica al apoyo de

las PyMES en el uso de las Tecnologías de Información para su beneficio.

Otra vez nos da envidia, ¿verdad? Mejor

aprendamos de otros y agreguemos nuestros granitos de arena. Porque lo que podemos hacer, también puede servir de ejemplo a los demás.

— Hanna Oktaba y Ana Vázquez

www.softwareguru.com.mx

// COLUMNA

/*MEJORA CONTINUA*/

Procesos y Variabilidad

La Diferencia entre Productos y Servicios

Luis R. Cuellar es Director de Calidad a nivel mundial de Softtek Information Services. Luis es reconocido por la American Society for Quality

(ASQ) como Certified Quality Manager, Certified Software Engineer, y Six Sigma Black Belt. En los últimos cinco años ha estado a cargo de la

definición e implantación de la estrategia para CMMI5 y Six Sigma a través de las diferentes áreas del centro de desarrollo de Softtek.

Ú

ltimamente he tenido que viajar a diferentes lugares, lo que me

ha dado algo de tiempo para leer. En la Harvard Business Review de noviembre 2006, encontré un artículo sumamente interesante, titulado: “Breaking the Tradeoff of Efficiency and Services”.

El artículo, básicamente habla sobre el hecho de que una de las grandes

diferencias entre las compañías de productos y las de servicio, radica en

que en una organización de servicios, el cliente constantemente irrumpe

en la operación, a través de un comportamiento impredecible, pidiendo

servicios en tiempos no apropiados, una gran cantidad de actividades

adicionales, o cambiando continuamente de opinión. Esto genera grandes variaciones en el proceso, y hace mucho más complicada la operación orientada a servicios, que la enfocada a producto.

En un servicio, conforme aumenta la variabilidad, también aumenta

el costo. Por ejemplo, si el cliente cambia con frecuencia de decisión,

en cuanto a si quiere su sistema con una funcionalidad específica

o no, el costo de la aplicación se eleva, y se genera trabajo que finalmente no se utilizará. Para poder resolver esta problemática, el

autor del artículo que leí, plantea la necesidad de definir el tipo de

interrupción que genera el cliente, y tomar la decisión entre:

a) Manejar la variabilidad en forma controlada. Por ejemplo, los procesos de Starbucks están diseñados para ofrecer un gran número de

opciones, y aun así, controlarlas dentro del mismo proceso.

b) Reducir la variabilidad. Por ejemplo, un restaurante maneja tipos

de cocina y menús para reducir las posibilidades de variación dentro

de las elecciones a seguir.

Máquinas y personas

Tal vez lo que más me llamó la atención del artículo, fueron las implicaciones que esta diferencia entre productos y servicios tiene en el área de

sistemas. Todos sabemos que desarrollar sistemas es, tanto un producto (el sistema en cuestión) como un servicio (análisis de la problemática, diseño de la solución, etcétera). Esta dualidad hace que el desarrollo

de sistemas sea una labor sumamente compleja y llena de decisiones,

y el gran problema que nos trae es que lo que a un cliente dejó sumamente maravillado, a otro simplemente no le trae ningún valor, por lo

que es difícil hacerlo repetible. Por desgracia, muchas de las teorías de

Ingeniería de Software y modelos de Calidad, se basan en modelos de

manufactura, en donde el cliente genera una variabilidad mínima.

Esto nos lleva a una amplia diferenciación entre dos extremos de pensamiento: por un lado están los que ven la calidad como una lista de

proceso, plantillas, y reglas inquebrantables que todo proyecto debe

seguir para minimizar la variabilidad. Por otro lado, están los que

piensan que no tienen sentido los modelos de calidad, pues por más

procesos que se tengan, siempre existirán miles de decisiones que se

10

ENE-FEB 2007

toman en su momento, y lo mejor es tener gente inteligente que pueda

resolver de forma autónoma todos los problemas que se le presenten.

El proceso que se siga, será a discreción de dichos individuos.

La estrategia de calidad inteligente, es precisamente la que se mueve en medio de estos dos mundos, la que da una serie de reglas,

prácticas técnicas y lineamientos. Se asegura que éstos se sigan de

acuerdo a como se planeó al principio del proyecto, y tiene apoyo

constante del resto de la organización para asegurarse de lograr un

buen balance entre flexibilidad y variabilidad.

Ni muy muy ni tan tan

Veamos de nuevo el desarrollo de software como un servicio. Los

procesos de calidad tienen dos funciones primordiales:

1) Lograr generar un producto sin defectos y bajo un presupuesto

predeterminado

2) Reducir el costo de manera constante al capitalizar el conocimiento, para que el siguiente producto se haga de forma más rápida.

En otras palabras, estamos buscando complacer al usuario lo más

eficientemente posible, por ende, con la menor variación posible.

Así, todo proyecto debe iniciar preguntándole al cliente cuáles son sus

requerimientos no funcionales más importantes y por qué. Con esta

información, podemos crear una serie de métricas que nos ayuden a

ver si estamos cumpliendo con lo que un cliente en particular considera calidad. Algunos clientes tienen muy claro que las métricas más

importantes de su proyecto son la entrega a tiempo, sin defectos y

bajo el presupuesto acordado. Sin embargo, tenemos muchos otros

con ideas diferentes, hay algunos que no les preocupan esas cosas;

buscan una compañía con la que se puedan entender, por lo que para

ellos, lo más importante es la flexibilidad en la forma de trabajo, y una

gran comunicación entre las personas del proyecto. Mientras que a

otros, lo que les interesa es que su gente se quede con el conocimiento necesario, aunque cueste más caro. Sin importar cuáles son los requisitos, es muy importante conocerlos, medirlos, y en base a ellos,

establecer en dónde se debe guiar al cliente y en dónde seguirlo.

A final de cuentas

Bajo ningún motivo, un proceso substituye a tener gente capaz de

resolver y entender las necesidades del cliente. Por lo tanto, la idea

de que exista un proceso, es buscar cómo disminuir, en la medida

posible, la mayoría de las variaciones en el proyecto, para así lograr

resultados más eficientes, y al mismo tiempo tener a nuestros clientes siempre contentos, sin importar lo que estén buscando.

—Luis Cuellar

www.softwareguru.com.mx

// PUBLIREPORTAJE

eDeveloper V10 de Magic Software Enterprises es el nuevo paso evolutivo de una herramienta de programación que por más de dos décadas, ha

estado entregando tecnología innovadora para los desarrolladores de

aplicaciones que se enfocan en minimizar los costos, ajustándose a los

estándares que prevalecen en la industria.

M

uchos de los conceptos actualmente aceptados como

parte esencial para la administración de todo el ciclo de

desarrollo, han sido la parte central de la productividad de eDeveloper a través de toda su historia.

Estos conceptos incluyen: repositorios para abarcar las descripciones de una aplicación completa, Reglas de Negocio para

obtener los mayores niveles de abstracción, Desarrollo Declarativo por medio de metadatos para reducir la codificación de

manera drástica.

Todo esto se logra sin definir una sola línea de código, ya que

todas la reglas de negocio están interconstruidas en el motor autómata, que es el núcleo central de la tecnología Magic.

Esto nos lleva a ser un Lenguaje visual 4GL y, a ser considerados

como una herramienta RAD+D, donde la última D, es la facilidad

de poner en Ejecución (Deployment) nuestros desarrollos.

Aunado a esto, tenemos la posibilidad de que las aplicaciones desarrolladas con eDeveloper sean rápidamente escalables, facilitando la implementación de nuevas versiones de sus sistemas.

También tenemos la capacidad de que sus desarrollos corran en

distintas plataformas, como UNIX, Linux o Windows, y con conexiones a las bases de datos líderes en la industria, incluida la

capacidad de explotar datos de sistemas AS/400.

Tenemos un rápido Retorno de la Inversión hecha con eDeveloper, ya que las ventajas que se le presentan al programador, le

permiten incrementar su eficiencia. Las mayores ventajas que

se otorgan son el uso de un paradigma de desarrollo uniforme,

tanto para aplicaciones C/S o para Web; una independencia de

la base de datos a utilizar, permitiendo que el desarrollador se

olvide de las tareas mundanas de conexión a las distintas bases

de datos que pudieran utilizarse en su organización; la interoperabilidad con las distintas tecnologías emergentes, como el

uso de XML, ejecución de servicios de mensajería MSMQ, la

interacción con plataformas J2EE y el uso de Web Services.

Con estas características de conexión tan diversas, tenemos la

capacidad de generar aplicaciones compuestas, sin que esto disminuya la velocidad de desarrollo.

Lo que nos permite ser compatibles con las Arquitecturas Orientadas a Servicios (SOA), y a su vez, ser una herramienta para el

Desarrollo de Aplicaciones Orientadas a Servicios (SODA), pero

siempre contemplando los estándares existentes en la industria;

como en el caso, por poner un ejemplo, de nuestra conexión a

Systinet, que es un aplicativo estándar para la comunicación,

tanto de consumo como de proveedor de Web Services.

Nuestros desarrollos se guardan en documentos XML, pero sin que

el desarrollador tenga que escribir una sola línea XML. eDeveloper

es tan compatible con XML, que puede ocupar un documento XML,

y editarlo como si se tratase de una tabla de una base de datos.

El entorno de desarrollo, conocido como Editor de Tareas, conjunta todas las características necesarias para el desarrollo de la

lógica, así como la presentación de un programa o tarea.

La edición de las formas que se dispondrán al usuario final, podrán tener la mejor presentación, siendo compatibles con los estilos gráficos de Windows XP, para el caso de aplicaciones C/S,

o compatibles con los estilos diseñados por el editor de páginas

HTML de su elección, para el caso de aplicaciones Web.

El programador podrá trabajar de la misma forma en C/S como en

Web, basados en un mismo paradigma de desarrollo. Todo está

basado en una tecnología que conocemos como Browser Client,

el cual, pondrá a nuestra disposición, la facilidad de crear aplicaciones para Internet o Intranet, pero dándole al usuario final, la

apariencia de que trabaja en C/S. Un concepto de una aplicación

para cliente ligero basado en un navegador.

El motor autómata permite ejecutar nuestras aplicaciones ya sea

corriendo dentro del módulo de ejecución de aplicaciones, como

en el caso de aplicaciones Stand-Alone o C/S, o corriendo como

servicios, para el caso de Servidores de Procesos o Servidores de

Aplicaciones Web. Y con la capacidad de portabilidad a distintas

plataformas, esto nos ofrece un espectro de posibilidades mayor.

Esto, y mucho más, es el eDeveloper V10. Mayor información en

www.rocasistemas.com.mx

// PRODUCTOS

/* LO QUE VIENE*/

Rational Software Delivery Platform 7.0

Desarrollo Global de Aplicaciones SOA

IBM lanzó la versión 7 de su línea de herramientas de desarrollo de software, Rational Software Delivery Platform (SDP) que es un conjunto de herramientas para

desarrollar software, basadas en Eclipse, y complementada con procesos que engloban mejores prácticas, como el Rational Unified Process.

Esta versión está principalmente orientada a la construcción y mantenimiento

de aplicaciones orientadas a servicios. Otro aspecto importante, es que atiende

las características y necesidades del desarrollo de software moderno y global,

donde los equipos de desarrollo están dispersos geográficamente, por lo que las

herramientas de desarrollo deben soportar y facilitar esta forma de trabajo.

Algunos de los productos específicos incluidos como parte de esta nueva

versión están:

•IBM Rational Application Developer – Un IDE completo para diseñar, desarrollar,

depurar e instalar aplicaciones SOA y J2EE en ambientes empresariales.

•IBM Rational Software Modeler – Un modelador visual basado en UML 2.1, para

que los arquitectos, analistas y diseñadores plasmen y comuniquen los requerimientos y diseño de los sistemas a construir.

•IBM Rational Functional Tester – Una herramienta de pruebas avanzada que

provee pruebas automatizadas funcionales y de regresión.

Más información en www-306.ibm.com/software/rational

Apache Axis2

JBoss Seam 1.1

Aplicaciones Web con Funcionalidad Compleja,

pero Desarrollo Sencillo

Seam es el framework de JBoss para desarrollar aplicaciones Web 2.0. Dicho framework integra tecnologías

populares como AJAX, Java Server Faces, EJB3, Java

portlets y workflow, bajo un modelo unificado.

Seam facilita el desarrollo de aplicaciones web ricas y basadas en estados (stateful), a través del manejo sencillo

de objetos con estado, que residen en el servidor, que

interactúan con componentes AJAX del lado del cliente.

La versión 1.1 de Seam se liberó recientemente, y entre

sus nuevas capacidades están:

•Modelo de componentes basado en POJOs, que elimina la dependencia a EJBs para manejar estado.

•Nuevo framework de persistencia basado en Java

Persistente API e Hibernate.

•Integración con ICEfaces y Ajax4jsf para generar componentes GUI de nueva generación.

•Soporte de conversaciones atómicas, las cuales

son requeridas por el modelo de operación de las

aplicaciones AJAX.

Mayor información en www.jboss.com/products/seam

Web Services Open Source de 3ra Generación

Axis2 es un motor de web services desarrollado por la Apache Software Foundation, y por lo tanto, open source. Axis2 se encuentra

actualmente en su versión 1.1, la cual fue recientemente liberada y

recibida con gran entusiasmo por la comunidad.

De acuerdo con los expertos, hoy en día estamos en la tercera generación de middleware para web services, y Axis2 forma parte de

ésta. Mientras que las dos primeras generaciones se enfocaron en

demostrar que los web services “eran posibles”, la tercera generación se enfoca en hacerlos eficientes y confiables. Es decir, algo que

vaya más allá de los prototipos, y que sea una alternativa real para

sistemas de misión crítica.

Apache Axis2 fue diseñado y construido desde cero, a partir de las

lecciones aprendidas con Apache Axis, el cual puede ser considerado

un middleware de web services de 2da generación. Axis2 es mucho

más eficiente, escalable y modular que su antecesor. Además, es

altamente extensible a través de módulos opcionales para soportar

especificaciones avanzadas de web services como son WS-Security,

WS-Trust, WS-Reliable Messaging, o WS-Eventing.

Más información en ws.apache.org/axis2

12

ENE-FEB 2007

Unity 1.6

Desarrollo de Juegos 3D Multiplataforma

Unity es una herramienta para desarrollar juegos de

3D, que se pueden ejecutar en un navegador web, o

standalone. Con Unity se puede generar gráficas de

gran detalle, a una gran velocidad. Vale la pena notar

ue, Unity utiliza Mono como máquina virtual para la

ejecución de scripts multiplataforma.

Unity es utilizado por diversos estudios desarrolladores de juegos, y recibió el segundo lugar en la categoría “Mejor uso de las gráficas de Mac OS X”, durante el

pasado Developer Conference de Apple.

En el sitio web de Unity (unity3d.com) se puede descargar

una versión de evaluación, y también se puede echar un

vistazo a la galería de cosas hechas con dicha herramienta. Quedarás impresionado por el detalle y velocidad de

las gráficas que se ejecutan en tu navegador.

www.softwareguru.com.mx

// PRODUCTOS

/* NOVEDADES*/

Windows Communication Foundation

Un Framework para Desarrollar Aplicaciones Distribuidas

Por Haarón González

V

ivimos en un mundo cada día más conectado. Las organizaciones se han enrolado en la era de Internet, ofreciendo servicios

electrónicos que les permiten integrar o exponer su información interna, hacia clientes u otros procesos empresariales externos. Esta

conectividad, combinada con la necesidad de integrar sistemas heterogéneos, ha influenciado el establecimiento de un nuevo paradigma: las arquitecturas orientadas a servicios (SOA), de las cuales

hemos oído tanto en los últimos meses.

A pesar de que ya existían múltiples tecnologías para construir este tipo

de sistemas, como lo son CORBA y DCOM, en definitiva los servicios web

basados en XML fueron un paso importante para descubrir y asimilar el

verdadero potencial del concepto de software como servicio, o software

que se conecta con software, abriendo una nueva gama de posibilidades para construir aplicaciones distribuidas, debido a la adopción de

estándares abiertos para conectar personas, sistemas y dispositivos.

Múltiples proveedores de plataformas tecnológicas ya soportan en sus

productos el uso de web services y sus estándares para permitirnos integrar sistemas, aunque éstos utilicen diferentes plataformas operativas. Sin embargo, las capacidades de integración a través de servicios

web no son del todo ricas, de alguna manera están limitadas a cierto

tipo de escenarios. En otras palabras, los servicios web se quedan cortos en funcionalidad. Por ejemplo, hacer trabajar tecnologías J2EE con

.NET es factible, pero complicado a la vez, requiere de consideraciones

técnicas adicionales para reforzar la seguridad, compartir la identidad

de usuario, soportar transacciones distribuidas.

Los retos que se tienen en la actualidad para hacer realidad la visión

de orientación a servicios son:

•¿Cómo podemos asegurarnos de que las conexiones entre los servicios sean confiables, y se repongan a fallos en la comunicación?

•¿Cómo establecer todo un mecanismo de seguridad integral para el

intercambio de mensajes entre servicios?

•¿Cómo crear aplicaciones que expandan sus fronteras de confianza y

participen en procesos transaccionales locales y remotos?

•¿Qué modelo de programación debo utilizar para construir servicios?

•¿Cómo puedo hacer que una aplicación esté orientada a servicios y

pueda beneficiarse de este estilo de arquitectura?

Para resolver estas necesidades, se ha creado la tecnología Windows

Communication Foundation (WCF).

Windows Communication Foundation

Es uno de los pilares del .NET Framework 3.0. Básicamente provee

un subsistema de programación para la construcción de aplicaciones

distribuidas orientadas a servicios. WCF permite el desarrollo de ser-

vicios seguros, confiables y transaccionales que interoperan ya sea

con plataformas Microsoft u otras; soportando coexistencia con anteriores tecnologías para aprovechar las inversiones existentes. Ofrece

mecanismos de implementación mucho más sofisticados que los que

actualmente utilizamos para distribuir servicios y conectar sistemas.

WCF combina y extiende las tecnologías actuales para construir sistemas distribuidos bajo plataforma Microsoft, hablamos de .NET Enterprise Services (COM+), MSMQ, .NET Framework Remoting, Web Service Enhancement (WSE), ASP.NET Web Services (ASMX) y System.Messaging,

con la intención de proveer un solo marco de trabajo o unificado.

Como ya comenté, WCF es parte del .NET Framework 3.0, lo que

significa que es parte integral e interna de Windows Vista, pero que

también estará disponible en otros sistemas operativos que soporten el .NET Framework 3.0, como Windows XP SP2 y Windows Server

2003 SP1. Adicionalmente, existen proyectos basados en Mono, para

llevar soporte de WCF a plataforma Unix/Linux.

Objetivos de Diseño

WCF hace posible lo anterior gracias a los siguientes objetivos de diseño:

•Soportar internamente un gran conjunto de protocolos para servicios web: las tecnologías actuales para web services proveen soporte para un tipo de interoperabilidad muy básica entre aplicaciones.

Por ejemplo, estas tecnologías carecen de la habilidad de lograr interoperabilidad garantizando una seguridad integral y comunicación

confiable. WCF soporta interoperabilidad segura, confiable y transaccional, a través de soporte interno para las especificaciones WS-*.

•Diseño orientado a servicios: los principios del desarrollo orientado

a servicios han permitido hacer frente al reto de construir software

que se adapta con rapidez a las necesidades del negocio. WCF es el

primer modelo de programación construido desde cero para facilitar

implícitamente el desarrollo de aplicaciones orientadas a servicios.

•Modelo de programación unificado: WCF provee una API diseñada

para el desarrollo de sistemas conectados, lo cual trae mejoras en

productividad al desarrollar este tipo de sistemas.

Fundamentos de WCF

La figura 1 ilustra el flujo de un servicio que utiliza WCF. Los EndPoint

son la unidad principal de exposición de funcionalidad en un servicio,

un servicio puede albergar múltiples EndPoint cada uno con su propia configuración. Los EndPoints pueden ser configurados de manera

programática (en código) o declarativa (en configuración XML) y son

prácticamente nuestros canales de conversación con las aplicaciones cliente o con otros consumidores de nuestros servicios, ya que

Haarón González trabaja para DirectApps, una empresa de Sacramento, CA dedicada a construir soluciones web para automatizar flujos de trabajo, servicios

de infraestructura y staffing. Haarón es Licenciado en Informática egresado del Instituto Tecnológico de Mexicali, y cuenta con las certificaciones MCP, MCAD

y MCT, además de ser reconocido como Microsoft MVP en la categorÌa ASP.NET, y ser orador regional de INETA (International .NET Association).

14

ENE-FEB 2007

www.softwareguru.com.mx

definen en donde, cómo y qué se intercambia. Los EndPoints están

compuestos por:

• Address define: donde exponer un servicio, en otras palabras, una

dirección en la red en donde reside un servicio.

• Binding define: cómo exponer un servicio, o qué protocolos de transporte (TCP, HTTP), codificación (texto, binario, MTOM) y requerimientos

de seguridad (SSL, WS-Security) se utilizarán en la conversación.

• Contract define: qué exponer en un servicio, es decir, qué estructuras (datos) y operaciones (métodos) se pueden intercambiar durante

una conversación entre servicios.

Un ejemplo sencillo

Una vez definido nuestro contrato, lo implementamos en la clase

CalculoService, que es donde realmente existirá la funcionalidad de

nuestro servicio.

using System.ServiceModel;

namespace BasicWCFDemo.Server

{

[ServiceBehavior(Name = “CalculoService”)]

public class CalculoService : ICalculoService

{ public int Suma(int x, int y)

{ return x + y; }

public int Resta(int x, int y)

{ return x - y; }

public int Multiplicacion(int x, int y) { return x * y; }

}

}

El siguiente paso es especificar el hospedaje de nuestro servicio, y

eso lo hacemos a través de la clase ServiceHost. Con ServiceHost podemos hacer que cualquier aplicación pueda convertirse en un huésped de algún servicio, eliminando dependencias a otros productos

del servidor. Por ejemplo, el siguiente código hace que nuestra aplicación de consola sea un huésped de servicio.

using System.ServiceModel;

Figura 1. Flujo de un servicio con WCF.

Para construir servicios WCF requerimos hacer referencia a System.

ServiceModel incluido en .NET Framework 3.0. Primeramente hay que

definir el contrato, ya que es muy importante especificar las reglas para

lograr una conversación. En WCF existen los atributos DataContract y

OperationContract. Los DataContract nos permiten calificar código para

que sean tomadas como las estructuras de datos que vamos a utilizar

para intercambiar mensajes. Los OperationContract nos permiten calificar código para que sea tomado como los métodos o puntos de entrada

que pueden invocarse durante el intercambio de mensajes.

Veamos el código para definir un contrato:

using System.ServiceModel;

namespace BasicWCFDemo.Server

{

[ServiceContract(Namespace = “http://DemoWCFService.ServiceContracts/2006/11”,

Name = “ICalculoService”)]

public interface ICalculoService

{ [OperationContract(Action = “Suma”, IsOneWay = false)]

int Suma(int x, int y);

[OperationContract(Action = “Resta”, IsOneWay = false)]

int Resta(int x, int y);

[OperationContract(Action = “Multiplicacion”, IsOneWay = false)]

int Multiplicacion(int x, int y);

}

}

www.softwareguru.com.mx

namespace BasicWCFDemo.Server

{

class Program

{

static void Main(string[] args)

{

Uri direccionUrl = new Uri(“http://localhost:8080/BasicWCFDemoServer”);

ServiceHost servicioHost = new ServiceHost(typeof(CalculoService), direccionUrl);

servicioHost.AddServiceEndpoint(typeof(ICalculoService), new BasicHttpBinding(),

direccionUrl);

servicioHost.Open();

Console.WriteLine(“Servicio escuchando...”);

Console.ReadKey();

servicioHost.Close();

}

}

}

Si observamos detenidamente el código, encontraremos que se ha especificado la dirección (address) donde reside nuestro servicio en la red,

el canal (binding) utilizado para intercambiar mensajes (BasicHttpBinding) y el contrato usado por el servicio. Aquí es donde sucede la magia,

ya que es donde podemos configurar nuestro servicio basado en los

tres conceptos más importantes: Address, Binding y Contract.

Conclusión

WCF se puede usar para conectar sistemas que se ejecutan en contextos locales, Intranet, Extranet e Internet. WCF provee un marco de

referencia unificado y con capacidades avanzadas para el desarrollo

de aplicaciones distribuidas.

ENE-FEB 2007

15

// ESPECIAL

¿Centros de Desarrollo

de Software en las Universidades?

Una Realidad aún sin Explotar

Por Joaquín Arellano

de una carrera de Ingeniería

¿paraEldeegresado

Software, está realmente preparado

afrontar como se debe, los retos que

demanda el mercado laboral?, lamentablemente, en la mayoría de los casos, el alumno promedio sólo obtiene los conocimientos

teóricos y prácticos que le enseñan en las

aulas, y que a pesar de que son buenos, no

son del todo suficientes. ¿Cuál puede ser una

de las causas? Hoy en día, no sólo es necesario dominar algún lenguaje de programación

orientado a objetos –pensando que es la única opción para un problema–, sino también,

poder codificar en el clásico notepad o en un

editor básico, saber que existen técnicas de

producción de sistemas; aprender de memoria el modelo de cascada o espiral, u otro, saber de la existencia de UML, pero no saberla

aplicar; conocer y desarrollar en una sola

base de datos, y en general, conceptos básicos del mundo de IT; se requiere ampliar así

como profundizar en dichos conocimientos y

en muchos más, no por soberbia, sino porque

el mercado lo exige, demanda profesionistas

mejor preparados en áreas de conocimientos

más recientes, cada vez más usadas.

Por otra parte, para incrementar su competitividad, el

egresado necesita tener un background más amplio de lo

que los planes de estudios actuales ofrecen. Esto, debido

a que el mercado laboral es muy exigente, competitivo,

y no sólo requiere profesionistas que sepan conceptos y

fundamentos básicos de Information Technology (IT, por

sus siglas en inglés); sino que también se requiere que estén familiarizados con:

•IDEs: como Java Studio Creator 2, Visual Studio

2003/2005, Eclipse, NetBeans, Zend Studio, etcétera.

•No sólo dominar un lenguaje de programación (orientado a objetos, estructurado, procedural, etcétera),

sino que además, sepan usar de forma básica otros

lenguajes (si no dominarlo, saber qué alcance tiene

cada uno y cuáles son sus ventajas sobre otros lenguajes) en caso que sea necesario moverse a un nuevo

lenguaje.

•Cómo interactúan diferentes lenguajes con diferentes

proveedores de bases de datos (Oracle, SQL Server, MySQL, Informix, PostgreSQL, etcétera).

•La ya tan mencionada Web 2.0.

•Modelos arquitectónicos como MVC (Model View Controller), o SOA (Service Oriented Architecture).

•Poder entender adecuadamente y llevar a la práctica

(en escala) conceptos de ingeniería de software, pasando por modelado de objetos, calidad en el software, PSP,

TSP, ITIL y, ¿por qué no?, CMM/CMMI y varios más.

•Creación de Software confiable, seguro, adaptable, administrable, entre otros.

•Facilidad de adaptarse a cambios, tiempos y tecnologías.

Joaquín Alonso Arellano Ramírez, se ha desempeñado como desarrollador, implementador y administrador de sistemas, coautor del artículo “Confiabilidad del Software: desarrollando productos confiables”. Sus intereses en el área de sistemas incluyen, sistemas en plataforma WEB y Técnicas de Producción de Sistemas. Trabaja

en el departamento de desarrollo de sistemas escolares del ITESM Campus Monterrey y forma parte del equipo que implementa el modelo CMMi en el mismo instituto.

16

ENE-FEB 2007

www.softwareguru.com.mx

“El egresado necesita tener un background

más amplio de lo que los planes de estudios

actuales ofrecen”.

¿Dónde puede el alumno aprender esto?, dónde más,

sino en su misma universidad, ¿de qué forma?, promoviendo centros de desarrollo de software en los que el

alumno pueda, de forma voluntaria, involucrarse y profundizar en conceptos como los antes mencionados,

mientras desarrolla proyectos reales, que no necesariamente tienen que ser grandes (en complejidad y tamaño)

para que el alumno pueda usar los conceptos anteriores,

sino a través de proyectos planeados y estructurados,

todo, al mismo tiempo que cursa su carrera. Esto ayuda

a que el alumno mientras estudia una carrera de Ingeniería de Software, tenga la posibilidad de aplicar todos los

conocimientos que adquiere a lo largo de sus estudios,

más una gran parte, de los que ya hemos mencionado, en

proyectos reales. Muchos de los conceptos, si no es que

la gran mayoría, se pueden obtener mediante iniciativas,

como por ejemplo:

•Acercamiento con empresas de software que aplican

CMM/CMMI, ITIL, PSP, TSP; conceptos de ingeniería de

software y herramientas tecnológicas actuales que requieren de los egresados cierto grado de conocimiento.

•Una gran gama de sitios en Internet en donde se puede

obtener material de alta calidad de los conceptos y tecnologías ya mencionados, y de muchos más, que quizá se me

puedan estar pasando.

•Acercamiento con gobiernos Estatal y Federal, para incentivar dichos centros en la educación pública y privada.

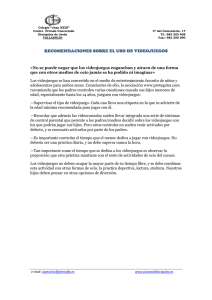

Estructura propuesta

Profundizando un poco en cómo se podrían estructurar dichos centros, considero tres bloques esenciales, como se

muestra en la siguiente figura.

•Software gratis. Algunos de ellos se pueden obtener

bajo algún tipo de licenciamiento, y en ciertos casos,

existen cursos, también gratuitos, que ofrecen las empresas, para capacitarse en el uso de dicha tecnología.

•Programas de certificaciones gratuitos, como los que

ofrece Microsoft con su Academia Latinoamericana de

Management (ITIL), Desarrollador Cinco estrellas 2005,

por mencionar uno.

•Evaluación de software, que muchas empresas ofrecen, como Flex 2 de Adobe (recién liberado) y las versiones constantes de los productos de Sun, IBM, Zend,

ActiveGrid, etcétera.

•Convenios como los que algunas universidades tienen con empresas como Microsoft, Macromedia (ahora

Adobe), Oracle, Sun, en donde el alumno puede tener

acceso a versiones gratuitas de software, o como las

versiones educativas que ponen a disposición un gran

número de empresas, como Zend Technology.

Estructura en 3 Bloques Esenciales.

www.softwareguru.com.mx

ENE-FEB 2007

17

// ESPECIAL

“De la curiosidad nace el interés, y es por

medio de centros de desarrollo de software

que el alumno puede despertar su inquietud

por conocer más, de lo que los planes de

estudio suelen cubrir”.

Zona operativa y de control

La integrarían personas que formen parte de las academias de IT de las mismas universidades, y alumnos; es de

academias de IT forme parte de esta zona, es para lograr

un vínculo entre los salones de clase y los centros de desarrollo de software; mientras que la de los alumnos, es

fortalecer los aspectos administrativos y de control de

proyectos de software en ellos, y no sólo la parte técnica

(el desarrollo del software como tal).

Zona de desarrollo de SW

Estaría conformada 100% por los alumnos que hayan

obtenido un nivel de conocimientos adecuado, que les

permita explotarlo en dichos proyectos. El nivel de conocimiento puede ser delimitado mediante varias formas:

de algún semestre en adelante, número de materias cursadas, conocimientos técnicos, promedios, etcétera.

Zona de soporte y apoyo:

En esta zona se encontrarían profesionistas de IT externos, empresas públicas y privadas, gobierno y demás

personas e instituciones que puedan aportar sus conocimientos para el beneficio de los centros. Las empresas

públicas, privadas y gobierno serían los “patrocinadores” de proyectos específicos, aportando SW licenciado para fines educativos, programas de capacitación,

charlas, orientación y soporte de las metodologías que

usan, por mencionar algunos. La forma puede ser variada, no necesariamente tiene que ser presencial; y los

profesionistas de IT aportarían los conocimientos que

han adquirido a lo largo de su carrera, permitiendo entre otras cosas, alentar a los estudiantes a seguir creciendo en el mundo de las IT’s y de igual forma, dando

soporte a proyectos que les interesen.

Como puntos finales es necesario recalcar, que el nivel

de conocimientos que un alumno pueda llegar a tener,

aprender, manejar y conocer, de los conceptos aquí presentados, dependerá en gran parte, de su propia inquietud, complementada por los consejos y apoyo que reciba

de todas las personas que formen parte de los centros,

así como de los proyectos manejados. De la curiosidad

nace el interés, y es por medio de centros de desarrollo

18

ENE-FEB 2007

de software que el alumno puede despertar su inquietud

por conocer más de lo que los planes de estudio suelen

cubrir. Esto con el fin último, de presentar egresados al

mercado laboral, con la confianza, el respaldo técnico y

conocimientos para enfrentar los retos laborales que el

mundo de IT necesita.

Sin duda se requiere de inversiones económicas, instalaciones, tiempo, esfuerzo y personal, pero no tienen

que ser necesariamente exigentes, es posible hacer

uso de mucho de lo que las instalaciones de las universidades tienen, para dar soporte a centros de esta

clase y los resultados compensarían la inversión.

No es necesario destacar los beneficios que los alumnos principalmente, las empresas públicas y privadas,

instituciones educativas y el gobierno podrían obtener,

porque son obvios. “El objetivo no sólo es beneficiar al

alumno sino también a todas las partes que se vean involucradas en proyectos de este tipo. Las formas de cristalizar los centros son variadas. Se propone una estructura operacional básica de cómo se podrían administrar

los centros, pero el hecho es que necesitan realizarse”,

como bien lo menciona el Dr. Carlos Montes de Oca en

la edición mayo-junio 2006 de la revista Software Guru,

y agregaría algo que sin duda muchos compartirán conmigo: que si México quiere competir internacionalmente

como país, en el desarrollo de software de calidad, es necesario que los alumnos y egresados estén a la par sobre

lo que día con día surge en este mundo cambiante de las

IT’s, siendo la propuesta aquí presentada, un medio por

el cual se puede lograr.

NOTA

El propósito de mencionar el software y las empresas aquí citadas, es con el fin de divulgar el

gran esfuerzo hecho, en términos generales, por

empresas de TI para dar a conocer a la comunidad los productos, tecnologías y metodologías

que ofrecen y promueven bajo diferentes esquemas de licenciamiento.

www.softwareguru.com.mx

// ENTREVISTA

El pasado mes de octubre en la ciudad de Guadalajara, Jalisco,

se realizó el primer Festival Nacional de Animación y Videojuegos, Creanimax 2006, donde se dieron lugar profesionistas y

entusiastas del medio, para compartir conocimientos, secretos, y conocer un poco más de cerca lo que se está haciendo

tanto en México como en otras partes del mundo.

Bill Plympton

Software Guru estuvo presente, y tuvimos la oportunidad de

platicar con tres interesantes personajes, cada uno con su muy

particular estilo y espacio en el universo de la animación 3D

y el desarrollo de videojuegos. Se trata de Bill Plympton, con

más de veinte años de experiencia, creador de cortos animados

como “Guard Dog”; Ernesto Gálvez, CEO y socio fundador de

Immersion Games, y René Castillo, animador en stop motion,

creador de “Poncho Balón” y de la película animada “Hasta los

Huesos”. A continuación lo que compartieron con nosotros.

20

ENE-FEB 2007

“Sobreviviendo como animador independiente” Nos

llamó la atención el título de tu ponencia, ¿qué es lo

que compartes con los asistentes?

Creo que ahora es un momento muy especial, parece ser

que hay mucho interés en la animación. Es la segunda

“época dorada” en animación. Y creo que es posible convertirse en un animador independiente y hacer dinero. Me

gusta compartir con la gente mi propia experiencia, cómo

he sobrevivido haciendo pequeños filmes, comerciales y

largometrajes. Me gusta revelar el secreto de mi éxito con

las personas, decirles cómo hacer las cosas y al mismo

tiempo, mostrar un poco de mi nuevo trabajo.

¿Podrías compartir con nosotros el secreto de tu éxito?

Me parece que es muy importante que el filme sea divertido, creo que a la gente le gusta reírse con la animación,

por lo tanto, debe ser divertido. También creo que debe

ser corto, alrededor de cinco minutos, y deber ser barato,

es decir, no invertir cientos y cientos de dólares. Si puedes

hacerlo, si puedes cumplir con estos tres requisitos, tu filme será exitoso y podrás hacer mucho dinero.

Seguro que hay algunos tips para todos aquellos que

quieren iniciarse en la animación independiente.

Por supuesto. Quizá el más importante es dibujar, hacerlo

siempre, nunca dejarlo; tener un cuaderno donde constantemente se anoten ideas, porque ésas, eventualmente

se convierten en proyectos. Es vital también, ver muchos

filmes, es importante conocer la animación, la historia de

la animación, debes amarla, deber tener pasión por ella ,

yo lo hago, trabajo doce horas al día haciendo mis filmes,

y esa es la clase de pasión que debes tener.

¿Cuál crees que sea el papel de México en el mundo de

la animación?

Justo de eso platicaba en la mañana con una persona, México

tiene una maravillosa tradición de historias y artistas, desde

los aztecas y los mayas, hasta las grandes leyendas; y creo

que el artista de hoy, ama al contador de historias, ama las

artes visuales, y son exactamente los dos ingredientes que

se necesitan para convertirse en un éxito. No creo que se necesite mucho dinero, no creo que se necesite mucha tecnología, sólo contar historias interesantes y entretenidas.

¿Ves futuro en los animadores mexicanos?

Bueno, René Castillo es una gran estrella, es una gran celebridad. Lo conocí hace alrededor de cinco años en un festival, y me gustan mucho sus filmes. Me parece que ahora,

como sabes, los cineastas mexicanos son muy populares,

por tanto, creo que México está explotando, en términos

de producción cinematográfica.

¿Cuál es el panorama de la industria actualmente?

Creo que está creciendo, y eso hace que sea el momento

perfecto para la animación. Hay muchísimos mercados, y

trabajos ahí, esperando por el talento.

BILL PLYMPTON

Nació en Portland, Oregon el 30 de abril de 1946. Sus filmes cortos se han mostrado

alrededor de los Estados Unidos, sobre todo durante festivales de animación. Con un

peculiar sentido del humor y visión burlona del día a día, que se reflejan en sus “Microtoons” y otros populares cortos para MTV, Plympton se ha hecho famoso con “Guard

Dog” que le valió la nominación al Oscar en 2005. Su más reciente producción se titula

“Idiots and Angeles”. Para conocer más de cerca su trabajo: www.plymptoons.com

www.softwareguru.com.mx

René Castillo

¿Cuál fue tu primer encuentro con la animación?

Desde niño hacía muñequitos de plastilina, era algo que no podía dejar

de hacer, tenía dinero y compraba plastilina para crear monitos diferentes,

nunca copiaba, y hacía mis historias. Pero a pesar de ese acercamiento,

no contemplé jamás la animación como una posibilidad. Y fue hasta los

23 años cuando iba en el coche, en el radio escuché un anuncio que decía:

“curso de animación con plastilina”. Me dije: “yo puedo hacer eso”, así es

que llamé, me inscribí y al día siguiente ya estaba ahí.

¿Qué opinas de eventos como Creanimax?

Cuando empecé a hacer animación, hace quince años, había dos

personas a quién preguntarles, y no te decían nada. Por tanto, esto

representa un gran crecimiento, relacionado con la tecnología que

nos acerca las herramientas; tiene que ver también con el software,

que nos permite ahora, hacer cosas de gran calidad y en un tiempo

aceptable. Antes, sólo Disney hacía películas, y usaban novecientas

personas para hacer un largometraje. Hoy en día, con cincuenta personas lo puedes hacer, y eso es gracias a la tecnología. Hay como un

“boom” en todo el mundo, justamente por eso, porque hay un sinfín

de plataformas para hacer animación 3D.

Hacer stop motion es laborioso. ¿Cuánto tiempo tardas?

Normalmente en un segundo de animación me tardo una hora. Si es

complicado y a 24 cuadros por segundo, me tardo hasta cinco horas

por segundo. Es que tienes que mezclar escultura, actuación y todo. Es

un proceso muy artesanal, extremadamente artesanal, de hecho, es la

técnica de animación más cara y lenta de todas. Además hay que tomar

en cuenta todo el tiempo previo, hay que hacer los personajes, las maquetas, iluminar, todo lleva consigo una preproducción bastante larga.

¿Qué tipo de software utilizas?

La verdad es que utilizo softwares diferentes, pero para stop motion, utilizo Adobe Premiere o Final Cut para hacer un animatic, que

es algo parecido a una maqueta que te permite ver cómo será tu

proyecto. La animación hay que planearla siempre y mucho, sea la

técnica que vayas a usar, siempre hay un trabajo de trazo a lápiz, de

story board, y luego un sistema de edición no lineal para armar tu

maqueta. Después, para animar stop motion, utilizo un software que

se llama Frame Thief, que graba cuadro por cuadro, es muy sencillo

porque grabas desde tu cámara, mientras ves cómo corre la animación. Todas son herramientas muy buenas que permiten previsualizar el avance de tu animación. Antes no teníamos nada de esto,

y era completamente a ciegas, animabas y después tardabas otros

dos días editando cuadro por cuadro, era hasta entonces cuando

podías ver cómo se veía. Ahora lo puedes ver al instante. También

hacemos animación en Flash, por ejemplo, Poncho Balón. Usamos

también software de animación 3D, tanto Maya como 3ds Studio

Max y claro, software como Photoshop que es básico y Word para

escribir, que es el primer paso. Digamos que la computadora es una

parte fundamental.

¿Cómo ves la industria de animación en México?

En México hay mucho talento, todavía es una materia pendiente,

pero puede llegar a ser una gran industria, representa ingresos importantes para Estados Unidos y Canadá, así como para muchos países asiáticos. Yo creo que podemos ser muy buenos maquiladores

a un costo relativamente bajo, súper competitivos con imagen, por

ejemplo, pero además, podemos generar propiedades, proyectos.

Aunque quizá, el principal problema aquí en México, son los animadores. No encontramos animadores, porque no hay, todavía no están

listos, la gente está aprendiendo por su cuenta y eso lleva mucho

tiempo. Y es que si te preguntas: ¿qué va primero?, es todo, las escuelas, los proyectos, las empresas, todo va de la mano.

¿Alguna vez te ha cruzado por la mente desarrollar videojuegos?

Totalmente, por supuesto, con Poncho Balón ya estoy en pláticas

con gente de aquí (Creanimax) para hacer un juego. Me parece magnífico que podamos encontrarnos, y veamos en conjunto todas las

posibilidades que tenemos. Porque quizá tú quieras desarrollar un

videojuego basado en un personaje que nadie conoce, y eso te dificulte darlo a conocer, pero si yo tengo un personaje, que a parte

estoy lanzando, y tengo grandes planes para él, de pronto podemos

lanzar un juego, es decir, sumamos esfuerzos.

RENÉ CASTILLO

Es egresado de la carrera de Comunicación por el ITESO en Guadalajara, Jalisco. Su afición desde pequeño por modelar personajes de plastilina lo llevó a encontrar en la animación stop motion el lugar perfecto para darle rienda suelta a su creatividad. Muestra

de su sobresaliente trabajo son los filmes animados “Hasta los Huesos” y “Sin Sostén”.

Además de la animación en Flash, “Poncho Balón”. www.ponchobalon.com

www.softwareguru.com.mx

ENE-FEB 2007

21

// ENTREVISTA

Ernesto Gálvez

¿Cómo surge Immersion Games?

Hace cuatro años decidimos fundar nuestra compañía,

queríamos hacer videojuegos, pero no teníamos presupuesto para hacerlo ni siquiera para pagar el primer mes de nuestros salarios, así que decidimos explorar otras áreas relacionadas también con gráficos

3D, pero orientadas hacia desarrollo de soluciones de

seguridad, de arquitectura, etcétera. Así nos mantuvimos durante mucho tiempo, viviendo de regatearle a los

clientes, eso nos cansó, nos aburrió, pero fue lo que nos

permitió ir creciendo poco a poco, y entonces decidimos

arriesgarlo todo y desarrollar videojuegos.

22

ENE-FEB 2007

¿Cómo captaron la atención de inversionistas? Porque

desarrollar un videojuego requiere capital y proyección para ser exitoso.

Se dio la oportunidad de que unos inversionistas metieran su dinero en nuestra compañía, pero nunca se

atrevieron, porque siempre nos vieron como un grupo

de jóvenes, pensaban que podían perder su dinero fácilmente. Mientras eso sucedía, contactamos con una compañía

norteamericana, porque pensábamos que con aquel dinero, compraríamos tecnología de otros para hacer nuestros

videojuegos, pero eso nunca sucedió. Un día, producto de

nuestra desesperación hablamos con dicha empresa con la

propuesta de hacer mejoras en su tecnología, a cambio de su

código fuente, y el uso de esa tecnología. Llevamos más de

un año y medio cerrando el negocio, pensamos que todo sería de un mes para otro, pero por suerte, al leer las propuestas técnicas de lo que ambos queríamos hacer, aceptaron, y

no sólo eso, sino que disminuyeron el valor de la tecnología

como en un 70%. Después nos pidieron imágenes de lo que

estábamos haciendo, cuando las vieron, nos ofrecieron su

tecnología a cambio de regalías cuando el juego estuviera

terminado. Luego de un par de semanas trabajando echaron

un vistazo a lo que estábamos haciendo, se dieron cuenta

que sí cumplíamos lo prometido, así que nos ofrecieron hacer

un juego en conjunto, y de ahí arrancamos.

¿Cómo dieron a conocer su trabajo en la industria?

En uno de los eventos más importantes de la industria de videojuegos, el GDC (Game Developers Conference), cuando lo

hicimos, causamos un gran impacto, e incluso, compañías de

talla mundial como Epic Games, dueña de uno de los mejo-

res motores gráficos llamado Unreal Engine 3, al ver nuestro

trabajo, decidió que usáramos su tecnología para desarrollar

el videojuego. Después conseguimos un publisher que nos financiara, y ahora estamos por terminar nuestros dos primeros

juegos: Monster Madness y CellFactor, uno lo terminamos en

diciembre, el otro en febrero.

¿Cuál es tu apreciación de Latinoamérica en el mundo

del desarrollo de videojuegos?

Desde el punto de vista, ya no tanto de lo artístico o técnico,

sino desde el punto de vista productivo, y en muchas conferencias he dicho lo mismo, el hecho de que estemos en

países en vías de desarrollo, ha provocado que aprendamos

a utilizar muy bien los poco recursos con los que contamos.

Queremos dar la oportunidad que nunca tuvimos. Sabemos

que en Latinoamérica hay muchos entusiastas, hay mucha

gente que quiere hacer videojuegos, pero desafortunadamente, dependiendo de dónde quieras competir, los niveles

que se necesitan de conocimiento son bastante fuertes, y

queremos que la gente se entere de eso, que hay una gran

oportunidad, pero que no se puede aprovechar si no has

desarrollado el conocimiento suficiente, que por el hecho

de que a ti te gusten los videojuegos o tengas una gran visión alrededor del tema o tengas el empuje o el dinero, no

significa que seas la persona indicada para hacerlo. El truco

está en que armes equipo de gente muy talentosa y que si

tú eres programador, y has programado algo para videojuegos, pero sabes que a tu nivel le falta, y terminas encontrándote con otra persona que hace cosas en un fin de semana

y todas son geniales, pues hazte a un lado, mantente en el

equipo, pero deja que sea él el que lo haga, y lo mismo en

la parte artística.

Tengo entendido que quieren impulsar la industria en

Latinoamérica, platícanos un poco al respecto.

Queremos trabajar muy fuerte para desarrollar la industria en Latinoamérica. Hemos encontrado en NAGA (National Gamers Association) un punto de apoyo para crear

una serie de programas, que por ejemplo, nos permitan

compartir todo el conocimiento que hemos adquirido.

Desarrollar programas de capacitación, pero no sólo eso,

también hacer que la industria mundial comience a dirigir la mirada hacia nosotros; que nos vean como un mercado interesante.

ERNESTO GÁLVEZ

Nacido, radicado en Colombia e ingeniero de profesión, es el CEO y socio fundador de

Immersion Games, junto a otras tres personas. Está encargado de la ingeniería de producción que está relacionada con el uso de las máquinas y los procesos para producir

cualquier clase de producto. En sus propias palabras: “Siempre he sido conciente de

que la universidad lo que hace es darte criterios y volverte una persona racional para

solucionar problemas y al final puedes terminar en cualquier área”.

www.immersionsoftware.com www.cellfactorgame.com www.monster-madness.com

www.softwareguru.com.mx

De

s

o

g

e

u

oj

e

d

o

l

l

sarro

e

d

i

V

el

Por Jo

ana

Villagr

bía

pre hante,

m

e

i

s

os, y

alme

eojueg ar uno. Fin spués de

nde

d

ó

i

v

D

s

r

cre

; de

o lo

,

¿Po

gustad roceso para esarrollarlos er proyecto é

n

a

h

me

el p

enc

rad

prim

iempre de cómo eso de aprenderfecto como ntonces comscasa;

s

o

ñ

i

esde n curiosidad e era tiemp eojuego pe mpiezo?” E s era muy e guaje

tenidoos, decidí qunutos un vidpor dónde euel entonce r: “¿Qué len ¿qué

ui

aq

¿Y

añ

mi

al?,