Tema 7

Anuncio

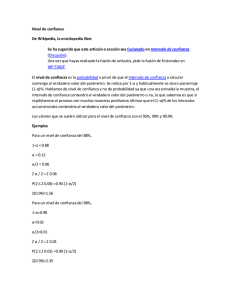

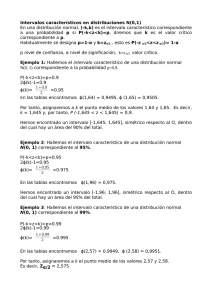

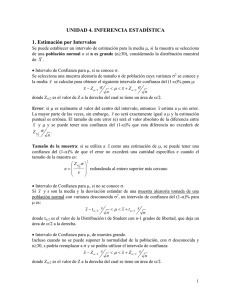

ESTIMACIÓN TEMA 5: Estimación puntual I. Propiedades de los estimadores TEMA 6: Estimación puntual II. Métodos de estimación puntual TEMA 7: Estimación por intervalos CONTRASTES DE HIPÓTESIS TEMA 8: Contrastes paramétricos TEMA 9: Contrastes no paramétricos MODELOS DE REGRESIÓN TEMA 10: Introducción a la Econometría 1 TEMA 7: ESTIMACIÓN POR INTERVALOS 7.1. Concepto de intervalo de confianza 7.2. Métodos de construcción de intervalos ⇒ 7.2.1. Método del pivote 7.2.2. Intervalos aproximados para E(X) 7.3. I.C. en una población normal ⇒ 7.3.1. I.C. para µ con varianza conocida 7.3.2. I.C. para µ con varianza desconocida 7.3.3. I.C. para la varianza 7.4. I.C. en dos poblaciones normales MUESTRAS INDEPENDIENTES: 7.4.1. I.C. para µ1-µ2 (σ1,σ2 conocidas) 7.4.2. I.C. para µ1-µ2 (σ1=σ2 desconocidas) 7.4.3. I.C. para µ1-µ2 (σ1≠σ2 desconocidas) 7.4.4. I.C. para cociente de varianzas MUESTRAS PAREADAS : I.C. para µ1-µ2 7.5. Intervalos de confianza para proporciones 2 ANTECEDENTES Inferencia Estadística: Tenemos una muestra (x1,...,xn). A partir de ella ¿qué conclusiones podemos sacar del modelo que los genera?. Ejemplo: Urna con bolas rojas/negras ⇒ ¿Inferencias sobre p=p(Roja)? POBLACIÓN/MODELO XXXXXXXXXXXX XXXXXXXXXXXX XXXXXXXX xxxx MUESTRA 1 si ocurreRoja → p → 0 si ocurre Negra → 1 − p ⎩ Modelo: Xi= ⎧⎨ v.a. i=1,…,n Realización de la muestra: (x1,...,xn)=(1,1,0,1,0,…,0,1)⇒ ¿ p̂ ? ¿p<0.5? Estimación puntual: proponer un valor plausible para el parámetro desconocido, p, calculado como una función de la muestra, p̂ = p̂ (X1,...,Xn). 3 7.1. CONCEPTO DE INTERVALO DE CONFIANZA Objetivo: no proporcionar sólo una estimación puntual del parámetro p, sino un rango de posibles valores para p, entre los cuales “confiamos” se hallará el verdadero valor del parámetro. ⇓ “más vale acertar aproximadamente que equivocarse completamente” ⇓ límite inferior: estimador “por defecto” límite superior: estimador “por exceso” ⇓ ENCUESTAS 4 Definición: Sea (X1,...,Xn) m.a.s. de una distribución F(x;θ) p( ϑˆ 1 (X1,..., X n ) ≤ θ ≤ ϑˆ 2 (X1,..., X n ) )=1-α ¡¡ [ ϑ̂1 , ϑ̂2 ] es aleatorio: depende de la muestra !! Ejemplo: (X1,...,X50) m.a.s. de una distribución N(µ,σ) ⇒ _ X − µ σ / n → N(0,1) 0.95 -1.96 -1.96 Caso particular: σ=10 ⇒ 0.95=p(-1.96≤ X−µ ≤1.96)=p( X -2.77≤µ≤ X +2.77) 10/ 50 5 Interpretación: El intervalo [ X -2.77, X +2.77] es ALEATORIO: depende de la muestra (X1,...,X50). Al cambiar la muestra (otro valor X ) cambiaría el intervalo. Con una muestra concreta, (x1,...,x50), con su media muestral, ¾ p.e. x =70 ⇒ intervalo numérico. 70±2.77= [67.23, 72.77] ¡contendrá o no a µ! ¾ p.e. x =68 ⇒ intervalo numérico. 68±2.77= [65.23, 70.77] ¡contendrá o no a µ! Esto nunca lo sabremos, pero tenemos un nivel de confianza grande, 95%, en que lo contendrá. ¿Qué significa un nivel de confianza 0.95? ⇒ Si tomáramos todas las muestras de tamaño n=50 posibles y construyéramos con cada una de ellas el intervalo [ x -2.77, x +2.77], el 95% de estos intervalos contendría el verdadero valor de µ. 6 7 Confianza y precisión (poca longitud): Aumentar el nivel de confianza ⇒ ampliar el intervalo (más probable acertar apostando por un rango amplio de valores) ⇒ información irrelevante pero certera ⇒ poca precisión. mayor nivel confianza ⇔ menor precisión menor nivel confianza ⇔ mayor precisión Solución: Fijar (1-α) y buscar I.C. longitud mínima 8 7.2. MÉTODOS DE CONSTRUCCIÓN DE INTERVALOS 7.2.1. Método del pivote ⇒ PIVOTE: T(X1,...,Xn;θ) Función de la muestra y del parámetro θ Continua y estrictamente monótona en θ Distribución muestral conocida que no depende del parámetro Fijado 1-α, encontrar a,b tales que: p( a≤ T(X1,...,Xn;θ) ≤ b ) = 1-α y luego despejar θ ⇒ p( ϑ̂1 (X1,...,Xn;a) ≤ θ ≤ ϑ̂2 (X1,...,Xn;b) )= 1-α ¾ ¿Cómo elegir a y b? Para que el intervalo sea de longitud mínima ¾ Si distribución de T simétrica, dejando α/2 a ambos lados 9 Ejemplo: (X1,...,Xn) m.a.s. de una N(µ,σ), con σ conocido ⇒ PIVOTE: X − µ → N(0,1) σ/ n α/2 α/2 1-α -zα/2 0 zα/2 1-α = p(-zα/2≤ X − µ ≤zα/2)=p( X -zα/2 σ/ n ⇒ Intervalo de Confianza 100(1-α)%: X ± zα/2 σ ≤µ≤ X +zα/2 σ ) n n σ σ ⇒ Simétrico, longitud =2 zα/2 n n L depende de: (1) α ⇒ (1-α)↑ ⇒ zα/2↑ ⇒ más longitud ⇒ menos precisión (2) n : si n aumenta ⇒ disminuye L ⇒mayor precisión (3) σ : si σ aumenta ⇒ aumenta L 10 7.2.2. Intervalos aproximados para la media Sea (X1,...,Xn) m.a.s. de X con E(Xi)=µ y Var(Xi)=σ2 Teorema central del límite: ⇒ X−µ ~ N ( 0,1) n → ∞ σ/ n 1-α ≅ p(-zα/2≤ X−µ σ σ ≤zα/2)=p( X -zα/2 ≤µ≤ X +zα/2 ) σ/ n n n 1-α -zα/2 0 zα/2 I.C. aproximado para E(X) = [ X - zα/2 σ , X + zα/2 σ ] n n Mejor cuanto mayor n y más simétrica la distribución de X NOTA: si σ desconocida ⇒ sustituir por I.C. aproximado = [ X - zα/2 σ̂ , X + n zα/2 σ̂ consistente ⇒otra fuente de “error” σ̂ ] n ¡ más impreciso que el anterior! 11 7.3. INT. CONFIANZA EN UNA POBLACIÓN NORMAL (X1,...,Xn) m.a.s. de una distribución N(µ,σ) 7.3.1. Intervalo de confianza para µ con σ conocida PIVOTE (I.b): [ X - zα/2 X −µ → σ/ n N(0,1) σ σ σ , X + zα/2 ] = ( X ± zα/2 ) n n n Simétrico respecto a X con margen de error E=zα/2 Determinación del tamaño de la muestra ⇒ n = σ n z2 σ 2 α/2 E2 12 7.3.2. Intervalo de confianza para µ con σ desconocida PIVOTE (I.c): X − µ → tn-1, con Sc = Sc / n α/2 α/2 1-α -tα/2 0 1 n (X − X ) 2 i n −1 i∑ =1 tα/2 Sc Sc Sc X−µ 1-α = p(-t α/2≤ ≤t )=p( X -t α/2 ≤µ≤ X +t α/2 ) ⇒ X ± tα/2 n n n Sc / n α/2 Simétrico respecto a X con margen de error E= tα/2 Sc n 2 2 t S Determinación del tamaño de la muestra n = α/2 2 c E 13 Ejemplo: Peña (2001, p. 326) El director de una empresa ha anunciado que el año pasado los salarios crecieron un promedio del 3.5%. Un grupo de trabajadoras toma una muestra de los incrementos salariales que han recibido 11 mujeres obteniendo los siguientes datos: 3%,3%,5%,1%,1%,2%,1%,1%,5%,2%,2%. Intervalo de confianza para el aumento salarial medio de las mujeres de esta empresa. Datos: n=11; X =2,36; Sc = 1 n ∑ (Xi − X )2 =1,5 n − 1 i =1 (1-α)x100=90% ⇒ t α/2 = t10,0.95 =1,812 µ ∈ [2,36 ± 1,12 1,5 ] = [2,36 ± 0.51] ⇒ [1.85; 2.87] 11 No incluye el valor 3,5% entre los “más” probables (1-α)x100=95% ⇒ t α/2 = t10,0.975 =2,228 µ ∈ [2,36 ± 2,228 1,5 ] = [2,36 ± 1.01] ⇒ [1.35; 3.37] 11 No incluye el valor 3,5% entre los “más” probables 14 7.3.4. Intervalo de confianza para la varianza σ2 n PIVOTE (I.d): α/2 i =1 n α/2 1-α a n S2 χ n2 -1, con S X2 = 2 X → σ ∑ (Xi − X ) 2 b n S2 n S2 n S2 2 p(a ≤ σ2 X ≤ b)= p( b X ≤ σ ≤ a X )= 1-α 15 7.4. INT. CONFIANZA DOS POBLACIONES NORMALES MUESTRAS INDEPENDIENTES X11,...,X1n1 m.a.s. de una X1 ~N(µ1,σ1) independientes X21,...,X2n2 m.a.s. de una X2 ~N(µ2,σ2) 7.4.1. Intervalo de confianza para µ1-µ2 (σ1,σ2 conocidas) α/2 -zα/2 1 − α = p( − z α 2 α/2 1-α 0 (X1 − X2 ) − (µ1 − µ2 ) →N(0,1) PIVOTE (II.a): 2 2 σ1 σ2 + n1 n 2 zα/2 ⎡ (X1 − X 2 ) − (µ1 − µ 2 ) α ≤ ≤ z 2 ) ⇒ (µ1-µ2)∈ (X1 − X2 ) ± z α 2 2 2 ⎢ σ1 σ2 + ⎣ n1 n 2 σ12 σ22 ⎤ + n1 n 2 ⎥⎦ 16 7.4.2. Intervalo de confianza para µ1-µ2 (σ1=σ2) PIVOTE (II.b): ( X1 − X 2 ) − (µ1 − µ 2 ) n1SX1 + n 2SX 2 2 2 →t n1 + n 2 − 2 1 + 1 n1 n 2 n1 + n 2 − 2 ⎡ n1S2X1 + n2S2X2 1 1 ⎤ (µ1 − µ2 ) ∈ ⎢(X1 − X2 ) ± t α / 2 +n ⎥ n 1 2⎥ n1 + n2 − 2 ⎢⎣ ⎦ 7.4.3. Intervalo de confianza para µ1-µ2 (σ1≠σ2) PIVOTE (II.c): (X1 − X2 ) − (µ1 − µ2 ) SC2 1 n1 (µ1-µ2)∈ + SC2 2 → tυ ~ N(0,1) si n1,n2 grandes n2 ⎡ ⎢ ⎢( X 1 ⎢ ⎢ ⎣ − X 2 ) ± tα 2 S C2 S C2 1 + 2 n1 n2 ⎤ ⎥ ⎥ ⎥ ⎥ ⎦ 17 RESUMEN: Intervalo de confianza para µ1-µ2 (MUESTRAS INDEPENDIENTES) 7.4.1. Con σ1,σ2 conocidas) ⎡ ⎢ ⎢( ⎢ ⎢⎣ (µ1 - µ2) ∈ X 1 − X 2 ) ± z α / 2 σ12 σ 22 n1 + n 2 ⎤ ⎥ ⎥ ⎥ ⎥⎦ 7.4.2. Con σ1=σ2 desconocidas ⎡ n1S2X1 + n2S2X2 1 1 ⎤ +n ⎥ (µ1 − µ2 ) ∈ ⎢(X1 − X2 ) ± t α / 2 n n1 + n2 − 2 1 2⎥ ⎦ ⎣⎢ 7.4.3. Con σ1≠σ2 desconocidas (µ1 - µ2) ∈ ⎡ ⎢ ⎢( X 1 ⎢ ⎢ ⎣ − X 2 ) ± tα 2 S C2 S C2 1 + 2 n1 n2 ⎤ ⎥ ⎥ ⎥ ⎥ ⎦ 18 Ejemplo: (Newbold, 1998, pp. 263-264) Para una muestra de 96 fumadores, el nº medio de horas mensuales de absentismo laboral fue de 2,15 con una desviación típica de 2,09 horas al mes. En una muestra independiente de 206 no fumadores resultó una media de 1,69 horas con una desviación típica de 1,91 horas al mes. I.C. al 99% para la diferencia de medias Datos: Fumadores: X1=2.15, n1=96, S1=2.09, Sc1=2.101 No fumadores: X 2 =1.69, n2=206, S2=1.91, Sc2=1.915 n1,n2 grandes ⇒ tυ~ N(0,1) ⇒ tα/2≅z0.005=2.575 VARIANZAS DISTINTAS: ⎡ ⎢ ⎢ ⎢ ⎢⎣ 2 (2,15 −1,69) ± 2,575 2,101 + 1,915 96 206 2⎤ ⎥ ⎥ ⎥ ⎥⎦ ⇒ [-0.19, 1.11] VARIANZAS IGUALES: ⎡ 96x2.092 + 206x1.912 1 1 ⎤ + − ± (2.15 1.69) 2,575 ⎢ 96 206 ⎥ + − 96 206 2 ⎣ ⎦ ⇒ [-0.27, 0.99] ⇒ El valor µ1-µ2=0 ∈ intervalos 19 7.4.4. Intervalo de confianza para PIVOTE (II.d): SC2 1 SC2 2 σ 22 σ12 α/2 σ12 / σ 22 α/2 1-α → Fn1 −1,n 2 −1 a b ⎛ ⎞ ⎛ 1 SC2 1 σ12 1 SC2 1 SC2 1 σ22 1 − α = p⎜⎜ a ≤ 2 2 ≤ b ⎟⎟ = p⎜⎜ 2 ≤ 2 ≤ 2 SC2 σ1 ⎝ ⎠ ⎝ b SC2 σ2 a SC2 ⎞ ⎟ ⎟ ⎠ 20 DATOS PAREADOS (X1,Y1)...(Xn,Yn) m.a.s. de Normal bidimensional 2 ⎛ X i ⎞ →N ⎛⎜⎛ µ1 ⎞⎛ σ1 ρσ1σ2 ⎞⎞⎟ ⎜Y ⎟ 2 ⎜ ⎟⎜ 2 ⎟ µ ⎝ i⎠ ⎝⎝ 2 ⎠⎝ρσ1σ2 σ2 ⎠⎠ donde E(Xi)=µ1, E(Yi)=µ2, Var(Xi)= σ12 , Var(Yi)= σ22 7.3.2.5. Intervalo de confianza para µ1-µ2 Diferencias ⇒ Di=Xi-Yi → N(µD,σD), con µD=µ1-µ2 Una sóla muestra D1,D2,...,Dn de una N(µD,σD) D − µD SD / n ⇒ Intervalo de Confianza para µD ⇒ PIVOTE (I.c): → tn-1 n n ∑ Di 1-α = p(-t α/2≤ D − µD ≤t α/2)=p(D∈ D ±t α/2 SD ), donde D = i =1 SD / n n n y SD = ∑ ( Di − D ) 2 i =1 n −1 21 Ejemplo: (Casas, 1996, pp. 248-249) Datos del consumo de gasolina por 1000 km de una muestra aleatoria de 9 cohes con dos carburantes X e Y. Suponiendo normalidad para los consumos, hallar intervalo de confianza al 99% para la diferencia de medias. Coche 1 2 3 4 5 6 7 8 9 1 Xi 132 139 126 114 122 132 142 119 126 n D = ∑ Di =2; SD = n i =1 ¾ 1 Di= Xi-Yi 8 -2 8 -2 8 0 -3 -4 5 n ∑ (Di − D )2 =5.17 n − 1 i =1 (1-α)x100=99% ⇒ t n-1, α/2 = t8,0.005 =3.355 [2 - 3.355x ¾ Yi 124 141 118 116 114 132 145 123 121 5,17 , 9 2 + 3.355x 5,17 ]=[-3.781, 9 7.781] Al 95% ⇒ t α/2 = t8,0.075 =2.306 [2 – 2.306x 5,17 , 9 2 + 2.306x 5,17 ]=[-1.974, 9 5.974] 22 7.4. INTERVALOS DE CONFIANZA PARA PROPORCIONES 7.4.1. Intervalo de confianza (aproximado) para la proporción p 1 si ocurre A (éxito) → p ⎩0 si ocurre A (fracaso) → 1 − p Sea X1,..., Xn m.a.s de una Bernoulli b(p) ⇒ Xi= ⎧⎨ _ p̂ = X n = ∑ Xi i =1 n = proporción “muestral” de éxitos Teorema Central límite: pˆ − p ~ N(0,1) p(1− p) n→∞ n Difícil despejar p: ⇒ Sustituimos por estimador pˆ − p pˆ (1 − pˆ ) n 1-α= ⎛ ⎜ p ⎜ - z α/2 ≤ ⎜ ⎜ ⎝ ⎞ ⎟ pˆ − p ≤ z α/2 ⎟ ⎟ pˆ (1 − pˆ ) ⎟ n ⎠ ~ n →∞ _ p̂ = X consistente N (0,1) = p⎛⎜ pˆ - zα/2 pˆ (1− pˆ ) ≤ p ≤ pˆ + zα/2 pˆ (1− pˆ ) ⎞⎟ n n ⎠ ⎝ ⇒ pˆ ± z α/2 pˆ (1 − pˆ ) n 23 Determinación del tamaño de la muestra Determinar el tamaño muestral n para tener una precisión determinada pˆ (1 − pˆ ) pˆ ± z α/2 n Es un intervalo de la forma margen de error ±E: E = zα/2 p̂ ±E ⇒ centrado en p̂ y simétrico con un 2 z α/2 X(1 − X) pˆ (1 − pˆ ) ⇒ n= E2 n El máximo de X (1- X ) es 1/4 que corresponde a p̂=1- p̂=0.5 (hipótesis más desfavorable de máxima indeterminación p=q=0.5) z 2α/2 ⇒ n= 4E 2 24 Ejemplo: En un determinado país se celebrarán próximamente elecciones generales y sólo se presentarán dos candidaturas A y B. Un mes antes de las elecciones se ha realizado una encuesta de intención de voto a 100 individuos y se han obtenido los siguientes resultados: el 42% prefiere al candidato A, el 50% prefiere a B y el 8% no contesta. (a) Hallar un I.C: para la proporción de individuos que votarán A (95%). (b) Si se hubieran hecho 4000 entrevistas y los % de resultados hubieran sido los mismos, ¿cuál habría sido el I.C.? (c) ¿Cuál debería ser el tamaño muestral necesario para poder estimar con una precisión de ±1% y una fiabilidad del 95%? 25 7.4.2. Intervalo de confianza para la diferencia de proporciones (X1,...,Xn1) m.a.s de b(p1) independientes (X1,...,Xn2) m.a.s de b(p2) Teorema Central límite: p̂1 N( p1, n→∞ ~ p1(1− p1) ); n1 p̂2 n→∞ N( p2 , ~ p2 (1− p2 ) ) n2 Independientes ⇓ pˆ 1 − pˆ 2 ~ n→∞ N( p1 - p2 , p1 (1 − p1 ) p2 (1 − p2 ) + ) n1 n2 Difícil despejar p1-p2: ⇒ Sustituimos p1, p2 por estimadores consistentes PIVOTE: ( pˆ1 − pˆ 2 ) − ( p1 − p2 ) →N(0,1) pˆ1 (1 − pˆ1 ) pˆ 2 (1 − pˆ 2 ) + n1 n2 ⎡ pˆ1(1− pˆ1) pˆ2(1− pˆ2) ⎤ ˆ ˆ − ± z ( p p ) ⇒ (p1–p2)∈ ⎢⎣ 1 2 α/2 n1 + n2 ⎥⎦ 26