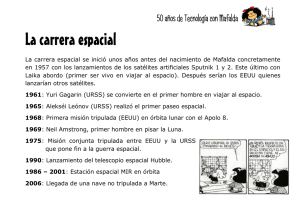

Rumbo al cosmos

Anuncio