Aplicaciones lineales. Diagonalización.

Anuncio

4

APLICACIONES LINEALES. DIAGONALIZACIÓN

DE MATRICES.

En ocasiones, y con objeto de simplificar ciertos cálculos, es conveniente poder

transformar una matriz en otra matriz lo más sencilla posible. Esto nos lleva a

considerar el concepto de matrices semejantes, esto es, matriz obtenidas desde

las de partidas bajo ciertas transformaciones.

Las matrices más cómodas de manipular son las matrices diagonales, dado que

para ellas es posible realizar gran parte de los cálculos matriciales de manera

simple y rápida.

El objetivo de este capı́tulo será encontrar condiciones bajo las cuales existen matrices diagonales semejantes a una matriz cuadrada y, en su caso, la

determinación de dichas matrices diagonales.

4.1

APLICACIONES LINEALES

+ Definición 1 Sean V y W dos espacios vectoriales. Una aplicación f : V → W

se dice lineal si se cumple que

a) f (~u + ~v ) = f (~u) + f (~v ), ∀ ~u, ~v ∈ V.

b) f (λ~u) = λf (~u), ∀ λ ∈ R y ∀~u ∈ V.

Las condiciones a) y b) anteriores pueden resumirse en la siguiente propiedad:

+ Una aplicación f : V → W es lineal si se cumple que

f (λ~u + µ~v ) = λf (~u) + µf (~v ),

∀λ, µ ∈ R, ∀~u, ~v ∈ V.

(4.1.1)

Resultado 4.1

• El vector f (~v ) se llama imagen del vector ~v mediante la aplicación f .

• La aplicación lineal f : V → W también se denomina homomorfismo entre los

espacios vectoriales V y W.

1

2

APLICACIONES LINEALES

- Ejemplo 4.1

• El operador derivada puede considerarse una alicación lineal entre los espacios vectoriales P3 [x] y P2 [x], definiendo la aplicación

D : P3 [x] −→ P2 [x]

p(x) 7→ D(p(x)) = p0 (x)

Las condiciones a) y b) se cumplen trivialmente teniendo en cuenta las propiedades

del operador derivada:

a) D(p(x) + q(x)) = D(p(x)) + D(q(x)),

5x2

b) D(λ p(x)) = λD(p(x)).

La imagen del polinomio p(x) = 3 + 2x −

+

es D(p(x)) = 2 − 10x + 31x2 .

• La aplicación f : R2 → R2 dada por f (x1 , x2 ) = (x1 + x2 , x1 − x2 ) es lineal dado que

se cumple

f ((x1 , x2 ) + (y1 , y2 )) =

=

=

=

=

f (λ(x1 , x2 )) =

=

7x3

f (x1 + y1 , x2 + y2 )

(x1 + y1 + x2 + y2 , x1 + y1 − (x2 + y2 ))

(x1 + x2 + y1 + y2 , x1 − x2 + y1 − y2 )

(x1 + x2 , x1 − x2 ) + (y1 + y2 , y1 − y2 )

f (x1 , y1 ) + f (x2 , y2 )

f (λx1 + λx2 ) = (λx1 + λx2 , λx1 − λx2 )

λ(x1 + x2 , x1 − x2 ) = λf (x1 , x2 ).

• La aplicación f : R → R2 , dada por f (x) = (x, 1) no es lineal, dado que

f (x1 + x2 ) 6= f (x1 ) + f (x2 ).

En efecto, f (x1 + x2 ) = (x1 + x2 , 1), mientras que f (x1 ) + f (x2 ) = (x1 , 1) + (x2 , 1) =

(x1 + x2 , 2), por lo que no se cumple la condición a).

4.1.1

Expresión matricial de una aplicación lineal

Sea f : V → W una aplicación lineal entre los espacios vectoriales V y W cuyas

dimensiones sean dim(V) = n y dim(W) = m. Supongamos que hemos fijado una

base B = {~u1 , ~u2 , . . . , ~un } de V y una base B = {~v1 , ~v2 , . . . , ~vm } de W, entonces se

tiene que

+ la aplicación lineal f : V → W queda determinada si conocemos las imágenes de

los vectores de la base B, es decir, si conocemos f (~u1 ), f (~u2 ), . . . , f (~un ), entonces

podemos determinar fácilmente la imagen de cualquier vector ~x ∈ V.

En efecto, si ~x ∈ V, entonces ~x se podrá expresar de forma única en la forma

~x = x1~u1 + x2~u2 + · · · + xn~un ,

donde como sabemos los números x1 , x2 , . . . , xn se llaman coordenadas del vector ~x

respecto de la base B. Entonces, por las condiciones a) y b) se tiene que

f (~x) = f (x1~u1 + x2~u2 + · · · + xn~un ) = x1 f (~u1 ) + x2 f (~u2 ) + · · · + xn f (~un ). (4.1.2)

La igualdad (4.1.2) nos permitirá dar la expresión analı́tica de cualquier aplicación

lineal. Para ello procedemos de la siguiente manera. Dado un vector ~x ∈ V,

llamemos ~y al vector de W tal que ~y = f (~x).

APLICACIONES LINEALES. DIAGONALIZACIÓN DE MATRICES.

3

Supongamos que

~x = (x1 , x2 , . . . , xn ) respecto de la base B,

~y = (y1 , y2 , . . . , ym ) respecto de la base B.

¿Qué relación existe entre las coordenadas (xi )ni=1 y las coordenadas (yj )m

j=1 ?

Como f (~u1 ), f (~u2 ), . . . , f (~un ) son vectores de W se podrán expresar como combinación lineal de los vectores de la base B, es decir,

f (~u1 ) = a11~v1 + a21~v2 + · · · + am1~vm ,

f (~u2 ) = a12~v1 + a22~v2 + · · · + am2~vm ,

···

··················

f (~un ) = a1n~v1 + a2n~v2 + · · · + amn~vm ,

(Hemos utilizado la notación aij para designar a la coordenada j del vector f (~ui )

respecto de la base B). Ahora, teniendo en cuenta la igualdad (4.1.2), se llega a que

~y = y1~v1 + y2~v2 + · · · + ym~vm

= f (~x) = x1 f (~u1 ) + x2 f (~u2 ) + · · · + xn f (~un )

= x1 (a11~v1 + a21~v2 + · · · + am1~vm ) + x2 (a12~v1 + a22~v2 + · · · + am2~vm )

+ · · · + xm (a1m~v1 + a2m~v2 + · · · + amn~vm )

= (a11 x1 + a12 x2 + · · · + a1n xn )~v1 + (a21 x1 + a22 x2 + · · · + a2n xn )~v1

= + · · · + (am1 x1 + am2 x2 + · · · + amn xn )~vm .

De donde se llega a las igualdades:

y = a11 x1 + a12 x2 + · · · + a1n xn

1

y2 = a21 x1 + a22 x2 + · · · + a2n xn

· · · · · · · · · · · ·

ym = am1 x1 + am2 x2 + · · · + amn xn

que reciben el nombre de ecuaciones cartesianas de la aplicación lineal. Las igualdades anteriores pueden también expresarse en forma vectorial

y1

a11

a12

a1n

y2

a

a

a

. = x1 .21 + x2 .22 + · · · + xn 2n

..

..

..

... ,

ym

am1

am2

amn

y en forma matricial

x1

a11 a12 · · · a1n

y1

y2 a21 a22 · · · a2n x2

. .

. = .

(4.1.3)

..

..

..

.. ..

.

.

. ..

xn

am1 am2 · · · amn

ym

La matriz

a11 a12 · · · a1n

a21 a22 · · · a2n

,

A=

..

..

..

...

.

.

.

am1 am2 · · · amn

se llama matriz asociada a la aplicación lineal f .

4

APLICACIONES LINEALES

La ecuación (4.1.4) se llama ecuación matricial de la aplicación lineal f y se puede

escribir abreviadamente en la forma

~y = f (~x) = A~x.

(4.1.4)

Observación 4.1 La matriz A asociada a la aplicación lineal f : V → W es de

dimensión m × n y que sus vectores columna son precisamente las coordenadas de

los vectores f (~u1 ), f (~u2 ), · · · , f (~un ) respecto de la base B.

- Ejemplo 4.2

• Consideremos la aplicación lineal f : P3 [x] → P2 [x] dada por f (p) = D(p) donde D

es el operador derivada. Para determinar la expresión analı́tica de f necesitamos

fijar una base en B en P3 [x] y una base B en P2 [x].

En nuestro caso podemos tomar B = {1, x, x2 , x3 } y B = {1, x, x2 }. Cualquier

polinomio p(x) ∈ P3 [x] puede entonces escribirse en la forma

p(x) = a0 + a1 x + a2 x2 + a3 x3

y cualquier polinomio q(x) ∈ P2 [x] en la forma

q(x) = b0 + b1 x + b2 x2 .

Tenemos definida una aplicación lineal f de tal forma que a un polinomio p(x) ∈

P3 [x] le hace corresponder un polinomio q(x) ∈ P2 [x], es decir,

f

a0 + a1 x + a2 x2 + a3 x3 −→ b0 + b1 x + b2 x2 .

Determinar la expresión de la aplicación f es sencillamente buscar la relación que

hay entre los coeficientes (bi ) y los coeficientes (ai ). Es decir, cómo determinar los

coeficientes bi si conocemos los coeficientes ai . En nuestro caso es relativamente

simple dado que al ser f el operador derivada

D

a0 + a1 x + a2 x2 + a3 x3 −→ a1 + 2a2 x + 3a3 x2 ,

de donde se deduce directamente que

b0 = a1 , b1 = 2a2 , b2 = 3a3 ,

que se puede expresar matricialmente en la forma

à ! Ã

! a0

b0

0 1 0 0

a

b1 = 0 0 2 0 1 .

a2

b2

0 0 0 3

a3

La matriz asociada a la aplicación lineal f es en este caso, la matriz

Ã

!

0 1 0 0

A= 0 0 2 0

0 0 0 3

de dimensión 3 × 4.

Siguiendo las indicaciones dadas en esta sección, otra forma de determinar la matriz

A serı́a encontrar las imágenes de los vectores de la base B. En nuestro caso, la base

B viene dada por los vectores {1, x, x2 , x3 } cuyas imágenes son:

f (1)

f (x)

f (x2 )

f (x3 )

=

=

=

=

D(1) = 0 = 0 · 1 + 0 · x + 0 · x2 ←→ f (1) = (0, 0, 0) respecto de B

D(x) = 1 = 1 · 1 + 0 · x + 0 · x2 ←→ f (x) = (1, 0, 0) respecto de B

D(x2 ) = 2x = 0 · 1 + 2 · x + 0 · x2 ←→ f (x2 ) = (0, 2, 0) respecto de B

D(x3 ) = 3x2 = 0 · 1 + 0 · x + 3 · x2 ←→ f (x3 ) = (0, 0, 3) respecto de B

APLICACIONES LINEALES. DIAGONALIZACIÓN DE MATRICES.

Por tanto, la matriz asociada a la aplicación f

Ã

0 1 0

A= 0 0 2

0 0 0

5

será

!

0

0

3

donde como puede observarse, las columnas de la matriz A son precisamente las

coordenadas de los vectores f (1), f (x), f (x2 ) y f (x3 ) respecto de la base B.

La expresión (4.1.4) sirve además para caracterizar las aplicaciones lineales entre un

espacio vectorial V de dimensión m y un espacio vectorial W de dimensión n. En

ocasiones, esta caracterización puede resultar más fácil que comprobar si se cumplen

las condiciones de linealidad a) y b) dadas en la definición 4.1.

+ Resultado 4.1.1 Sean V y W dos espacios vectoriales tales que dim(V) = n

y dim(V) = m. Una aplicación f : V → W es lineal si, y solamente si, se puede

expresar en la forma

f (~x) = A ~x,

(4.1.5)

donde A ∈ Mm×n (R).

Nota: En la expresión (4.1.5) estamos identificando el ~x con el vector columna

de Rm cuyas coordenadas son las coordenadas del vector ~x respecto de la base B

considerada en V.

- Ejemplo 4.3

• Se considera la aplicación f : R2 → R2 definida por

f (x, y) = (x cos φ − y senφ, x sen φ + y cos φ)

donde φ ∈ [0, 2π]. Para probar que f es una aplicación lineal basta ver si es posible escribirla en forma matricial. En nuestro caso, utilizando notación de vector

columna,

µ ¶ µ

¶ µ

¶µ ¶

x

x cos φ − y senφ

cos φ − sen φ

x

f

=

=

,

y

x sen φ + y cos φ

sen φ cos φ

y

luego f es una aplicación lineal. Observemos que si consideramos en R2 la base

canónica, B = {~e1 , ~e2 }, entonces

f (~e1 ) = f (1, 0) = (cos φ, sen φ),

f (~e2 ) = (− sen φ, cos φ),

son precisamente las columnas de la matriz asociada a la aplicación.

• La aplicación f : R2 → R2 dada por f (x, y) = (x + 2y, x + y + 1) no es lineal, dado

que no es posible expresarla en la forma (4.1.5)

µ ¶ µ

¶ µ

¶µ ¶

x

x + 2y

1 2

x

f

=

=

.

y

x+y+1

¿? ¿?

y

6

APLICACIONES LINEALES

4.2

NÚCLEO E IMAGEN DE UNA APLICACIÓN LINEAL

4.2.1

Núcleo de una aplicación lineal

+ Definición 2 Sea f : V → W una aplicación lineal entre los espacios vectoriales

V y W. Se define el núcleo de f y se denota por Ker(f ) al conjunto

Ker(f ) = {~x ∈ V : f (~x) = ~0}.

- Ejemplo 4.4

• Consideramos la aplicación lineal f : R3 → R2 definida por

f (x1 , x2 , x3 ) = (x1 − x2 , x2 − x3 ),

Entonces

½

3

Ker(f ) = {(x1 , x2 , x3 ) ∈ R : f (x1 , x2 , x3 ) = (0, 0)} ⇒

Resolviendo el sistema anterior se obtiene

(

à !

à !

x1 = λ

x1

1

x2 = λ ⇐⇒ x2 = λ 1 ,

x3 = λ

x3

1

x1 − x2 = 0

x2 − x3 = 0

λ ∈ R,

es decir, Ker(f ) es el subespacio vectorial de R3 generado por el vector {(1, 1, 1)}.

+ Propiedad 4.2.1 El núcleo de una aplicación lineal, f : V → W, es un subespacio vectorial de V.

Si la aplicación lineal viene dada en forma matricial como

f (~x) = A ~x

entonces el Ker(f ) viene determinado por las soluciones del sistema lineal homogéneo

A ~x = ~0.

(4.2.6)

Como una consecuencia inmediata de Propiedad 4.2.1 se obtiene que el conjunto de

soluciones de un sistema lineal homogéneo (de m ecuaciones y n incógnitas) forman

un subespacio vectorial de Rn que se denomina NullSpace de la matriz A (donde A

es la matriz de coeficientes del sistema).

Si Ker(f ) = {~0} se dice que la aplicación lineal f : V → W es un monomorfirmo.

- Ejercicio 4.5

• Probar que si f : V → W es un monomorfismo, entonces f es una aplicación inyectiva, es decir, se cumple que

~u 6= ~v ⇒ f (~u) 6= f (~v ).

APLICACIONES LINEALES. DIAGONALIZACIÓN DE MATRICES.

4.2.2

7

Imagen de una aplicación lineal

+ Definición 3 Sea f : V → W una aplicación lineal entre los espacios vectoriales

V y W. Se define la imagen de f y se denota por Im(f ) al conjunto

Im(f ) = {~y ∈ W : ~y = f (~x) para algún ~x ∈ V}.

Supongamos que hemos fijado una base B = {~u1 , ~u2 , . . . , ~un } en V. Entonces, si

~y ∈ Im(f ), la igualdad (4.1.2) nos asegura que

~y = f (~x) = f (x1~u1 + x2~u2 + · · · + xn~un ) = x1 f (~u1 ) + x2 f (~u2 ) + · · · + xn f (~un )

lo que nos dice que cualquier vector ~y ∈ Im(f ) puede ponerse como combinación

lineal de los vectores f (~u1 ), f (~u2 ), . . . , f (~un ), lo que nos permite enunciar la siguiente

propiedad:

+ Propiedad 4.2.2 Si B = {~u1 , ~u2 , . . . , ~un } es una base de V, entonces la imagen

de una aplicación lineal f : V → W es el subespacio vectorial de W generado por

los vectores f (~u1 ), f (~u2 ), . . . , f (~un ).

- Ejemplo 4.6

• Sea f : R4 → R3 la aplicación lineal dada en forma matricial por

à ! Ã

! x1

y1

1 −1

2 0

x

y2 = 2

0 −1 1 2 .

x3

y3

3 −1

1 1

x4

Si tomamos una base B = {~u1 , ~u2 , ~u3 , ~u4 } de R4 , entonces un sistema de generadores

de Im(f ) vendrá por los vectores {f (~u1 , f (~u2 ), f (~u3 ), f (~u4 )}. Tomando

~u1 = (1, 0, 0, 0),

~u2 = (0, 1, 0, 0),

es decir, la base canónica en

f (~u1 ) = (1, 2, 3),

R4 ,

~u3 = (0, 0, 1, 0),

~u4 = (0, 0, 0, 1),

se tiene que (ver observación 4.1)

f (~u2 ) = (−1, 0, −1),

f (~u3 ) = (2, −1, 1),

f (~u4 ) = (0, 1, 1).

Luego,

Im(f ) = h(1, 2, 3), (−1, 0, −1), (2, −1, 1), (0, 1, 1)i.

Para determinar una base de Im(f ) hemos de seleccionar aquellos vectores que sean

linealmente independientes. Para ello podemos calcular el rango de la matriz formada por ellos, es decir,

Ã

!

1 −1

2 0

0 −1 1 .

rango 2

3 −1

1 1

(¿Té suena de algo esta matriz?) En nuestro caso, rango(A) = 2, por lo que sólo

hay dos vectores linealmente independientes. Por otra parte, el menor formado por

las 2 primeras filas y las 2 primeras columnas es distinto de cero

¯

¯

¯ 1 −1 ¯

¯ = 2 6= 0,

¯

¯2

0¯

por lo que una base de Im(f ) viene determinada por los vectores {(1, 2, 3), (−1, 0, −1)}.

Podemos entonces decir que dim(Im(f )) = 2.

8

APLICACIONES LINEALES

Si Im(f ) = W se dice que la aplicación lineal f : V → W es sobreyectiva o que es

un epimorfirmo.

4.2.3

Teorema de la dimensión

+ Resultado 4.2.1 Sea f : V → W una aplicación lineal entre los espacios vectoriales V y W. Entonces se cumple que.

dim(Ker(f )) + dim(Im(f )) = dim(V).

- Ejercicio 4.7

• Se considera la aplicación f : M2×2 (R) → R2 dada por f (A) = (1, −1)A.

a) Hallar f (A), f (B), f (C) donde

µ

¶

µ

¶

1 0

1 −2

A=

, B=

,

0 1

2 −1

b)

c)

d)

e)

4.2.4

µ

C=

1 1

1 1

¶

.

Probar que es una aplicación lineal.

Encontrar la matriz asociada.

Determinar el núcleo y la imagen de f .

Comprobar que se cumple el Resultado 4.2.1.

Isomorfismos de espacios vectoriales

+ Definición 4 Si Im(f ) = W se dice que la aplicación lineal f : V → W es

biyectiva o que es un isoformismo si se cumple que

i) f es un monomorfismo, es decir, Ker(f ) = {~0}.

ii) f es un epimorfirmo, es decir, Im(f ) = W.

Si f : V → W es un isomorfismo se dice que los espacios vectoriales V y W son

isomorfos y se simboliza en la forma

V ' W.

Desde un punto de vista algebraico, el hecho de que f : V → W sea un isomorfismo

significa que los espacios vectoriales V y W pueden ‘identificarse’, es decir, son

esencialmente el mismo.

Si dim(V) = n y B = {~u1 , ~u2 , . . . , ~un } es una base de V entonces sabemos que

cualquier vector ~x ∈ V puede escribirse de forma única en la forma

~x = x1~u1 + x2~u2 + · · · + xn u~n .

Los números x1 , x2 , . . . , xn son las coordenadas del vector ~x respecto de la base B.

Esto nos permite definir una aplicación lineal f : V → Rn dada por

f : V −→ Rn

~x 7−→ (x1 , x2 , . . . , xn ).

(4.2.7)

APLICACIONES LINEALES. DIAGONALIZACIÓN DE MATRICES.

9

- Ejercicio 4.8

• Probar que la aplicación lineal dada en (4.2.7) es un isomorfismo entre los espacios

vectoriales V y Rn .

De acuerdo con el resultado del Ejercicio 4.7 podemos enunciar el siguiente resultado:

+ Resultado 4.2.2 Todo espacio vectorial V tal que dim(V) = n es isomorfo a

Rn .

- Ejemplo 4.9

• El espacio vectorial P2 [x] de los polinomios de grado menor o igual que 2 es isomorfo

a R3 .

Si tomamos la base B = {1, x, x2 } de P2 [x], cualquier polinomio p(x) ∈ P2 [x] puede

escribirse de forma única como

p(x) = a0 + a1 x + a2 x2 ,

es decir, (a0 , a1 , a2 ) son las coordenadas del polinomio p(x) = a0 +a1 x+a2 x2 respecto

de la base B. Por tanto, podemos establecer el isomorfismo

f

:

P2 [x]

−→ R3

2

a0 + a1 x + a2 x 7−→ (a0 , a1 , a2 ).

Por tanto, podemos decir que

P2 [x] ' R3 .

• El espacio vectorial M2×2 (R) es isomorfo a R4 .

Cualquier matriz A ∈ M2×2 (R) puede escribirse en la forma

µ

¶

µ

¶

µ

¶

µ

¶

µ

¶

a11 a12

1 0

0 1

0 0

0 0

A=

= a11

+ a12

+ a21

+ a22

,

a21 a22

0 1

0 0

1 0

0 1

lo que, en definitiva, viene a decirnos que

½µ

¶ µ

¶ µ

¶ µ

¶¾

1 0

0 1

0 0

0 0

B=

,

,

,

,

0 1

0 0

1 0

0 1

es una base de M2×2 (R). Los números a11 , a12 , a13 , a14 , son precisamente las coordenadas de la matriz A respecto de la base B. Por tanto, podemos establecer el

isomorfismo

f : µM2×2 (R)¶ −→ R4

a11 a12

7−→ (a11 , a12 , a21 , a22 ).

a21 a22

En definitiva, podemos asegurar que

M2×2 (R) ' R4 .

10

4.3

APLICACIONES LINEALES

CAMBIO DE BASE EN UN HOMOMORFISMO

Sea f : V → W una aplicación lineal entre los espacios vectoriales V y W y

supongamos que tenemos una base B = {~u1 , ~u2 , · · · , ~vn } de V y una base B =

{~v1 , ~v2 , . . . , ~vm } de W. La aplicación f se podrá escribir en la forma

~y = f (~x) = A ~x,

(4.3.8)

donde A ∈ Mm×n (R) es la matriz asociada a f respecto de las bases B y B.

Supongamos ahora que hacemos un cambio de base en V pasando de la base B a la

base B 0 y que este cambio de base viene dado por la ecuación

~x = P ~x 0 .

(4.3.9)

De igual forma, efectuamos un cambio de base en W pasando de la base B a la base

B 0 dado por la ecuación

~y = Q ~y 0 .

(4.3.10)

¿Cuál será la nueva matriz asociada a f respecto de las nuevas bases B 0 y B 0

A partir de (4.3.8), (4.3.9) y (4.3.10) se obtiene,

~y 0 = Q−1 ~y = Q−1 A ~x = Q−1 A P ~x 0 .

+ La nueva matriz asociada a la aplicación lineal f respecto de las nuevas bases

B 0 y B viene dada por

A0 = Q−1 A P.

(4.3.11)

- Ejemplo 4.10

• Sea f : R2 → R3 la aplicación lineal dada por la ecuación

à ! Ã

!

y1

−1 2 µ ¶

x1

y2 =

0 1

.

x2

y3

−1 0

Si nos indican nada supondremos que en ambos espacios hemos considerado las

bases canónicas, B = {(1, 0), (0, 1)} en R2 y B = {(1, 0, 0), (0, 1, 0), (0, 0, 1)} en

R3 . Supongamos que hacemos un doble cambio de base considerando las bases

B0 = {(1, 2), (1, 1)} en R2 y B 0 = {(1, 1, 0), (0, 1, 1), (1, 0, 1)} en R3 .

Los cambios de base vendrán dados por las ecuaciones

Ã

!Ã ! Ã

! y10

µ

¶µ ¶ µ

¶µ 0 ¶

1

0

0

1

0

1

y

1

x1

1 0

x1

1 1

0 1 0

y2 = 1 1 0 y20 .

=

,

0

0 1

x2

2 1

x2

y3

0 0 1

0 1 1

y30

De donde se deduce que la ecuaciónes del cambio de base vendrán dadas por

µ ¶ µ

µ 0¶

¶µ 0 ¶

x1

x1

x1

1

1

,

=

=P

0

x2

2 −1

x02

x2

0

à ! Ã

! y10

y1

y1

1 0 1

0

0

y2 = 1 1 0 y2 = Q y2 .

y3

0 1 1

y30

y30

APLICACIONES LINEALES. DIAGONALIZACIÓN DE MATRICES.

11

Por tanto, la matriz asociada a la aplicación f respecto de las nuevas bases B0 en

R2 y B 0 en R3 , será

Ã

! Ã

!

¶

1 0 1 −1 −1 2 µ

1 1

0

−1

0 1

A = Q AP = 1 1 0

2 1

0 1 1

−1 0

1

1

1 Ã

!

3

¶

2

2 −2

3

−1 2 µ

2

1

1

1

1

0 1

= −1 − 21 .

= − 21

2

2

2 1

−1 0

0 − 21

1

1

1

−

2

2

2

La nueva expresión de la aplicación f será

0

3

3

y1

µ 0¶

2

0

x1

1

.

y2 = −1 − 2

x02

0

y3

0 − 12

4.4

ENDORMORFISMOS DE ESPACIOS VECTORIALES

+ Definición 5 Una aplicación lineal f : V → V del espacio vectorial V en si

mismo recibe el nombre de endomorfismo.

Dado que el espacio origen y el espacio destino son el mismo, lo usual es considerar

la misma base en ambos espacios. Si suponemos que dim(V) = n y fijamos una base

B = {~u1 , ~u2 , . . . , ~un } en V, la aplicación lineal podrá expresarse en la forma

~y = f (~x) = A ~x,

donde A ∈ Mn×n (R) es la matriz asociada a f respecto de la base B.

4.4.1

Cambio de base en un endomorfismo

Sea B 0 una nueva base en V y supongamos que la ecuación del cambio de base de B

a B 0 venga dada por la matriz P , es decir,

~x = P ~x 0 ,

~y = P ~y 0 .

De acuerdo con (4.3.11), la nueva matriz asociada a la aplicación f será

A0 = P −1 A P.

- Ejemplo 4.11

• Sea f : R3 → R3 la aplicación lineal definida por

à ! Ã

!Ã !

2 −1 −1

y1

x1

y2 = 0

3

1

x2 .

y3

x3

0

1

3

Suponemos que la base considerada en R3 es la base canónica. ¿Cuál será la matriz

asociada respecto de la base B 0 = {(−1, 1, 1), (−1, 1, −1), (1, 1, 1)}?

12

APLICACIONES LINEALES

Puesto que la base de partida es la base canónica, la ecuación del cambio de base

vendrá dado por

à ! Ã

! x01

! y10

à ! Ã

x1

−1 −1 1

y1

−1 −1 1

x2 = −1

1 1 x02 ,

y2 = −1

1 1 y20 .

x3

1 −1 1

y3

1 −1 1

x0

y0

3

3

Por tanto, la matriz asociada a f en la nueva base será

!

! Ã

!Ã

! Ã

Ã

2 0 0

−1 −1 1

−1 −1 1 −1 2 −1 −1

0

−1

−1

1 1 = 0 2 0 .

0

3

1

1 1

A = P A P = −1

0 0 4

1 −1 1

0

1

3

1 −1 1

La nueva expresión de la aplicación f será

0

Ã

! x01

y1

2 0

0

0

0 x02 .

y2 = 0 4

0 0 −2

y0

x0

3

3

En el ejemplo anterior hemos realizado un cambio de base en un endomorfismo f

y hemos conseguido que la matriz asociada a f en la nueva base sea una matriz

diagonal. ¿Podrá siempre conseguirse que mediante un cambio de base la matriz

asociada sea diagonal? En caso de que sea posible, ¿hay alguna forma de determinar

cuál debe ser la base? La siguiente sección está dedicada a dar respuesta a ambas

preguntas.

4.5

DIAGONALIZACIÓN DE MATRICES

+ Definición 6 Una matriz A ∈ Rn se dice diagonalizable si existe una matriz P

tal que

P −1 AP = D (diagonal).

Supongamos que tenemos un endomorfismo f : Rn → Rn cuya matriz asociada

respecto de la base canónica es A y que hemos podido elegir una base

B 0 = {~u1 , ~u2 , . . . , ~un }

en Rn de forma que la matriz asociada a f sea diagonal, es decir,

λ1 0 · · · 0

0 λ2 · · · 0

P −1 AP = D =

.. . .

. .

...

. ..

.

0 0 · · · λn

De la expresión anterior se deduce que

AP = DP.

Ahora bien, las columnas de la matriz P son precisamente las coordenadas de los

vectores ~u1 , ~u2 , . . . , ~un , por lo que

A(~u1 |~u2 | · · · |~un ) = D(~u1 |~u2 | · · · |~un )

La columna j-ésima de la matriz AP se obtiene precisamente multiplicando la matriz

A por la columna j-ésima de la matriz P . De igual forma, la multiplicación a

izquierda por la matriz D (diagonal) equivale a multiplicar cada columna de la

APLICACIONES LINEALES. DIAGONALIZACIÓN DE MATRICES.

13

matriz P por el elemento correspondiente de la diagonal de la matriz D. Por lo

tanto,

(A~u1 |A~u2 | . . . |A~un ) = (λ1~u1 |λ2~u2 | · · · |λn~un ),

de donde se deduce que

A~u1 = λ1~u1 ,

A~u2 = λ2~u2 , · · · , A~un = λ~un .

Esto nos permite establecer el siguiente resultado:

+ Resultado 4.5.1 Una matriz A ∈ Mn×n (R) es diagonalizable si podemos encontrar una base B 0 = {~u1 , ~u2 , . . . , ~un } de vectores de Rn tales que

A ~ui = λi~ui ,

λi ∈ R,

i = 1, 2, . . . , n.

(4.5.12)

Los números reales λi serán precisamente los elementos que figuren en la diagonal

de la matriz D (la matriz diagonal que estamos buscando).

4.5.1

Valores propios y vectores propios de una matriz

El Resultado 4.5.1 nos indica el camino que tenemos que seguir para determinar la

base B. Se trata de encontrar vectores ~u ∈ Rn tales que

A~u = λ ~u,

λ ∈ R.

(4.5.13)

+ Definición 7 Los vectores ~u ∈ Rn que cumplen la condición (4.5.13) se denominan vectores propios de la matriz A asociados al valor λ (que recibe el nombre de

valor propio de la matriz A).

De la igualdad (4.5.13) se obtiene

A~u = λ~u ⇒ A~u − λ~u = ~0 ⇒ (A − λI)~u = ~0,

donde I denota la matriz identidad de orden n. Esto nos asegura que el vector ~u es

solución del sistema homogéneo

(A − λI)~x = ~0.

(4.5.14)

Por tanto, la existencia de vectores ~u conlleva que el sistema anterior tiene solución

distinta de la trivial y, en consecuencia, deberá cumplirse que

det(A − λI) = 0.

(4.5.15)

La ecuación (4.5.15) se denomina ecuación caracterı́stica de la matriz A y sus soluciones son precisamente los valores propios de la matriz.

4.5.1.1 Polinomio caracterı́stico de una matriz. El determinante de la matriz

A−λI es un polinomio de grado n en la variable λ que recibe el nombre de polinomio

caracterı́stico de la matriz A, que notamos por pA (λ),

pA (λ) = det(A − λI).

14

APLICACIONES LINEALES

4.5.1.2 Multiplicidad algebraica de un valor propio. Los valores propios de la

matriz A son las raı́ces del polinomio caracterı́stico. Si conocemos dichas raı́ces el

polinomio se descompone en la forma

pA (λ) = (−1)n (λ − λ1 )nλ1 (λ − λ2 )nλ2 · · · (λ − λk )nλk ,

con nλ1 + nλ2 + · · · + nλk = n, donde los números nλi se denominan la multiplicidad

algebraica del valor propio λi e indican el número de veces que el valor λi aparece

como solución de la ecuación caracterı́stica.

- Ejemplo 4.12

Ã

• Para determinar los valores propios de la matriz A =

2 −1 −1

0

3

1

0

1

3

!

calculamos el

polinomio caracterı́stico

¯

¯

¯ 2 − λ −1

−1 ¯

¯

¯

3−λ

1 ¯ = 0 ⇒ −λ3 + 8λ2 − 20λ + 16.

pA (λ) = det(A − λI) = ¯ 0

¯ 0

1

3−λ ¯

Los valores propios son las raı́ces de este polinomio, es decir, las soluciones de la

ecuación caracterı́stica

½

λ1 = 2 (doble)

3

2

pA (λ) = 0 ⇒ −λ + 8λ − 20λ + 16 ⇒

λ2 = 4 (simple).

El polinomio caracterı́stico se descompone en la forma

pA (λ) = −λ3 + 8λ2 − 20λ + 16 = (−1)3 (λ − 2)2 (λ − 4).

En este caso, la multiplicidad algebraica del valor propio λ1 = 2 es nλ1 = 2 y la de

valor propio λ2 = 4 es nλ2 = 1.

4.5.2

Subespacio propio asociado a un valor propio. Multiplicidad

geométrica

Para determinar los valores propios asociados al valor propio λ hemos de resolver el

sistema dado por

(A − λI)~x = ~0.

(4.5.16)

Como sabemos, las soluciones de un sistema homogéneo determinan un subespacio

vectorial, por lo que los vectores ~x ∈ Rn que satisfacen el sistema (4.5.16) determinarán un subespacio vectorial de Rn . Este subespacio vectorial se denomina

subespacio propio asociado al valor propio λ y lo denotaremos por Vλ , es decir,

Vλ = {~x ∈ Rn : (A − λI)~x = ~0.}

La dimensión de este subespacio se denomina multiplicidad geométrica del valor

propio λ,

mλ = (multiplicidad geométrica de λ) = dim(Vλ ).

APLICACIONES LINEALES. DIAGONALIZACIÓN DE MATRICES.

- Ejemplo 4.13

15

Ã

!

2 −1 −1

3

1 (ver Ejemplo anterior) son

• Los valores propios de la matriz A = 0

0

1

3

λ1 = 2 (doble) y λ2 = 4 (simple). Para determinar el subespacio propio asociado al

valor propio λ1 = 2 hemos de resolver el sistema

(A − λ1 I)~x = ~0.

En nuestro caso

!Ã ! Ã !

0

0 −1 −1

x1

~

~

0

1

1

x

= 0

(A − λ1 I)~x = 0 ⇒ (A − 2I)~x = 0 ⇒

2

0

0

1

1

x3

à !

Ã

!

à !

(

(

x1

1

0

−x2 − x3 = 0

x1 = α

x2 + x3 = 0 ⇒ x2 = −β ⇒ x2 = α 0 + β −1

⇒

0

1

x3

x3 = β

x2 + x3 = 0

lo que nos dice que Vλ1 es el subespacio vectorial generado por los vectores ~u1 =

(1, 0, 0) y ~u2 = (0, −1, 1). Por tanto, la multiplicidad geométrica del autovalor λ1 = 2

será

mλ1 = dim(Vλ1 ) = 2.

Además, el subespacio Vλ1 nos proporciona dos vectores propios ~u1 y ~u2 , linealmente

independientes.

De igual forma para determinar el subespacio propio asociado al valor propio λ2 = 4

hemos de resolver el sistema

Ã

!Ã ! Ã !

−2 −1 −1

x1

0

0 −1

1

x2 = 0

(A − λ2 I)~x = ~0 ⇒ (A − 4I)~x = ~0 ⇒

0

1 −1

x3

0

(

(

à !

Ã

!

−2x1 − x2 − x3 = 0

x1 = −α

x1

−1

−x2 + x3 = 0 ⇒ x2 = α

1 ,

⇒

⇒ x2 = α

x2 − x3 = 0

x3 = α

x3

1

Ã

lo que nos dice que Vλ2 está generado por el vector ~u3 = (−1, 1, 1) y, por tanto, la

multiplicidad geométrica del valor propio λ2 = 4 será

mλ2 = dim(Vλ2 ) = 1.

Además, el subespacio Vλ2 nos proporciona un tercer vector propio linealmente independiente ~u3 = (−1, 1, 1).

Por tanto, la matriz P que nos permite diagonalizar la matriz A vendrá dada por

Ã

!

1

0 −1

1 ,

P = (~u1 |~u2 |~u3 ) = 0 −1

0

1

1

y puede comprobarse fácilmente que

Ã

! Ã

!Ã

!

1

0 −1 −1 2 −1 −1

1

0 −1

−1

0 −1

1

0

3

1

0 −1

1

P AP =

0

1

1

0

1

3

0

1

1

1

1

Ã

!Ã

! Ã

!

1

2

2

2 −1 −1

1

0 −1

2 0 0

1

1 0

3

1

0 −1

1 = 0 2 0 .

= 0 −2 2

0

1

3

0

1

1

0 0 4

1

1

0

2

2

16

APLICACIONES LINEALES

El siguiente resultado nos permite determinar cuándo una matriz es diagonalizable.

+ Resultado 4.5.2 Una matriz A ∈ Mn×n (R) es diagonalizable si y solo si se

cumple que

i) Todos los valores propios de A son reales.

ii) Para todo valor propio λ de A se cumple que mλ = nλ .

- Ejemplo 4.14

!

2 −1 −1

3

1 estudiada en los Ejemplos 4.12 y 4.13 tiene los valores

• La matriz A = 0

0

1

3

propios λ = 1 = 2 (doble) y λ2 = 4 (simple) y se cumple que

mλ1 = nλ1 = 2,

mλ2 = nλ2 = 1.

Por tanto, la matriz A es diagonalizable.

Ã

+ Resultado 4.5.3 Si λ es un valor propio real de una matriz A ∈ Mn×n (R)

entonces se cumple que

1 ≤ mλ ≤ nλ .

(4.5.17)

Como consecuencia inmediata del Resultado 4.5.4 se obtiene el siguiente resultado:

+ Resultado 4.5.4 Si todos los valores propios de una matriz A ∈ Mn×n (R)

son reales y simples, entonces la matriz A es diagonalizable.

- Ejemplo 4.15

• Se considera la matriz

Ã

!

−2 0 0

0 3 0 .

A=

4 0 m

Estudiar para qué valores de m la matriz M es diagonalizable.

Solución: En primer lugar calculamos su polinomio caracterı́stico

¯

¯

¯−2 − λ

0

0 ¯

¯

¯

3−λ

0 ¯ = (−2 − λ)(3 − λ)(m − λ).

¯ 0

¯ 4

0

m − λ¯

Ası́, los valores propios de M (raı́ces del polinomio anterior) son λ1 = −2, λ2 = 3 y

λ3 = m.

A continuación distinguimos los siguientes casos.

a) Si m 6= −2, 3, entonces A tiene tres valores propios distintos y, en consecuencia,

es diagonalizable.

b) Si m = −2, entonces λ1 = −2 tiene multiplicidad algebraica 2. Para calcular su

multiplicidad geométrica calculamos el subespacio propio asociado resolviendo

el sistema

Ã

!Ã ! Ã !

(

à !

à !

0 0 0

x1

0

x1 = α

x1

1

x2 = 0 ⇒ x2 = 0 ⇒ x2 = α 0 ,

(A−λ2 I)~x = ~0 ⇒ 0 5 0

4 0 0

x3

0

x3 = 0

x3

0

APLICACIONES LINEALES. DIAGONALIZACIÓN DE MATRICES.

17

Por tanto Vλ1 está generado por el vector ~u1 = (1, 0, 0), por lo que mλ1 =

dim(Vλ1 ) = 1. Al ser mλ1 6= nλ1 concluimos que la matriz A no es diagonalizable.

c) En el caso m = 3 el valor propio λ1 = −2 tiene multiplicidad algebraica 1 por

lo que, aplicando (4.5.17) se tiene que mλ1 = nλ1 = 1.

Para el valor propio λ2 = 3 su multiplicidad geométrica es 2. Para calcular

su multiplicidad geométrica recurrimos de nuevo a determinar el subespacio

propio asociado resolviendo el sistema:

Ã

!Ã ! Ã !

0

−5 0 0

x1

0 0 0

x2 = 0

(A − λ2 I)~x = ~0 ⇒

0

4 0 0

x3

à !

à !

à !

(

0

0

x1 = 0

x1

⇒ x2 = α ⇒ x2 = α 1 + β 0

x3

0

1

x3 = β

Luego, Vλ2 es el subespacio vectorial generado por los vectores (0, 1, 0) y

(0, 0, 1) y, en consecuencia, mλ2 = dim(Vλ2 ) = 2.

Concluimos que la matriz A es, en este caso, diagonalizable.

En resumen A es diagonalizable cuando m 6= −2.

4.5.2.1 Matrices simétricas. Como sabemos, una matriz simétrica es aquella que

cumple que A = A> . El interés de las matrices simétricas es el siguiente resultado.

+ Resultado 4.5.5

a) Todos los valores propios de una matriz simétrica son reales.

b) Toda matriz simétrica es diagonalizable.

4.6

APLICACIÓN. CÁLCULO DE LA POTENCIA DE UNA MATRIZ

En determinadas ocasiones se requiere el cálculo de la potencia Ak donde A es una

matriz cuadrada y k ∈ N. Salvo casos excepcionales, esta operación puede ser muy

engorrosa. Una de las principales aplicaciones de la diagonalización de matrices es

precisamente el cálculo de la potencia de una matriz. Se base en el hecho de que

para una matriz diagonal siempre se cumple que

k

λ1 0 · · · 0

λ1 0 · · · 0 k

0 λk2 · · · 0

0 λ2 · · · 0

.

=

Dk =

.. . .

.

.. . .

. .

..

...

. ..

. ..

.

.

0 0 · · · λn

0 0 · · · λkn

Supongamos que A ∈ Mn×n (R) es una matriz diagonalizable, entonces existe una

matriz P tal que

P −1 AP = D (diagonal),

de donde se deduce que

A = P DP −1 .

18

APLICACIONES LINEALES

Aplicando la propiedad asociativa de producto de matrices, se tiene

A2 = A · A = (P · D · P −1 ) · (P · D · P −1 ) = P · D2 · P −1 ,

A3 = A2 · A = (P · D2 · P −1 ) · (P · D · P −1 ) = P · D3 · P −1

y, en general,

Ak = P · Dk · P −1 .

El cálculo de Ak se ha reducido considerablemente.

- Ejemplo 4.16

• Supongamos que queremos calcular Ak ,

2

0

A=

0

0

con k ∈ N, siendo

1 −1 0

4 −2 0

.

3 −1 0

4 −4 2

En primer lugar probamos que la matriz A es diagonalizable. En nuestro caso, la

matriz P viene dada por

1 1 0 0

2 0 1 0

,

P =

3 0 1 0

4 0 0 1

siendo

1 0 0 0

0 2 0 0

.

P −1 AP = D =

0 0 2 0

0 0 0 2

Entonces,

1 0 0 0 k 1 1 0 0 −1

1 1 0 0

2 0 1 0 0 2 0 0 2 0 1 0

Ak =

3 0 1 0 0 0 2 0 3 0 1 0

0 0 0 2

4 0 0 1

4 0 0 1

1 0 0 0

1 1 0 0

1 1 0 0 −1

k

0 0

2 0 1 0

0 2

2 0 1 0

=

3 0 1 0 0 0 2k 0 3 0 1 0

4 0 0 1

4 0 0 1

0 0 0 2k

1 0 0 0

1 1 0 0

0 −1

1 0

k

0 0

1 −1 0

2 0 1 0

0 2

1

=

3 0 1 0 0 0 2k 0 0

3 −2 0

4 0 0 1

0

4 −4 1

0 0 0 2k

k

2

2k − 1

1 − 2k 0

0 3×2k − 2 2 − 2k+1 0

=

0 3×2k − 3 3 − 2k+1 0 .

0 2k+2 − 4 4 − 2k+2 2k

APLICACIONES LINEALES. DIAGONALIZACIÓN DE MATRICES.

4.7

19

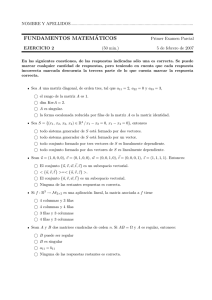

EJERCICIOS PROPUESTOS EN EXÁMENES ANTERIORES

1.- Dado el endomorfismo f : R3 → R3 definido por

f (x1 , x2 , x3 ) = (mx1 + x2 − x3 , x1 + 2x2 + x3 , x1 + 3x2 − x3 ).

a) Calcular la matriz asociada a f respecto de la base canónica.

b) Determinar Ker(f ) e Im(f ), discutiendo el problema según los valores de m.

por bloques, calcular An , siendo A la matriz

..

0

0

.

0

0

0

..

1

0

.

0

0

0

..

0

1

.

0

0

0

··· ··· ··· ··· ··· ···

..

0

0

. 1/2 0 1/2

..

0

0

.

0

1

0

..

0

0

0

.

0

0

1

µ

¶

cos θ sen θ

3.- Dada la matriz T =

, donde θ ∈ [0, 2π], probar que T es

− sen θ cos θ

ortogonal y calcular T n , con n ∈ N.

4.- Determinar si el endomorfismo de f : P3 [x] → P3 [x] definido por

2.- Usando el producto matricial

1

0

0

A = · · ·

0

0

f (a + b x + c x2 + d x3 ) = d + c x + b x2 + a x3 ,

es diagonalizable. En caso afirmativo, determinar la base respecto de la cual la

matriz asociada a f es diagonal.

Ã

!

1 1 0

0 2 0 .

5.- Halla la potencia An de la matriz A =

−2 1 3