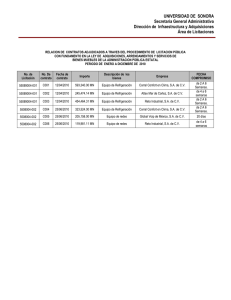

Descargar Aquí.

Anuncio