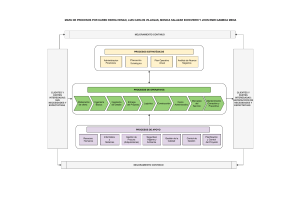

modernizacion gestion por resultados manual base para la evaluacion de politicas publicas 2016

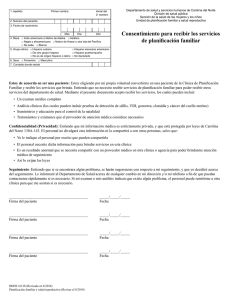

Anuncio