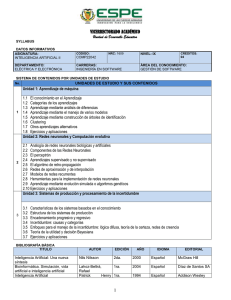

Instituto de Educación Superior Rosario Castellanos Licenciatura en Tecnologías de Información y Comunicación Guía de Estudio Examen Final Sistemas Inteligentes LAIT201 6to Semestre Docente: Ing. Christian Francisco Enríquez Lozano Presentación de la guía El propósito de esta guía es proveer de una herramienta esencial que le permita al estudiante de la asignatura de Sistemas Inteligentes realizar una recapitulación de los temas abordados a lo largo de la asignatura y programar su proceso de aprendizaje para dimensionar en qué temas deberá poner atención para su examen final. Se abordan los puntos de importancia analizados en cada una de las unidades temáticas del curso en la verificación de los aspectos relacionados a la generación de soluciones informáticas utilizando un lenguaje de programación conociendo el proceso de transformación de un lenguaje de alto nivel a un lenguaje entendible por la computadora. Respecto al lenguaje de programación se analizaron los componentes y estructuras para la generación de un programa informático. Objetivos de la asignatura Conocer los conceptos relacionados a los sistemas inteligentes y sus avances relacionados a la inteligencia artificial. Temas por unidad Unidad no 1 Identificación de requerimientos Planeación Diseño del sistema lógico Pruebas Evaluación del usuario Unidad no 2 Sistema de Búsqueda La búsqueda Heurística y sus propiedades Ejemplos de funciones heurísticas El problema del agente viajero Algoritmos Genéticos Aplicación de los algoritmos genéticos Unidad no 3 Metodología de Jackson de eliminación Gaussiana Metodología de Warnier Metodología de Yourdon Unidad no 4 Introducción al aprendizaje automático Redes neuronales Árboles de decisión Estrategias de estudio Estimado estudiante de la materia, te recomiendo de manera previa a la presentación del examen final de la materia analizar la presente guía y realizar un esquema del contenido de cada una de las unidades de la materia, en el esquema puedes aportar conceptos de importancia relacionados al tema de la unidad. Una vez preparado te invito a realizar el examen final de la materia el cual tiene un límite de 1 hora en su realización por lo que te invito a tomar el tiempo y atención adecuadas para su presentación, es importante comentar que se cuentan con dos intentos en esta actividad. Unidad no 1 La Inteligencia Artificial (IA) es una de las ramas de las ciencias de la computación que más interés ha despertado en la actualidad, debido a su enorme campo de aplicación. La búsqueda de mecanismos que nos ayuden a comprender la inteligencia y realizar modelos y simulaciones de estos, es algo que ha motivado a muchos científicos a elegir esta área de investigación. En los años 50 cuando se logra realizar un sistema que tuvo cierto éxito, se llamó el Perceptrón de Rossenblatt. Este era un sistema visual de reconocimiento de patrones en el cual se aunaron esfuerzos para que se pudieran resolver una gama amplia de problemas, pero estas energías se diluyeron enseguida. Aproximadamente en ese tiempo, el matemático inglés Alan Turing (1912-1954) propuso una prueba con la finalidad de demostrar la existencia de “inteligencia” en un dispositivo no biológico. Esta prueba conocida como “test de Turing” se fundamenta en la hipótesis de, si una máquina se comporta en todos aspectos como inteligente, entonces debe ser inteligente (Alan Turing, 1950). Como consecuencia de esta prueba, muchos de los esfuerzos de los investigadores en ese tiempo, se enfocaron en la redacción de sistemas de inteligencia artificial lingüísticos, lo que marcó el nacimiento de los conocidos como “chatbots” (robots de plática). A pesar de que ya se había realizado una investigación sobre el diseño y las capacidades de las entidades no biológicas, el trabajo de Alan Turing de 1950 concentró el interés de la comunidad científica en el desarrollo de las “máquinas inteligentes”. Dos de las contribuciones más importantes de Alan Turing son el diseño de la primera computadora capaz de jugar al ajedrez y el establecimiento de la naturaleza simbólica de la computación (ITAM, 1987). El primer sistema experto o inteligente fue el denominado Dendral, un intérprete de espectrograma de masa construido en 1967, pero el más influyente resultaría ser el Mycin de 1974. La representación del conocimiento experto es una de las tareas más difíciles en la construcción de un sistema basado en el conocimiento, sin embargo, de forma creciente se han incorporado sistemas y procesos informáticos en su diario vivir con el fin de tener una mejor calidad de vida. Existe una clasificación de los modelos de inteligencia Artificial que se basa en el objetivo y la forma en que trabaja el sistema, esta clasificación de manera inicial se veía como clases independientes, sin embargo, en la actualidad los sistemas mezclan características de ellas. (LATIn, 2014). Sistemas que piensan como humanos Sistemas que actúan como humanos Sistemas que piensan racionalmente Sistemas actuantes racionales La prueba de Turing (Alan Turing ,1950) intenta ofrecer una definición de Inteligencia Artificial que se pueda evaluar. Para que un ser o máquina se considere inteligente debe lograr engañar a un evaluador de que este ser o máquina se trata de un humano evaluando todas las actividades de tipo cognoscitivo que puede realizar el ser humano. Si el diálogo que ocurra y el número de errores en la solución dada se acerca al número de errores ocurridos en la comunicación con un ser humano, se podrá estimar -según Turing- que estamos ante una máquina “inteligente”. Conceptos de Sistemas Inteligentes La rama de la computación “machine learning”, trata de crear programas capaces de generalizar comportamientos a partir de una información no estructurada suministrada en forma de ejemplos, promoviendo de esta forma un proceso de creación de conocimiento. Los algoritmos que se utilizan en el machine learning, así como los enfoques para su resolución, son muy variados: modelos estadísticos, teoría de la decisión, redes neuronales, etc. Debido al enorme éxito que tuvieron los sistemas expertos en la década de los 80’s, empezaron a surgir desarrollos conocidos como shells. Un Shell es una pieza de software que provee una interfaz para los usuarios. Un sistema experto posee entre sus componentes las dos herramientas siguientes: Base de conocimientos: El conocimiento relacionado con un problema o fenómeno se codifica según una notación específica que incluye reglas, predicados, redes semánticas y objetos. Motor de inferencia: es el mecanismo que combina los hechos y las preguntas particulares, utilizando la base de conocimiento, seleccionando los datos y pasos apropiados para presentar los resultados. Un Shell es un “sistema experto” que posee una base de conocimientos vacía, pero acompañada de las herramientas necesarias para proveer la base de conocimiento sobre el dominio del discurso de una aplicación específica. Un Shell provee también al ingeniero del conocimiento (encargado de recabar la base de conocimientos) de una herramienta que trae integrado algún mecanismo de representación del conocimiento, un mecanismo de inferencia, elementos que faciliten la explicación del procedimiento o decisión tomados por el sistema experto (componente explicativo) e incluso, algunas veces, proveen una interfaz de usuario. Importancia de los sistemas Inteligente El desarrollo de la inteligencia artificial (IA) es un tema ampliamente debatido a lo largo de las últimas décadas. La intención última es la creación y diseño de entidades capaces de tomar decisiones por sí mismas utilizando como paradigma la inteligencia humana. El enfoque computacional de la inteligencia artificial se fundamenta en la creación de sistemas expertos con gran capacidad de cálculo, aspecto en el que son claramente imbatibles al encontrarse en un orden de desempeño muy superior al de cualquier humano. Esto ha hecho que, en ciertos ámbitos, en aquellos en los que el entorno está bien definido y las reglas de operación se pueden implementar de una forma lógica, como en el juego del ajedrez, los resultados sean espectaculares. Aplicación de los sistemas inteligentes Reconocimiento de patrones, es una de las técnicas fundamentales de cualquier sistema machine learning es el reconocimiento de patrones, que aún es un punto débil en cualquier sistema inteligente. Sin embargo, en los últimos años se ha producido una mejora importante en este tipo de tecnologías y en su comercialización; un ejemplo son los sistemas automáticos de identificación de caras en una foto o los sistemas de atención telefónica automáticos. En el caso del reconocimiento de caras, empresas como Google, Facebook o Apple ya lo incluyen en sus servicios al público. No obstante, el problema fundamental se encuentra en la identificación de patrones más complejos como los de comportamiento, o en entender una conversación en lenguaje natural, lo que se llama NLP (Natural Language Processing). En el primer caso, los sistemas de Big Data como Smart Steps ofrecen una aproximación que está dando buenos resultados; en el segundo existen gran cantidad de empresas que se han especializado en ese tipo de servicios, como Lexalytics , que permite analizar textos de la nube y obtener información, como, por ejemplo, análisis de sentimientos, o Palantir , que permite analizar tuits Automatización del trabajo en el sector primario: La automatización del trabajo en el sector primario ha estado históricamente centrada en la sustitución de actividades manuales muy fatigosas para los trabajadores (arar, cosechar, etc.). Sin embargo, esta automatización está alcanzando a tareas en las que la inteligencia humana dirige la toma de decisiones, como evaluar las condiciones para la siembra o alimentar a los animales y controlarlos sanitariamente. Aplicaciones en las tecnologías de la información: Detrás de la mayoría de los servicios se encuentra el despliegue de tecnologías de comunicaciones que permiten la conexión permanente, sin embargo, nos centraremos en tecnologías de servicio para el usuario, destacando la computación en la nube, el Internet de las cosas, los ambientes inteligentes y el Big Data. Big Data. La generación de cantidades grandes de información; cantidades que no se pueden analizar utilizando los enfoques clásicos. Con el nombre de Big Data se encuadran aquellas técnicas que permiten analizar en tiempo real gran cantidad de datos estructurados y desestructurados que proceden de fuentes de muy diverso tipo. Estas tecnologías permiten obtener un valor de la gran cantidad de datos que se están generando continuamente en una sociedad cada vez más informatizada. Su aplicación es de lo más variada: conocer mejor a los clientes para poder ofrecerles un mejor servicio, contrastar datos que permitan conseguir avances en el conocimiento científico, encontrar fuentes de ineficiencias en los entornos fabriles, etc. Cualquiera de estos usos tiene un impacto económico importante, por ejemplo, se estima que la utilización del Big Data en el entorno fabril de Europa podría sumar 2,2 billones de euros al PIB europeo en 2030. Unidad no 2 Debido a que la búsqueda es el núcleo de muchos procesos inteligentes, es adecuado estructurar los programas de IA de forma que se facilite describir y desarrollar el proceso de búsqueda. Los sistemas de producción proporcionan tales estructuras. Un sistema de producción consiste en: · Un conjunto de reglas. · Una o más bases de datos/conocimiento. · Una estrategia de control que especifique el orden en el que las reglas se comparan con la base de datos, y la forma de resolver los conflictos que surjan cuando varias reglas puedan ser aplicadas a la vez. · Un aplicador de reglas. El proceso de solución del problema puede modelarse como un sistema de producción. El problema que se plantea es escoger la estructura de control apropiada para el sistema de producción (base de datos, hechos, conocimiento o información sobre el problema, conjunto de reglas o aplicado) con el fin de que el proceso de búsqueda sea lo más eficiente posible. Búsqueda La búsqueda en inteligencia pretende resolver los problemas o tareas complejas a través de algoritmos que garanticen la solución del problema o tarea. Los sistemas o las técnicas de búsqueda son una serie de esquemas de representación del conocimiento, que mediante diversos algoritmos nos permite resolver problemas desde el punto de vista de lA. Búsqueda sin información del dominio También se denominan técnicas de búsqueda ciega, porque realizan una búsqueda sistemática y objetiva (en el sentido de que el control del proceso no depende del problema concreto que se esté́ resolviendo). Por el contrario, las técnicas de búsqueda heurística realizan una búsqueda informada e intentan optimizar dicho proceso eligiendo los caminos que a priori van a suponer un menor coste. Búsqueda en amplitud Es aquella estrategia de control en la que se revisan todas las trayectorias de una determinada longitud antes de crear una trayectoria más larga. Es decir, no se genera ningún nodo de nivel N hasta que no se hayan obtenido todos los del nivel N-1. Búsqueda en profundidad Es aquel procedimiento de control en el que se centra en expandir un único camino desde la raíz. En el caso de llegar a un callejón sin salida se retrocede hasta el nodo más cercano desde donde se puede tomar una ruta alternativa para poder seguir avanzando. Búsqueda con retroceso Es una técnica que a diferencia de los algoritmos en amplitud y en profundidad (que consideran todos los sucesores) solamente expande un sucesor en cada iteración, restringiendo por lo tanto el espacio de estados considerado. Cuanto mejor sea el criterio para limitar el número de estados considerados más eficiente será́ el proceso de búsqueda. Es decir, es como el recorrido en profundidad, pero nos ahorramos tener que expandir todos los nodos para obtener sus sucesores. El camino sigue avanzando por ese sucesor, y si nos encontramos con un callejón sin salido retrocedemos hasta el primer antepasado desde el que todavía partan caminos inexplorados. Búsqueda Heurística Las técnicas de búsqueda heurística disponen de alguna información sobre la proximidad de cada estado a un estado objetivo, lo que permite explorar en primer lugar los caminos más prometedores. Las características de las técnicas heurísticas: · No garantizan que se encuentre una solución, aunque existan soluciones · Si encuentran una solución, no se asegura que esta tenga las mejor esas propiedades (que sea de longitud mínima o de coste optimo). La función heurística puede tener dos interpretaciones. Por una parte, la función puede ser una estimación de lo próximo que se encuentra el estado de un estado objetivo. Bajo esta perspectiva, los estados de menor valor heurístico son los preferidos. Pero en otros casos puede suceder que lo que convenga sea maximizar esa función. Algoritmos genéticos Los algoritmos genéticos pertenecen a la computación evolutiva, son considerados también una técnica de inteligencia artificial. A través de millones de años, los organismos han evolucionado biológicamente para sobrevivir y crecer en un mundo cambiante. Los materiales genéticos de todos los organismos vivos consisten de cromosomas que están divididos en genes; su codificación y desarrollo son considerados un proceso clave en la continuación de las especies. El proceso de selección natural y el sobrevivir de los más aptos son considerados elementos importantes en la evolución, que ha sido estudiada desde el siglo XVII. Los Algoritmos Genéticos están basados en estos aspectos de evolución. Para poder explicar la estructura de los algoritmos genéticos voy a introducir primero algunos términos que serán útiles: Individuo: los individuos de nuestra población son las posibles soluciones al problema que estamos tratando. Población: conjunto de individuos (soluciones). Función fitness o de adaptación: función que evalúa a los individuos y les asigna una puntuación en función de lo buenas soluciones que sean para el problema. Función de cruce: función que, dados dos individuos, genera dos ‘descendientes’ a partir de la combinación de genes de sus ‘padres’. Esta función se diseña especialmente para el problema que se esté tratando y, por lo general, se encarga de que los hijos sean mejores soluciones que los padres. La aplicación más común de los algoritmos genéticos ha sido la solución de problemas de optimización, en donde han mostrado ser muy eficientes y confiables. Sin embargo, no todos los problemas pudieran ser apropiados para la técnica, y se recomienda en general tomar en cuenta las siguientes características del mismo antes de intentar usarla: • Su espacio de búsqueda (i.e., sus posibles soluciones) debe estar delimitado dentro de un cierto rango. • Debe poderse definir una función de aptitud que nos indique qué tan buena o mala es una cierta respuesta. • Las soluciones deben codificarse de una forma que resulte relativamente fácil de implementar en la computadora. Unidad no 3 Es el proceso de transformación de éste a un dominio o un lenguaje simbólico para ser procesado en un computador. Es un área de la inteligencia artificial cuyo objetivo fundamental es representar el conocimiento de una manera que facilite la inferencia (sacar conclusiones) a partir de dicho conocimiento. Es una combinación de estructuras de datos (que nos permiten representar mediante un formalismo determinado las "verdades" relevantes en algún dominio) asociadas con mecanismos interpretativos que nos permiten manipular el conocimiento representado a fin de crear soluciones a problemas nuevos. Característica Representación del Conocimiento en Inteligencia Artificial 1.Cobertura, significa que la representación del conocimiento cubre la información en anchura y profundidad. 2. Comprensible por humanos. La representación del conocimiento es vista como un lenguaje natural, así que la lógica debería fluir libremente. 3. Consistencia. Siendo consistente, la representación del conocimiento puede eliminar conocimiento redundante o conflictivo. 4. Eficiencia. 5. Facilidad de modificación y actualización. 6. Soporte de la actividad inteligente que usa la base de conocimiento. Propiedades del Conocimiento en Inteligencia Artificial Voluminoso Difícil de caracterizar con precisión Incierto/impreciso Cambia constantemente Tipos de conocimiento Conocimiento Declarativo Son hechos sobre objetos o situaciones. Posee mayor capacidad expresiva, menor capacidad creativa o computacional. Es conocimiento pasivo, expresado como sentencias acerca de los hechos del mundo que nos rodea (el saber que hacer). Puede ser representado con modelos relacionales y esquemas basados en lógica. Los modelos relacionales pueden representar el conocimiento en forma de árboles, grafos o redes semánticas. Conocimiento Procedimental Es aquel conocimiento compilado que se refiere a la forma de realizar una cierta tarea (el saber cómo hacerlo). Por ejemplo, los pasos necesarios para resolver una ecuación algebraica son expresados como conocimiento procedimental. Los modelos procedimentales y sus esquemas de representación almacenan conocimiento en la forma de cómo hacer las cosas. Pueden estar caracterizados por gramáticas formales, usualmente implantadas por sistemas o lenguajes procedimentales y sistemas basados en reglas (sistemas de producción). Por ejemplo, los pasos necesarios para resolver una ecuación algebraica son expresados como conocimiento procedimental. Conocimiento Heurístico Es un tipo especial de conocimiento usado por los humanos para resolver problemas complejos. El adjetivo heurístico significa medio para descubrir. Está relacionado con la palabra griega heuriskein que significa descubrir, encontrar. Se entiende por heurístico a un criterio, estrategia, método o truco utilizado para simplificar la solución de problemas. Técnicas de Representación Marcos Reglas Etiquetado Redes Semánticas Propiedades del Sistema de Representación Capacidad Expresiva Capacidad Deductiva Eficiencia Deductiva Eficiencia en la Adquisición Formas de representación del conocimiento Una vez que se adquiere (del especialista) el conocimiento, es necesario encontrar una representación simbólica, clara, precisa y completa del mismo. Para ello podemos mencionar que existen diversas formas de representar el conocimiento, como las siguientes: Representación del Conocimiento · · · · Tripletas OAV Redes Semánticas Frames Reglas Redes Semánticas. Ofrecen un esquema más general y desestructurado que las tripletas OAV. Donde cada nodo representa cualquier concepto u objeto, y los arcos representan relaciones que existen entre dichos conceptos Sistemas basados en reglas Hay muchos casos en los que podemos resolver situaciones complejas haciendo uso de reglas deterministas, hasta el punto de su uso consigue sistemas automáticos que se comportan como humanos expertos en un dominio particular permitiendo tomar decisiones delicadas, por ejemplo: en sistemas de control de tráfico, transacciones bancarias, o diagnóstico de enfermedades. En estos sistemas, la base de conocimiento de la que se parte contiene las variables y el conjunto de reglas que definen el problema, y el motor de inferencia es capaz de extraer conclusiones aplicando métodos de la lógica clásica sobre esta base. En un sistema basado en reglas existen dos elementos básicos que sirven para la representación del conocimiento: Conocimiento ● Atributos ● Reglas Diferencia entre información y conocimiento Este conocimiento ha de permitir guiar a los mecanismos de IA para obtener soluciones de manera más eficiente y nos enfrentamos a los problemas de: a) ¿Cómo escoger el formalismo de representación que nos permita hacer una traducción fácil del mundo real a la representación? b) ¿Cómo ha de ser esa representación para que pueda ser utilizada de forma eficiente? Llamaremos información al conjunto de datos básicos, sin interpretar, que se obtienen como entrada del sistema. Por ejemplo: Los datos numéricos que aparecen en una analítica de sangre o los datos de los sensores de una planta química. Llamaremos conocimiento al conjunto de datos de primer orden, que modelan de forma estructurada la experiencia que se tiene sobre un cierto dominio o que surgen de interpretar los datos básicos. Por ejemplo: La interpretación de los valores de la analítica de sangre o de los sensores de la planta química para decir si son normales, altos o bajos, preocupantes, peligrosos o el conjunto de estructuras de datos y métodos para diagnosticar a pacientes a partir de la interpretación del análisis de sangre, o para ayudar en la toma de decisiones de que hacer en la planta química Unidad no 4 Introducción al aprendizaje automático En la actualidad, gracias a los avances de la informática, es posible almacenar y procesar grandes cantidades de datos, así como acceder a datos ubicados físicamente en otras localidades geográficas a través de las redes computacionales. En este contexto aparece el concepto de aprendizaje en informática, denominado también aprendizaje de máquina o automático, que corresponde a programas computacionales que buscan optimizar los parámetros de un modelo usando datos previos o datos de entrenamiento. Los modelos pueden ser inductivos, cuando permiten hacer predicciones sobre el futuro o bien descriptivos cuando permiten generar conocimiento a partir de los datos. El aprendizaje automático usa la teoría estadística para construir modelos matemáticos, pues de esta manera es posible hacer inferencias a partir de una muestra. La ciencia de la computación es requerida en la fase de entrenamiento para la implementación de algoritmos de optimización eficientes, además de ser necesaria en las tareas de almacenamiento y procesamiento de grandes volúmenes de datos. Una vez que un modelo es ajustado, se requiere también eficiencia en su representación y solución algorítmica para la fase de inferencia. Los métodos de aprendizaje automático han jugado un papel importante en la Inteligencia Artificial, desde sus comienzos. Probablemente esto se debe a la probabilidad de aprender, adaptarse y modificar el comportamiento, es un componente fundamental de la inteligencia humana. El aprendizaje automático puede ser: Aprendizaje supervisado Entrada Conjunto de instancias con sus etiquetas asociadas Objetivo A partir de conjunto de entrenamiento etiquetado Construir modelo capaz de predecir la etiqueta de nuevas instancias Distintos tipos Clasificación Regresión La Minería de datos es el concepto acuñado en el mundo del negocio para la aplicación del aprendizaje automático en grandes volúmenes de datos con el objeto de extraer información de los mismos. Aplicaciones de Minería de Datos se han extendido a diversas áreas, como por ejemplo el estudio del comportamiento de consumo de los clientes de un supermercado. En finanzas bancarias los datos históricos se utilizan para construir modelos de riesgo de créditos, detección de fraudes entre otros Redes neuronales Las Redes Neuronales son un paradigma de aprendizaje y procesamiento automático inspirado en la forma en que funciona el cerebro para realizar las tareas de pensar y tomar decisiones (sistema nervioso). El cerebro se trata de un sistema de interconexión de neuronas en una red que colabora para producir un estímulo de salida. Una red neuronal es un modelo computacional, paralelo, compuesto de unidades procesadoras adaptativas con una alta interconexión entre ellas (Hassoun, 1995). Ventajas y desventajas de las Redes Neuronales Artificiales Ventajas Aprendizaje adaptativo en el cual aprende a realizar tareas a partir de un conjunto de datos siendo así que en el proceso de aprendizaje de estos datos sean representados como entradas y pesos. Auto-organización pueden crear su propia organización o representación de la información recibida, las redes neuronales auto-organizan su información que reciben durante el aprendizaje de la operación utilizando los métodos matemáticos Adeline, Madeline y Perceptron entre otros. Tolerancia a fallos parciales sabiendo que la destrucción parcial de la red daña el funcionamiento a la misma, pero no la destruye completamente. Esto es debido a la redundancia de la información contenida, es decir, esto conlleva a que la información no se pierda ya que funciona como el cuerpo humano. Operación en tiempo real, que pueden ser llevadas a cabo por computadoras o dispositivos de hardware especial para aprovechar así la capacidad de las RNA. Desventajas Menciona que las redes neuronales artificiales tienen complejidad para el aprendizaje de tareas grandes. Elevado tiempo de aprendizaje, esto dependerá de, el número de patrones a reconocer y la flexibilidad para reconocer patrones que sean bastante parecidos. (Rivera, 2007, pág. 64). No tiene la capacidad de interpretar los resultados que esta produce siendo necesario por tal razón la interpretación del desarrollador o de la aplicación para que le de significados a tales resultados. Tiempo de convergencia, es decir existen aplicaciones que requieren un enorme conjunto de ejemplos para el entrenamiento lo que se traduce en tiempo de cálculo. Modelos Neuronales En todo modelo artificial de neurona se tienen cuatro elementos básicos: 1. Un conjunto de conexiones, pesos o sinapsis que determinan el comportamiento de la neurona. Estas conexiones pueden ser excitadoras (presentan un signo positivo), o inhibidoras (conexiones negativas). 2. Un sumador que se encarga de sumar todas las entradas multiplicadas por las respectivas sinapsis. 3. Una función de activación no lineal para limitar la amplitud de la salida de la neurona. 4. Un umbral exterior que determina el umbral por encima del cual la neurona se activa. Estructuras neuronales Las redes neuronales se pueden usar en una serie de estructuras según la aplicación a la que está destinado el sistema. Así pues, según la disposición de la red neuronal se tendrán las siguientes estructuras: Estructura directa Estructura inversa Arboles de decisión El tomar una decisión implica servirse en parte (no solo de la información disponible), de la intuición y las emociones. Esto es debido a que la persona tiende a ver desde una perspectiva imparcial la realidad objeto de análisis, tomando una decisión rápida o simple, con los riesgos que este hecho conlleva (Lozano, 2013). Los Árboles de decisión ofrecen un apoyo útil para los directivos, porque sin duda simplificará la toma de decisiones en la empresa, aportando simplicidad y concreción ante una determinada problemática, minimizando los errores. El método árbol de decisión consiste en aquella representación gráfica de una serie de secuencias lógicas que interpretan una realidad, más o menos compleja. Dicha realidad estará desglosada en una o varias secuencias de eventos, ordenados estos según una línea temporal coherente. De este modo, los sucesos más recientes vendrán precedidos por otros anteriores, hilvanados y originando las diferentes alternativas de las que el sujeto se servirá para tomar una decisión al problema planteado. Algunos de estos eventos se conocen como eventos aleatorios; aquellos cuya realización vendrá influida por una probabilidad, causa de la intervención de variables externas al individuo que condicionaran los posibles resultados. Otros sin embargo no, ya que serían decisiones que atañerían exclusivamente al decisor y, por lo tanto, no estarían condicionados por el entorno. Un Árbol de Decisión es una representación gráfica de una serie de secuencias lógicas que interpretan una realidad, más o menos compleja. El árbol de decisión reflejará de forma fiel los pasos que habrá de afrontar una persona, equipo o entidad; ordenados de manera lógica y atendiendo a unas complejidades concretas. Por eso es importante que antes de plantear el árbol de decisión, y con el objeto de llegar a una conclusión más fiable, se haya recogido la máxima información posible, reduciendo así el riesgo. Para poder diagramar un árbol de decisión es necesario diferenciar dos elementos principales: por un lado, los nudos; por otro, las ramas. Bibliografía y Recursos de apoyo lfaomega. ISBN: 970-15-1166-2. Mexico. Rusell & Norving (2003). Inteligencia Artificial. Un enfoque moderno, Segunda Edición. Prentice Hall. Benitez, R., Escudero, G., Kannan, S. y Masip, R. (2010) Inteligencia Artificial Avanzada. España: UOC. García Serrano, A. (2016) Inteligencia Artificial. Fundamentos, práctica y aplicaciones. México: Alfaomega. Pajares G. y Santos M. (2006).Inteligencia Artificial e Ingeniería del Conocimiento. Ponce Cruz, P. (2014) Inteligencia Artificial con aplicaciones en la Ingeniería. México: Alfaomega. Benitez, R., Escudero, G., Kannan, S. y Masip, R. (2010) Inteligencia Artificial Avanzada. España: UOC. García Serrano, A. (2016) Inteligencia Artificial Fundamentos, práctica y aplicaciones. México: Alfaomega. http://ocw.uv.es/ingenieria-y-arquitectura/1-2/libro_ocw_libro_de_redes.pdf Russell Stuart y Peter Norvig (2004) Inteligencia Artificial. Un Enfoque Moderno. PrenticeHall.