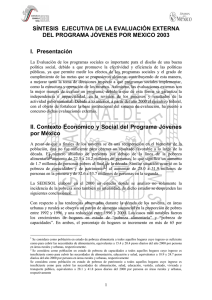

C A P Í

Anuncio

CAPÍTULO 6 RESULTADOS 96. ¿El programa recolecta regularmente información veraz y oportuna sobre sus indicadores de Propósito y Fin? Respuesta: Sí. Por el tipo de indicadores de Propósito y Fin que contiene la Matriz de Marco Lógico del programa, la medición de éstos es anual y en una sola etapa. Es decir, se precisan los datos del cierre de ejercicio para calcularlos en una sola ocasión por año. La veracidad de la información de los indicadores es aceptable en tanto la información proviene de bases de datos levantadas por el programa y conocidas por esta evaluación. En los últimos días del mes de diciembre 2007 el programa había calculado los indicadores del ejercicio 2007 y compartieron los resultados con esta evaluación, mismos que se indican a continuación: INDICADOR RESULTADO UNIDAD DE MEDIDA 1.1 Porcentaje de municipios de la Estrategia 100x100 atendidos por el Programa respecto al total de municipios de la Estrategia 100x100. 44.66 Porcentaje 2.1 Porcentaje de proyectos que atienden localidades en municipios 100x100 respecto al total de proyectos del Programa. 55.86 Porcentaje 2.2 Inversión beneficiarias 15.68 Pesos / cápita per cápita en las localidades Fuente: Cálculo de indicadores de la MML al finalizar el año 2007, proporcionada por el programa el 20 de diciembre 2007. Los indicadores 1.1 y 2.1 tienen metas, sin embargo, están programadas para el año 2010, razón por la cual no se puede comparar el desempeño de estos indicadores respecto a la meta. 101 RESULTADOS 97. ¿El programa ha llevado a cabo evaluaciones externas con metodologías rigurosas que le permitan medir el impacto del programa en la población objetivo (evaluaciones que permitan medir los avances en términos de su Propósito y Fin)? Respuesta: No. La respuesta a esta pregunta tiene dos componentes. En primer término se constata que el programa Jóvenes por México sí ha llevado a cabo evaluaciones externas anteriores a esta. En 2002 por la Universidad Autónoma de Tlaxcala, en 2003 por el Colegio Nacional de Economistas y en 2006 por la Red para el Desarrollo Sostenible de México, A.C. Sin embargo, estas evaluaciones no han sido “rigurosas” en el sentido estricto de esta pregunta, es decir, no han medido el impacto en la población objetivo y no han contado con metodologías de grupo de control.62 Frente a esto es importante hacer algunas precisiones: 1) La evaluación externa 2003 tomó como referencia un grupo de población no beneficiada por el programa, pero con el objetivo de realizar un comparativo entre las percepciones de beneficiarios y no beneficiarios, más no midió impactos del programa; 2) La dificultad de Jóvenes por México en definir su población objetivo,63 ha impedido tener claridad sobre si los impactos deben medirse en los Prestadores de Servicio Social o en los habitantes de las comunidades donde se ejecutan los proyectos, razón que imposibilita una medición de impacto. 3) En 2002 y 2003 la población objetivo estaba definida como: grupos vulnerables, damnificados por desastres naturales y comunidades marginadas, lo cual hubiera hecho demasiado costosa una medición de impacto sobre las condiciones de vida de esta población, evaluación que podría no ser costo –eficiente para un programa de las dimensiones de Jóvenes por México. 62 Esta especificación es realizada en los “Criterios generales para dar respuesta a las preguntas de la Evaluación de Consistencia y Resultados y de Diseño 2007 de los Programas Federales”, de CONEVAL. 63 Problema detectado desde la evaluación externa 2002 en su Capítulo 1, pág. 28. 102 RESULTADOS 98. Con base en las evaluaciones externas, ¿cuáles han sido los principales impactos del programa?* Como se mencionó en la pregunta anterior, las evaluaciones externas no han realizado mediciones rigurosas de impacto del programa Jóvenes por México. Esta evaluación recogió las principales características metodológicas (ver pregunta 46) y los principales resultados encontrados en cada estudio. 2002: Por cada 100 pesos que invirtió el programa, 92 pesos se convirtieron en becas para PSS, la relación beneficio –costo del programa fue de 3.42, calculada por la cantidad de ahorro que se generó tanto para las comunidades donde se ejecutó el proyecto como para las entidades ejecutoras (valorando los PSS igual que un profesionista o técnico), el programa tuvo un cumplimiento favorable de metas físicas y financieras en ese año, la eficacia se mantuvo, mientras que la eficiencia aumentó y los prestadores de servicio social tuvieron una percepción favorable del programa. 2003: El área de estudio de los becarios coincide con su actividad en el servicio social, el programa de servicio social comunitario propicia el arraigo de los prestadores sociales en las microrregiones, no hay evidencia para afirmar que los ingresos por servicio social ayudan a la economía familiar del becario, el 86% de los no beneficiarios del programa manifestaron que los proyectos serían de mucha utilidad, la mayoría de los beneficiarios de los proyectos manifestó que su situación económica o el bienestar de su comunidad mejoró mucho con la realización de los proyectos, el 100% de los becarios están satisfechos con el programa pero no con el estímulo económico recibido, los proyectos más valorados son los grandes de infraestructura y el índice de eficiencia en general fue de 0.93. 2006: La lógica vertical y horizontal de la MML se validó, el 90% de los municipios atendidos por el programa fueron de alta y muy alta marginación y el 89% de la inversión llegó a estos municipios, las acciones de la Unidad Administrativa se apegaron en tiempo y forma a los lineamientos de las ROP, se entregaron apoyos a una proporción demasiado pequeña de la población objetivo, las mujeres aumentaron su participación relativa en 2006 pero no su participación total, la percepción de los operadores del programa fue, en general, catalogada de “buena” y “muy buena”. Fuente: elaboración propia con base en las evaluaciones externas citadas. 103 RESULTADOS 99. ¿El diseño y la operación del programa permiten realizar una evaluación de impacto rigurosa? Si no es así, explicar y proponer los ajustes necesarios para que sean compatibles. Respuesta: No. El diseño actual del programa presenta una dificultad en la definición de su población objetivo que no permite realizar una evaluación de impacto rigurosa. En la población objetivo de las Reglas de Operación64 se encuentran dos grupos distintos, uno denominado beneficiarios, que son los prestadores de servicio social y otro, los sujetos de atención, que son los habitantes de las comunidades donde se ejecutan proyectos. Como se ve, existen dos grupos poblacionales muy distintos dentro de una sola definición de población objetivo. Una evaluación de impacto tendría en frente una limitante para definir en qué grupo mide los resultados del programa y contra qué grupo los compara. Una segunda dificultad consiste en los distintos tratamientos del programa, especialmente porque en algunos de ellos, como los de ordenamiento urbano local, los beneficios son colectivos y difíciles de cuantificar. Finalmente, otro aspecto que obstaculizaría una medición rigurosa de impacto es el bajo presupuesto con el que opera Jóvenes por México. En proporción a los gastos del programa, una evaluación rigurosa de impacto podría no resultar costo – eficiente. Con base en los puntos anteriores esta evaluación propone: 1) Definir claramente la población objetivo, 2) Redefinir el tipo de proyectos que se apoyan con base en los objetivos del programa, 3) Asesorar y monitorear la cuantificación de la población atendida por cada proyecto y 4) Cuestionarse el costo- beneficio de cada tipo de evaluación. 64 Reglas de Operación 2007 del programa Jóvenes por México, numeral 3.2. 104 RESULTADOS 100. Con base en la información obtenida de los distintos instrumentos, ¿el programa ha demostrado adecuado progreso en alcanzar su Propósito y Fin? Especificar los principales resultados. Respuesta: No. El programa Jóvenes por México ha logrado efectos positivos en los prestadores de servicio social y en las poblaciones donde éstos han trabajado. Sin embargo, dificultades en la definición de sus resultados y en la especificación de sus indicadores no permiten demostrar que haya habido progreso. Así, esta pregunta debe contestarse de manera negativa, pero esto se debe más a un problema de diseño que de ejecución. Como se mencionó en el capítulo de Diseño de esta evaluación, el Fin del programa no cuenta con un indicador adecuado para medir su progreso, y el indicador disponible no mide si el programa contribuyó a la generación de oportunidades para los habitantes de las zonas donde se desarrollaron proyectos (ver respuestas 14 y 15). Respecto al Propósito, sí existe evidencia de que se ha cumplido tal como está redactado: “Proyectos de desarrollo social y humano desarrollados por Instituciones de Educación Técnica Media Superior a través de Jóvenes Prestadores de Servicio Social”. No obstante, esta evaluación ha señalado que esta redacción no está orientada a resultados y que sus indicadores no son adecuados (ver respuestas 3, 4, 14 y 15). Por ejemplo, en el 2007 se desarrollaron menos proyectos que en 2006 con el mismo presupuesto, por lo cual no se podría considerar que haya progresado el programa en el logro de ese propósito. Según los funcionarios de JXM esto se debe a que se privilegió la calidad sobre la cantidad, y esto puede ser cierto. Sin embargo esta apreciación es difícil de medir en cuanto el programa no tiene instrumentos adecuados para medir los impactos de los proyectos. 105