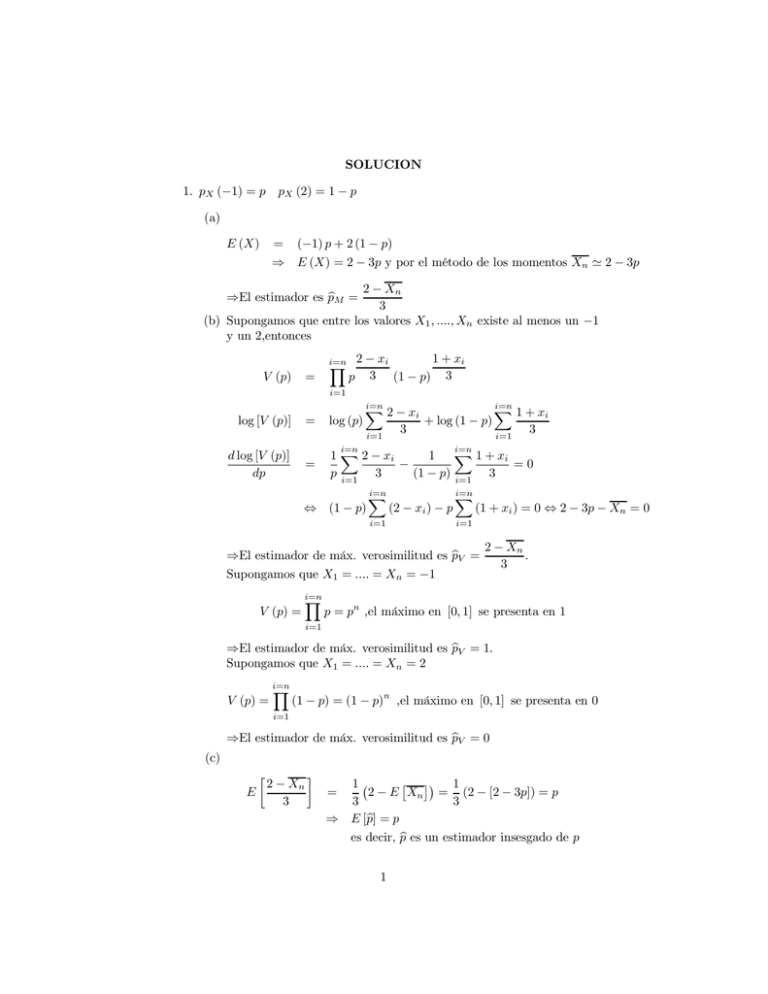

SOLUCION 1. pX (−1) = p p X (2) = 1 − p (a) E (X) = (−1)p + 2 (1 − p

Anuncio

SOLUCION

1. pX (−1) = p pX (2) = 1 − p

(a)

E (X)

= (−1) p + 2 (1 − p)

⇒ E (X) = 2 − 3p y por el método de los momentos Xn 2 − 3p

2 − Xn

3

(b) Supongamos que entre los valores X1 , ...., Xn existe al menos un −1

y un 2,entonces

⇒El estimador es pM =

V (p)

=

i=n

i=1

log [V (p)]

=

p

1 + xi

2 − xi

3 (1 − p) 3

log (p)

i=n

2 − xi

i=1

i=n

d log [V (p)]

dp

=

3

+ log (1 − p)

i=n

i=n

i=1

(2 − xi ) − p

i=n

i=1

3

(1 + xi ) = 0 ⇔ 2 − 3p − Xn = 0

⇒El estimador de máx. verosimilitud es pV =

Supongamos que X1 = .... = Xn = −1

i=n

i=1

1 + xi

1 2 − xi

1

−

=0

p i=1 3

(1 − p) i=1 3

⇔ (1 − p)

V (p) =

i=n

1 + xi

2 − Xn

.

3

p = pn ,el máximo en [0, 1] se presenta en 1

i=1

⇒El estimador de máx. verosimilitud es pV = 1.

Supongamos que X1 = .... = Xn = 2

V (p) =

i=n

i=1

(c)

(1 − p) = (1 − p)n ,el máximo en [0, 1] se presenta en 0

⇒El estimador de máx. verosimilitud es pV = 0

E

2 − Xn

3

1

1

2 − E Xn = (2 − [2 − 3p]) = p

3

3

⇒ E [

p] = p

es decir, p es un estimador insesgado de p

=

1

(d) Por ejercicio del práctico 9.6

ECM [

pn ]

=

V ar (

pn )

=

y V ar (X)

=

(c)

V ar (

pn ) + (sesgo)2 = V ar (

pn )

V ar Xn

2 − Xn

V ar (X)

V ar

=

=

3

9

9n

2

2

2

2

2

E X − [E (X)] = (−1) p + 2 (1 − p) − [2 − 3p]

p + 4 (1 − p) − 4 + 12p − 9p2 = 9p (1 − p)

p (1 − p)

⇒ ECM [

pn ] =

n

=

(e) Buscamos un IdeC aprox para el promedio usando TCL, tenemos

40 × (−1) + 80 × 2

2−1

= 1 ⇒ p =

= 1/3

120

3

2 = 9(1/3)(1 − (1/3)) = 2

y como V ar (X) = 9p (1 − p) entonces σ

por otro lado z0,5 = 1.645 y n = 120

X 120

=

entonces el IdeC para 2 − 3p es

√

√

√

√

z0,5 2

z0,5 2

1.645 2

1.645 2

[1− √

, 1+ √

] = [1− √

, 1+ √

] = [0.788, 1.212]

120

120

120

120

de donde IdeC para p es

2 − 1.212 2 − 0.787

,

= [0.263, 0.404]

3

3

2. (a) Test de Rachas, R=3, p_valor=0.19, el test no rechaza aleatoriedad

Test de Spearman, rs=-0.25, p_valor=0.297, el test no rechaza aleatoriedad

(b) Test de Kolmogorov-Smirnov (una muestra), Dn=0.3036, p_valor

>0.2, el test no rechaza que sea U [0, 2]

(c) Test de Mann-Whitney-Wilcoxon, Tx=58, p_valor=0.433, el test no

rechaza que tengan la misma distribución.

Test de Kolmogorov -Smirnov (dos muestras), nmD=18, p_valor

>0.118, el test no rechaza que tengan la misma distribución.

3. (a) Sean:

E error

A1 la señal emite un 1

2

A0 la señal emite un 0.

E = [E ∩ A1 ] ∪ [E ∩ A0 ]

P (E) = P [E ∩ A1 ] + P [E ∩ A0 ] = P [E/A1 ] P (A1 ) + P [E/A0 ] P (A0 )

P [E/A1 ] = P (decodificar 0/A1 ) = Pµ=µ1 (U ≤ c) = P (Z ≤ c) con Z ∼ N µ1 , σ 2

Z − µ1

c − µ1

c − µ1

P [E/A1 ] = P

≤

=Φ

σ

σ

σ

P [E/A0 ] = P (decodificar 1/A0 ) = Pµ=µ0 (U > c) = 1 − P (Z ≤ c) con Z ∼ N µ0 , σ 2

Z − µ0

c − µ0

c − µ0

≤

=1−Φ

P [E/A0 ] = 1 − P

σ

σ

σ

P (A1 ) = 1 − p0 y P (A0 ) = p0

c − µ0

c − µ1

(1 − p0 ) + 1 − Φ

p0 = f (c)

P (E) = Φ

σ

σ

(b)

df (c)

dc

dΦ

=

=

=

df (c)

dc

=

⇔

⇔

⇔

⇔

⇔

df (c)

dc

>

df (c)

dc

<

c−µ1

σ

dΦ

c−µ0

σ

p0

(1 − p0 ) −

dc

dc

1

c − µ1

c − µ0

ϕ

(1 − p0 ) − ϕ

p0

σ

σ

σ

2

2 1

1 c − µ1

1 c − µ0

√

exp −

(1 − p0 ) − exp −

p0

2

σ

2

σ

2πσ

2 2 1 c − µ1

1 c − µ0

0 ⇔ exp −

(1 − p0 ) − exp −

p0 = 0

2

σ

2

σ

2 2 1

c − µ1

c − µ0

p0

exp −

−

=

2

σ

σ

1 − p0

2 2 1

c − µ1

c − µ0

p0

−

−

= ln

2

σ

σ

1 − p0

1

p0

− 2 c2 − 2cµ1 + µ21 − c2 + 2cµ0 − µ0 2 = ln

2σ

1 − p0

p0

2c (µ1 − µ0 ) + µ0 2 − µ21 = 2σ2 ln

1 − p0

p0

2

2

2σ 2 ln 1−p

+

µ

−

µ

0

1

0

c=

además

2 (µ1 − µ0 )

p0

2σ2 ln 1−p

+ µ21 − µ0 2

0

0⇔c>

y

2 (µ1 − µ0 )

p0

2σ2 ln 1−p

+ µ21 − µ0 2

0

0⇔c>

ya que µ1 > µ0

2 (µ1 − µ0 )

3

por lo que efectivamente

2σ 2 ln

copt =

(c)

p0

1−p0

+ µ21 − µ0 2

2 (µ1 − µ0 )

i.

P (U ≤ 1.2)

con Z0

P (U ≤ 1.2)

P (U ≤ 1.2)

=

∼

=

=

p0 P (Z0 ≤ 1.2) + (1 − p0 ) P (Z1 ≤ 1.2)

N (0, 1) y Z1 ∼ N (2, 1)

p0 P (Z0 ≤ 1.2) + (1 − p0 ) P (Z0 ≤ −0.8) = p0 × 0.88 + (1 − p0 ) × 0.21

0.67p0 + 0.21

ii. Según los datos {i : Ui ≤ 1.2} = 6 por lo que estamos en la

región crítica y rechazamos H0 .

El error asociado a esta decisión es del tipo I y por lo tanto su

proibabilidad es α .

α = PH0 ([ {i : Ui ≤ 1.2} ≥ 5]) = Pp0 =0.61 ([ {i : Ui ≤ 1.2} ≥ 5])

Pp0 =0.61 (U ≤ 1.2) = 0.67 × 0.61 + 0.21 = 0.62

{i : Ui ≤ 1.2} =

i=9

i=1

Xi con Xi ∼ Ber (0.62) por lo cual

{i : Ui ≤ 1.2} = W con W ∼ Bin (9, 0.62) ⇒

α = P (W ≥ 5) = 1 − P (W ≤ 4) 1 − 0.23 = 0.77

4