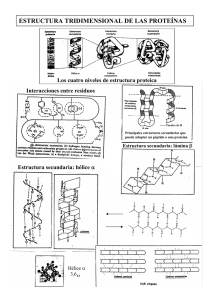

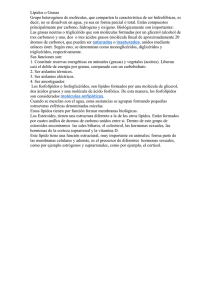

Análisis estructural y funcional de Macromoléculas

Anuncio