Examen de Teoría de Reconocimiento de Formas

Anuncio

Examen de Teoría de Reconocimiento de Formas

Facultad de Informática, Departamento de Sistemas Informáticos y Computación

Universidad Politécnica de Valencia, Enero de 2010

Apellidos:

Nombre:

Cuestiones (3 puntos, 1 hora, sin apuntes)

Marca cada recuadro con una única opción de entre las dadas.

A Los sistemas de reconocimiento de formas suelen constar de tres bloques principales: a) preproceso, b) extracción de características o propiedades, y c) clasificación o interpretación. Indica cuál de las siguientes afirmaciones sobre los mismos es falsa:

A) El preproceso se ocupa de la adquisición, segmentación y mejora (filtrado) del objeto a reconocer. La adquisición se debe

realizar mediante algún algoritmo de cuantificación como, por ejemplo, el algoritmo C-medias.

B) La extracción de propiedades obtiene una representación normalizada del objeto preprocesado, la cual debe ser compacta y

capturar información relevante para su discriminación en el bloque interpretativo.

C) La interpretación toma la representación normalizada del objeto a reconocer y devuelve el resultado último del proceso de

reconocimiento, que habitualmente se reduce a una etiqueta de clase de entre un conjunto finito de posibles etiquetas.

D) Algunas aplicaciones típicas del reconocimiento de formas son: OCR (del inglés Optical Character Recognition), reconocimiento automático del habla y reconocimiento de caras.

B Indica cuál de las siguientes afirmaciones sobre el clasificador de Bayes o mínimo riesgo es incorrecta:

A) Si las probabilidades a priori de las clases son iguales, cada objeto x se asigna a la clase que otorga a x mayor (densidad

de) probabilidad.

B) En el mejor de los casos, existe una única clase a la que todos los objetos pertenecen con probabilidad 1.

C) Para problemas de tres clases y en el peor de los casos, el error de Bayes no será superior al 70 %.

D) No existe ningún clasificador mejor en términos de probabilidad de error.

C ¿Cuál de las siguientes afirmaciones sobre PCA es incorrecta?

A) PCA se puede ver como una técnica no supervisada de extracción de características.

B) PCA proyecta los datos en el subespacio lineal engendrado por los vectores propios asociados a los mayores valores propios

de la matriz de covarianzas de los datos.

C) Cada componente principal escogido por PCA retiene la máxima varianza posible de los datos originales, especialmente

varianza inter-clase.

D) PCA no sólo se aplica en reconocimiento de formas, sino que también se emplea para comprimir, estandarizar o visualizar

datos en general.

D Indica cuál de las siguientes afirmaciones sobre modelos lineales de clasificación y generalizaciones es incorrecta:

A) En el caso de un clasificador lineal para dos clases, éstas se separan mediante un único hiperplano.

B) Una función discriminante lineal se puede extender a cuadrática mediante la adición de términos asociados a productos de

pares de características.

C) Una función discriminante lineal se puede extender a lineal generalizada mediante la introducción de una función arbitraria

que transforme cada vector de características original en un nuevo vector de características. La función discriminante lineal

generalizada se puede ver como una lineal convencional sobre el nuevo espacio de características.

D) El algoritmo Perceptrón se puede aplicar en el caso de funciones discriminantes lineales, pero no en el caso de las lineales

generalizadas, pues éstas pueden ser transformaciones no-lineales de los vectores de características originales.

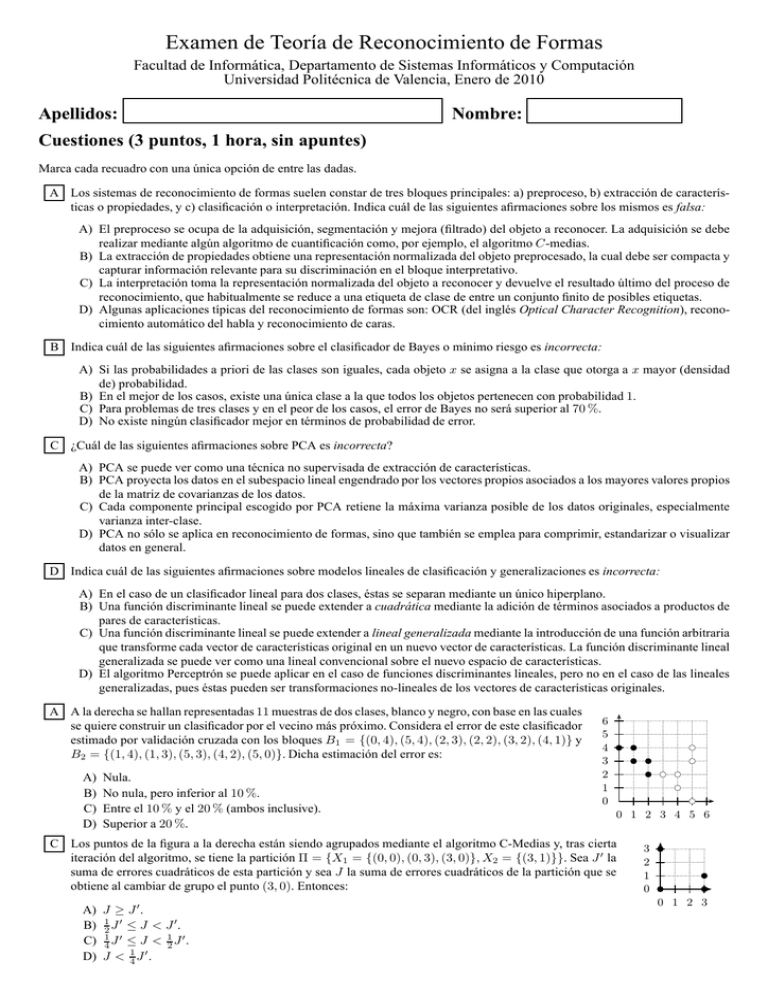

A A la derecha se hallan representadas 11 muestras de dos clases, blanco y negro, con base en las cuales

se quiere construir un clasificador por el vecino más próximo. Considera el error de este clasificador

estimado por validación cruzada con los bloques B1 = {(0, 4), (5, 4), (2, 3), (2, 2), (3, 2), (4, 1)} y

B2 = {(1, 4), (1, 3), (5, 3), (4, 2), (5, 0)}. Dicha estimación del error es:

A)

B)

C)

D)

Nula.

No nula, pero inferior al 10 %.

Entre el 10 % y el 20 % (ambos inclusive).

Superior a 20 %.

6

5

4

3

2

1

0

b

bc

b

bc

b

bc

bc

bc

0 1 2 3 4 5 6

C Los puntos de la figura a la derecha están siendo agrupados mediante el algoritmo C-Medias y, tras cierta

iteración del algoritmo, se tiene la partición Π = {X1 = {(0, 0), (0, 3), (3, 0)}, X2 = {(3, 1)}}. Sea J ′ la

suma de errores cuadráticos de esta partición y sea J la suma de errores cuadráticos de la partición que se

obtiene al cambiar de grupo el punto (3, 0). Entonces:

A) J ≥ J ′ .

B) 12 J ′ ≤ J < J ′ .

C) 41 J ′ ≤ J < 12 J ′ .

D) J < 41 J ′ .

bc

b

b

3

2

1

0

b

b

b

b

0 1 2 3

B Dadas dos cadenas x e y, y unos costes de edición de símbolos determinado, se cumple que:

A) la distancia de edición entre x e y y la distancia de edición normalizada entre esas mismas cadenas siempre es igual.

B) la distancia de edición normalizada entre x e y es siempre menor o igual que la distancia de edición entre esas mismas

cadenas.

C) la distancia de edición entre x e y y la distancia de edición normalizada entre esas mismas cadenas siempre es diferente.

D) la distancia de edición normalizada entre x e y es siempre mayor que la distancia de edición entre esas mismas cadenas.

C Dado el MOM Θ

a

b

!

!

0.5

0.5

0.5

!

0.5

0.5

0.5

0.5

q1

!

0.3

0.7

0.5

0.5

q2

0.5

q3

q4

y las cadenas x = “abaaa” y y = “aaaba”, indica cuál de las siguientes afirmaciones es cierta:

A)

B)

C)

D)

PrΘ (x) = PrΘ (y).

PrΘ (x) ≥ PrΘ (y).

PrΘ (x) < PrΘ (y).

PrΘ (x) = 2 PrΘ (y).

A Dado el MOM Θ de la pregunta anterior, si lo estimamos con la muestra M = {aba, aba} utilizando el algoritmo de Viterbi

indica cuál de las siguientes afirmaciones es cierta:

A)

B)

C)

D)

Alguno de los parámetros toma valor 0.0.

No cambian las probabilidades de emisión y de transición.

No se puede estimar con el algoritmo de Viterbi.

Las probabilidades de emisión no cambian.

B Sea la siguiente red bayesian cuyas variables toman los valores 0 ó 1:

X

0 1

0.5 0.5

Y 0

X

0 1

0.7 0.3

Z 0

Y

0 1

0.6 0.6

1

0.3 0.7

1

0.4 0.4

X

Y

Z

la probabilidad Pr(Y = 1|Z = 0) es:

A)

B)

C)

D)

0.6

0.5

0.0

0.9

D Dados los potenciales f (X) = Pr(X) y g(X, Y ) = Pr(Y |X) donde la tablas de probabilidad condicional corresponden a la red

bayesiana de la pregunta anterior, el potencial g(X, Y ) = f (X)g(X, Y ) es:

A)

X

0

0

1

1

Y

0

1

0

1

0.15

0.35

0.35

0.15

B)

X

0

0

1

1

Y

0

1

0

1

0.15

0.15

0.35

0.35

C)

X

0

0

1

1

Y

0

1

0

1

0.35

0.35

0.15

0.15

A Con marco de la máxima entropía:

A)

B)

C)

D)

Se pueden abordar problemas de clasificación de reconocimiento de formas.

Sólo se pueden abordar problemas de clasificación en dos clases.

No se pueden abordar problemas de clasificación de reconocimiento de formas.

Ninguna de las anteriores.

D)

X

0

0

1

1

Y

0

1

0

1

0.35

0.15

0.15

0.35

Examen de Teoría de Reconocimiento de Formas

Facultad de Informática, Departamento de Sistemas Informáticos y Computación

Universidad Politécnica de Valencia, Enero de 2010

Nombre:

Apellidos:

Problemas (4 puntos, 1 hora, con apuntes)

1. (2 puntos) El clasificador multinomial se define como el clasificador de Bayes particularizado al caso en el las funciones de

probabilidad condicionales de las clases son de tipo multinomial:

p(x | c) ∼ M ultD (x+ , pc ),

c = 1, . . . , C.

a) Demuestra que el clasificador multinomial es lineal con el vector de características x:

c∗ (x) = arg max gc (x)

c

con

gc (x) = wct x + wc0

donde

wc = log pc

y

wc0 = log p(c)

(1)

b) Supón que se tienen dos clases, A y B, de probabilidades a priori idénticas y funciones de probabilidad condicionales de

las clases de tipo multinomial:

3

p(x | A) ∼ M ult2 (x+ = 5, pA )

con pA = 41

(2)

4

1

(3)

p(x | B) ∼ M ult2 (x+ = 5, pB )

con pB = 43

4

Determina el clasificador multinomial asociado, en términos de funciones discriminantes simplificadas.

c) Halla la frontera entre las dos clases inducida por el clasificador determinado en el apartado anterior, así como su probabilidad de error.

Solución:

a)

c∗ (x) = arg max p(c | x)

c

p(c) p(x | c)

p(x)

= arg max p(c) p(x | c)

= arg max

c

c

= arg max log p(c) + log p(x | c)

c

X

X

= arg max log p(c) + log x+ ! −

log xd ! +

xd log pcd

c

d

= arg max log p(c) +

c

b)

X

d

xd log pcd

d

gc (x) =

X

(log2 pcd ) xd + log2 p(c)

d

∗

c (x1 , x2 ) ≡

c) Frontera:

gA = (log2 3 − 2) x1 − 2 x2

gB = −2 x1 + (log2 3 − 2) x2

x2 = x1

p(error) =

X

p(x) p(error | x)

x

=

X

p(x) mı́n(p(A | x), p(B | x))

x

=

X

mı́n(p(A) p(x | A), p(B) p(x | B))

x

=

13

= 1.27 %

1024

2. (2 puntos) Tenemos un problema de clasificación de muestras en dos clases c0 y c1 . Cada muestra se caracteriza por una cadena

de tres símbolos x0 x1 x2 , tal que x0 , x1 , x2 ∈ {a, b}.

a) Dado el MOM Θ0 asociado a la clase c0 que aparece a la izquierda y el MOM Θ1 asociado a la clase c1 que aparece a la

derecha:

a

b

!

!

0.3

0.7

0.7

q1

!

0.3

0.7

0.4

0.3

a

b

0.6

q2

!

!

0.6

0.4

0.7

q3

!

0.5

0.5

0.6

0.3

q1

q2

0.4

q3

Calcula la probabilidad de la cadena “abb” con ambos modelos e indica en qué clase quedaría clasificada.

b) Sea un modelo de máxima entropía para clasificar las cadena, para lo cual se han definido características del tipo:

f (y, z) =

(

1 si y = C y el símbolo z está en la posición i en la cadena x

0 en otro caso

donde C ∈ {c0 , c1 } y z ∈ {a, b}.

Supongamos que tenemos un modelo ya estimado cuyos parámetros son:

λc0 ,a1 =

0.096 λc0 ,a2 = −0.074 λc0 ,b0 =

λc0 ,a0 =

0.0

λc1 ,a0 =

0.231 λc1 ,a1 = −0.135 λc1 ,a2 =

0.170 λc0 ,b1 = −0.051 λc0 ,b2 =

0.061 λc1 ,b0 = −0.366 λc1 ,b1 =

0.061

0.045 λc1 ,b2 = −0.074

Indica cómo clasificaríamos la cadena “abb”. Escribe los cáculos correspondientes.

Solución

a) Para el primero modelo Θ0 tenemos que:

a

b

b

0.7

0.3

q1

0.7

a

0.7

q1

0.3

b

0.3

q2

0.6

q3

b

0.7

q1

0.3

0.7

q2

0.4

q2

0.6

q3

con una probabilidad total pΘ0 (“abb”) = 0.029. Mientras que para el segundo modelo Θ1 tenemos que:

a

b

0.4

0.6

q1

0.7

q1

a

b

0.5

0.3

q2

b

0.6

0.4

q3

q1

b

0.5

0.3

q2

0.5

0.6

q2

0.4

con una probabilidad total pΘ1 (“abb”) = 0.021. Por lo que la cadena quedaría clasificada en la clase c0 .

b) Tenemos que:

exp(0.0 − 0.051 + 0.061)

= 0.452

exp(0.0 − 0.051 + 0.061) + exp(0.231 + 0.045 − 0.074)

exp(0.231 + 0.045 − 0.074)

= 0.548

pλ (c1 |“abb”) =

exp(0.0 − 0.051 + 0.061) + exp(0.231 + 0.045 − 0.074)

pλ (c0 |“abb”) =

por lo que clasificaríamos la cadena en la clase c1 .

q3