analisis instrumental eap de biotecnología

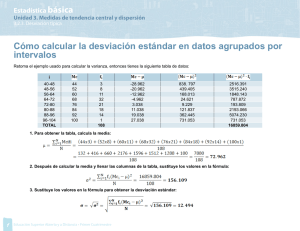

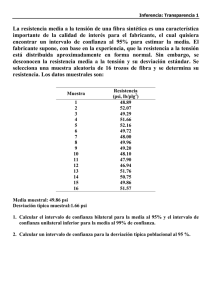

Anuncio

UNIVERSIDAD NACIONAL DEL SANTA FACULTAD DE INGENIERÍA DEPARTAMENTO ACADÉMICO DE ENERGÍA Y FÍSICA ANALISIS INSTRUMENTAL E.A.P. DE BIOTECNOLOGÍA DOCENTE: Lic. CHRISTIAN PUICAN FARROÑAY NUEVO CHIMBOTE – PERÚ 2011 MÉTODOS ANALÍTICOS El curso de Análisis Instrumental permite proporcionar a los estudiantes una introducción de los métodos de análisis espectroscópicos, electroanalíticos y cromatográficos, donde los estudiantes descubrirán los tipos de instrumentos actualmente disponibles, así como sus ventajas y desventajas. I. INTRODUCCIÓN Los ingenieros y los científicos disponen de una serie impresionantes de poderosas y selectivas herramientas en el campo de la Biología y de la Física, para obtener información cualitativa y cuantitativa acerca de la composición y estructura de la materia. Los estudiantes de Química, Bioquímica, Física, Biotecnología, Geología, Ciencias de la Salud, Ingeniería y Ciencias medioambientales deben desarrollar un conocimiento de dichas herramientas y de cómo han de utilizarse para la resolución de los problemas analíticos. La correcta elección y el buen uso de los instrumentos analíticos modernos requieren la comprensión de los principios fundamentales en los que se basan estos sistemas de medida. Sólo así se pueden elegir de forma adecuada entre las distintas alternativas para resolver un problema analítico; sólo así se podrán valorar las dificultades inherentes a las medidas físicas y establecer un criterio respecto a las limitaciones de las medidas instrumentales en cuanto a la sensibilidad, precisión y exactitud. Con esta idea, el objetivo es proporcionar al estudiante una introducción a los principios de los métodos de análisis espectroscópicos, electroanalíticos y cromatográficos. 1.1. Algunas definiciones A continuación desarrollamos algunas definiciones necesarias para comenzar. Su utilización es de uso generalizado en el campo de análisis incluyendo el análisis clínico. Identificación, Determinación, Análisis, Cuantificación y Analito. En una muestra se identifican elementos, iones y compuestos. Por ejemplo, que el análisis ha identificado penicilina en un antibiótico es lo mismo que decir que la penicilina está presente a un nivel o por encima de un determinado nivel. Si se determina la cantidad de penicilina en una muestra, se utiliza la palabra cuantificación para describir el proceso. Solo se analizan muestras; por eso decimos, por ejemplo, que la muestra es para un análisis de penicilina. Por otro lado, no es correcto decir que se analiza la penicilina, a no ser que la muestra sea penicilina en polvo puro y se analiza para determinar si están presentes en ella otros componentes. Si intentamos averiguar la fracción de una sustancia problema en una muestra, entonces usamos la palabra análisis o determinación. A la sustancia a determinar se la llama analito. Por ejemplo, si se ha de determinar la cantidad de un elemento específico, un ión o un compuesto – digamos carbono en el hierro – podemos decir que realizamos un análisis para carbono. El carbono es el analito. Puede haber cierta confusión con estos términos cuando la muestra es un elemento o un compuesto de pureza desconocida. Al decir “haremos un análisis de hierro” lo que queremos indicar es que se va a realizar una cuantificación de impurezas en la muestra de hierro. Sin embargo, si se quiere determinar la cantidad de hierro mismo, la palabra correcta para el procedimiento es ensayo. Así un análisis de hierro tiene un significado distinto de un ensayo de hierro. 1.2. Clasificación de los métodos analíticos Los métodos analíticos se suelen clasificar en clásicos e instrumentales. Esta clasificación es, en gran medida histórica, ya que métodos clásicos a veces denominados métodos de química húmeda, precedieron en un siglo o más a los métodos instrumentales. a) Métodos clásicos En los primeros años de la química, la mayor parte de los análisis se realizaban separando los componentes de interés de una muestra (los analitos) mediante un procedimiento de precipitación, extracción o destilación. En los análisis cualitativos, los componentes separados se trataban seguidamente con reactivos originándose unos productos que podían identificar por su color, su punto de ebullición o de fusión, su solubilidad en una serie de disolventes, su olor, su actividad óptica o su índice de refracción. En los análisis cuantitativos, la cantidad de analito se determinaba mediante medidas gravimétricas o volumétricas. En las primeras se determinaba la masa del analito o la de algún compuesto generado a partir del mismo. En los procedimientos volumétricos se determinaba el volumen o el peso de un reactivo patrón que reaccionase completamente con el analito. Estos métodos clásicos para la separación y determinación de analito se usan todavía en muchos laboratorios. Sin embargo, su grado de aplicación general va disminuyendo con el paso del tiempo y con la implantación de los métodos instrumentales que los están desplazando. b) Métodos instrumentales A partir del siglo XX, los científicos comenzaron a utilizar fenómenos distintos de los utilizados en los métodos clásicos para resolver los problemas más analíticos. Así, el análisis cuantitativo de una gran variedad de analito inorgánicos, orgánicos y bioquímicos se empezaron a utilizar las medidas de sus propiedades físicas tales como la conductividad, el potencial de electrodos, la absorción o emisión de luz, la relación masa/carga y la fluorescencia. Además, en la separación de mezclas complejas, técnicas de cromatográficas y electroforéticas muy eficaces empezaron a reemplazar a la destilación, extracción y precipitación como etapa previa a su determinación cualitativa o cuantitativa. A estos métodos más modernos para la separación y determinación de especies químicas se les conoce, en conjunto, como métodos instrumentales de análisis. El crecimiento de los métodos instrumentales de análisis modernos ha ido paralelo al desarrollo de la industria electrónica e informática. b.1) Tipos de métodos instrumentales Para este estudio, es conveniente considerar las propiedades físicas y químicas que se pueden utilizar en el análisis cualitativo o cuantitativo. La siguiente tabla enumera la mayoría de las propiedades características que se utilizan actualmente en análisis instrumental. Tabla 1. Propiedades Físicas y Químicas que se emplean en los métodos instrumentales Propiedades Métodos instrumentales Dispersión de la radiación Espectroscopia de emisión (rayos X, UV, visible, de electrones) fluorescencia, fosforescencia y luminiscencia (rayos X, UV y visible) Espectrofotometría y fotometria (rayos X, UV, visible, infrarrojos); espectroscopia, fotoacústica, resonancia magnética nuclear y espectroscopia de resonancia de espín electrónico. Turbidimetría, espectroscopia Raman Refracción de la radiación Refractometria; interferometría Difracción de la radiación Método de difracción de rayos X y de electrones Rotación de la radiación Polarimetría; dispersión de rotación óptica Potencial eléctrico Potenciometría; cronopotenciometría Carga eléctrica Coulombimetría Corriente eléctrica Polarografía, amperometría Resistencia eléctrica Conductimetría Masa Gravimetría (microbalanza de cristal de cuarzo) Razón masa a carga Espectrometría de masas Velocidad de reacción Métodos cinéticos Propiedades térmicas Gravimetría y volumetría térmica; calorimetría de barrido diferencial; análisis térmico diferencial; métodos de conductividad térmica. Métodos de activación y de dilución isotópica Emisión de radiación Absorción de la radiación Radiactividad Obsérvese que las seis primeras entradas de la tabla están relacionadas con las interacciones del analito y la radiación electromagnética. En primer lugar el analito origina señal radiante: las cinco siguientes implican cambios en el haz de radiación producidos por su interacción con la muestra. Las cuatro que siguen son eléctricas. Por último, cuatro propiedades diversas se agrupan conjuntamente: la relación masa/carga, la velocidad de reacción, las señales térmicas y la radiactividad. Un método instrumental puede ser más selectivo para ciertos compuestos o combinaciones de elementos: pero para otros, un análisis volumétrico o gravimétrico puede tener menores interferencias. Como se ha indicado, además de los numerosos métodos señalados en la segunda columna de la tabla, existe un grupo de procedimientos instrumentales que se utilizan para separar y resolver compuestos afines. La mayoría de ellos están relacionados con la cromatografía y la electroforesis. Para completar el análisis, tras las separaciones cromatográficas, se suele usar alguna de las propiedades de la tabla. Con esta finalidad se han utilizados, se han utilizado, por ejemplo, la conductividad térmica, la absorción en el infrarrojo y el ultravioleta, el índice de refracción la conductividad térmica. INSTRUMENTOS PARA EL ANÁLISIS Para conseguir la información del analito deseada es necesario proporcionar un estímulo, generalmente en forma de energía electromagnética, eléctrica, mecánica o nuclear, como se muestra en la figura 1. Estímulo Fuente de energía Respuesta Sistema objeto de estudio Información analítica Fig. 1. Diagrama de bloques que muestra el proceso completo de una medida instrumental. Un ejemplo habitual es el paso de una banda estrecha de longitudes de onda de luz visible a través de una muestra para medir la capacidad de absorción del analito. Se determina la intensidad de la luz antes y después de su interacción con la muestra y la relación entre ellas proporciona la medida de la concentración del analito. Tabla 2. Algunos ejemplos de los componentes de los instrumentos. SELECCIÓN DE UN MÉTODO ANALÍTICO La segunda columna de la Tabla 1 pone de manifiesto de una enorme serie de herramientas para realizar análisis, tantas que, de hecho la elección resulta, a menudo, difícil. En esta parte se estudia cómo se realiza dicha elección. a) Definición del Problema Para poder seleccionar correctamente un método analítico, es esencial definir con claridad la naturaleza del problema analítico, y esta definición requiere contestar a las siguientes preguntas. 1. ¿Qué exactitud se requiere? 2. ¿De cuánta muestra se dispone? 3. ¿En qué intervalo de concentración está el analito? 4. ¿Qué componentes de la muestra interfieren? 5. ¿Cuáles son las propiedades físicas y químicas de la matriz de la muestra? 6. ¿Cuántas muestras hay que analizar? Es de vital importancia la respuesta a la primera pregunta, ya que determina el tiempo y el esmero que requerirá el análisis. Las respuestas a la segunda y tercera determinan lo sensible que debe ser el método y al intervalo de concentración al que debe adaptarse. La respuesta a la cuarta pregunta determina qué selectividad se requiere. Es importante la respuesta a la quinta pregunta porque algunos de los métodos analíticos de la Tabla 1 sirvan para disoluciones de analito (normalmente acuosas). Otros se aplican con mayor facilidad a muestras gaseosas, mientras que otros métodos son más adecuados para el análisis directo de sólidos. Una consideración importante desde un punto de vista económico es el número de muestras que hay que analizar (pregunta sexta). Si es elevado, se puede invertir más tiempo y dinero en la instrumentación, en el desarrollo del método y en la calibración. Además, si el número fuera muy elevado, debería elegirse un método que precisara del mínimo tiempo de dedicación del operador a cada muestra. Teniendo en cuenta las respuestas a las seis preguntas anteriores, se puede escoger un método, siempre que se conozcan las características del funcionamiento de los distintos métodos instrumentales indicados en la tabla 1. Características de funcionamiento de los instrumentos; parámetros de calidad En la siguiente tabla 3 se enumeran los criterios cuantitativos de funcionamiento de los instrumentos, criterios que se pueden utilizar para decidir si un determinado método instrumental es o no adecuado para resolver un problema analítico. Estas características se expresan en términos numéricos y se denominan parámetros de calidad. Para un problema analítico dado, los parámetros de calidad permiten reducir la elección de los instrumentos a tan sólo unos pocos y entonces la selección entre ellos ya se hace con los criterios cualitativos de funcionamiento señalados en la tabla 4. Tabla 3. Criterios numéricos para seleccionar métodos analíticos Criterios Parámetros de calidad 2. Sesgo Desviación estándar absoluta, desviación estándar relativa, coeficiente de variación, varianza. Error absoluto sistemático, error relativo sistemático. 3. Sensibilidad Sensibilidad de calibración, sensibilidad analítica 4. Límite de detección 5. Intervalo de concentración 6. Selectividad Blanco más tres veces la desviación estándar del blanco Concentración entre el límite de cuantificación (LOQ) y el limite de linealidad (LOL) Coeficiente de selectividad 1. Precisión Tabla 4. Otras características a tener en cuenta en la elección del método 1. Velocidad 2. Facilidad y comodidad 3. Habilidad del operador 4. coste y disponibilidad del equipo 5. Coste por muestra Unidades patrones internacionales de medidas Una medida indica la cuantía del tamaño del algo, especialmente si se lo compara con un estándar de referencia. Por ejemplo, el gramo se define exactamente como 1/100 de una masa estándar que se guarda en el Instituto de Pesos y Medidas de París. Se seleccionó para que fuera exactamente la masa de 1,000mL de agua a la temperatura de su máxima densidad, 3,98ºC. Desde su definición original el valor de la masa del agua se ha medido con más precisión y difiere de la original en aproximadamente 3 partes por 10000. Sin embargo el gramo estándar se ha mantenido igual por ser su valor suficientemente cercano a todas las mediciones exceptuando las proporcionadas por los métodos de medida de más precisión. De forma similar se define el centímetro por un estándar. Finalmente, las escalas de grados Celsius y Kelvin se definen como 1/100 de la diferencia entre el punto de ebullición y de congelación del agua. Es interesante observar que estos tres patrones internacionales de medida están definidos arbitrariamente. Masa atómica Las masas atómicas son una serie de números relativos; su valor absoluto depende del estándar definido, la masa del isótopo 12 C, al cual se le asigna una masa de exactamente 12 y 1/12 de esta masa es la masa atómica unificada, que se designa por la inicial u. actualmente éste es el término recomendado, aunque aún se utiliza la sigla UMA para designar a la unidad de masa atómica. La unidad de masa atómica también recibe el nombre de dalton. Normalmente a las masas atómicas se las conoce como pesos atómicos. Notación de prefijos El intervalo de concentraciones y los tamaños de las muestras que pueden analizarse varían ampliamente y se benefician de un lenguaje para expresar estos intervalos. Medidas primarias como el metro o el gramo reciben nombres de prefijos en función de múltiplos de diez. Por ejemplo, el prefijo kilo – significa mil veces la unidad de medida, como un kilogramo; sin embargo, para otras situaciones pueden requerirse unidades de medidas mayores. TABLA 1.1. NOTACIÓN DE PREFIJOS EXPONENTE NOMBRE DEL PREFIJO SIMBOLO 1024 1021 1018 1015 1012 109 106 103 102 10 10-1 10-2 10-3 10-6 yotta zetta exa peta tera giga mega kilo hecto deca deci centi mili micro nano pico femto atto zepto yocto Y Z E P T G M K h da d c m μ η p f a z y 10-9 10-12 10-15 10-18 10-21 10-24 Tabla 1.2. Unidades de Concentración Componente medido por Peso Peso Volumen Número Muestra entera medida por el Peso Volumen Volumen Volumen Nomenclatura Abreviatura Peso a peso Peso a volumen Volumen a volumen Molaridad, normalidad p/p p/v v/v M,N Unidades de concentración Se emplean cuatro tipos fundamentales de nomenclatura para expresar la concentración de una sustancia en una muestra o disolución, a) Unidades de medida de peso a peso Las medidas de peso a peso (p/p) expresan la relación entre el peso de un componente y el peso del total. Porcentaje en peso, abreviado % (p/p), es la relación entre el peso de un componente y el peso de toda la mezcla, expresada en porcentaje. Así: % ( p / p) = componente de masa x100 muestra de masa Las unidades de masa deben ser las mismas. Alguna vez % (p/p) se denomina partes por ciento. Para describir fracciones más pequeñas se usa partes por mil (%), partes por millón (ppm, p.p.m.), partes por billón (partes por 109, ppb, p.p.b.) y partes por trillón (partes por 1012, ppt). Una medida de peso a peso puede ser expresado también como una fracción. Por ejemplo: la muestra contiene 33μg del ingrediente X/mg; también 33μg/mg equivale a 33 partes por mil. También se dan las siguientes equivalencias: Partes por millón = μg/g Partes por billón = ng/g Partes por trillón = pg/g ENSAYOS ESTADISTICOS Y ANALISIS DE ERRORES Cuando se llega a un resultado final, es muy útil poder decir cuál es la certeza de tal resultado. Todos usamos frases como “casi seguros”, “muy seguros”, “lo más probable”, “improbable” para expresar los diferentes grados de certeza. Sin embargo, el análisis químico necesita información más cuantitativa. La sustitución de estas frases, más bien indefinidas, se realiza utilizando los análisis matemáticos estadísticos. Veremos algunos de estos métodos estadísticos para la evaluación de los resultados experimentales. Primeramente, deberemos responder a las siguientes preguntas: • ¿Qué seguridad tenemos de que el valor experimental obtenido está próximo al valor real? • ¿Qué seguridad tenemos de que el valor obtenido es igual (o diferente) a otros valores hallados en el análisis de la misma muestra, o a los valores hallados por otra persona o en otro momento? La primera pregunta incide sobre la cuestión fundamental del análisis físico y químico, y de todas las ciencias experimentales. La segunda es más importante en el área de las normativas nacionales o internacionales de la presencia (o ausencia) de sustancias químicas. La información aportada por diferentes análisis o laboratorios debe ser coordinada, y los resultados analíticos han de ser fidedignos. Si los resultados no fuesen fiables, las normativas carecen de sentido. Evidentemente, es preferible que los resultados puedan ser intercambiados entre los laboratorios. Para ello debemos hacer un esfuerzo para validar un método analítico. Validar significa cerciorarse de que el método desarrollado para determinar una sustancia específica (por ejemplo, vanadio) en una muestra específica (por ejemplo, un hígado de vacuno) produzca resultados comparables para la gran mayoría de los analistas. La validación es muy importante para un analista que trabaje solo, para un grupo de analistas que trabajen en un laboratorio o para un grupo de laboratorios coordinando sus análisis. 2.2. Hallazgo de errores Un punto crucial para la mejor de los análisis químicos será identificar dónde se producen los errores y cómo pueden evaluarse su magnitud. Para ilustrar este aspecto, veamos un caso sencillo de un análisis típico de laboratorio, por ejemplo, la determinación del nivel de fenol (en peso y volumen) en un inhalador pulmonar mediante cromatografía líquida. No será necesario conocer profundamente este método cromatográfico. Un sencillo análisis mediante cromatografía Éste es uno de los análisis más sencillos: diluiremos una muestra líquida e inyectaremos en un cromatógrafo una pequeña cantidad de la misma, para determinar el nivel de fenol en un producto. Utilizaremos para ellos dos pipetas automáticas, una para 1.00mL y la otra para 10.00μL. el procedimiento es muy simple. Añadiremos 1.00mL de agua destilada y desionizada en un tubo de muestras junto con 10.00μL del inhalador. Colocaremos el tubo en un portamuestras, y un inyector introducirá una cantidad una cantidad fija en un cromatógrafo, donde, después de haber sido separado de los demás componentes del inhalador, el fenol será analizado cuantitativamente por absorción luminosa a 210nm. En este procedimiento tan sencillo, como en todos los demás, la posibilidad de cometer errores aparece en cada paso del análisis. Estos posibles errores los llamaremos fuentes de error. Algunas posibles fuentes de error en el análisis descrito pudieran ser diferencias en los volúmenes medidos por ambas pipetas, diferencias en la cantidad de muestra inyectada por el autoinyector, o una relación errónea entre la concentración de fenol y la absorción de radiación. Otra fuente de error, quizás menos obvia, pudiera ser la mezcla de una muestra con otra en cualquiera de los equipos. A esta mezcla se la denomina contaminación cruzada. Por otra parte, también pudiera existir contaminación en algunos de los reactivos. ¿Me encuentro al menos en el entorno? ¿Cómo podemos descubrir que hemos cometido un error?. Después de todo, nadie conoce la cantidad exacta de fenol contenida en la muestra. Una manera de conseguirlo es aplicar el procedimiento a muestras repetidas o réplicas. Todas las réplicas se han de obtener de la misma muestra original. Si los resultados del análisis de dos réplicas del inhalador pulmonar fuesen similares, indicaría que no existen errores como los que anteriormente hemos mencionado. Si tomásemos el análisis de tres replicas, todavía estaríamos más seguros. Cuanto mayor sea el número de experimentos que se llevan a cabo, mayor certeza tendremos de que el próximo experimento va a estar en el mismo entorno que los anteriores. La descripción estadística de certeza trae consigo un aumento de la confianza en el resultado promedio. 2.3. Medida de errores Es importante reconocer que no se puede obtener la medida estadística de la cantidad de un experimento a menos que se desarrollen series diferentes de análisis. Si únicamente se analiza una vez la muestra, deberemos tomar el valor medido como el resultado. Sin embargo, si realizamos una serie de mediciones a diferentes réplicas, será improbable encontrar que todos los valores son exactamente iguales. Esto se puede ver en el caso, donde se representan los resultados de las pruebas de análisis de la aflatoxina. Si en cada caso obtenemos un valor diferente, ¿qué valor debemos tomar como resultado final del análisis?. Un resultado numérico útil en una serie de pruebas será la media aritmética de los resultados individuales. La media aritmética de una serie se calcula dividiendo la suma de todos los valores entre el número de valores obtenidos. Esto matemáticamente se expresa como: X = ∑X i i (1) N donde: X : representa la media aritmética, Xi : represena el resultado numérico del i-ésimo valor y N : es el número total de valores. A menudo a la media aritmética se la denomina media o promedio. El cálculo de la media se ilustra con otro ejemplo de la tabla 2. En la tabla 2 muestra un test estadístico de varias pesadas de una muestra. Para llevar a cabo este experimento, la muestra se colocó en la balanza, se pesó y se descargó posteriormente de la misma. Este procedimiento se repitió tres veces más. Los resultados de las cuatro pesadas se muestran en la primera columna. El resultado de la suma de las cuatro pesadas es 12,4115g. El peso medio X resultado 12,4115/4 = 3,1029g, calculado según indica la ecuación (1). A continuación encontraremos nuevas definiciones. La desviación con respecto a la media di se define, para cada medida individual, como la diferencia entre cada medida del valor Xi, y el valor medio calculado para todas las medidas, X , algebraicamente: di = X i − X (2) Como ejemplo, se pueden ver los cálculos más representativos en la tabla 2. En la tercera columna, se muestran los valores de las desviaciones de la media de cada pesada individual. El recorrido es la diferencia, en magnitud, entre el mayor y menor de los valores observados en una serie. Recorrido = w = Xsuperior – Xinferior El recorrido en el ejemplo en la tabla 2.21….. es 0,0010g, la diferencia entre 0,0006 y +0,0004. La medida de la reproducibilidad de una serie de medidas más utilizadas (y con más significado estadístico) es la desviación estándar. La desviación estándar es la raíz cuadrada de la varianza. La varianza se define: varianza = d12 + d 22 + ....... + d N2 N −1 desviación estándar = d12 + d 22 + ....... + d N2 N −1 Otra medida estadística del error es la desviación estándar relativa, que es la desviación estándar expresada como una fracción o porcentaje de la media. Algebraicamente se expresa como: Desviación estándar relativa = s X o bien Tanto por ciento de la desviación estándar relativa = s x 100 X Algunas veces el porcentaje de la desviación estándar relativa se expresa como coeficiente de variación. 2.4. Medidas absolutas y relativas La desviación estándar es un número: una medida absoluta. Sus unidades son las mismas que las de los valores medios, como gmL-1. La desviación estándar relativa es un coeficiente entre la desviación estándar y el valor medio. La desviación relativa será, por tanto un valor sin unidades. Estos valores se denominan relativos. Cuando veamos relativa, indicaremos un cociente entre dos números que poseen las mismas unidades. Por ello, los valores relativos no tienen unidades. Los valores absolutos y relativos están relacionados por: relativo = absoluto valor medio Se observa que los valores relativos y absolutos se pueden relacionar fácilmente. 2.5. Precisión y Exactitud Hasta ahora, sólo hemos considerado la difusión o dispersión de los datos de los resultados analíticos. Cuando la dispersión de los datos obtenidos experimentalmente es pequeña, decimos que la precisión es alta. La desviación estándar de una serie de medidas es una medida cuantitativa de la dispersión. La desviación estándar es pequeña cuando la precisión del experimento es elevada. Sin embargo, todavía no hemos considerado si el valor medio, calculado a partir de una serie de datos experimentales, se acerca a la cantidad presente realmente en la muestra. En otras palabras, la precisión de los datos no nos responde a la pregunta de: ¿Cuánto se acerca el valor medio al valor real en los análisis?, o expresado de otro modo: ¿Cuál es su exactitud? La diferencia entre precisión y exactitud se observa claramente en la figura 2.1., donde se muestran cuatro combinaciones diferentes. Los valores de los cuatro experimentos se muestran como puntos a lo largo del eje X. los dos primeros dibujos muestran una alta precisión en los resultados. Sin embargo, el valor medio en el segundo dibujo está lejos del “valor real”; el valor medio tiene poca exactitud, pero mucha precisión. Pero, ¿Cómo es posible que esto ocurra? Una posibilidad puede provenir de que en todas las muestras algún otro componente reaccione de la misma manera que el componente buscado: un interferente. La diferencia entre el “valor real” del analito y el valor medio de los resultados analíticos obtenidos en las series se denominan error absoluto, abreviado como Em. El error absoluto tiene las mismas unidades que la media realiza, e incluye un signo (+ o -). Cuando el error absoluto se expresa como un porcentaje de un resultado real se denomina error relativo. Tal y como sugiere la palabra relativo, no tiene unidades. (No ha de confundirse error relativo con desviación estándar relativa) Es importante comprender que desde un punto de vista puramente estadístico, no existe el concepto de error absoluto ya que el “resultado real” o el “valor real” no se conocen nunca. Sin embargo, podemos aproximarnos a la “verdad” con experimentos diseñados para su validación. Una aproximación válida podría ser mezclar completamente y en las mismas proporciones, diferentes reactivos altamente puros para producir una muestra igual a la que se están analizando. Estas muestras “artificiales” y perfectamente conocidas se analizan exactamente de la misma manera que las muestras desconocidas, hasta que encontremos que una mezcla nos ofrece los mismos resultados que la muestra desconocida. Como podemos imaginar, esta labor de aproximación es tediosa, siendo posible conseguir aproximaciones experimentales más sencillas. Generalmente, el error absoluto entra dentro de la categoría de errores sistemáticos. Sistemáticos nos indicará que se origina por una causa fija. Un error sistemático en un análisis es o bien únicamente alto o bien únicamente bajo cada vez que se efectúe el análisis. Al error sistemático también se le puede denominar error determinado. Por otro lado, los errores para los cuales utilizamos la desviación estándar como medida serán errores aleatorios, los cuales se originan debido a causas arbitrarias o indeterminadas. En un análisis, los errores arbitrarios producen valores altos o a veces bajos. Figura 2.1. Muestra de la exactitud y de la precisión. Cuatro dibujos con los valores de los resultados de cuatro series de pruebas. Los puntos indican los valores de los resultados de cada experimento individual. Convenimos que el “valor real” es conocido e igual a 61. X es el valor medio de cada serie de experimento I – IV Em Se denomina error absoluto El error absoluto relativo es Em / X o, como porcentaje, (Em/ X )x 100 2.6. Errores aleatorios y la distribución normal (Gaussiana) Cuando varios sucesos o errores aparecen de forma aleatoria, éstos son independientes unos de otros. Un ejemplo de sucesos aleatorios es la aparición de caras o cruces después de lanzar una moneda al aire. La mitad de las veces el resultado será cara y la otra mitad será cruz. El resultado de un lanzamiento no tiene ningún efecto sobre el siguiente; son independientes. Cuando los errores en una medida son aleatorios, los valores tienden a distribuirse de una forma característica a ambos lados del valor medio. El siguiente estudio sobre la Fígura 2.2 muestra la naturaleza estadística de esta distribución. Figura 2.2. Graficas de los resultados de una serie de 40 experimentos clasificados en grupos adyacentes de valores. (a) Cada barra tiene un intervalo de 2ppm. La altura de cada barra representa en número de resultados en cada intervalo. El valor medio es 100ppm. En la figura se muestran resultados con 5, 10 y 40 experimentos. Figura 2.2. (b) Para un número muy alto de resultados, la distribución de los resultados se aproxima a una curva gaussiana que se caracteriza por la desviación estándar σ y una máxima en el valor medio. El 68.3% de los resultados se encuentra dentro del intervalo σ, y el 95.4% de los resultados se encuentra dentro del intervalo 2σ. Primero, se analizan diferentes réplicas del mismo material. Tal procedimiento es similar a realizar la pesada de la misma masa repetidas veces. Con los resultados obtenidos podemos calcular el valor medio, y seguidamente las desviaciones de la media de cada una de las medidas. Asumiremos para nuestro razonamiento que se han realizado las medidas de 40 veces diferentes. Este número de experimentos se debería utilizar cuando se valide un método nuevo de análisis. Sin embargo, para procedimientos de rutina, raramente se utilizan más de cuatro réplicas. Tal y como se muestra en la Fig. 2.2a se tomaron y evaluaron los datos después de obtener los resultado de las primeras 5, las primeras 10 y finalmente las 40 réplicas. Posteriormente se clasificó a cada uno de los valores experimentales dentro de un grupo, en función de la lejanía de su valor al valor medio. Cada grupo tiene igual intervalo de error – la diferencia entre el valor mayor y el valor menor - . Los datos se representaron en un gráfico de barras. El gráfico muestra el número de experimentos cuyo resultado se encuentra dentro de cada uno de los intervalos frente a los valores experimentales. Este tipo de gráfico se denomina histograma. El valor medio es de 100ppm, y cada barra del histograma tiene una anchura de 2ppm. En el histograma, la altura de cada barra es proporcional al número de sucesos en cada intervalo, de manera que podemos nombrar la escala de la izquierda como número de experimento. Como las barras son todas iguales en anchura, el área de cada una de ellas es también proporcional al número de experimentos con valores dentro de ese intervalo. Por consiguiente, el área total de las barras será proporcional al número final de experimentos; en nuestro caso, 5, 10 y 40. Otro modo de tratar los datos es establecer que la suma de las áreas de todas las barras sea igual a la unidad. La escala de la izquierda entonces pasa a ser la proporción de los experimentos realizados o la frecuencia relativa de un suceso. El área de cada barra será entonces proporcional a la fracción de los experimentos que tienen el error en el intervalo dado Otra característica que se puede observar en estos histogramas es la tendencia de las barras a decrecer en altura según nos alejamos de la media. El número de errores en cada grupo tiende a disminuir cuando aumenta la desviación de la media (cuando el grupo está más lejano de X ). Esto se puede observar más claramente en el histograma con los 40 análisis. Sin embargo, la distribución esperada no tiene por que observarse con unas pocas medidas, tal y como se observa en los histogramas con 5 y 10 réplicas. El tratamiento estadístico de los errores aleatorios es levemente diferente a dibujar un histograma y calcular las frecuencias relativas de los sucesos frente a la desviación. La diferencia principal consiste en que el error estadístico se calcularía si hubiese un número infinito de experimentos; cada intervalo sería infinitamente estrecho. En este caso, la distribución de los errores aleatorios sobre la media podría ser descrita mediante una curva de error gaussiana, tal y como se observa en la figura 2.2b. Otros nombres para esta curva son: curva de error normal o curva de distribución normal. De otro modo expresado, la curva que se muestra en la figura 2.2b engloba la distribución de resultados cuando se realizan un gran número de análisis. El eje X es la escala de los valores experimentales. El valor medio se encuentra en el pico de la curva. La altura de la curva es una representación de la probabilidad de que un resultado experimental tenga el valor anotado en el eje X. Obsérvese que los errores pueden ser positivos o negativos a partir del valor medio. Denominaremos como μ al medio de la curva gaussiana. Éste es el valor límite de X para un número muy elevado de análisis.