´Algebra Lineal

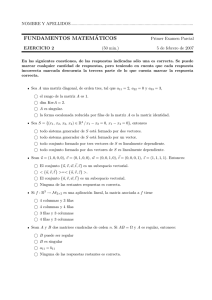

Anuncio

Álgebra Lineal

Grado en Ingenierı́a Electrónica Industrial y Automática

Grado en Ingenierı́a Eléctrica

Dpto. de Matemática Aplicada

Escuela de Ingenierı́as Industriales de Valladolid

Universidad de Valladolid

Curso Actual

Capı́tulo 1

Matrices, Sistemas y Determinantes.

1.1.

1.1.1.

Matrices.

Definiciones básicas

Una matriz es una tabla rectangular de números, (es decir, una distribución ordenada de

números). Los números de la tabla se conocen con el nombre de elementos de la matriz. El

tamaño de una matriz se describe especificando el número de filas y columnas que la forman. Si A

es una matriz de m filas y n columnas, Am×n , se usará aij para denotar el elemento de la fila i y la

columna j y en general, se representará por

A=

a11

a21

..

.

a12

a22

..

.

· · · a1n

· · · a2n

.

· · · ..

am1 am2 · · · amn

Al conjunto de todas las matrices de tamaño m × n lo denotaremos por Mm×n

Se dice que dos matrices son iguales si tienen el mismo tamaño y los elementos correspondientes

en ambas matrices son iguales.

Una matriz An×n se denomina matriz cuadrada de orden n y de los elementos de la matriz

a11 , a22 , ..., ann se dice que forman la diagonal principal.

Una matriz cuadrada A se dice triangular superior, si todos los elementos por debajo de la

diagonal principal son nulos, es decir: aij = 0, para cualquier i,j tal que i > j. Una matriz cuadrada

A se dice triangular inferior, si todos los elementos por encima de la diagonal principal son nulos,

es decir: aij = 0, para cualquier i,j tal que i < j. Una matriz cuadrada A se dice que es diagonal,

si es triangular superior e inferior.

1.1.2.

Operaciones en las matrices

Suma: Si A y B son dos matrices del mismo tamaño la suma A + B es otra matriz C del mismo

tamaño con cij = aij + bij , ∀i, j.

El neutro de la suma es la matriz cero, 0, con todos los elementos cero.

Producto por escalares: Si A es una matriz y k ∈ IR un escalar, el producto kA es otra matriz

C del mismo tamaño y tal que cij = kaij , ∀i, j.

1

m

at

1.1 Matrices.

Producto de matrices: Si Am×n y Bn×p el producto AB es otra matriz C de tamaño m × p y tal

que cij =

n

X

aik bkj (obsérvese que se trata de sumar los productos de cada elemento de la fila i de A

k=1

por el elemento correspondiente de la columna j de B).

Esta definición requiere que el número de columnas de la primera matriz, A, sea igual que el

número de filas de la segunda matriz, B, puesto que para el cálculo de cij ha de haber tantos

elementos en la fila i (número de columnas de A) como en la columna j (número de filas de B). En

forma sinóptica con los tamaños (m × n) · (n × p) = (m × p). La matriz identidad, In×n , formada

por ceros excepto en la diagonal principal que tiene unos, verifica que para toda Am×n se tiene que

Im×m · Am×n = Am×n y Am×n · In×n = Am×n .

Proposición 1 (Propiedades de las operaciones).1. A + B = B + A

(conmutativa de la suma)

2. A + (B + C) = (A + B) + C

3. A(BC) = (AB)C

(asociativa de la suma)

(asociativa del producto)

4. A(B + C) = AB + AC

(distributiva por la izquierda)

5. (A + B)C = AC + BC

(distributiva por la derecha)

6. k(B + C) = kB + kC; ∀k ∈ IR

7. (k + λ)C = kC + λC; ∀k, λ ∈ IR

8. k(BC) = (kB)C = B(kC); ∀k ∈ IR

• AB = BA

En general, NO es cierto que: • AB = AC =⇒ B = C

• AB = 0 =⇒ A = 0 ó B = 0

!

!

!

0 1

3 7

−1 −1

Ejemplo 2.- Con A =

, B =

y C =

obtenemos que AB =

0 2

0 0

0

0

!

!

0 0

0 17

6= BA =

es decir AB 6= BA y AB = 0 con A 6= 0 y B 6= 0. Además

0 0

0 0

AC = 0 = AB y B 6= C.

1.1.3.

Matrices elementales

Definición 3.- Llamamos operación elemental en las filas de las matrices, a alguna de las siguientes:

a) Cambiar la posición de dos filas. Fi ↔ Fj

b) Multiplicar una fila por una constante k distinta de cero. Fi → kFj

c) Sumar a una fila un múltiplo λ de otra fila. Fi → Fi + λFj

Matemáticas I

2

m

at

1.2 Lenguaje matricial de los sistemas de ecuaciones

Definición 4.- Se dice que una matriz n × n es una matriz elemental si se obtiene de efectuar

una sola operación elemental sobre la matriz identidad n × n.

Teorema 5.- Si la matriz elemental Em×m resulta de efectuar cierta operación elemental sobre las

filas de Im×m y si Am×n es otra matriz, el producto EA es la matriz m × n que resulta de efectuar

la misma operación elemental sobre las filas de A.

1.2.

1.2.1.

Lenguaje matricial de los sistemas de ecuaciones

Método de Gauss

Si consideramos un sistema de m ecuaciones lineales con n incógnitas

a11 x1 + a12 x2 + . . . + a1n xn = b1

a21 x1 + a22 x2 + . . . + a2n xn = b2

...............

am1 x1 + am2 x2 + . . . + amn xn = bm

éste puede escribirse como AX = B donde Am×n = (aij ), Xn×1 = (xi ), Bm×1 = (bj ).

La matriz A se denomina matriz de los coeficientes del sistema y la matriz (A|B) se denomina

matriz ampliada del sistema.

Multiplicando sucesivamente en la igualdad AX = B por matrices elementales adecuadas E1 AX =

E1 B, E2 E1 AX = E2 E1 B, . . . , Ek . . . E2 E1 AX = Ek . . . E2 E1 B se llega a un sistema equivalente

RX = L, que tiene las mismas soluciones que el inicial, pero de mayor simplicidad a la hora de

encontrar las soluciones (por ejemplo si la matriz R conseguida es la identidad tendrı́amos IX = L

es decir X = L que es la solución buscada).

En general buscaremos una matriz escalonada, con ceros por debajo de la “escalera”, que

permite una resolución sencilla (como veremos luego). Esta matriz reducida debe cumplir:

1. Si una fila consta únicamente de ceros debe ir en la parte inferior de la matriz.

2. Si dos filas seguidas no constan sólo de ceros, el primer elemento distinto de cero de la fila

inferior debe encontrarse más a la derecha que el primer elemento distinto de cero de la fila

superior.

La búsqueda de estas matrices se conoce con el nombre de método de Gauss.

Ejemplo 6.5x3 + 10x4 + 15x6 = 5

x1 + 3x2 − 2x3 + 2x5 = 0

2x1 + 6x2 − 5x3 − 2x4 + 4x5 − 3x6 = −1

2x1 + 6x2 + 8x4 + 4x5 + 18x6 = 6

Apliquemos sobre este sistema el método de Gauss, es decir hagamos operaciones elementales, sobre

la matriz A de los coeficientes y, como vimos, también sobre B para que se mantenga la igualdad. Por

comodidad efectuamos las operaciones elementales sobre la matriz ampliada para con ello realizar

las operaciones sobre A y B de una sola vez.

Matemáticas I

3

1.2 Lenguaje matricial de los sistemas de ecuaciones

A|B =

0

1

2

2

0 5 10 0 15 5

3 −2 0 2 0

0

6 −5 −2 4 −3 −1

6 0

8 4 18 6

1

0

2

2

3 −2 0 2 0

0

0 5 10 0 15 5

6 −5 −2 4 −3 −1

6 0

8 4 18 6

1

0

0

0

3 −2 0 2 0

0

0 5 10 0 15 5

0 −1 −2 0 −3 −1

0 4

8 0 18 6

Por la operación (a) cambiamos la fila

1 por la fila 2, F1 ↔ F2 .

Por (b) hacemos cero el 2 de F3 y el de

F4 : F3 → F3 − 2F1 , F4 → F4 − 2F1 .

Hacemos 0 el −1 de F3 y el 4 de F4 :

F3 → F3 + 51 F2 , F4 → F4 − 45 F2 .

1

0

0

0

3 −2 0 2 0 0

0 5 10 0 15 5

0 0 0 0 0 0

0 0 0 0 6 2

1

0

0

0

3 −2 0 2 0 0

0 5 10 0 15 5

0 0 0 0 6 2

0 0 0 0 0 0

x1 + 3x2 − 2x3 + 2x5 = 0

5x3 + 10x4 + 15x6 = 5

6x6 = 2

0=0

F3 ↔ F4 .

Esta matriz es escalonada, y nos proporciona el sistema

m

at

Las soluciones se encuentran fácilmente

sustituyendo de abajo hacia arriba,

obteniéndose:

x6 = 13 , x3 = −2x4 , x1 = −3x2 − 4x4 − 2x5 , donde x2 , x4 y x5 pueden tomar cualquier valor. Las

soluciones son: (−3x2 − 4x4 − 2x5 , x2 , −2x4 , x4 , x5 , 31 ) para todo x2 , x4 y x5 ∈ IR.

El primer elemento distinto de cero de las filas lo llamaremos elemento principal y las incógnitas

correspondientes a estos elementos incógnitas principales.

Si en alguna fila el elemento principal está en la columna ampliada, el sistema no tiene solución

(obviamente una de las ecuaciones equivalentes será 0x1 + . . . + 0xn = k(elemento principal 6= 0)

y esta igualdad no puede cumplirse para ningún valor que demos a las incógnitas). En este caso,

diremos que se trata de un sistema incompatible.

Si el sistema tiene solución, es decir, si el sistema es compatible, tenemos dos casos:

Si el número de elementos principales es igual que el número de

tiene

incógnitas el sistema

1 −2 0 0

solución única. Supongamos que la matriz escalonada obtenida es 0 5 15 5 , el sistema

0 0 6 2

x

=

2x

x

=

0

2

1

1

5x2 = 5 − 15x3 y se obtiene

x2 = 0 solución única. En este caso, diremos que se trata

6x3 = 2

x3 = 31

de un sistema compatible determinado.

Matemáticas I

4

1.3 Matriz transpuesta. Inversa de una matriz

m

at

Si el número de elementos principales es menor que el número de incógnitas el sistema tiene

infinitas soluciones. Basta observar el ejemplo 6 anterior, tenemos una solución para cada uno

de los posibles valores de x2 , x4 y x5 . En este caso, diremos que se trata de un sistema

compatible indeterminado.

Sistemas homogéneos

Un sistema de ecuaciones lineales se dice que es homogéneo si tiene todos los términos independientes cero; es decir, un sistema de la forma AX = 0.

Un sistema homogéneo siempre tiene solución (en efecto X = 0 es siempre solución, a esta

solución suele llamarse la solución trivial y de cualquier otra solución distinta de ésta se dice solución

no trivial).

1.2.2.

Método de Gauss-Jordan

El método de Gauss-Jordan continúa el método de Gauss, haciendo operaciones elementales para

conseguir una matriz escalonada reducida que tiene unos por elementos principales y en las

columnas que contienen a dichos unos todos los demás elementos son cero.

Continuando con el

1 3 −2 0 2

0 0 5 10 0

0 0 0

0 0

0 0 0 0 0

1

0

0

0

1

0

0

0

1

0

0

0

sistema anterior

0 0

15 5

Hacemos 1 los elementos principales:

6 2

F2 → 15 F2 y F3 → 16 F3 .

0 0

3 −2 0 2 0 0

0 1 2 0 3 1

1

0 0 0 0 1 3

0 0 0 0 0 0

3 −2 0 2 0 0

0 1 2 0 0 0

1

0 0 0 0 1 3

0 0 0 0 0 0

3

0

0

0

0

1

0

0

4

2

0

0

2

0

0

0

0 0

0 0

1

1 3

0 0

Hay que hacer cero el 3 de F2 y C6 (a26 ):

F2 → F2 − 3F3 .

Hay que hacer cero el -2 de F1 y C3

(a13 ): F1 → F1 + 2F2 .

x1 = −3x2 − 4x4 − 2x5

Luego x3 = −2x4

x6 = 13

obteniéndose, naturalmente, las mismas soluciones que antes.

1.3.

1.3.1.

Matriz transpuesta. Inversa de una matriz

Matriz transpuesta

Definición 7.- Si A es una matriz m × n llamamos matriz transpuesta de A a la matriz At de

tamaño n × m que tiene por filas las columnas de A y por columnas las filas de A.

Matemáticas I

5

1.3 Matriz transpuesta. Inversa de una matriz

m

at

Proposición 8.- Se verifican las siguientes propiedades:

1. (At )t = A

2. (A + B)t = At + B t

3. (kA)t = kAt

4. (AB)t = B t At

(en general (A1 A2 · · · An )t = Atn · · · At2 At1 )

Definición 9.- Una matriz cuadrada A se dice simétrica si A = At , es decir, si aij = aji para todo

i,j. Se dice antisimétrica si A = −At , es decir, si aij = −aji para todo i,j.

1.3.2.

Matrices inversibles

Definición 10.- Si A es una matriz cuadrada de orden n, An×n , y existe Bn×n tal que AB = I

ó BA = I (en cuyo caso AB = BA = I), se dice que A es inversible y que B es inversa de A.

Si una matriz A tiene inversa, esta es única y se denotará por A−1 .

Proposición 11.- Las matrices elementales son inversibles y sus inversas son también elementales:

De intercambiar dos filas, intercambiarlas de nuevo.

De multiplicar una fila por k 6= 0, multiplicar esa fila por 1/k.

De sumar a una fila un múltiplo de otra, restar a esa fila el múltiplo sumado.

Teorema 12.- Si A y B son dos matrices inversibles, entonces AB es inversible y

(AB)−1 = B −1 A−1 .

Demostración:

Basta comprobarlo:

(AB)B −1 A−1 = A(BB −1 )A−1 = AA−1 = I.

−1 −1

En general (A1 A2 · · · Ak )−1 = A−1

k · · · A2 A1

Proposición 13 (Propiedades).1. (A−1 )−1 = A,

2. (An )−1 = (A−1 )n ,

3. Si k 6= 0 entonces (kA)−1 = k1 A−1 .

Definición 14.- Una matriz cuadrada, A, se dice ortogonal si A−1 = At .

Teorema 15.- Sea An×n una matriz. Son equivalentes:

a) A es inversible.

b) El sistema homogéneo asociado AX = 0 tiene solución única.

c) Por operaciones elementales en A puedo llegar a la identidad.

Corolario 16 (Cálculo de A−1 por el método de Gauss).- Si A es inversible ya vimos que

Ek · · · E2 E1 A = I, luego A−1 = Ek · · · E2 E1 . Puede fácilmente calcularse la inversa a partir de

las operaciones elementales, sin más que realizar sobre I las mismas operaciones elementales que

efectuemos sobre A para llegar a la identidad. Es decir,

Tomando (A|I) −→ efectuando las operaciones en A e I se llega a −→ (I|A−1 )

Matemáticas I

6

m

at

1.3 Matriz transpuesta. Inversa de una matriz

1.3.3.

Determinante de una matriz cuadrada

Definición 17.- Sea A ∈ Mn×n , llamaremos menor del elemento aij y lo denotaremos por Mij ,

al determinante de la submatriz que se forma al suprimir en A la fila i y la columna j. Al número

(−1)i+j Mij lo llamaremos cofactor del elemento aij y lo denotaremos por Cij .

Definición 18.- Sea A ∈ Mn×n . Se define el determinante de A, que denotaremos por det(A) ó det A

ó |A|, de la siguiente manera:

Si n = 1, det A = a11 .

Si n ≥ 2, det A = a11 C11 + a12 C12 + · · · + a1n C1n

Ejemplo 19.

1 2 3 5 6

4 5 6 = 1

8 9

7 8 9 −2

4 5

4 6 + 3

7 8

7 9 = 1(5 · 9 − 6 · 8) − 2(4 · 9 − 6 · 7) + 3(4 · 8 − 5 · 7) = 0

La definición de determinante que hemos dado utiliza los cofactores de la primera fila de la matriz,

pero podrı́amos haber utilizado cualquier otra fila o columna, como pone de manifiesto el siguiente

resultado

Teorema 20.- Sea A ∈ Mn×n entonces

det(A) =

n

X

aik Cik para cualquier fila i = 1, 2, . . . , n y

k=1

det(A) =

n

X

akj Ckj para cualquier columna j = 1, 2, . . . , n

k=1

Puesto que el resultado anterior permite el cálculo del determinante por cualquier fila o columna

de la matriz, elegiremos la que tenga más ceros.

Dos resultados inmediatos:

1. Si A es una matriz que tiene una fila o una columna de ceros, entonces |A| = 0.

2. Si A es una matriz triangular (superior o inferior) entonces |A| es el producto de los elementos

de la diagonal principal, |A| = a11 a22 · · · ann .

Cálculo de determinantes por reducción a la forma escalonada

Teorema 21 (de las operaciones elementales).- Sea An×n una matriz. Se tiene:

a) que si A′ es la matriz que resulta de multiplicar una fila de A por una constante k, entonces

det(A′ ) = k det(A).

b) que si A′ es la matriz que resulta de intercambiar dos filas de A, entonces

det(A′ ) = − det(A).

c) que si A′ es la matriz que resulta de sumar a una fila k un múltiplo de la fila i, entonces

det(A′ ) = det(A).

Matemáticas I

7

m

at

1.4 Rango de una matriz. Teorema de Rouché

Corolario 22.- Una matriz con dos filas iguales tiene determinante cero.

Demostración:

Sea B una matriz cuadrada que tiene la fila i y la fila k iguales, entonces por la parte b) anterior,

si intercambiamos las filas i y k que son iguales se obtiene que det(B) = − det(B) es decir que

det(B) = 0.

Lema 23.- Para An×n tenemos que: det(At ) = det(A) y det(kA) = k n det(A).

Teorema 24.- Si A y B son matrices cuadradas de orden n, entonces

det(AB) = det(A) · det(B).

Teorema 25.- Para An×n se cumple: A es inversible ⇔ det(A) 6= 0, en cuyo caso det(A−1 ) = det1(A) .

Regla de Cramer.

Teorema 26.- Sea AX = B, un sistema de n ecuaciones con n incógnitas, tal que A es inversible,

entonces el sistema tiene como única solución:

x1 =

1.4.

b1 a12 · · · a1n b2 a22 · · · a2n ..

.. . .

. . .. .

.

bn an2 · · · ann , x2 =

|A|

a11 b1

a21 b2

..

..

.

.

an1 bn

· · · a1n · · · a2n . ..

. .. · · · ann , . . . , xn =

|A|

a11 a12 · · · b1 a21 a22 · · · b2 ..

.. . .

. . .. .

.

an1 an2 · · · bn .

|A|

Rango de una matriz. Teorema de Rouché

Definición 27.- Se llama rango de una matriz Am×n , rang(A) ó rg(A), al máximo orden que resulta

de considerar todas las submatrices cuadradas de A, cuyo determinante es distinto de cero.

Resultan evidentes, estos resultados:

- Si A es m × n, entonces: rg(A) ≤ mı́n(m, n).

- Si A es m × n, entonces: rg(A) = rg(At ).

- Si A es n × n, entonces: rg(A) = n ⇐⇒ det(A) 6= 0.

Dado que el rango de una matriz no varı́a realizando en ella operaciones elementales puede también

definirse el rango como:

“el número de filas distintas de cero que aparecen en alguna de las formas escalonadas de

la matriz”.

Proposición 28.- Sea Am×n una matriz, y Mr×r una submatriz de A con determinante distinto de

cero. Entonces, si el determinante de todas las submatrices de orden r + 1 que se pueden conseguir

en A añadiendo una fila y una columna a M son cero, el rango de A es r.

Matemáticas I

8

m

at

1.4 Rango de una matriz. Teorema de Rouché

Este resultado permite encontrar el rango de una matriz buscando una submatriz de orden uno

con determinante distinto de cero; si ésta existe, buscamos una de orden 2 con determinante no nulo

que “orle” a la anterior (si esta no existe no será posible encontrar ninguna otra submatriz de orden

2 de determinante no nulo, por lo que el rango es 1); si existiese, buscarı́amos ahora una de orden 3

con determinante no nulo que orlase a esta última; y ası́ sucesivamente.

Teorema 29 (Teorema de Rouché).- Sea el sistema AX = B, sistema de m ecuaciones con n

incógnitas. Entonces: AX = B tiene solución si, y sólo si, rg(A) = rg(A|B). En caso de tener solución,

si rg(A) = r, toda solución puede expresarse en la forma: X = V0 + t1 V1 + t2 V2 + · · · + tn−r Vn−r ,

siendo V0 una solución particular de AX = B y los V1 , . . . , Vn−r soluciones del sistema homogéneo

asociado AX = 0.

Resumiendo:

Si rg(A) = r, entonces:

rg(A) = rg(A|B) =⇒ Sist. Compatible (con sol.)

(

r = n → Sist. Comp. Determinado.

r < n → Sist. Comp. Indeterminado.

rg(A) 6= rg(A|B) =⇒ Sist. Incompatible (no tiene solución)

Matemáticas I

9

Capı́tulo 2

Espacios vectoriales reales.

2.1.

Espacios vectoriales.

Definición 30.- Un espacio vectorial real V es un conjunto de elementos denominados vectores,

junto con dos operaciones, una que recibe el nombre de “suma de vectores” y otra que recibe el

nombre de “producto de vectores por números reales” o “producto por escalares”, que verifican las

siguientes propiedades:

1. u + v ∈ V ; ∀u, v ∈ V .

2. u + v = v + u; ∀u, v ∈ V .

3. u + (v + w) = (u + v) + w; ∀u, v, w ∈ V .

4. Existe un vector, llamado vector cero y denotado por 0, tal que: 0 + u = u + 0 = u; ∀u ∈ V .

5. Para cada vector u ∈ V , existe un vector de V , llamado opuesto de u y denotado por −u,

tal que u + (−u) = 0.

6. ku ∈ V ; ∀k ∈ IR y ∀u ∈ V .

7. k(u + v) = ku + kv; ∀k ∈ IR y ∀u, v ∈ V .

8. (k + l)u = ku + lu; ∀k, l ∈ IR y ∀u ∈ V .

9. (kl)u = k(lu); ∀k, l ∈ IR y ∀u ∈ V .

10. 1u = u; ∀u ∈ V .

Se pueden considerar espacios vectoriales sobre cuerpos distintos de IR, en particular suelen ser

interesantes los espacios vectoriales complejos.

Proposición 31.- Algunas propiedades que se deducen de las anteriores son:

1. 0u = 0.

2. k0 = 0.

3. (−1)u = −u.

10

2.2 Subespacios vectoriales.

m

at

4. ku = 0 ⇐⇒ k = 0 ó u = 0.

5. El vector cero de un espacio vectorial es único.

6. El vector opuesto de cada vector del espacio vectorial es único.

2.2.

Subespacios vectoriales.

Definición 32.- Un subconjunto W de un espacio vectorial V es un subespacio vectorial de V

si, W es por si solo un espacio vectorial con las operaciones definidas en V .

Para ver si un subconjunto W de un espacio vectorial V es subespacio vectorial, es condición necesaria

y suficiente que se verifiquen:

a) u + v ∈ W ; ∀u, v ∈ W

b) ku ∈ W ; ∀u ∈ W y ∀k ∈ IR

Estas dos propiedades son a su vez equivalentes a que se cumpla la propiedad:

ku + lv ∈ W ; ∀u, v ∈ W y ∀k, l ∈ IR.

Definición 33.- Se dice que un vector v ∈ V es combinación lineal de los vectores v 1 , v 2 , . . . , v n

si y sólo si ∃c1 , c2 , . . . , cn ∈ IR tales que v = c1 v 1 + c2 v 2 + · · · + cn v n .

Definición 34.- Dado un conjunto de vectores S = {v 1 , v 2 , . . . , v k } de un espacio vectorial V ,

podemos considerar el subespacio vectorial, W , más pequeño que contiene a S. Dicho subespacio, es

el conjunto de todas las combinaciones lineales que se pueden formar con los vectores del conjunto

S, y se denota por lin S ó lin{v 1 , v 2 , . . . , v k }, y se dirá que v 1 , v 2 , . . . , v k generan W .

Definición 35 (Independencia lineal).- Dado un conjunto S = {v 1 , v 2 , . . . , v k } de vectores del

espacio vectorial V , la ecuación vectorial c1 v 1 + c2 v 2 + · · · + ck v k = 0 tiene al menos una solución,

a saber: c1 = c2 = · · · = ck = 0. Si esta solución es única, entonces se dice que S es un conjunto

linealmente independiente, (o que los vectores de S son linealmente independientes). Si existen

otras soluciones, entonces se dice que S es linealmente dependiente, (los vectores son linealmente

dependientes).

Se tiene la siguente caracterización para que un conjunto de dos o más vectores sea linealmente

dependiente:

“Un conjunto de dos o más vectores es linealmente dependiente si, y sólo si, al menos uno

de los vectores es una combinación lineal de los restantes.”

2.3.

Base y dimensión.

Definición 36.- Si V es un espacio vectorial y S = {v 1 , . . . , v n } es un conjunto finito de vectores

de V , diremos que S es una base de V si:

a) S es linealmente independiente, y

Matemáticas I

11

2.4 El espacio vectorial IRn

m

at

b) S genera a V .

Se podrı́a pensar que dos bases de un mismo espacio vectorial pudieran tener un número distinto de

vectores, pero no es ası́, como nos asegura el teorema siguiente:

Proposición 37.- Sean V un espacio vectorial y B una base de V formada por n vectores. Entonces

cualquier conjunto {v 1 , v 2 , . . . , v m } de vectores de V , con m > n, es linealmente dependiente.

Teorema 38 (Teorema de la base).- Cualesquiera dos bases de un espacio vectorial tienen el

mismo número de elementos.

Definición 39.- Un espacio vectorial V se dice de dimensión finita si contiene un conjunto finito

de vectores que forman una base.

Si no existe un conjunto de este tipo, se dice que V es de dimensión infinita.

Al espacio vectorial {0} le consideramos de dimensión finita, aún cuando no tiene conjuntos

linealmente independientes.

Si un espacio vectorial V es de dimensión finita, teniendo en cuenta el teorema de la base, diremos

que la dimensión de V , dim V , es el número de vectores de cualquier base de V .

Proposición 40.- Si V es un espacio vectorial de dimensión finita, con dim V = n, entonces:

a) un conjunto de n vectores de V es base de V , si el conjunto es linealmente independiente o si

genera a V .

b) a un conjunto de r vectores de V linealmente independiente, con r < n, se le pueden agregar

n − r vectores hasta formar una base de V .

2.4.

El espacio vectorial IRn

Es frecuente representar el conjunto de los números reales, IR, mediante el conjunto de puntos de

una recta en la que se ha definido un sistema de referencia (un origen, un sentido, y una unidad de

medida). Esta representación nos permite identificar gráficamente cada número real con un punto de

la recta, y viceversa.

También es conocida la representación de IR2 = IR × IR mediante el conjunto de los puntos de

un plano en el que se ha definido un sistema de coordenadas cartesianas (dos rectas perpendiculares

entre sı́ en las que se definen dos sistemas de referencia que tienen en común el punto origen, y la

unidad de medida). En este caso, se identifican pares de números reales, (x, y), con puntos del plano.

Análogamente se identifican ternas de números reales (x, y, z) con puntos del espacio en el que se

ha definido un sistema de coordenadas cartesianas (tres rectas perpendiculares entre sı́ . . . ). De esta

forma se establece una biyección entre el conjunto IR3 = IR × IR × IR y el conjunto de los puntos del

espacio tridimensional.

Aunque no sea identificable con una representación gráfica, nada impide considerar n-úplas de

números reales (x1 , x2 , . . . , xn ), con n ≥ 4. De este modo, llamaremos espacio n-dimensional, IRn ,

al conjunto

IRn = IR × IR × · · · × IR = {(x1 , . . . , xn ) : xi ∈ IR; ∀i = 1, . . . , n.}.

Utilizaremos la notación x para designar más brevemente al punto (x1 , . . . , xn ) de IRn . En este

caso, al número real xi lo llamaremos coordenada o componente i-ésima del punto o vector x.

Matemáticas I

12

m

at

2.4 El espacio vectorial IRn

Está claro que lo más frecuente es trabajar con IR2 ó IR3 , pero también es cierto que los casos

en que n > 3 se presentan con suficiente frecuencia en la práctica como para justificar su estudio.

Nos encontramos con un espacio n-dimensional cada vez que consideremos un objeto cuyo estudio

requiera contemplar n aspectos distintos susceptibles de variación.

Definición 41 (Igualdad de puntos).- Diremos que dos puntos x = (x1 , . . . , xn ) e

y = (y1 , . . . , yn ) de IRn son iguales, y escribiremos x = y si y sólo si xi = yi; ∀i = 1, . . . , n.

Definición 42 (Suma de puntos).- Llamaremos suma de dos puntos x, y ∈ IRn , y lo representaremos por x + y, al punto:

x + y = (x1 + y1 , . . . , xn + yn )

Definición 43 (Producto por escalares).- Llamaremos producto del punto x ∈ IRn por el

número real λ ∈ IR, y lo denotaremos por λx, al punto:

λx = λ(x1 , . . . , xn ) = (λx1 , . . . , λxn )

Estas dos operaciones dotan a IRn de una estructura de espacio vectorial. Por esta razón, llamaremos también vectores a los puntos de IRn .

El espacio vectorial IRn tiene dimensión n, y cualquier vector puede escribirse de la forma

(x1 , x2 , . . . , xn ) = x1 (1, 0, . . . , 0) + x2 (0, 1, . . . , 0) + · · · + xn (0, 0, . . . , 1).

El conjunto de los vectores

B = {e1 = (1, 0, . . . , 0), e2 = (0, 1, . . . , 0), . . . , en = (0, 0, . . . , 1)},

se denomina base canónica de IRn , y es la base más sencilla y cómoda, en general.

Evidentemente, existen otras operaciones que pueden dotar a IRn de estructura de espacio vectorial, pero las aquı́ definidas son las más usuales ya que supone trabajar con ellas a nivel geométrico

en los casos IR2 y IR3 .

Otros ejemplos de espacios vectoriales son:

1. El conjunto de todas las matrices de tamaño m × n con elementos reales, junto con las operaciones de suma de matrices y producto de números reales por matrices, ya indicadas. La

dimensión de este espacio Mm×n es mn y una base es

0 ...

0 ...

..

. ...

0 0 ...

1

0

..

.

0

0

..

.

0

,

1 ...

0 ...

..

. ...

0 0 ...

0

0

..

.

0

0

..

.

0

,...,

0 ...

0 ...

..

. ...

0 0 ...

0

0

..

.

0

0

..

.

1

2. El conjunto de todos los polinomios de grado menor o igual que n con coeficientes reales, junto

con las operaciones de suma y producto de números reales, ya conocidas. La dimensión de este

espacio Pn (IR) es n + 1 y una base es {1, x, x2 , . . . , xn }

3. El conjunto de las funciones f : IR −→ IR con las operaciones

a) (f + g)(x) = f (x) + g(x); ∀f, g: IR −→ IR

b) (kf )(x) = kf (x); ∀k ∈ IR y ∀f : IR −→ IR

Matemáticas I

13

2.5 Espacios de las filas y las columnas de una matriz. Coordenadas.

2.5.

m

at

Espacios de las filas y las columnas de una matriz. Coordenadas.

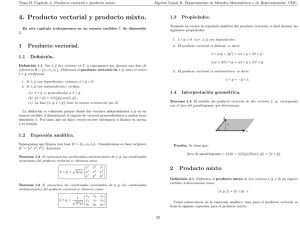

Definición 44.- Consideremos la matriz Am×n ,

A=

a11

a21

..

.

a12

a22

..

.

. . . a1n

. . . a2n

.

. . . ..

am1 am2 . . . amn

.

Los m vectores r 1 = (a11 , . . . , a1n ), r 2 = (a21 , . . . , a2n ), . . . , r m = (am1 , . . . , amn ) ∈ IRn , se denominan

vectores fila de A y el subespacio vectorial de IRn generado por ellos, Ef (A) = lin{r1 , r2 , . . . , rm },

espacio de las filas de A.

Los n vectores c1 = (a11 , . . . , am1 ), c2 = (a12 , . . . , am2 ), . . . , cn = (a1n , . . . , amn ) ∈ IRm , se denominan vectores columna de A y el subespacio vectorial de IRm generado por ellos, Ec (A) =

lin{c1 , c2 , . . . , cn }, espacio de las columnas de A.

Proposición 45.- Si A es una matriz de tamaño m × n, entonces las operaciones elementales sobre

las filas (resp. columnas) de A no cambian el espacio de las filas (resp. columnas) de A.

Corolario 46.- Sea A una matriz, entonces:

1. Los vectores no nulos en la forma escalonada de la matriz A, forman una base del espacio de

las filas de A.

2. Los vectores no nulos en la forma escalonada de la matriz At , forman una base del espacio de

las columnas de A.

Teorema 47.- Sea A una matriz de tamaño m × n, entonces:

dim(Ef (A)) = dim(Ec (A)).

Resultado inmediato teniendo en cuenta que rg(A) = rg(At ), y que el rango de una matriz coincide

con el número de vectores no nulos en la forma escalonada, ası́ como el resultado anterior.

Definición 48.- Dado un espacio vectorial V de dimensión finita y B = {v 1 , v 2 , . . . , v n } una base

de V , para cada vector v ∈ V existen unos únicos números reales c1 , c2 , . . . , cn tales que v =

c1 v 1 + c2 v 2 + · · · + cn v n . Estos números se denominan coordenadas de v relativas a la base B.

El vector de coordenadas de v relativo a la base B se denota mediante (v)B y es el vector de IRn :

(v)B = (c1 , c2 , . . . , cn ). La matriz de coordenadas

de v relativas a la base B se denota por [v]B y

c1

c2

t

es la matriz n × 1 definida por: [v]B = (v)B = ..

.

.

cn

Matemáticas I

14

m

at

2.6 Cambios de base.

2.6.

Cambios de base.

Definición 49.- Sean B = {u1 , u2 , . . . , un } y B ′ = {v 1 , v 2 , . . . , v n } son bases de un espacio vectorial

V . Recibe el nombre de matriz de transición o matriz de cambio de la base B a la base B ′ , la

matriz de dimensiones n × n, que por columnas es

P =

[u1 ]B′ [u2 ]B′ · · · [un ]B′

= M(B → B ′ ),

es decir, la columna i-ésima está constituida por las coordenadas del vector ui en la base B ′ .

Proposición 50.- Sea P la matriz de paso de una base B a otra base B ′ para un espacio vectorial

V . Entonces:

1. ∀x ∈ V se tiene que [x]B′ = P · [x]B .

2. P es inversible y su inversa, P −1 , es la matriz de paso de la base B ′ a la base B.

2.7.

2.7.1.

Espacios vectoriales con producto interior.

Producto interior. Norma. Distancia

Definición 51.- Un producto interior en un espacio vectorial real V es una función que a cada

par de vectores u, v ∈ V le asocia un número real, que denotaremos por hu, vi, de tal manera que

se cumplen las siguientes propiedades:

1. hu, vi = hv, ui; ∀u, v ∈ V .

2. hu + v, wi = hu, wi + hv, wi; ∀u, v, w ∈ V .

3. hku, vi = khu, vi; ∀u, v ∈ V y ∀k ∈ IR.

4. hu, ui ≥ 0; ∀u ∈ V y hu, ui = 0 ⇐⇒ u = 0.

Otra propiedades que se deducen de las anteriores son:

1. h0, ui = 0

2. hu, v + wi = hu, vi + hu, wi

3. hu, kvi = khu, vi

A partir de un producto interior sobre un espacio vectorial V se definen los conceptos de norma,

distancia y ángulo.

Definición 52.- Si V es un espacio vectorial con producto interior, entonces la norma o longitud

de un vector v ∈ V se denota mediante kvk y se define como

q

kvk = + hv, vi.

La distancia entre dos vectores u y v de V se denota mediante d(u, v) y se define como

q

d(u, v) = ku − vk = + hu − v, u − vi.

Matemáticas I

15

m

at

2.7 Espacios vectoriales con producto interior.

Teorema 53 (Desigualdad de Cauchy-Schwarz).- Para todo u, v ∈ V , espacio con producto

interior, se tiene que

hu, vi2 ≤ kuk2 kvk2 .

Definición 54.- Si u y v son vectores, distintos de cero, de un espacio con producto interior, entonces, como consecuencia de la desigualdad de Cauchy-Schwarz se tiene que

−1 ≤

hu, vi

≤1

kuk · kvk

y por tanto existe un único ángulo, θ, tal que

cos θ =

hu, vi

, con 0 ≤ θ ≤ π

kuk · kvk

Definición 55.- En un espacio vectorial con producto interior, V , dos vectores u y v se dicen

ortogonales si hu, vi = 0.

Además, si u ∈ V es ortogonal a todos los vectores de un conjunto W , se dice que u es ortogonal

a W.

Proposición 56 (Propiedades básicas de la norma).1. kuk ≥ 0; ∀u ∈ V

2. kuk = 0 ⇐⇒ u = 0

3. kkuk = |k| · kuk; ∀u ∈ V y ∀k ∈ IR

4. ku + vk ≤ kuk + kvk; ∀u, v ∈ V

Proposición 57 (Propiedades básicas de la distancia).1. d(u, v) ≥ 0; ∀u, v ∈ V

2. d(u, v) = 0 ⇐⇒ u = v

3. d(u, v) = d(v, u); ∀u, v ∈ V

4. d(u, v) ≤ d(u, w) + d(w, v); ∀u, v, w ∈ V

2.7.2.

El espacio euclı́deo n-dimensional: IRn

Sobre el espacio vectorial IRn definimos la siguiente función

IRn × IRn −→ IR

(x, y) −→ x · y = x1 y1 + · · · + xn yn =

n

X

xi yi

i=1

siendo x = (x1 , . . . , xn ) e y = (y1 , . . . , yn ).

Como puede verse fácilmente dicha función es un producto interior, el que se conoce como producto interior euclı́deo. Este producto interior da lugar a las conocidas como norma y distancia

euclı́deas.

Se llama espacio euclı́deo n-dimensional a IRn con las operaciones de suma, producto por

escalares y producto interior definidos.

El producto interior euclı́deo, aquı́ definido, constituye una generalización a IRn del producto

escalar definido, y bien conocido, en IR2 y IR3 .

Matemáticas I

16

2.7 Espacios vectoriales con producto interior.

m

at

Teorema 58 (Generalización del Teorema de Pitágoras).- Si u y v son dos vectores ortogonales de un espacio vectorial con producto interior, entonces

ku + vk2 = kuk2 + kvk2 .

Este resultado de fácil demostración, se reduce en IR2 con el producto interior euclı́deo, al conocido

teorema de Pitágoras.

2.7.3.

Bases ortonormales. Proceso de Gram-Schmidt

Definición 59.- Sean V un espacio vectorial de dimensión n con producto interior y

B = {v 1 , v 2 , . . . , v n } una base de V . Se dice que B es una base ortonormal de V si kv i k = 1,

∀i = 1, . . . , n y hv i , v j i = 0; ∀i, j = 1, . . . , n con i 6= j.

La ventaja de trabajar con bases ortonormales es muy grande como ya es conocido en IR2 ó IR3 .

Teorema 60.- Si B = {v 1 , v 2 , . . . , v n } es una base ortonormal para un espacio, V , con producto

interior, entonces ∀v ∈ V se tiene que:

v = hv, v 1 iv 1 + hv, v 2 iv 2 + · · · + hv, v n iv n ,

es decir, (v)B = (hv, v 1 i, hv, v 2 i, . . . , hv, v n i).

Teorema 61.- Si S = {v 1 , v 2 , . . . , v k } un conjunto finito de vectores no nulos, ortogonales dos a

dos, entonces S es linealmente independiente.

Teorema 62.- Si P es la matriz de paso de una base ortonormal B a otra base ortonormal B ′ ,

entonces P es una matriz ortogonal (es decir, P t = P −1 ).

Teorema 63.- Sean V un espacio vectorial con producto interior y S = {v 1 , v 2 , . . . , v k } un conjunto

finito ortonormal de vectores de V . Sea W = lin S, entonces cualquier v ∈ V se puede expresar de

forma única como v = w 1 + w2 , donde w1 ∈ W viene dado por w1 = hv, v 1 iv 1 + hv, v2 iv 2 + · · · +

hv, v k iv k y w 2 es ortogonal a W (lógicamente w 2 = v − w 1 ).

A w 1 se le llama proyección ortogonal de v sobre W y se le denota por ProyW v. Al vector

w2 se le llama componente ortogonal de v sobre W .

Teorema 64 (Proceso de ortonormalización de Gram-Schmidt).- Sean V un espacio vectorial con producto interior de dimensión finita y B = {v 1 , v2 , . . . , vn } una base de V . Vamos a describir

un proceso para conseguir a partir de la base B una base ortonormal B ′ = {u1 , u2 , . . . , un }. Este

proceso de ortonormalización es el de Gram-Schmidt y se basa en el teorema anterior.

Demostración:

1a etapa.- Tomamos u1 =

Matemáticas I

v1

, que tiene norma 1.

kv 1 k

17

2.7 Espacios vectoriales con producto interior.

m

at

2a etapa.- Sea W1 = lin{u1 }, aplicando el teorema anterior, sabemos que el vector

u2 =

v 2 − ProyW1 v 2

v 2 − hv 2 , u1 iu1

=

kv 2 − ProyW1 v 2 k

kv 2 − hv 2 , u1 iu1 k

es ortogonal a W1 y en particular a u1 , y además tiene norma 1. El único problema que se plantea es si

v1

v 2 −hv 2 , u1 iu1 = 0, pero ésto no es posible puesto que en ese caso 0 = v 2 − hv 2 , u1 iu1 = v 2 − hv 2 , u1 i

=

kv 1 k

hv 2 , v 1 i

λ1 v 1 + λ2 v 2 ; para λ1 = −

, λ2 = 1 y {v 1 , v 2 } serı́a un conjunto linealmente dependiente, lo

kv 1 k2

que es absurdo por ser B = {v1 , v 2 , . . . , v n } una base de V .

3a etapa.- Sea W2 = lin{u1 , u2 }, aplicando el teorema anterior, sabemos que el vector

u3 =

v 3 − ProyW2 v 3

v 3 − hv 3 , u1 iu1 − hv 3 , u2 iu2

=

kv 3 − ProyW2 v 3 k

kv3 − hv 3 , u1 iu1 − hv 3 , u2iu2 k

es ortogonal a W2 y en particular a u1 y u2 , y además tiene norma 1. El único problema que se

plantea es si v 3 − hv 3 , u1 iu1 − hv 3 , u2 iu2 = 0, pero ésto no es posible puesto que en ese caso

0 = v 3 − hv3 , u1 iu1 − hv 3 , u2 iu2 =

v1

v 2 − hv 2 , u1 iu1

= v 3 − hv3 , u1 i

− hv3 , u2 i

= λ1 v 1 + λ2 v 2 + λ3 v 3 ;

kv 1 k

kv 2 − hv 2 , u1 iu1 k

y como λ3 = 1, {v 1 , v 2 , v 3 } serı́a un conjunto linealmente dependiente, lo que es absurdo por ser

B = {v 1 , v2 , . . . , vn } una base de V .

Continuando con el proceso se va construyendo un conjunto ortonormal de n vectores no nulos, B ′ =

{u1 , u2 , . . . , un }. Dado que dim V = n y que todo conjunto ortonormal es linealmente independiente,

se concluye que B ′ es una base ortonormal de V .

Matemáticas I

18

Capı́tulo 3

Aplicaciones lineales

Definición 65.- Sea f : V −→ W una aplicación entre los espacios vectoriales reales V y W . Se dice

que f es una aplicación lineal si:

1. f (u + v) = f (u) + f (v); ∀u, v ∈ V

2. f (ku) = kf (u); ∀u ∈ V , ∀k ∈ IR

Las dos propiedades se pueden reunir en una sola:

f (ku + lv) = kf (u) + lf (v);

∀u, v ∈ V,

∀k, l ∈ IR

En general, se tiene que:

f (k1 u1 + k2 u2 + · · · + kr ur ) = k1 f (u1 ) + k2 f (u2 ) + · · · + kr f (ur )

∀u1 , u2 . . . . , ur ∈ V,

∀k1 , k2, . . . , kr ∈ IR

Si una aplicación f : V −→ W es lineal y biyectiva, se dice que f es un isomorfismo entre los

espacios V y W .

Si V = W , entonces la aplicación lineal f : V −→ V recibe el nombre de operador lineal o

endomorfismo. Y si f es además biyectiva se dice que f es un automorfismo.

3.1.

Propiedades de las aplicaciones lineales. Núcleo e imagen.

Proposición 66.- Si f : V −→ W es una aplicación lineal, entonces:

1. f (0V ) = 0W ; 0V , 0W son los ceros de V y W .

2. f (−v) = −f (v); ∀v ∈ V .

Definición 67.- Dada una aplicación lineal f : V −→ W , se define el núcleo de f , que se denota

por Ker(f ) ó Ker f , como el conjunto:

Ker f = {v ∈ V : f (v) = 0}

y se define la imagen de f , que se denota por Im(f ) ó Im f , como el conjunto

Im f = {w ∈ W : ∃v ∈ V tal que f (v) = w}

19

m

at

3.2 Aplicaciones matriciales

Es sencillo probar que Ker f es un subespacio vectorial de V e Im f es subespacio vectorial de W .

Definición 68.- Si f : V −→ W es una aplicación lineal, entonces la dimensión del núcleo se denomina la nulidad de f y la dimensión de la imagen de f se denomina el rango de f .

Si f : V −→ W es una aplicación lineal y B = {v 1 , v 2 , . . . , v n } es una base de V , la aplicación

lineal queda perfectamente determinada si conocemos las imágenes por f de los vectores de la base

B, ya que para todo v ∈ V existen k1 , k2 , . . . , kn ∈ IR únicos, tales que v = k1 v 1 + k2v 2 + · · · + kn v n ,

con lo que

f (v) = f (k1 v 1 + k2 v 2 + · · · + kn v n ) = k1 f (v 1 ) + k2 f (v 2 ) + · · · + kn f (v n )

Nótese, que de ésto se deduce que Im f = lin{f (v1 ), f (v2 ), . . . , f (v n )}

Teorema 69 (de la dimensión).- Si f : V −→ W es una aplicación lineal, con V un espacio vectorial de dimensión n, entonces:

dim(Ker f ) + dim(Im f ) = n = dim(V )

3.2.

Aplicaciones matriciales

Consideremos la aplicación f : IRn −→ IRm definida por f (x) = Ax, siendo A una matriz fija

m × n y x ∈ IRn , x = (x1 , x2 , . . . , xn )t .

Como consecuencia de las operaciones sobre las matrices, la aplicación es lineal. A este tipo de

aplicaciones se les denomina aplicaciones matriciales.

El estudio de estas aplicaciones es fundamental ya que, como veremos, todas las aplicaciones

lineales entre espacios vectoriales de dimensión finita acaban siendo aplicaciones matriciales al usar

coordenadas.

El núcleo de estas aplicaciones será:

Ker f = {x ∈ IRn : Ax = 0},

es decir, el conjunto de soluciones del sistema homogéneo Ax = 0.

La imagen de f coincide con el espacio de las columnas de la matriz A, Ec (A), pues

b ∈ Im(f ) ⇐⇒ ∃x ∈ IRn : Ax = b

Matemáticas I

20

m

at

3.3 Matrices que representan aplicaciones lineales

es decir, si tiene solución el sistema

a11

a21

..

.

⇐⇒

⇐⇒

3.3.

x1

a11

a21

..

.

am1

· · · a1n

· · · a2n

.

· · · ..

am1 am2 · · · amn

a12

a22

..

.

x1

x2

..

.

xn

=

a11 x1 + a12 x2 + · · · + a1n xn

a21 x1 + a22 x2 + · · · + a2n xn

············

am1 x1 + am2 x2 + · · · + amn xn

+ x2

a12

a22

..

.

am2

a1n

a2n

..

.

+ · · · + xn

amn

b1

b2

..

.

bm

=

=

⇐⇒

b1

b2

..

.

bm

b1

b2

..

.

bm

⇐⇒

⇐⇒ b ∈ Ec (A)

Matrices que representan aplicaciones lineales

Veremos que toda transformación o aplicación lineal entre espacios vectoriales de dimensión finita,

se puede considerar como una aplicación matricial.

Aplicaciones lineales de IRn en IRm

3.3.1.

Proposición 70.- Si f : IRn −→ IRm es una aplicación lineal, entonces f es una aplicación matricial

(es decir existe una matriz A tal que f (x) = Ax).

Demostración:

Sea B = {e1 , e2 , . . . , en } la base canónica de IRn , y sea A la matriz m × n que tiene a los vectores

f (e1 ), f (e2 ), . . . , f (en ) de IRm como sus vectores columna. Vamos a probar que f (x) = Ax; ∀x ∈ IRn .

Se tiene que x = (x1 , x2 , . . . , xn ) = x1 e1 + · · · + xn en y por la linealidad de f ,

f (x) = x1 f (e1 ) + · · · + xn f (en ).

Por otra parte

Ax =

=

x1

a11

a21

..

.

a12

a22

..

.

· · · a1n

· · · a2n

.

· · · ..

am1 am2 · · · amn

a11

a21

..

.

am1

+ x2

a12

a22

..

.

am2

x1

x2

..

.

xn

+ · · · + xn

=

a1n

a2n

..

.

amn

a11 x1 + a12 x2 + · · · + a1n xn

a21 x1 + a22 x2 + · · · + a2n xn

············

am1 x1 + am2 x2 + · · · + amn xn

=

= x1 f (e1 ) + · · · + xn f (en ) = f (x)

Luego efectivamente, f (x) = Ax, para A definida como indicamos.

A esta matriz A se la llama matriz estándar de f .

Matemáticas I

21

m

at

3.3 Matrices que representan aplicaciones lineales

3.3.2.

Aplicaciones lineales entre espacios cualesquiera

Vamos ahora a demostrar que a cualquier aplicación lineal f : V −→ W , con dim V = n y dim W =

m, se le puede asociar una aplicación matricial.

Sean B = {v 1 , v 2 , . . . , v n } una base del espacio V y B ′ = {w1 , w 2 , . . . , wm } una base de W .

Todo v ∈ V se escribe de forma única como combinación lineal de los vectores de la base,

v = k1 v 1 + k2 v 2 + · · · + kn v n , luego f (v) = k1 f (v 1 ) + k2 f (v 2 ) + · · · + kn f (v n ). Supongamos que

conocemos las imágenes de f (v 1 ), f (v 2 ), . . . , f (v n ) expresadas en la base B ′ ,

f (v 1 ) = a11 w 1 + a21 w 2 + · · · + am1 w m

f (v 2 ) = a12 w 1 + a22 w 2 + · · · + am2 w m

·····················

f (v n ) = a1n w 1 + a2n w 2 + · · · + amn w m

por tanto

f (v) = k1 (a11 w 1 + a21 w 2 + · · · + am1 w m ) + k2 (a12 w 1 + a22 w 2 + · · · + am2 w m )

+ · · · · · · · · · · · · · · · · · · + kn (a1n w 1 + a2n w 2 + · · · + amn w m )

= (k1 a11 + k2 a12 + · · · + kn a1n )w 1 + (k1 a21 + k2 a22 + · · · + kn a2n )w 2

+ · · · · · · · · · · · · · · · · · · + (k1 am1 + k2 am2 + · · · + kn amn )wm

que expresado en coordenadas

[f (v)]B′ =

k1 a11 + k2 a12 + · · · + kn a1n

k1 a21 + k2 a22 + · · · + kn a2n

···············

k1 am1 + k2 am2 + · · · + kn amn

=

a11

a21

..

.

a12

a22

..

.

· · · a1n

· · · a2n

.

· · · ..

am1 am2 · · · amn

k1

k2

..

.

kn

Luego, hemos encontrado que

[f (v)]B′ =

[f (v 1 )]B′ [f (v 2 )]B′ · · · [f (v n )]B′

[v]B = A[v]B

Por tanto fijadas las bases B y B ′ en los espacios V y W , a cada aplicación lineal f se le puede

asociar una única matriz, Am×n , que recibe el nombre de matriz de f respecto de las bases B y

B ′ , A = M(f ; B, B ′ ).

Si tenemos un operador lineal f : V −→ V y consideramos que tenemos la misma base B en el

espacio de partida y en el de llegada, entonces se habla de matriz de f respecto de la base

B,A = M(f ; B).

Si nos dicen que la matriz Am×n es la matriz de la aplicación lineal f : V −→ W respecto de las

bases B y B ′ . ¿Cómo calcularemos Ker f e Im f ?

Cálculo de Ker f

Ker f = {v ∈ V : f (v) = 0} = {v ∈ V : [f (v)]B′ = [0]B′ } = {v ∈ V : A[v]B = [0]B′ }

Luego para calcular Ker f hallaremos las soluciones del sistema homogéneo Ax = 0, y esas

soluciones constituirán las coordenadas de los vectores del Ker f en la base B. El paso de coordenadas

a vectores es inmediato.

Matemáticas I

22

m

at

3.4 Composición de aplicaciones lineales

Cálculo de Im f

Hemos visto que Im f = lin{f (v 1 ), f (v 2 ), . . . , f (vn )} luego para calcular una base de la imagen

hay que encontrar una base de ese subespacio. Pero un conjunto de vectores de un espacio vectorial

es base si lo es el conjunto formado por los vectores de coordenadas (ejercicio 2.??), luego basta

con encontrar una base para el espacio de las columnas de la matriz A. Por tanto, se verifica que

rg(f ) = rg(A).

3.4.

Composición de aplicaciones lineales

Definición 71.- Sean f : V −→ W y g: W −→ U aplicaciones lineales. Llamaremos aplicación

compuesta de f y g, a la aplicación g ◦ f : V −→ U definida por

(g ◦ f )(v) = g(f (v)),

∀v ∈ V.

Proposición 72.- Sean f : V −→ W y g: W −→ U aplicaciones lineales, con dim V = n, dim W = m

y dim U = p, y sean B, B ′ y B ′′ bases de V , W y U, respectivamente. Entonces:

a) g ◦ f es una aplicación lineal.

b) Si Am×n es la matriz asociada a f respecto de las bases B y B ′ , y Cp×m es la matriz asociada

a g respecto de las bases B ′ y B ′′ , entonces CA es la matriz asociada a g ◦ f respecto de las

bases B y B ′′ .

Demostración:

a) (g ◦ f )(ku + lv) = g(f (ku + lv)) = g(kf (u) + lf (v)) = kg(f (u)) + lg(f (v)) = k(g ◦ f )(u) +

l(g ◦ f )(v).

b) Teniendo en cuenta que [g(w)]B′′ = C[w]B′ y [f (v)]B′ = A[v]B ,

[(g ◦ f )(v)]B′′ = [g(f (v))]B′′ = C[f (v)]B′ = CA[v]B ;

3.5.

∀v ∈ V

Teorema de Semejanza

Teorema 73.- Sean f : V −→ V , con dim V = n, un operador lineal, A la matriz de f respecto de

la base B de V y A′ la matriz de f respecto de la base B ′ . Entonces

A′ = P −1 AP

siendo P la matriz de paso de la base B ′ a la base B.

Demostración:

A′ [v]B′ = [f (v)]B′ = P −1 [f (v)]B = P −1 A[v]B = P −1 AP [v]B′

Como lo verifica para todo v ∈ V , (ejercicio 1.??) se llega a que A′ = P −1 AP .

Este resultado es un caso particular del siguiente más general:

Matemáticas I

23

3.5 Teorema de Semejanza

m

at

Teorema 74 (Teorema de semejanza).- Si f : V −→ W es una aplicación lineal, A la matriz de

la aplicación f respecto de las bases B1 de V y B2 de W y A′ es la matriz de f respecto de las bases

B1′ de V y B2′ de W , entonces

A′ = QAP

siendo P la matriz de paso de la base B1′ a la base B1 y Q la matriz de paso de B2 a B2′ .

Definición 75.- Dadas dos matrices A y B de orden n se dice que A y B son semejantes si, y sólo

si existe una matriz P inversible tal que B = P −1 AP .

Proposición 76.- Dos matrices A y B son semejantes si y sólo si representan al mismo operador

lineal respecto a dos bases.

Demostración:

⇐=) Es el Teorema de Semejanza.

=⇒) A y B son semejantes ⇐⇒ ∃P inversible tal que B = P −1 AP .

Consideremos el operador lineal f : IRn −→ IRn definido por f (x) = Ax, luego A es la matriz de

f respecto de la base canónica. P es inversible luego sus columnas forman una base de IRn , y por

tanto P es la matriz de paso de la base formada por las columnas de P a la base canónica. Por el

Teorema de Semejanza B = P −1AP es la matriz de f respecto a esa base y A y B representan al

mismo operador lineal respecto a bases distintas.

Como consecuencia de este resultado se tiene también que si A y B son semejantes, entonces

tienen el mismo rango.

Matemáticas I

24

Capı́tulo 4

Diagonalización

4.1.

Introducción. Valores y vectores propios.

Planteamiento del problema.

Problema general de diagonalización. Dado un operador lineal f sobre un espacio vectorial V

de dimensión n, nos planteamos el problema de cuándo es posible encontrar una base de V respecto de

la cuál la matriz de f sea diagonal. Si A es la matriz del operador f con respecto a una determinada

base entonces el planteamiento anterior es equivalente a preguntarse cuándo existe un cambio de

base tal que la matriz del operador en la nueva base sea diagonal. Esa nueva matriz sabemos que

viene dada por P −1AP , donde P es la matriz de paso de la nueva base a la anterior (Teorema de

Semejanza).

Problema de la diagonalización ortogonal. Dado un operador lineal f sobre un espacio vectorial V con producto interior y de dimensión n, nos planteamos el problema de cuándo es posible

encontrar una base ortonormal de V respecto de la cuál la matriz de f sea diagonal. Si V es un

espacio con producto interior y las bases son ortonormales entonces se tendrá que P será ortogonal.

Podemos pues formular los dos problemas anteriores en términos de matrices.

Problema 1. Dada una matriz cuadrada A, ¿existe una matriz P inversible tal que P −1 AP sea

diagonal?

Problema 2. Dada una matriz cuadrada A, ¿existe una matriz ortogonal P tal que P t AP sea

diagonal?

Definición 77.- Se dice que una matriz A cuadrada es diagonalizable si existe una matriz P

inversible tal que P −1 AP es diagonal. En ese caso se dice que P diagonaliza a la matriz A.

Si existe una matriz ortogonal P tal que P −1 AP es diagonal, entonces se dice que A es diagonalizable ortogonalmente y que P diagonaliza ortogonalmente a A.

Diagonalización

Supongamos que la matriz An×n es diagonalizable, es decir que existe P inversible tal que

P AP = D, con D diagonal.

−1

25

m

at

4.1 Introducción. Valores y vectores propios.

Esto es equivalente a que exista P inversible tal que AP = P D para cierta matriz D diagonal,

luego

AP = P D =

p11 p12

p21 p22

..

..

.

.

pn1 pn2

· · · p1n

λ1

· · · p2n

0

.

..

.

. ..

..

· · · pnn

0

0 ···

λ2 · · ·

.. . .

.

.

0 ···

0

0

..

.

λn

λ1 p11 λ2 p12 · · · λn p1n

=

λ1 p21 λ2 p22 · · · λn p2n

.

..

..

..

.

.

.

.

.

λ1 pn1 λ2 pn2 · · · λn pnn

Si llamamos p1 , p2 , . . . , pn a los vectores columnas de P , como las columnas de la matriz AP y las

correspondientes de la matriz P D han de coincidir, lo anterior puede escribirse de la forma

Ap1 = λ1 p1 ,

Ap2 = λ2 p2 ,

...,

Apn = λn pn ,

es decir, han de existir n vectores pi y n números reales λi tales que Api = λi pi , para los i = 1, . . . , n.

Como la matriz P es inversible, los vectores pi son distintos del 0 y linealmente independientes.

Definición 78.- Si A es una matriz cuadrada de orden n, diremos que λ es un valor propio, valor

caracterı́stico o autovalor de A si existe un p ∈ IRn , p 6= 0, tal que Ap = λp.

Del vector p diremos que es un vector propio, vector caracterı́stico o autovector de A

correspondiente al valor propio λ.

Teorema 79.- Si A es una matriz de orden n, las siguientes proposiciones son equivalentes:

a) λ es un valor propio de A.

b) El sistema de ecuaciones (A − λI)x = 0 tiene soluciones distintas de la trivial.

c) det(A − λI) = 0.

Demostración:

λ es un valor propio de A ⇐⇒ existe un vector x ∈ IRn diferente de cero, tal que Ax = λx

⇐⇒ el sistema (A − λI)x = 0 tiene soluciones distintas de la trivial. ⇐⇒ |A − λI| = 0

Al polinomio en λ, P(λ) = |A − λI|, se le denomina polinomio caracterı́stico de la matriz A,

y a la ecuación P(λ) = |A − λI| = 0 ecuación caracterı́stica de A.

Definición 80.- Sea A una matriz de orden n y λ un valor propio de A, al espacio de las soluciones

del sistema (A − λI)x = 0 se le denomina espacio caracterı́stico de A correspondiente al valor

propio λ y lo denotaremos por V (λ).

Observación:

Si λ es un valor propio de A, V (λ) = {x : (A − λI)x = 0} =

6 {0} y por tanto dim V (λ) ≥ 1.

En el estudio sobre la diagonalización realizado hasta ahora, hemos buscado la diagonalización

de matrices, separándolas del operador lineal que aparece en el planteamiento inicial del problema.

Lo que hemos encontrado hasta ahora ¿es reutilizable también para el estudio de ese operador? En

efecto:

Definición 81.- Sea f : V −→ V un operador lineal, diremos que un escalar λ es un valor propio

de f si existe un vector v ∈ V , diferente de cero, tal que f (v) = λv.

Al vector v se lo denomina vector propio de f correspondiente a λ.

Matemáticas I

26

4.1 Introducción. Valores y vectores propios.

m

at

Teorema 82.- Los vectores propios de f correspondientes al valor propio λ son los vectores, distintos

de cero, del núcleo de la aplicación f − λId (denotaremos por Id la aplicación identidad).

Demostración:

Si v un vector propio correspondiente a λ, entonces f (v) = λv =⇒ f (v) − λv = 0 =⇒ v ∈

Ker(f − λId ).

Por otra parte si v 6= 0 pertenece al Ker(f − λId ) se tiene que (f − λId )v = 0 =⇒ f (v) − λv = 0

=⇒ f (v) = λv, luego v es un vector propio de f correspondiente a λ.

Observación:

Este núcleo se denominará, espacio caracterı́stico de f correspondiente al valor propio λ.

Teorema 83.- Sean V un espacio vectorial de dimensión n, f : V −→ V un operador lineal y A la

matriz de f con respecto a una base B = {v 1 , v 2 , . . . , vn }. Entonces:

a) Los valores propios de f son los valores propios de A

b) Un vector v ∈ V es un vector propio de f correspondiente al valor propio λ si y sólo si su

matriz de coordenadas [v]B es un vector propio de A correspondiente a λ.

Demostración:

a) Sea λ un valor propio de f , es decir, ∃v ∈ V , distinto de 0, tal que f (v) = λv =⇒ [f (v)]B =

[λv]B =⇒ A[v]B = λ[v]B , luego λ es un valor propio de A al ser [v]B 6= 0.

Sea λ un valor propio de A, entonces ∃x ∈ IRn , x 6= 0 tal que Ax = λx. Si tomamos x∗ =

x1 v 1 + · · · + xn v n , siendo x = (x1 , . . . , xn ), lo anterior quiere decir que A[x∗ ]B = λ[x∗ ]B ⇒

[f (x∗ )]B = [λx∗ ]B ⇒ f (x∗ ) = λx∗ y λ es un valor propio de f ya que x∗ 6= 0

b) v es un vector propio de f correspondiente a λ si y sólo si

f (v) = λv ⇐⇒ [f (v)]B = [λv]B ⇐⇒ A[v]B = λ[v]B

si, y sólo si, [v]B es un vector propio de A correspondiente a λ.

A la vista de este resultado y siempre que trabajemos en términos de valores y vectores propios,

el problema de encontrar una base del espacio en la cual la matriz asociada al operador sea diagonal,

se reduce al estudio de la diagonalización de las matrices.

Matemáticas I

27

m

at

4.2 Diagonalización

4.2.

Diagonalización

Teorema 84.- Si A es una matriz de orden n, son equivalentes:

a) A es diagonalizable.

b) A tiene n vectores propios linealmente independientes.

Demostración:

a) ⇒ b). Lo hemos probado en los comentarios anteriores.

b) ⇒ a). Sean los n vectores p1 , p2 , . . . , pn vectores propios linealmente independientes de A

correspondientes a los valores propios λ1 , λ2 , . . . , λn . Consideremos la matriz

p11 p12

p21 p22

P =

..

..

.

.

pn1 pn2

· · · p1n

· · · p2n

..

..

. .

· · · pnn

que tiene por vectores columna los p1 , p2 , . . . , pn .

Las columnas de la matriz producto AP son Ap1 , Ap2 , . . . , Apn y los pi son vectores propios,

luego Ap1 = λ1 p1 , . . . , Apn = λn pn , por lo que:

λ1 p11 λ2 p12

λ1 p21 λ2 p22

AP =

..

..

.

.

λ1 pn1 λ2 pn2

· · · λn p1n

· · · λn p2n

..

..

.

.

· · · λn pnn

p11 p12

p21 p22

= .

..

.

.

.

pn1 pn2

· · · p1n

λ1

· · · p2n

0

.

..

.

. ..

..

· · · pnn

0

0 ···

λ2 · · ·

.. . .

.

.

0 ···

0

0

..

.

λn

= PD

donde D es la matriz diagonal que tiene como elementos en la diagonal principal a los valores propios

λ1 , λ2 , . . . , λn . Dado que los vectores columnas de P son linealmente independientes, P es inversible

y por tanto se tiene que D = P −1AP , es decir, A es diagonalizable.

Proposición 85.- Sea f : V −→ V un operador lineal, siendo V un espacio vectorial de dimensión

n. Entonces, existe una base de V con respecto a la cual la matriz de f es diagonal si, y sólo si, f

tiene n vectores propios linealmente independientes.

Teorema 86.- Sean v 1 , v 2 , . . . , v k vectores propios de una matriz A asociados a los valores propios

λ1 , λ2 , . . . , λk respectivamente, siendo λi 6= λj , ∀i, j = 1, 2, . . . , k, con i 6= j. Entonces el conjunto de

vectores {v 1 , v 2 , . . . , v k } es linealmente independiente.

Corolario 87.- Si una matriz A de orden n tiene n valores propios distintos, entonces A es diagonalizable.

Proposición 88.- Sea A una matriz de orden n y λi un valor propio de A de multiplicidad ni , si

V (λi ) es el espacio caracterı́stico correspondiente al valor propio λi . Entonces

1 ≤ dim V (λi ) ≤ ni .

Teorema 89 (fundamental de la diagonalización.).- Sea A una matriz de orden n. Entonces A

es diagonalizable si y sólo si se cumplen las condiciones:

a) Las n raı́ces de la ecuación caracterı́stica de A son todas reales. Es decir, |A − λI| = (λ1 −

λ)n1 · · · (λm − λ)nm con n1 + n2 + · · · + nm = n.

b) Si V (λi ) es el espacio caracterı́stico de A correspondiente a λi , 1 ≤ i ≤ m, y ni es la multiplicidad

de λi en la ecuación caracterı́stica de A, entonces dim V (λi ) = ni .

Matemáticas I

28

4.3 Diagonalización ortogonal.

4.3.

m

at

Diagonalización ortogonal.

Teorema 90.- Sea A una matriz de orden n, entonces son equivalentes:

a) A es diagonalizable ortogonalmente.

b) A tiene un conjunto de n vectores propios ortonormales.

Demostración:

En efecto, A es diagonalizable ortogonalmente ⇐⇒ existe P ortogonal tal que P t AP = D (con

D diagonal) ⇐⇒ existe P ortogonal tal que AP = P D.

Si llamamos p1 , p2 , . . . , pn a los vectores columnas de P , éstos vectores son ortonormales ylo

λ1 0 · · · 0

0 λ2 · · · 0

anterior es lo mismo que escribir Ap1 = λ1 p1 , . . . , Apn = λn pn , supuesto que D = .. .. . . ..

,

. .

. .

0 0 · · · λn

y como al ser P inversible se tiene que p1 , p2 , . . . , pn son linealmente independientes y por tanto no

nulos ⇐⇒ A tiene n vectores propios ortonormales.

Teorema 91.- Una matriz A de orden n es diagonalizable ortogonalmente si y sólo si A es simétrica.

Teorema 92.- Si A es una matriz simétrica, entonces los vectores propios que pertenecen a valores

propios distintos son ortogonales.

Demostración:

Sean λ1 y λ2 valores propios distintos de una matriz simétrica A y sean u y v vectores propios

correspondientes a λ1 y λ2 respectivamente.

Tenemos que probar que ut v = 0. (Notar que ut Av es un escalar).

Se tiene que

ut Av = (ut Av)t = v t Au = v t λ1 u = λ1 v t u = λ1 ut v,

y por otra parte que ut Av = ut λ2 v = λ2 ut v,

por tanto λ1 ut v = λ2 ut v ⇒ (λ1 − λ2 )ut v = 0 y como λ1 − λ2 6= 0, entonces ut v = 0.

Matemáticas I

29

Índice general

1. Matrices, Sistemas y Determinantes.

1.1. Matrices. . . . . . . . . . . . . . . . . . . . . . .

1.1.1. Definiciones básicas . . . . . . . . . . . .

1.1.2. Operaciones en las matrices . . . . . . . .

1.1.3. Matrices elementales . . . . . . . . . . . .

1.2. Lenguaje matricial de los sistemas de ecuaciones

1.2.1. Método de Gauss . . . . . . . . . . . . . .

1.2.2. Método de Gauss-Jordan . . . . . . . . .

1.3. Matriz transpuesta. Inversa de una matriz . . . .

1.3.1. Matriz transpuesta . . . . . . . . . . . . .

1.3.2. Matrices inversibles . . . . . . . . . . . .

1.3.3. Determinante de una matriz cuadrada . .

1.4. Rango de una matriz. Teorema de Rouché . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

1

1

1

1

2

3

3

5

5

5

6

7

8

2. Espacios vectoriales reales.

2.1. Espacios vectoriales. . . . . . . . . . . . . . . . . . . . . . . . . .

2.2. Subespacios vectoriales. . . . . . . . . . . . . . . . . . . . . . . .

2.3. Base y dimensión. . . . . . . . . . . . . . . . . . . . . . . . . . .

2.4. El espacio vectorial IRn . . . . . . . . . . . . . . . . . . . . . . .

2.5. Espacios de las filas y las columnas de una matriz. Coordenadas.

2.6. Cambios de base. . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.7. Espacios vectoriales con producto interior. . . . . . . . . . . . . .

2.7.1. Producto interior. Norma. Distancia . . . . . . . . . . . .

2.7.2. El espacio euclı́deo n-dimensional: IRn . . . . . . . . . . .

2.7.3. Bases ortonormales. Proceso de Gram-Schmidt . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

10

10

11

11

12

14

15

15

15

16

17

3. Aplicaciones lineales

3.1. Propiedades de las aplicaciones lineales. Núcleo e imagen.

3.2. Aplicaciones matriciales . . . . . . . . . . . . . . . . . . .

3.3. Matrices que representan aplicaciones lineales . . . . . . .

3.3.1. Aplicaciones lineales de IRn en IRm . . . . . . . . .

3.3.2. Aplicaciones lineales entre espacios cualesquiera . .

3.4. Composición de aplicaciones lineales . . . . . . . . . . . .

3.5. Teorema de Semejanza . . . . . . . . . . . . . . . . . . . .

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

19

19

20

21

21

22

23

23

4. Diagonalización

4.1. Introducción. Valores y vectores propios. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.2. Diagonalización . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3. Diagonalización ortogonal. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

25

25

28

29

.

.

.

.

.

.

.

.

.

.

.

.

30

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.

.