VERIFICACIÓN NO PARAMÉTRICA

Anuncio

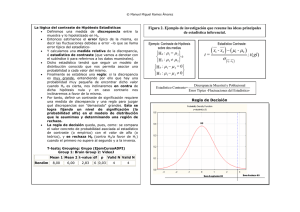

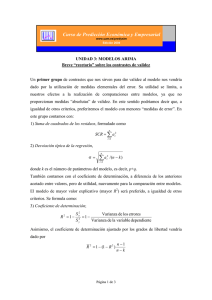

A. Morillas: Contrastes no paramétricos (I). CONTRASTES NO PARAMÉTRICOS (I) Antonio Morillas 1. Introducción 2. Contrastes de ajuste 2.1 Contraste χ2 2.2 Contraste de Kolmogorov-Smirnov 3. Contrastes específicos de normalidad 3.1 Contraste de normalidad de Lilliefors 3.2 Contraste de normalidad de Jarque y Bera (asimetría y curtosis) 3.3 Contraste de normalidad de Shapiro y Wilks 4. Contraste de independencia (asociación). Tablas de contingencia 5. Contraste de homogeneidad 1 A. Morillas: Contrastes no paramétricos (I). 1. Introducción En las lecciones precedentes se han propuesto métodos para estimar parámetros de una población o contrastar hipótesis acerca de los mismos, tomando como base la información procedente de una muestra. Se ha considerado, para ello, que los datos obtenidos en la misma se han obtenido mediante muestreo aleatorio simple, con lo que se dan por asumidas ciertas hipótesis. Entre otras, que proceden de un modelo de población perfectamente conocido en su forma, aunque no se tenga noticia acerca del valor de alguno o de todos sus parámetros. Por ejemplo, como se ha visto en lecciones anteriores, para verificar si es significativa la diferencia entre dos medias poblacionales, se utilizan dos muestras, que se suponen independientes, y se establece que la diferencia de las medias en el muestreo se distribuye normalmente. Se ha visto como, bajo estas condiciones, el estadístico muestral que debe ser utilizado para la verificación de tal hipótesis sigue una distribución t. En contraposición a este tipo de métodos, que se suelen conocer como paramétricos, se utilizan con bastante frecuencia los métodos no paramétricos, cuando algunas de estas hipótesis pueden ser puestas en cuestión. Como se comprobará más adelante, los correspondientes contrastes no paramétricos para la localización de dos poblaciones (Wilcoxon, por ejemplo) no hacen uso de estos supuestos y proponen su particular estadístico de contraste, cuya distribución se puede obtener independientemente de la forma que pueda tener la población (desconocida generalmente), por lo que suelen también llamarse métodos de libre distribución . Los contrastes no paramétricos son, frecuentemente, más potentes en caso de incumplimiento de las hipótesis enunciadas (especialmente, si no es cierta la de normalidad). Además, son los apropiados para verificar hipótesis cuando los datos con los que se trabaja proceden de características de poblaciones que sólo pueden ser medidas a escala ordinal e, incluso, nominal. Esta es, quizás, la diferencia respecto a los paramétricos que más les caracteriza. Las hipótesis más utilizadas en capítulos anteriores, a la hora de estimar parámetros o contrastar hipótesis acerca de los mismos, han sido: • las realizadas sobre el modelo de probabilidad que sigue la población de la cual proceden los datos de la muestra 2 A. Morillas: Contrastes no paramétricos (I). • la permanencia de dicho modelo, tanto en forma como en parámetros, durante la obtención de la misma • la independencia de las observaciones muestrales. Los contrastes no paramétricos, por tanto, van a cubrir este abanico de posibilidades de incumplimiento de hipótesis básicas. En especial, se ha visto en lecciones anteriores como tanto la estimación de parámetros como la verificación de hipótesis descansaban en el supuesto de normalidad. Siendo este, además, un modelo tan generalizado, no es de extrañar que uno de los primeros objetivos de los métodos no paramétricos haya sido el contraste de normalidad en la población. No obstante, su aplicación a cualquier otra hipótesis sobre la forma de la distribución de probabilidad de la población ha dado lugar a contrastes de ajuste generalizados, en los que se comparan los datos obtenidos en la muestra con los que cabría esperar que se obtuvieran si la hipótesis vertida sobre la población fuese cierta. En este mismo criterio, de comparación entre frecuencias empíricas y valores esperados, aunque con diferente fundamento teórico, se basa otra clase de contrastes no paramétricos, que analizan la información suministrada por una tabla de doble entrada, llamada tabla de contingencia, en la que se valora si los datos recogidos en fila son contingentes (dependientes) de los expresados por columna. A los primeros, con los que comenzaremos esta lección, se les suele llamar contrastes de bondad del ajuste. Dentro de los segundos, se encuentran los contrastes de independencia (asociación) y de homogeneidad. Además, posteriormente, veremos algunos contrastes de aleatoriedad y de localización para una y dos muestras. 2. Contrastes de ajuste La estimación por intervalos y el contraste de hipótesis, vistos en lecciones anteriores, se basan en la utilización de un estimador adecuado del parámetro poblacional y en la evaluación de su precisión, que, a su vez, dependen del modelo teórico que se supone sigue la población. Un contraste de ajuste tiene como objeto comprobar si con base en la información suministrada por la muestra se puede aceptar que la población de origen sigue una determinada distribución de probabilidad. Trataremos en este epígrafe los dos más generales, el basado en la χ2 3 y el de A. Morillas: Contrastes no paramétricos (I). Kolmogorov-Smirnov, y dejaremos para después algunos otros que son más específicos de normalidad. 2.1. Contraste χ2 Se trata de un contraste de bondad del ajuste aplicable tanto a variables continuas, siempre agrupadas en intervalos, como discretas. Es el contraste más antiguo y consiste en comparar las frecuencias observadas en la muestra para cada intervalo o clase del histograma, con las que se obtendrían según el modelo teórico propuesto para ser contrastado. Para ello, como se ha dicho, los datos de la muestra se agrupan en intervalos, bien porque la variable es continua o bien porque , aún siendo discreta, el tamaño de la muestra es grande, como requiere el test. En su caso, el primero y el último de los intervalos se dejarán abiertos, con objeto de abarcar todo el recorrido de la variable. Tabla 2.1.1: Contraste χ2 de Pearson Menos de L1 Frecuencias observadas ni n1 Probabilidad pi /H0 p1 Probabilidad de ni P(ni) P(n1) = p1n1 Frecuencias esperadas ei e1 = np1 Valor del estadístico (ni-ei)2 / ei (n1-e1)2 / e1 L1 – L 2 n2 p2 P(n2) = p2n2 e2 = np2 (n2-e2)2 / e2 .. .. .. .. .. .. ei = npi (ni-ei)2 / ei Intervalos P(ni) = pini Li-1 – Li ni pi .. .. .. .. .. .. Lk-1 y más nk pn P(nk) = pknk ek = npk (nk-ek)2 / ek ∑ni = n ∑ pi = 1 χ2obs. La hipótesis de partida es que los datos x1, x2, ..., xn de una variable X, observados en una muestra de tamaño n, que ha de ser suficientemente grande (n > 25), proceden de una característica de la población que sigue un modelo probabilístico determinado. Si, por ejemplo, Ho: f(x) = fo(x) , la probabilidad de obtener una observación en el intervalo i-ésimo, cuando la población tiene la función de densidad fo(x), vendría dada por la expresión pi / H 0 = Li ∫f 0 ( x)dx (en adelante, pi). El número, ni , de observaciones Li −1 contabilizadas en la muestra para cada intervalo, son las frecuencias absolutas reflejadas en la segunda columna de la Tabla 2.1.1 . Si la hipótesis nula planteada acerca del modelo poblacional del que procede la muestra fuese cierta, estas frecuencias observadas y los valores esperados de las mismas, según dicho modelo, deberían estar 4 A. Morillas: Contrastes no paramétricos (I). suficientemente próximos. El problema radica, por tanto, en encontrar el estadístico adecuado para evaluar la discrepancia entre valores observados y valores teóricos de las frecuencias. Veamos como se puede conseguir. Si se supone que la muestra se ha obtenido aleatoriamente, de tal forma que sus observaciones, x1, x2, ..., xn, puedan ser consideradas variables aleatorias independientes, la probabilidad de obtener exactamente ni observaciones en el intervalo i-ésimo se obtendría multiplicando ni veces la de obtener una observación (pi). Por tanto, como se recoge en la columna cuatro de la Tabla 2.2.1, se deduce que P(ni) = pini , para i=1,...,k , serían las probabilidades de obtener exactamente n1, n2 ,..., nk observaciones en los correspondientes intervalos. En muestras sucesivas, el número de observaciones pertenecientes a cada intervalo constituye una variable aleatoria. El experimento consistente en obtener n1 observaciones en la clase 1, n2 observaciones en la clase 2, ... , y nk observaciones en la clase k, siendo p1 , p2 , ... , pk las probabilidades de cada uno de los k resultados posibles, sigue un modelo de probabilidad multinomial, que da la probabilidad de obtener una muestra con una distribución de frecuencias determinada para las k categorías contempladas. Es decir, la hipótesis nula podría ser formulada como sigue: H0 : pi = pi0 , i= 1, 2, …,k La distribución marginal del estadístico ni , número de observaciones (éxitos) obtenidas en la clase i-ésima al tomar una muestra de tamaño n (repetición de n pruebas independientes, con probabilidad constante de éxito igual a pi), sigue una distribución binomial de parámetros n y pi (recuérdese que las distribuciones marginales de una multinomial son todas binomiales): ni ∼ B(n , pi ) El valor esperado de ni , por tanto, vendrá dado por E(ni) = ei = n . pi , tal como se refleja en la penúltima columna de la Tabla 2.2.1. Considerando n suficientemente grande y pi muy pequeño, lo que hará conveniente que se defina un número importante de intervalos, puede aproximarse la distribución de ni mediante una distribución de Poisson, ni ∼ P(λ = n . pi ), y a esta, a su vez, siempre 5 A. Morillas: Contrastes no paramétricos (I). que, λ = E(ni) = n . pi ≥ 5, es posible aproximarle una distribución normal, ya que, como se vio en su momento1: ni − npi npi ∼ N (0,1) Si elevamos al cuadrado esta expresión, y sumamos para los k intervalos, se obtendría una suma de k variables normales tipificadas elevadas al cuadrado que da como resultado una distribución χ2 , con tantos grados de libertad como variables aleatorias independientes intervienen en la suma; es decir, k-1, ya que, como es evidente, k ∑n i =1 i = n , y basta con conocer las frecuencias de k-1 intervalos para determinar la del restante. En definitiva, el estadístico adecuado, si fuese cierta la hipótesis nula, para evaluar la significación estadística de la discrepancia será: 2 (ni − ei ) 2 ∼ χ , con ei = npi 0 ∑ −1 k ei i =1 k La región crítica para el contraste (rechazo de la hipótesis sobre el modelo propuesto) estará situada en la cola de la derecha, para valores grandes del estadístico, indicando que cuanto mayor sea la discrepancia entre ni y ei , más razones tendremos para rechazar H0. Para valores pequeños de esta expresión, se concluirá que no hay evidencia estadística suficiente para rechazar que la muestra proviene del modelo enunciado en la hipótesis nula. El procedimiento a seguir para desarrollar el contraste coincide con la tabla 2.2.1 (excepto la columna 4): 1. Se comenzará tabulando las observaciones de la muestra en clases o intervalos (k≥5), que han de ser exhaustivas (de aquí que a veces sea necesario trabajar con intervalos abiertos) y mutuamente excluyentes. El número de clases, lógicamente, conviene que sea lo mayor posible, y puede venir determinado por la experiencia o por investigaciones anteriores. Es preciso, como se ha dicho anteriormente, que el valor esperado de la frecuencia, ei , en todas las clases sea mayor o igual a 5. Si este requisito no se cumple, es necesario agrupar las clases afectadas para conseguir que la aproximación sea válida. 1 La acción conjunta de ambas condiciones, pi pequeña y ei ≥ 5, obliga a un tamaño muestral grande. 6 A. Morillas: Contrastes no paramétricos (I). 2. Una vez tabulada la muestra, se calcula la probabilidad que el modelo propuesto otorga a cada uno de los intervalos (pi0), y, a partir de ella, se obtienen los correspondientes valores esperados de las frecuencias absolutas (ei = n . pi0). 3. Por último, se efectúan los cálculos de la última columna de la tabla 2.2.1, que arrojan, como suma de la misma, el resultado del valor observado (χ2obs.) para la variable χ2 que mide la discrepancia. Si este valor supera el punto crítico (percentil) determinado por el nivel de significación α en la distribución χ 2 k −1 , se rechazará que el modelo poblacional es el propuesto en la hipótesis nula. Es conveniente, en todo caso, valorar por separado la contribución de cada intervalo a este resultado del contraste, ya que es posible que el valor alto observado venga provocado por la magnitud de la diferencia en un intervalo concreto, que pueda venir producida por algún error en los datos. Además, el detalle de las diferencias en cada intervalo puede sernos de utilidad para plantear un modelo alternativo como hipótesis nula. Normalmente, no se conoce la forma de la población, pero en el contraste se supone que la hipótesis nula es cierta. No ocurre así con sus parámetros que no suelen conocerse ni quedan especificados en dicha hipótesis sobre la forma de la distribución. En tal caso, no se podrían calcular las frecuencias esperadas al no poder obtener las probabilidades para cada intervalo y no sería posible aplicar el contraste. Sin embargo, puede demostrarse que, siempre que estimemos por máxima verosimilitud dichos parámetros a partir de los datos muestrales, el contraste sigue siendo válido sin más que corregir los grados de libertad, disminuyéndolos con el número de parámetros estimados. Es decir, si desconocemos r parámetros de la población, y son estimados por máxima verosimilitud, el estadístico adecuado será el siguiente: (ni − npi ) 2 2 ∼ χ k −r −1 ∑ npi i =1 k Finalmente, hay que subrayar el hecho de que el contraste es asintótico y, por tanto, resulta muy sensible al tamaño de la muestra, hasta el punto de que, si no está muy bien especificada la hipótesis nula, con gran proximidad a la verdadera distribución, es bastante seguro que la rechazaremos cuando n sea muy grande. De 7 A. Morillas: Contrastes no paramétricos (I). hecho, puede demostrarse que la potencia del contraste tiende a 1 cuando n tiende a ∞. Esta circunstancia del contraste puede comprobarse fácilmente, sin más que multiplicar el tamaño muestral por una constante, c>1. En tal caso, se tiene que el valor observado del contraste para el nuevo tamaño muestral, c.n , será: χ 2 obs.( c .n ) k =∑ i =1 2 (cni − cnpi ) 2 =cχ obs. cnpi y se tenderá a rechazar la hipótesis nula con el aumento del tamaño de la muestra. Conviene tener presente al respecto la diferencia entre discrepancia estadística y discrepancia real a la que hicimos alusión en los temas anteriores. 8 A. Morillas: Contrastes no paramétricos (I). 2.2. Contraste de Kolmogorov-Smirnov. Se ha visto que para poder aplicar el contraste χ2 a variables continuas es preciso agrupar los datos observados en intervalos. Por otro lado, dada la aproximación asintótica que se hace a una normal, es requisito imprescindible que el tamaño muestral sea lo suficientemente grande como para que, junto con la condición de pi pequeña se cumpla que n . pi ≥ 5, en todos y cada uno de los intervalos. Esto quiere decir que n ha de ser relativamente grande y que sería necesario un número de clases de agrupamiento mínimamente razonable. Y esto, a su vez, como se acaba de comentar, hace que este contraste asintótico tienda a rechazar la hipótesis nula si su especificación no es muy buena. El contraste que se expone a continuación trata de solventar estas limitaciones, no siendo necesario, para su aplicación, el agrupamiento de las observaciones muestrales en clases, y se puede aplicar a muestras de pequeño tamaño. Eso sí, a diferencia del anterior, sólo es válido para variables de tipo continuo. Su método consiste en comparar la distribución acumulada de frecuencias de la muestra, Fn(x), con la función de distribución, o probabilidad acumulada, que habría si fuera cierto el modelo de la población que se propone como hipótesis nula, F0(x). Es preciso subrayar que esta hipótesis debe estar perfectamente especificada, no sólo en su forma sino, también, en sus parámetros. De no ser así, la necesaria estimación de los mismos a partir de la muestra, hace que tienda a aceptarse siempre la hipótesis propuesta. Este es, probablemente, el mayor inconveniente de este contraste, que, por cierto, también puede ser utilizado para detectar si hay evidencia empírica de que dos muestras observadas provienen de una misma población. Obsevaciones Ordenadas x(i) x(1) x(2) .. x(i) .. x(n) Tabla 2.2.1 Contraste de Kolmogorov-Smirnov Frecuencias Frecuencias Probabilidad Distancia desde Distancia desde absolutas relativas acumulada Fn(x(i-1)) Fn(x(i)) D1(x(i)) D2(x(i)) acumuladas acumuladas según Ni Fn(x(i))=Ni / n F0(x(i)) N1 Fn(x(1)) F0(x(1)) D1(x(1)) D2(x(1)) N2 Fn(x(2)) F0(x(2)) D1(x(2)) D2(x(2)) .. .. .. .. .. Ni Fn(x(i)) F0(x(i)) D1(x(i)) D2(x(i)) .. .. .. .. .. Nn Fn(x(n)) F0(x(n)) D1(x(n)) D2(x(n)) El proceso para llevar a cabo el contraste puede esquematizarse como sigue (véase Tabla 2.2.1 y Gráfico 2.2.1): 9 A. Morillas: Contrastes no paramétricos (I). 1. Se establece la hipótesis nula, acerca de que la muestra observada proviene de una variable continua, representativa de una característica de la población, cuyo modelo de probabilidad tiene como función de distribución a F0(x). Es decir, H0 : F(x)= F0(x). 2. Se procede a la ordenación, de menor a mayor, de los valores observados en la muestra: x(1) ≤ x(2) ≤ ...,≤ x(i) ≤,...,≤ x(n) . 3. Se obtiene la distribución acumulada de frecuencias relativas, Fn(x(i)) (función de distribución empírica de la muestra). 4. Se obtiene la probabilidad acumulada correspondiente, según el modelo propuesto, F0(x(i)). 5. Para cada x(i), se obtiene la discrepancia entre la distribución empírica y la teórica. Al tratarse, la primera de ellas, de un diagrama en escalera, la distancia entre éste y la distribución teórica puede medirse a partir de la ordenada Fn(x(i-1)) o de la Fn(x(i)) (véase Gráfico 2.2.1). Puede observarse que, para medir tal discrepancia en cada valor muestral, se dispone de dos referencias (ordenadas de la distribución empírica) o distancias distintas. En este ejemplo, la existente entre la curva teórica y la frecuencia acumulada hasta la observación x(i-1) , segmento situado por debajo de F0(x), dada por |Fn(x(i-1))- F0(x(i))|= D1(x(i)) , y la que hay entre la frecuencia acumulada hasta x(i) y la función teórica, segmento situado por encima de esta última, dada por |Fn(x(i))- F0(x(i))|= D2(x(i)). 6. Por último, de entre todas estas distancias, se elige la mayor de ellas, como indicador de la máxima discrepancia observada entre los datos muestrales y el modelo propuesto: Dn=maxD1(x(i))∪ D2(x(i)) , para i=1,2,...,n. Para cada muestra, Dn podrá tomar valores distintos, y su distribución de probabilidad, que puede demostrarse es independiente del modelo propuesto en la hipótesis nula, sólo depende del tamaño de la muestra. La distribución de este estadístico muestral, cuando F0(x) es cierta, está tabulada, por lo que fijado un nivel de significación, α , si la distancia observada, Dobs., es mayor que la dada por la tabla, Dn , no se tendrá evidencia muestral suficiente para aceptar como válido el modelo. 10 A. Morillas: Contrastes no paramétricos (I). Fn(x(n))=1 Fn(x(i)) F0(x) D2(xi) F0(xi) D1(xi) Fn(x(i-1)) Fn(x(2)) Fn(x(1)) x(1) x(2) ......... x(i-1) x(i) ................ Gráfico 2.2.1: Contraste de Kolmogorov-Smirnov 11 x(n) A. Morillas: Contrastes no paramétricos (I). 3. Contrastes específicos de normalidad La idea de que la normalidad es algo muy frecuente en el comportamiento de una población, junto a su trascendencia para muchos desarrollos teóricos, hace que su contraste tenga gran interés. No es extraño, pues, que hayan surgido métodos destinados específicamente a comprobar esta hipótesis. Es evidente que el contraste χ2 puede ser empleado para este fin, pero siempre que se disponga de una muestra grande. Esto no es necesario para el contraste que se acaba de ver, pero, sin embargo, como se ha dicho, el contraste de Kolmogorov-Smirnov precisa de una completa especificación de los parámetros poblacionales, pues, en caso contrario, conduce a resultados muy conservadores. Vamos a ver, a continuación, una serie de contrastes, dirigidos específicamente a probar la hipótesis de normalidad, por lo que suelen llamarse generalmente contrastes de normalidad. Hay que decir que no hay uno que sea preferible a los demás, ya que depende del tamaño de la muestra y de la verdadera forma de la distribución de la población. 3.1. Contraste de normalidad de Lilliefors Para el caso del contraste de normalidad, Lilliefors tabuló de nuevo el estadístico Dn , cuando µ y σ2 son estimados a partir de la muestra, mediante x y sˆ 2 , media y cuasivarianza muestrales, respectivamente. El desarrollo del contraste es exactamente igual que el anterior, aunque la tabla utilizada para la obtención de los valores críticos de Dn es diferente. Hay que decir que su potencia para un tamaño muestral no muy grande es baja, llegándose a demostrar que se necesitan 100 observaciones para distinguir entre una N(0,1) de una distribución uniforme entre -31/2 y 31/2. 12 A. Morillas: Contrastes no paramétricos (I). 3.2 Contraste de normalidad de Jarque y Bera (asimetría y curtosis). Se trata de un contraste específico de normalidad, basado en el análisis de las medidas de forma de una distribución: la asimetría y la curtosis o apuntamiento. Se necesita una muestra grande y suele aplicarse cuando se sospecha que hay desviaciones de la normalidad en cierta dirección. El estadístico muestral de asimetría es n α1 = ∑ (x i =1 i − x)3 ns 3 , y si la hipótesis de normalidad es cierta, se sabe que E(α1)=0 . Para muestras grandes (n≥50), se demuestra que α1 ∼ N(µ=0,σ2≅ 6/n), lo que permite verificar la consistencia de la hipótesis de simetría con la evidencia que arrojan los datos obtenidos en la muestra. Por otro lado, el apuntamiento o curtosis en muestras de n tamaño n, vendrá dado por la expresión α 2 = ∑ (x i =1 i − x)4 ns 4 . Se puede comprobar, asimismo, que este estadístico, para n≥200, sigue una distribución asintóticamente normal, con E(α2)=3, el apuntamiento de una curva normal, y Var(α2)≅ 24/n . Es posible, por tanto, verificar hipótesis acerca de si el apuntamiento en la población es el de una curva normal. Finalmente, si se combinan ambos estadísticos, puesto que se trata de la suma de los cuadrados de dos variables normales tipificadas, se tiene, como ya se sabe, que 2 2 2 2 2 α1 − 0 α 2 − 3 n 2 (α − 3) ∼ . + ∼ χ , o lo que es igual α 1 + 2 χ 2 2 6 4 6 / n 24 / n Valores de α1 y α2 próximos a cero y a tres, respectivamente, harían que χ2obs. fuese próxima a cero, lo que invitaría a aceptar la hipótesis de normalidad. Por el contrario, valores altos del estadístico en la muestra observada, conducirían a rechazar dicha hipótesis, dada la falta de consistencia entre la observación empírica y el modelo propuesto como hipótesis nula. 3.3. Contraste de normalidad de Shapiro y Wilks A diferencia de los dos anteriores, es un contraste adecuado para muestras pequeñas (n<30). Se basa en el estudio del ajuste de los datos observados en la muestra a una recta dibujada en papel probabilístico normal. Si la hipótesis nula, de normalidad 13 A. Morillas: Contrastes no paramétricos (I). en la población, es cierta, entonces se puede afirmar que los valores muestrales provienen de una distribución N(µ,σ2), y sus correspondientes valores tipificados y ordenados, serían una muestra ordenada procedente de una N(0,1): x(1) − µ σ ≤ x( 2 ) − µ σ ≤ ... x( i ) − µ σ ≤ ... ≤ x( n ) − µ σ El valor esperado del término que ocupa el lugar i-ésimo (cuantil), en esta x −µ = c( i ),n , por lo que, de ser cierta la hipótesis de muestra de tamaño n será E ( i ) σ normalidad, los valores esperados en la muestra deberían estar próximos a la recta que se deduce de esta igualdad: E ( x(i ) ) = µ + σ .c( i ),n Quiere esto decir que, si representamos gráficamente la recta anterior (diagrama probabilístico normal), las observaciones muestrales deberían situarse junto a la misma, si realmente la hipótesis nula es correcta. Como puede observarse, la ordenada en el origen viene estimada por µ y su pendiente por σ. Este tipo de representación constituye, por si mismo, un método gráfico de evaluación de la normalidad de los datos y suelen llamarse diagramas o gráficos Q-Q, en los que los cuantiles de la muestra se representan en relación a sus valores esperados en una distribución normal. Los valores observados, que suelen ser previamente estandarizados, aunque no es imprescindible, se colocan en el eje de abscisas y los esperados, según la distribución normal tipificada, se toman en el eje de ordenadas. Este gráfico debería dar lugar a una línea recta y estar comprendidos en el intervalo (-3,+3), si los datos proceden de una población distribuida normalmente. Una nube de puntos próxima a una línea recta, hará plausible la hipótesis de normalidad. Por el contrario, cualquier desviación de esta pauta de comportamiento 3.5 3.5 2.5 2.5 1.5 1.5 RESIDUOS ESPERADOS RESIDUOS ESPERADOS indicará una desviación de la hipótesis de normalidad. 0.5 -0.5 -1.5 -1.5 -2.5 -2.5 -3.5 -3.5 0.5 -0.5 -2.5 -1.5 -0.5 0.5 1.5 2.5 3.5 -3.5 -3.5 -2.5 -1.5 -0.5 0.5 1.5 2.5 3.5 RESIDUOS OBSERVADOS RESIDUOS OBSERVADOS Gráfico 3.3.1: Prueba de normalidad El gráfico 3.3.1 recoge dos casos bien distintos sobre la hipótesis de normalidad de los residuos en un modelo estadístico. En el primero de ellos, la hipótesis es aceptable; en el 14 A. Morillas: Contrastes no paramétricos (I). segundo, además de que puede observarse un comportamiento no aleatorio de los residuos, su alejamiento de la recta, indicaría una desviación de la normalidad. El contraste de Shapiro-Wilk, trata de cuantificar la bondad de tal ajuste utilizando el cuadrado del coeficiente de correlación lineal (coeficiente de determinación) entre x(i) y c(i),n . Si la hipótesis de normalidad es cierta, la correlación debe ser muy fuerte. En caso contrario, habría que rechazar tal hipótesis. Dada la simetría de la normal, los autores, para simplificar el cálculo de r2, cuya distribución muestral llaman ω , proponen la siguiente forma para la misma: 2 |c | A2 1 q w = 2 ∑ a( j ),n (x( n− j +1) − x( j ) ) = 2 , con a( j ),n = q ( j ),n ns j =1 ns ∑ c 2 ( j ),n j =1 siendo q=n/2 , si n es par, y q=(n-1)/2 , si n es impar. Los valores de los a(j),n y del estadístico w están tabulados. La hipótesis de normalidad será rechazada cuando el valor wobs., observado en la muestra, sea menor que el valor crítico dado en la tabla, puesto que no hemos de olvidar que se está midiendo la bondad del ajuste a la recta y no la discrepancia con la hipótesis nula de normalidad. 15 A. Morillas: Contrastes no paramétricos (I). 4. Contraste de independencia (asociación). Tablas de contingencia Es relativamente frecuente encontrarse con información referida a la observación de dos características de una población, en las que se establecen modalidades o categorías, mediante las cuales se clasifican los individuos o elementos que constituyen una muestra de la misma. Este tipo de distribución bidimensional de frecuencias suele presentarse en forma de tabla de doble entrada, también llamada tabla de contingencia. Estas tablas permiten analizar si existe asociación o dependencia entre las frecuencias observadas por fila y columna y, en definitiva, si las dos variables inmersas en la clasificación son independientes, aún sin conocer cuales son sus correspondientes funciones de probabilidad. Nos ceñiremos al estudio de tablas de contingencia con sólo 1 2 .. i .. r Total característica A Categorías de la dos criterios (variables) de clasificación, tal y como la reflejada en la Tabla 4.1. Tabla 4.1 Categorías de la característica B 2 .. j .. n1j n12 .. .. n2j n22 .. .. .. .. .. .. nij ni2 .. .. .. .. .. .. nr2 .. nrj .. n.2 .. n.j .. 1 n11 n21 .. ni1 .. nr1 n.1 s n1s n2s .. nis .. nrs n.s Total n1. n2. .. ni. .. nr. n Como se recordará, el cuerpo central de la tabla define la distribución conjunta de frecuencias de las características A y B, mientras que la fila y columna de totales definen, respectivamente, sus correspondientes distribuciones marginales. También se sabe que: r s r s i =1 j =1 ∑∑ nij = ∑ ni. = ∑ n. j = n i =1 j =1 Supongamos que pij es la probabilidad de que un sujeto extraído al azar de la población pertenezca a la categoría (i,j) de la tabla anterior. Sean pi. y p.j las probabilidades marginales de que se encuentre en la categoría i-ésima de A y en la categoría j-ésima de B, respectivamente. Siempre que ambas categorías sean independientes, la probabilidad conjunta ha de ser igual al producto de las marginales. Por tanto, si postulamos como hipótesis a contrastar la independencia entre las dos variables, podremos escribirla como sigue: H0: pij = pi. . p.j , i=1,2,...,r ; j=1,2,...,s 16 A. Morillas: Contrastes no paramétricos (I). Por otro lado, aplicando el criterio del contraste χ2 de bondad del ajuste, discrepancia entre frecuencias observadas y frecuencias esperadas, para las r . s casillas de la tabla, se puede escribir que: r s ∑∑ (nij − eij ) 2 eij i =1 j =1 ∼χ 2 rs −1 , con eij = n.pij Pero, si la hipótesis de independencia es cierta, se tiene que pij = pi. . p.j , por lo que la expresión anterior, para n suficientemente grande, queda como sigue: r s ∑∑ i =1 j =1 (nij − npi. p. j ) 2 npi. p. j ∼χ 2 rs −1 Para realizar el contraste, por tanto, es preciso conocer las funciones de probabilidad de las variables A y B. Sin embargo, esto no es lo más frecuente, por lo que se habrán de estimar a partir de las observaciones muestrales. Se puede demostrar que los estimadores máximo verosímiles de pi. y p.j son, respectivamente, ni. /n y n.j /n, por lo que sustituyendo estas frecuencias relativas, obtenidas de la tabla, se mantiene la forma de la distribución del estadístico, si bien habrá que corregir los grados de libertad, restando el número de parámetros estimados. Dado que Σ pi.= Σ p.j =1, habrá que estimar (r-1) parámetros de la característica A y (s-1) de la B. Por consiguiente, cuando no se conocen las probabilidades teóricas y se estiman con las frecuencias relativas de la muestra, habrá que restar (r-1) + (s-1) grados de libertad a los (rs-1) anteriores, y el contraste queda como sigue: 2 nn nij − i. . j r s 2 n ∼χ ∑∑ ( r −1)( s −1) ni. n. j i =1 j =1 n Si el valor muestral del estadístico es muy grande, cabe pensar que hay mucha discrepancia entre las frecuencias de la distribución conjunta y las obtenidas a través del producto de las distribuciones marginales, por lo que no hay evidencia de que las variables sean independientes. Por el contrario, valores pequeños querrían decir que no hay evidencia empírica suficiente para rechazar la hipótesis de independencia. 17 A. Morillas: Contrastes no paramétricos (I). 5. Contraste de homogeneidad. En ocasiones ocurre que tenemos a varias poblaciones clasificadas de acuerdo con las categorías definidas para una determinada variable. La pregunta que se sugiere inmediatamente es si la proporción de individuos pertenecientes a cada una de las clases es la misma en todas las poblaciones. Si, con la información suministrada por las muestras obtenidas, se puede aceptar que esto es así, diremos que las poblaciones son homogéneas con respecto a la variable de clasificación utilizada. Dicho de otra forma, si tomamos un determinado número de muestras (realizamos un determinado número de experimentos), podremos afirmar que hay evidencia estadística de que todas las muestras provienen de la misma población (son resultados independientes de un mismo experimento aleatorio). Como puede comprobarse, conceptualmente es algo bien distinto al contraste de independencia, aunque, como se verá, su aplicación se desarrolle en forma parecida (véase Tabla 5.1). La hipótesis a contrastar será, ahora, si las característica A Categorías de la poblaciones son homogéneas respecto a la variable o característica de clasificación. 1 2 .. i .. r Total 1 n11 n21 .. ni1 .. nr1 n.1 2 n12 n22 .. ni2 .. nr2 n.2 Tabla 5.1 Muestras o experimentos .. j n1j .. n2j .. .. .. nij .. .. .. .. nrj .. n.j .. .. .. .. .. .. .. .. s n1s n2s .. nis .. nrs n.s Total n1. n2. .. ni. .. nr. n Supongamos, por ejemplo, que se tienen s muestras o experimentos (columnas de la tabla) sobre la característica A, clasificada en r categorías exhaustivas y mutuamente excluyentes (filas de la tabla), que representan los resultados posibles del experimento. Ahora, el valor de n.j representa el tamaño de la muestra j-ésima; el de ni. , el número total de resultados favorables a la categoría i-ésima obtenido en el conjunto de los s experimentos; y, finalmente, nij será el número de observaciones de la categoría i-ésima obtenidas en el experimento j-ésimo. Cada muestra puede ser considerada como un experimento multinomial, con r resultados posibles. La hipótesis nula es que la probabilidad de éxito (obtener una observación) para cada categoría es la misma en todas las muestras. Es decir, la distribución de probabilidad de la población es siempre la misma; no cambia muestra a muestra. Por tanto, la formalización de esta hipótesis se puede escribir como sigue: 18 A. Morillas: Contrastes no paramétricos (I). H0 : pi1 = pi2 = ... = pij = ... = pis = pi. , ∀ i =1,2,...,r El contraste de esta hipótesis compuesta no es nada fácil, pero puede demostrarse que la χ2 asintótica (-2 log λ) que debe aproximarse en el correspondiente contraste de la razón de verosimilitudes, coincide con la del contraste de independencia. Por tanto, basándonos en la discrepancia entre las frecuencias observadas y las esperadas para cada categoría, según la hipótesis nula de homogeneidad, podemos aplicar dicho contraste. Como en el caso anterior, los estimadores máximo verosímiles de las probabilidades de cada categoría, pi. , pude demostrarse que son las correspondientes frecuencias relativas, ni./n , con que se presentan en el conjunto de las s muestras (versiones independientes del mismo experimento, si la hipótesis nula es cierta). Por tanto, el valor esperado para la frecuencia de la categoría i-ésima en la muestra j-ésima vendrá dado por la siguiente expresión: eij = E(nij) = n.j . (ni./n). Y el estadístico adecuado para realizar el contraste será: nn nij − i. . j 2 r s (n − e ) r s n ij ij = ∑∑ ∑∑ ni. n. j eij i =1 j =1 i =1 j =1 2 ∼ 2 χ ( r −1)( s −1) n Valores de este estadístico superiores al punto crítico del contraste, para el nivel de significación dado, conducirán al rechazo de la hipótesis de homogeneidad: las muestras no provienen de la misma población (no son versiones independientes de un mismo experimento). 19