Variables aleatorias continuas, TCL y Esperanza Condicional

Anuncio

Variables aleatorias continuas, TCL y

Esperanza Condicional

FaMAF

20 de marzo, 2012

1 / 37

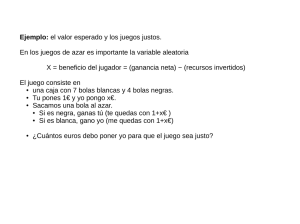

Poisson P(λ)

Número de éxitos en una cantidad grande de ensayos

independientes

I

Rango: {0, 1, 2, . . . } = {0} ∪ N

I

Función de masa:

P(X = k ) = e−λ

I

λk

.

k!

Valor esperado:

E[X ] = λ.

I

Varianza:

Var(X ) = λ.

I

Fórmula recursiva:

pk +1 =

λ

pk .

k +1

2 / 37

Poisson

0.4

0.35

λ=1

λ=2

0.3

1

0.3

0.25

0.2

0.9

0.2

0.15

0.8

0.1

0.1

0.7

0.05

0

0

5

10

15

0

0

5

10

15

0.6

0.5

0.2

0.2

λ=5

0.4

λ=7

0.15

0.15

0.1

0.1

0.05

0.05

0.3

0.2

0.1

0

0

0

5

10

15

0

0

5

10

0

5

10

15

15

3 / 37

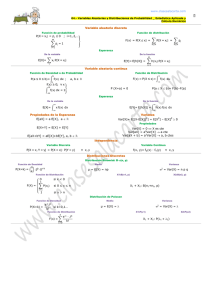

Variables aleatorias continuas

Definición

Una variable aleatoria X se dice (absolutamente continua) si existe

f : R 7→ R con f ≥ 0, tal que

Z

P(X ∈ C) =

f (x) dx.

C

Ejemplos:

I

Uniforme: X ∼ U(a, b)

I

Normal: X ∼ N (µ, σ)

I

Exponencial: X ∼ E(λ).

I

Otras: " distribuciones derivadas de la normal": χ2 , t-Student.

I

Otras: Gamma, Beta, Weibull, Cauchy, Laplacian, etc.

4 / 37

Distribución uniforme

Definición

X se dice uniformemente distribuida en (a, b) si su función de

densidad está dada por

(

1

a<x <b

1

f (x) =

I(a,b) (x) = b−a

b−a

0

c.c.

I

Función de distribución acumulada:

x ≤a

0

F (x) = x−a

a<x <b

b−a

1

x ≥b

I

E[X ] =

I

a+b

.

2

1

Var (X ) =

(b − a)2 .

12

5 / 37

Gráficos

1

f (x) = I(3,5) (x)

2

F (x) =

0

x−3

2

1

x ≤3

3<x <5

x ≥5

6 / 37

Distribución exponencial

Definición

Una v.a. X con función de densidad dada por

fλ (x) = λ e−λx ,

x > 0,

para cierto λ > 0 se dice una v.a. exponencial con parámetro λ.

1

λ

I

E[X ] =

I

Var(X ) =

1

λ2

7 / 37

Función de densidad

1

0.9

0.8

0.7

0.6

0.5

0.4

0.3

0.2

0.1

0

0

5

10

15

20

25

8 / 37

Propiedades

I

Una variable aleatoria con distribución exponencial tiene falta de

memoria.

P(X > s + t | X > s) = P(X > t).

I

Son las únicas v.a. continuas con falta de memoria.

I

El análogo en el caso discreto son las v.a. geométricas.

I

Si X ∼ E(λ), entonces c X ∼ E( 1c λ).

9 / 37

Mínimo de exponenciales

Sean X1 , X2 , . . . , Xn son v.a. independientes con f.d.a. F1 , F2 , . . . ,

Fn , y sea

M = min {X1 , X2 , . . . , Xn } .

1≤i≤n

Entonces

1 − FM (x) = P(M > x) = (1 − F1 (x)) · (1 − F2 (x)) · · · (1 − Fn (x)).

Si Xi ∼ E(λi ), entonces

P

1 − FX (x) = e−λ1 x · e−λ2 x . . . e−λn x = e−(

i

λi ) x

.

M ∼ E(λ1 + λ2 + · · · + λn ).

10 / 37

Distribución Normal

Definición

La v.a. X se dice normalmente distribuida con media µ y varianza σ 2

si su función de densidad de probabilidad está dada por

f (x) = √

1

2πσ

e−(x−µ)

2

/2σ 2

,

x ∈ R.

I

µ ∈ R, σ > 0.

I

Notación: X ∼ N(µ, σ).

I

Distribución normal estándar: Z ∼ N(0, 1).

2

1

fZ (x) = √ e−x /2 ,

2π

x ∈ R.

11 / 37

Variando µ

I

Máximo: x = µ

I

Valor Máximo: √

I

I

1

2πσ

1

√

' 0.398

2π

1

√

' 0.2

2π 2

12 / 37

Variando σ

13 / 37

La desviación estándar

I

P(|X − µ| < σ) ' 68%

I

P(|X − µ| < 2σ) ' 95%

I

P(|X − µ| < 3σ) ' 99.7%

14 / 37

Distribución Normal estándar

1

Φ(x) = P(Z ≤ x) = √

2π

Z

x

e−t

2

/2

dt.

−∞

I

No existe una fórmula cerrada para Φ(x).

I

Si X ∼ N(µ, σ), entonces

aX + b ∼ N(aµ + b, |a|σ).

I

I

X −µ

∼ Z = N(0, 1).

σ

Si X ∼ N(µ, σ),

P(X ≤ x) = Φ

X −µ

σ

.

15 / 37

La función Φ(x)

P(X ≤ 2) = P(Z ≤ 1) = Φ(1).

16 / 37

Valores de Φ(x)

I

Para α ∈ (0, 1), zα es el número real tal que

P(Z > zα ) = α.

I

Los valores de Φ(z) están tabulados:

Φ(zα ) = P(Z ≤ α) = 1 − α

I

Φ(−z) = 1 − Φ(z), por lo tanto es suficiente tabular para z ≥ 0, o

z ≤ 0.

17 / 37

Tabla de Φ(z)

Z ∼ N(0, 1)

P(Z ≤ 1.51) = 0.93448

z

0

..

.

1.5

..

.

0.00

0.5

0.01

0.50399

0.02

0.50398

0.03

0.51197

0.93319

0.93448

0.93574

0.93699

18 / 37

Valores usuales de zα

I

α = 0.05

I

zα = 1.64

P(−1.64 ≤ Z ≤ 1.64) = 0.90

19 / 37

Valores usuales de zα

I

α = 0.025

I

zα = 1.96

P(−1.96 ≤ Z ≤ 1.96) = 0.95

20 / 37

Valores frecuentes de zα

I

α = 0.01

I

zα = 2.33

P(−2.33 ≤ Z ≤ 2.33) = 0.98

21 / 37

Desigualdad de Chebyshev

Lema (Desigualdad de Markov)

Si X toma sólo valores no negativos y a > 0, entonces

P(X ≥ a) ≤

E[X ]

.

a

Teorema (Desigualdad de Chebyshev)

Si X es v.a. con media µ y varianza σ 2 , entonces para k > 0

P(|X − µ| ≥ k σ) ≤

1

.

k2

22 / 37

Leyes de los grandes números

Si X1 , X2 , . . . , Xn , . . . son v.a. independientes e idénticamente

distribuidas, con media µ:

I

I

Ley débil de los grandes números:

X1 + X2 + · · · + Xn

− µ > → 0

P n

n → ∞.

Ley fuerte de los grandes números:

Con probabilidad 1 se cumple que:

lim

n→∞

X1 + X2 + · · · + Xn

= µ.

n

23 / 37

LGN

número de caras−número de cecas

frecuencia relativa=proporción de caras

100

0.7

80

0.6

60

0.5

40

0.4

20

0.3

0

0.2

−20

0.1

−40

0

1000

2000

3000

4000

5000

6000

N=cantidad de tiradas

7000

8000

9000

0

10000 −1000

0

1000

2000

3000

4000

5000

6000

N=cantidad de tiradas

7000

8000

9000

10000

24 / 37

Teorema Central del límite

Teorema (Teorema Central del Límite)

Sean X1 , X2 , . . . , variables aleatorias igualmente distribuidas, con

media µ y varianza σ 2 . Entonces

X1 + X2 + · · · + Xn − nµ

√

lim P

< x = Φ(x).

n→∞

σ n

25 / 37

Muestra finita

51 intervalos

25 intervalos

5

7

6

4

5

3

4

2

3

2

1

0

1

80

90

100

110

0

80

15 intervalos

12

10

10

8

8

6

6

4

4

2

2

80

90

100

100

110

10 intervalos

12

0

90

110

0

80

90

100

110

26 / 37

Teorema Central del límite

Ejemplo

Supongamos que un programa suma números aproximando cada

sumando al entero más próximo. Si todos los errores cometidos son

independientes entre sí y están distribuidos uniformemente entre -0.5

y 0.5 y se suman 1500 números, ¿A lo sumo cuántos números

pueden sumarse juntos para que la magnitud del error total se

mantenga menor que 10 con probabilidad 0.9?

27 / 37

resolución

Cada error cometido es una variable aleatoria εk con distribución

U[−0.5, 0.5]

E(εk ) = [0.5 + (−0.5)]/2 = 0 Var (εk ) = (0.5 − (0.5))2 /12 = 1/12

Pn

Definamos Sn = k =1 εk , si deseamos encontrar el n más grande

para el cual

0.9 = P(|Sn | < 10)

p

Usando el TCL [S1500 − nE(ε)]/ nVar (ε) ∼ N(0, 1) y

!

−10 − nE(ε)

Sn − nE(ε)

10 − nE(ε)

p

P(|Sn | < 10) = P

≤ p

≤ p

nVar (ε)

nVar (ε)

nVar (ε)

−10

10

−10

= P q ≤ Z ≤ q = 1 − 2P Z ≤ q

n

12

n

12

n

12

28 / 37

resolución

por lo cual

−10

−10

0.9 = 1 − 2P Z ≤ q =⇒ P Z ≤ q = 0.05

n

12

−10

y√

= −1.65. Entonces, despejando resulta n =

n

12

n

12

102 12

1.652

= 440.7.

29 / 37

Teorema Central del límite

Ejemplo

Suponga que se tienen 100 lámparas de un cierto tipo, cuya duración

puede modelarse como una variable exponencial de parámetro

λ = 0.002. Si la duración de cada lámpara es independiente de la

duración de las otras, encuentre la probabilidad de que el promedio

muestral T = (1/100)(T1 + · · · + T100 ) se encuentre entre 400 y 550

horas.

30 / 37

Resolución

Como n es 100, podemos suponerlo suficientemente grande y

aproximar la distribución del promedio por una normal. Entonces la

esperanza y varianza de Sn = T1 + · · · + Tn son

E(Sn ) = E(T1 + · · · + T100 ) = 100.E(T1 ) =

100

= 50000

0.002

Var (Sn ) = Var (T1 + · · · + T100 ) = 100.Var (T1 ) =

100

0.0022

P(400 ≤ (1/100)T1 +· · ·+T100 ≤ 550) = P(40000 ≤ T1 +· · ·+T100 ≤ 55000)

∼

Φ(55000 − E(Sn )/

p

p

Var (Sn )) − Φ(40000 − E(Sn )/ Var (Sn ))

= Φ(55000 − 50000/5000) − Φ(40000 − 50000/5000)

= Φ(1) − Φ(−2) = 0.8413 − 0.0228 = 0.8185

31 / 37

Distribución condicional

I

X e Y discretas:

p(x, y ) = pX |Y (x | y )pY (y )

p(x, y )

P(X = x ∩ Y = y )

=

.

P(Y = y )

pY (y )

X

P(X ≤ x | Y = y ) =

pX |Y (ai | y )

pX |Y (x | y ) = P(X = x | Y = y ) =

ai ≤x

I

X e Y conjuntamente continuas con densidad:

fX |Y (x | y ) =

fY |X (y | x)fX (x)

f (x, y )

=

.

fY (y )

fY (y )

Z

x

P(X ≤ x | Y = y ) =

fX |Y (s | y ) ds.

−∞

32 / 37

Esperanza condicional

I

X e Y conjuntamente discretas se define a la esperanza

condicional de X dado Y = y como

E(X | Y = y ) =

X

xpX |Y (x | y )

x

E(X | Y = y ) =

X

xP(X = x | Y = y ) =

x

I

X P(X = x, Y = y )

x

P(Y = y )

x

X e Y conjuntamente continuas con densidad:

Z

E(X | Y = y ) =

R

xf (x, y )dx

xfX |Y (x | y )dx = R

f (x, y )dx

33 / 37

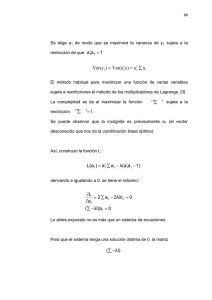

Proposición

Proposición

Sea E(X | Y ) la variable aleatoria (función de la variable aleatoria Y )

cuyo valor en Y = y es E(X | Y = y ). Entonces

E(E(X | Y )) = E(X )

Para el caso X , Y conjuntamente absolutamente continuo o

conjuntamente discreto,

X

E(X ) =

E(X | Y = y )P(Y = y )

y

Z

E(X ) =

E(X | Y = y )fY (y )dy

34 / 37

Esperanza condicional

Ejemplo

Una rata está encerrada en el centro de un laberinto con tres

posibles salidas a diferentes corredores, A, B, C que llevan al interior

del laberinto donde hay una celda con comida. La rata tiende a elegir

la puerta de su derecha (A) la mitad de las veces, mientras que la

otra mitad de las veces elige B o C sin distinguirlas. Ahora, si elige la

puerta A tarda 2 minutos en encontrar la celda de la comida, si elige

la puerta B tarda 3 minutos, y si elige la puerta C da vueltas dentro

del laberinto por 5 minutos y vuelve al lugar de partida (pero no se da

cuenta, es decir cuando elige la puerta del corredor lo hace

nuevamente con las probabilidades de inicio). Encuentre la

esperanza de T , el tiempo que tarda la rata en encontrar su comida.

35 / 37

Esperanza condicional

I

Sea éxito elegir la salida A o B, y sea C̃ la variable aleatoria que

mide la cantidad de veces que se elige la salida C hasta por fin

elegir A o B. Entonces C̃ es geométrica de parámetro 3/4 (que

va desde el cero!!).

I

Sea T el tiempo que se tarda en encontrar la salida

T =

I

2 + 5C̃

3 + 5C̃

si se elige C̃ veces la puerta C y luego A

si se elige C̃ veces la puerta C y luego B

Sea D la variable que es 1 si se eligió la puerta A y 0 si se eligió

la puerta B. Entonces

E(T ) = E(E(T | D)) = E(T | D = 0)P(D = 0)+E(T | D = 1)P(D = 1)

= (2 + 5E(C̃))

2

1

+ (3 + 5E(C̃)) = 4

3

3

36 / 37

Varianza Condicional

Definición

X e Y variables aleatorias se define a la varianza condicional de X

dado el valor de Y como

Var (X | Y ) = E[(X − E[X | Y ])2 | Y ]

Esto es, Var (X | Y ) es una función de Y tal que en Y = y es la

varianza de X dado Y = y .

Proposición

Var (X ) = E[Var (X | Y )] + Var (E[X | Y ])

37 / 37