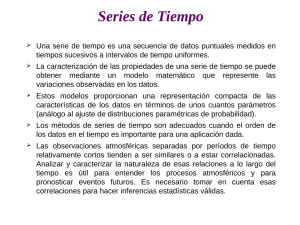

Proceso Estocástico

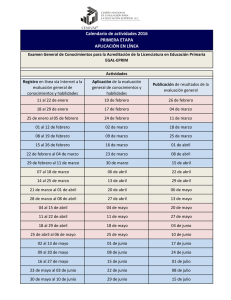

Anuncio

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Proceso Estocástico

Un fenómeno estadístico que evoluciona en el tiempo de acuerdo a leyes probabilísticas

se llama proceso estocástico .

La serie de tiempo puede ser vista como una realización, producto de esa ley

probabilística. Al analizar una serie de tiempo la estamos concibiendo como una

realización de un proceso estocástico (Box-Jenkins-Reinsel 1994).

Cada x t es la realización de cierta variable aleatoria X t . Una serie de tiempo x t de T0

datos, {x t , t ∈ T0 }, es una muestra de tamaño uno del vector de T0 variables aleatorias

ordenadas en el tiempo, es decir, es una realización de la familia de variables aleatorias

{X t , t ∈ T0 }.

Algunas definiciones

Un proceso estocástico es una familia de variables aleatorias {X t , t ∈ T } definidas en un

espacio de probabilidad {Ω, F, P}, donde T es un subconjunto de R, generalmente

puntos del tiempo {0, ±1, ±2, ...}; {0, 1, 2, 3, ...}; [0; ∞]; (-∞; ∞).

Nota: Para cada t ∈ T , X t es una función en Ω. Por otra parte, para cada ω ∈ Ω ,

X t (ω ) es una función en T .

Una realización de un proceso estocástico se define como una función {X (ω ), ω ∈ Ω}

en T, que también se conoce con el nombre de trayectoria del proceso {X t , t ∈ T }.

Otra forma de definir estos conceptos:

Un proceso estocástico es un conjunto de variables aleatorias {Z t } y t toma valores en

cierto conjunto C (días, meses, trimestres, años).

Para cada t ∈ C está definida una v.a. {Z t } y los valores observados en diferentes

momentos forman una serie temporal.

Una serie de T datos ( z1 , z 2 ,..., z T ) es una muestra de tamaño 1 del vector de T variables

aleatorias ordenadas en el tiempo y la serie observada se considera la realización o

trayectoria del proceso estocástico.

El proceso queda caracterizado si definimos la distribución de probabilidad conjunta de

las variables aleatorias ( Z 1 , Z 2 ,..., Z T ), ∀T . Conoceremos la estructura probabilística de

un proceso estocástico cuando se conozcan estas distribuciones.

Ejemplo 1: Sean A y θ variables aleatorias independientes, A ≥ 0; θ ∈ U [0,2π ]. Un

proceso estocástico {X t , t ∈ T } puede definirse en términos de A y θ para cualquier

v ≥ 0 y r > 0:

1

1

X t = A cos(vt + θ ) , ó, más explícitamente, X t (ω ) = A(ω )cos(vt + θ (ω )) con ω ∈ Ω .

r

r

1

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Las realizaciones de este proceso son las funciones de t que se obtienen al fijar ω , es

decir

1

x (t ) = a cos(vt + θ ) .

r

1. La función de distribución de un proceso estocástico:

{X t , t ∈ T ⊂ R} y Γ el conjunto de vectores

Sea

Γ = { t = (t1 , t 2 , K , t n ) ∈ T n : t1 < t 2 < K < t n ; n = 1,2, K}.

Las funciones de distribución (de dimensión finita) de

{Ft (.), t ∈ Γ} definidas para t = (t1 , t 2 ,K, t n ) por

(

{X t , t ∈ T }

son las funciones

)

Ft ( X ) = P X t1 ≤ x1 , X t2 ≤ x 2 ,...., X tn ≤ x n , X = ( x1 , ..... x n )'∈ R n

.

Cada observación es una variable aleatoria y la misma evoluciona en el tiempo de

acuerdo a ciertas leyes probabilísticas.

X t = ε t + θε t −1 , con E (ε t ) = 0 ; V (ε t ) = σ 2 ; COV (ε t , ε s ) = 0 si t ≠ s . Un

{

}

{

}

grupo particular de ε 0 ,K, ε T produce un conjunto x 0 ,K, xT , un grupo diferente de

épsilons, produciría otro conjunto distinto de x’s. Hay infinitos conjuntos de

realizaciones posibles en t=1, 2, 3, ...,T.

Ejemplo:

{

}

El modelo define así una distribución conjunta para las variables aleatorias X 0 ,K X T .

Los momentos del proceso estocástico se definen con respecto a la distribución de las

variables aleatorias X 0 ,K, X T . Pero el problema es que tenemos sólo una observación

para cada momento del tiempo (t), lo que da paso a la idea de estacionariedad.

La importancia del concepto de estacionariedad radica en que, dado que sólo contamos

con una observación para cada momento del tiempo, una única realización, que las

series manifiesten tener propiedades invariantes en el tiempo cobra una importancia

fundamental. En la práctica pocas series presentan esta característica, la mayoría son no

estacionarias, pero se han diseñado filtros que la transforman en una serie con

comportamiento estable, más adelante veremos qué transformaciones se puede aplicar y

los efectos que inducen. De todos modos hay que considerar que la observación de esta

característica depende del período de observación, esto es, del período que abarca las

observaciones con que contamos, pues una serie puede ser estable durante un período

corto pero no estacionaria en un período mayor. Si consideramos la variable

temperatura de la tierra, esta serie puede ser estacionaria si consideramos un período de

20 años, en cambio, puede mostrar una tendencia creciente si ampliamos

sustancialmente el período de medición.

Hay dos formas equivalentes de enfocar el tema de series de tiempo, desde el dominio

del tiempo y desde el dominio de las frecuencias. El primer enfoque se apoya en una

herramienta fundamental para el análisis, la función de autocovarianzas. El segundo

enfoque se basan en la extensión del análisis de Fourier, que se apoyan en la idea de

que, en un intervalo finito, cualquier función analítica puede ser aproximada, con el

2

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

grado de precisión deseado, aproximándola mediante una suma ponderada de funciones

seno y coseno en las frecuencias armónicas. Un proceso Yt puede ser modelizado

mediante una suma ponderada de componentes periódicos a los que se les superimpone

un componente aleatorio.

Función de medias del proceso

E (Z t ) = µ t

Un caso particular se da cuando todas las variables tienen la misma media , en ese caso

la función de medias es una constante. Las realizaciones del proceso no mostrarán

tendencia y diremos que el proceso es estable en media.

Función de varianzas del proceso

Esta función proporciona las varianzas en cada instante temporal :

V ( Z t ) = σ t2

El proceso es estable en varianza, si esta función es constante en el tiempo.

Un proceso puede ser estable en media y no en varianza y viceversa.

La estructura de dependencia lineal entre las variables aleatorias del proceso se

representa por la funciones de autcovarianzas y autocorrelación.

Función de autocovarianzas del proceso

Es una función que describe las covarianzas entre dos variables de proceso en dos

instantes cualesquiera.

Si {X t , t ∈ T } es un proceso estacionario en media y con V ( X t ) < ∞ para cada t∈T,

entonces la FACov γ X (.,.) de {X t } se define como:

γ (t , t + j ) = Cov( X t , X t + j ) = E[( X t − µ t )( X t − j − µ t )]

γ (t , t ) = Var ( X t ) = σ t2

Las autocovarianzas tienen dimensiones, las del cuadrado de la serie, por lo que son no

convenientes para comparar series medidas en unidades distintas.

Se puede quitar esta dimensión y tener una medida de la dependencia lineal mediante la

función de autocorrelación.

3

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Estacionariedad estricta

Un proceso es estrictamente estacionario si sus propiedades no se ven afectadas por un

cambio en el período de análisis, si la distribución conjunta asociada a un conjunto de m

observaciones x1, x2,......xm es la misma a la asociada a x1+k, x2+k,.........xm+k.

La serie de tiempo {X t , t ∈ Z } se dice estrictamente estacionaria si las distribuciones

conjuntas de ( X t1 ,...., X tk )' y ( X t1 + h ,...., X tk + h )' son las mismas para todo entero

positivo k, y para todo t1 , K , t k , k ∈ Z . La distribución conjunta de cualquier conjunto

de variables no se modifica si trasladamos las variables en el tiempo.

La obtención de las distribuciones de probabilidad del proceso es posible en ciertas

situaciones, por ejemplo variables climáticas, donde suponer que cada año se observa

una realización del mismo proceso. Pero en ocasiones sólo se observa una realización

del proceso.

El proceso estocástico existe conceptualmente pero no es posible obtener realizaciones

o muestras sucesivas del mismo, entonces para estimar las características transversales

del proceso es necesario suponer que esas propiedades son estables a lo largo del tiempo

(concepto de estacionariedad).

Estacionariedad débil

La serie de tiempo {X t , t ∈ Z }con

débilmente estacionaria si:

E [X t ] = µ ∀t ∈ Z

Z = {0,±1,±2,K} es covarianza estacionaria ó

E [X t − µ ] < ∞ ∀t ∈ Z

γ (t , t + j ) = Cov( X t , X t + j ) = E[( X t − µ t )( X t − j − µ t )] = γ j ∀j.t ∈ Z

2

La estacionariedad débil no garantiza la estabilidad completa del proceso, porque la

distribución de la variable aleatoria Xt puede estar cambiando en el tiempo. Pero si

suponemos que las variables tienen distribución conjunta normal n-dimensional, como

esta queda determinada por las medias, varianzas y covarianzas , entonces todas las

distribuciones de subconjuntos y las marginales serán idénticas, por o tanto, en este

caso, la estacionariedad débil y estricta coinciden.

La función de autocorrelación (FAC) del proceso estacionario {X t } es una medida

normalizada de la función de autocovarianza y se define como

ρ (t , t + j ) =

Cov( X t , X t + j )

σ tσ t + j

=

γj

γ (t , t + j )

= ρj =

γ0

γ (t , t ) γ (t + j , t + j )

A diferencia de la función de autocovarianzas la función de autocorrelación es

independiente de la escala de medidade la serie, γh = ρh σ2 .

La función de autocorrelación simple (FAS) representa los coeficientes de

autocorrelación (ρ k ) en función del retardo k.

4

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Combinación de procesos estacionarios

Los procesos estacionarios son estables ante combinaciones lineales, los procesos

obtenidos mediante combinaciones lineales de procesos estacionarios son todos

estacionarios.

Ejemplo

Sea Z t un proceso estacionario y Wt = Z t − Z t −1

E (Wt ) = E ( Z t ) − E ( Z t −1 ) = µ − µ = 0

Var (Wt ) = Var ( Z t ) − Var ( Z t −1 ) + 2Cov( Z t , Z t −1 ) = σ 2 + σ 2 + 2γ 1 = 2(σ 2 + γ 1 )

Cov(WtWt + k ) = E[( Z t − Z t +1 )( Z t + k + Z t + k −1 )] = E[ Z t Z t + k − Z t Z t + k −1 − Z t −1 Z t + k + Z t −1 Z t + k −1 ]

= 2 γ k − 2 γ k −1 = 2( γ k − γ k −1 )

⇒ esperanza, varianza y covarianzas no dependen de t ⇒ Wt es estacionario.

Resultado general:

Sea Z t = ( Z 1t ,..., Z kt ) k procesos estacionarios.

Consideremos al proceso escalar definido por :

Yt = c' Z t = c1 Z 1t + ... + c k Z kt ,

con

c' = (c1 ,..., c k )

E (Yt ) = c' E ( Z t ) = c1 E ( Z 1t ) + ... + c k ( Z kt ) = c' µ

µ' = (µ1 ,..., µ k ) vector de medias, como E ( Z ti ) = µ i son constantes ⇒ E (Yt ) es

constante.

Var (Yt ) = E (c' ( Z t − µ)( Z t − µ)c) = c' Γz c

Γz es la matriz de varianzas y covarianzas entre las componentes, como las

componentes son estacionarias, la matriz de covarianzas entre ellas también lo es.

Cov(Yt , Yt + k ) = c' Γz (k )c

Γz (k ) contiene las covarianzas entre los componentes en distintos instantes, que por

hipótesis sólo dependen del retardo.

⇒ Yt es estacionario.

Una consecuencia de este resultado es que las autocovarianzas tienen que cumplir

ciertas condiciones correspondan a un proceso estacionario.

Sea Yt = c1 Z t + c 2 Z t −1 + ... + c k Z t − k

Var (Yt ) = c' Γz (k )c debe ser no negativa

5

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

γ0

γ

Γ(k ) = 1

M

γ k −1

γ1

γ0

L

...

O

L

L

γ k −1

γ k −2

M

γ 0

la matriz de autocovarianzas de orden k del proceso Z t es definida no negativa.

Para una secuencia de números pueda ser una FACov de un proceso estacionario, esta

secuencia debe verificar que la matriz de autocovarianzas asociada de orden k debe ser

definida no negativa.

Si considero un proceso con γ 0 = 1 ⇒ γ k = ρ k

1 ρ1 L ρ k −1

ρ

O

M

1

→R=

debe ser también definida no negativa.

M

O M

ρ k −1 L L 1

Propiedades de la función de autocovarianzas

a) γ k = γ −k

b) γ 0 = Var (Yt ) > 0

c) γ k ≤ γ 0

d )Γk → matriz _ semidefinida _ positiva

e)ρ k =

γk

γ0

d) Que las matrices de autocovarianza y autocorrelación sean definidas positivas

implica que su determinante y los menores principales sean mayor que 0.

1

• Sea n=2 , ρ1

1

•

Sea n=3

ρ1

ρ2

ρ1

>0→

1

ρ1

1

ρ1

ρ2

ρ1 > 0 ,

1

1 − ρ12 > 0

1 − ρ12 > 0ρ12 > 1 → −1 < ρ1 < 1

ρ12 < 1

1

ρ1

ρ1

>0

1

1

ρ2

ρ2

>0

1

6

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

implica que: − 1 < ρ1 < 1

− 1 < ρ2 < 1

ρ 2 − ρ12

−1 <

<1

1 − ρ12

Ejercicios:Discutir la estacionariedad

Caso 1.

X t = α cos(θ t ) + β sen(θ t ), t ∈ Z

α y β v.a. no corr.

E (α ) = E ( β ) = 0; V (α ) = V ( β ) = 1; θ fijo.

Note que cos( X ± Y ) = cos( X )cos(Y ) ± sen ( X )sen (Y )

Caso 2.

Y t = X 1 + X 2 + .... + X t

X t → NI (0, σ 2 );

E (Y t ) = 0

Serie de Tiempo Gaussiana o Normal

El proceso {X t } se dice Gaussiano o Normal si y sólo si las funciones de distribución de

{X t } son todas Normales Multivariadas.

Nota: Si {X t , t ∈ Z } es un proceso Gaussiano y débilemnte estacionario, entonces es

estrictamente estacionario, ya que para todo n ∈ {1,2,K} y para todo h, t1 , t 2 K ∈ Z los

vectores ( X t1 ,...., X tk )' y ( X t1 + h ,...., X tk + h )' tienen la misma media y matriz de

covarianzas, y por tanto la misma distribución.

Operador de Rezagos

Notaremos L al operador de rezagos. Es un operador lineal, tal que, aplicado a

x t produce x t −1 :

Lxt = xt −1 .

Se extiende fácilmente a más rezagos L j x t = x t − j , j = 0,1,K

L puede manipularse como cualquier cantidad algebraica.

Una constante se interpreta como una función que es constante en el tiempo, por tanto

aplicar el operador de rezagos a una constante, no da lugar a modificaciones.

L(a) = a , a = cte.

Es un operador lineal, por tanto si:

L(a Xt + b Yt) = a Xt-1 + b Yt-1

Sea un proceso autorregresivo de orden 1

7

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

xt = φ xt −1 + ε t

φ ( L) = (1 − φ L )xt = ε t

∞

∞

j =0

j =0

xt = ∑ φ jε t − j = ∑ (φL ) ε t =

j

1

εt

1 − φL

Se pueden definir polinomios en el operador de rezagos, esto presenta la ventaja de que

se operan de la misma manera que los polinomios algebraicos ordinarios.

Obsérvese que el resultado de la progresión geométrica implica tratar a L como si

tuviera “magnitud” 1, más allá de lo que el término magnitud pueda significar.

Operador de Diferencias

Un caso particular de operador polinómico es el operador diferencias, se define como

∆ = (1 − L ) . Por tanto, ∆x t = (1 − L )x t = x t − x t −1 , y al igual que en el caso del operador

de rezagos, se generaliza fácilmente a cualquier número de diferencias: ∆ j = (1 − L )

j

Note que ∆2 = (1 − L ) = (1 + L2 − 2 L ) , es decir que ∆2 x t = x t + x t − 2 − 2 x t −1

2

Operador Suma

∞

Sea S= (1-L)-1 = 1 + L+ L2 + .....Lp y tiene el siguiente efecto: Sxt = ∑ xt −1

i =0

8

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

PROCESOS ESTOCASTICOS ESTACIONARIOS

Ruido Blanco

El proceso estocástico débilmente estacionario más simple que se puede definir, se

denomina RUIDO BLANCO (RB). Un proceso estocástico estacionario se denomina

Ruido Blanco si:

1) E ( X t ) = 0 ∀t ∈ Z

σ 2 si k = 0

2) γ ( k ) =

0 si k ≠ 0

Es un proceso con esperanza cero, varianza constante y donde las variables del proceso

están incorrelacionadas para todos los retardos.

El proceso ruido blanco no es necesariamente estacionario en sentido estricto, sólo se

impone incorrelación, por tanto no necesariamente las variables son independientes. Si

se impone la condición de que las variables del proceso tienen distribución normal, el

proceso será estacionario en sentido estricto. Bajo estas características el proceso se

denomina ruido blanco gaussiano.

Ejemplo:Se simulan 1500 observaciones de un proceso ruido blanco gaussiano

-3

-2

-1

0

w

1

2

3

w=rnorm(1500,0,1)

plot.ts(w)

par(mfrow=c(2,1))

autoc_rb<-acf(w,lag.max=24,main="Autocorrelograma Ruido Blanco")

pacf_rb<-pacf(w,lag.max=24,main="Autocorrelograma Parcial Ruido

Blanco")

autoc_rb

pacf_rb

0

500

1000

1500

Time

9

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

0.4

0.0

AC F

0.8

Au to c o rre lo g ra m a Ru id o B la n c o

0

5

10

15

20

Lag

0.02

-0.04

Partial A C F

Au to c o rre lo g ra m a P a rc ia l Ru id o B la n c o

5

10

15

20

Lag

Autocorrelations of series 'w', by lag

0

1

2

3

4

5

6

7

8

9

10

1.000 0.009 0.020 -0.011 0.006 -0.005 -0.003 -0.019 -0.023 0.022 -0.009

11

12

13

14

15

16

17

18

19

20

21

-0.021 -0.001 -0.009 -0.028 -0.014 0.017 0.020 0.010 0.006 -0.046 -0.017

22

23

24

-0.023 -0.003 0.024

Partial autocorrelations of series 'w', by lag

1

2

3

4

5

6

7

8

9

10

11

0.009 0.020 -0.011 0.006 -0.005 -0.004 -0.018 -0.023 0.023 -0.009 -0.023

12

13

14

15

16

17

18

19

20

21

22

0.000 -0.009 -0.029 -0.014 0.019 0.020 0.007 0.005 -0.046 -0.018 -0.023

23

24

-0.002 0.026

Procesos Autorregresivos

Los modelos autorregresivos se basan enla idea de que los valores corrientes de la serie

puede ser explicados a partir de los p valores pasados, como combinación lineal de los

mismos.

10

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

El proceso {X t , t ∈ T } se dice autorregresivo de orden p; X t → AR ( p ) ⇔

X t = φ1 X t −1 + φ 2 X t − 2 + ..... + φ ` p X t − p + ε t , donde ε t es un ruido blanco y los φ ’s son

coeficientes fijos.

Utilizando el operador de rezagos definido previamente, podemos re-escribir la

expresión anterior:

(1 − φ 1 L − φ 2 L2 − ..... − φ ` p L p ) X t = ε t .

Podemos escribir sintéticamente el polinomio en L:

(1 − φ1 L − φ 2 L2 − ..... − φ` p Lp ) = φ ( L) ⇒ φ ( L) X t = ε t

Xt =

εt

φ (L)

A partir de un RB genero X t . La introducción de los rezagos de X t es lo que introduce

correlación en el proceso (correlación que el RB no tiene).

Cuando p = 1 tenemos un caso muy simple que se presenta a continuación.

Proceso autorregresivo de orden uno, AR(1)

X t = φX t −1 + ε t

Ejemplo:

t

0

1

2

3

4

5

6

εt

-0,12

0,20

0,06

-0,18

-0,04

0,00

X t (φ = 0,5)

0,16

-0,04

0,18

0,15

-0,105

-0,09

-0,045

A partir de t = 1, genero un ruido blanco, a partir de ese ruido, de X 0 y de φ ; genero el

resto de la serie. Con este ejemplo muy simple, vemos que se requiere un punto de

partida, un arranque, X 0 = 0,16 en este caso.

Si consideramos la serie de entrada y la de salida, se aprecia es que ε t tiene un

comportamiento más errático que X t , y ello se debe a la parte φX t −1 que es la que da

inercia.

En el trabajo con series temporales estacionarias, iremos viendo que la “forma“ de los

procesos es lo importante. La “forma” del proceso AR(1) no depende de t, es decir, lo

que vale para t, vale para t - 1, t + 1, etc. Ello nos permite utilizar el procedimiento

recursivo, que resulta muy útil para trabajar la serie:

X t = φX t −1 + ε t = φ (φX t − 2 + ε t −1 ) + ε t = φ 2 X t − 2 + φε t −1 + ε t = ......... =

n −1

φ n X t − n + φ n −1ε t − ( n −1) + φ n − 2 ε t − ( n − 2 ) + ..... + φε t −1 + ε t = φ n X t − n + ∑ φ j ε t − j

j =0

Llegados a este punto, nos preguntamos: Dónde comenzó el proceso? En el momento

0?, En el pasado infinito? Veremos a continuación que esta decisión es importante.

11

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Estacionariedad e inicio del proceso

1. El proceso comenzó en t = 0 , con X 0 fijo.

Tenemos que:

n −1

X t = φ X t −n + ∑φ j ε t − j .

n

j =0

t −1

Si tomamos n = t, tenemos: X t = φ t X 0 + ∑ φ j ε t − j

j =0

E( X t ) = µt = φ X 0

t

1 − φ 2 t 2

t −1

t −1

t

σ

φ2 ≠1

V ( X t ) = V φ X 0 + ∑ φ j ε t − j = V ∑ φ j ε t − j = 1 − φ 2

j =0

j =0

tσ 2

φ 2 =1

Obsérvese que la media depende de t, al igual que la varianza, cualquiera sea el valor de

φ. No tenemos por tanto un proceso estacionario.

Veamos la Covarianza:

t + k −1

t −1

t −1

E ( X t . X t + k ) = E ∑φ jε t − j ∑φ jε t +k − j = ∑φ kφ 2 j E (ε 2 t − j ) =

j =0

j =0

j =0

t −1

φ kV ( X t ) φ 2 ≠ 1

φ k ∑φ 2 jσ 2 =

φ2 =1

j =0

V ( X t )

La covarianza también depende de t (porque la varianza depende de t) como era de

esperar.

Por tanto, si el proceso comenzó en t = 0, con X 0 fijo (no aleatorio), no tenemos

estacionariedad.

El caso φ =1 tampoco es estacionario, pero es un caso muy especial, conocido como

paseo aleatorio.

2. El proceso comienza en t = -∞ (|φ | < 1)

En la medida en que el proceso comenzó en el pasado remoto, (t = -∞) el primer término del

proceso desaparece, con lo cual queda redefinido como:

∞

X t = ∑φ jε t − j

0

E( X t ) = µt = φ t X 0 = 0

∞

∞

σ2

V ( X t ) = V ∑ φ j ε t − j = σ 2 ∑ φ 2 j =

= γ (0)

1−φ 2

0

j =0

Cov( X t . X t + k ) = γ (k ) = φ k γ (0)

Por lo tanto, basta con que |φ | < 1 para que el proceso sea estacionario, cuando éste

comenzó en t = -∞ .

Note que ρ ( k ) = γ ( k ) / γ (0) = φ k

12

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

3. El proceso comienza en t = 0, pero con X 0 una variable aleatoria

E( X 0 ) = 0 y V ( X 0 ) =

σ

2

1−φ2

y además, X 0 no está correlacionado con ε 1 , ε 2 ,K etc.

X 0 se piensa como una variable aleatoria que es igual al proceso en estado estacionario.

Además consideramos el caso |φ | < 1.

E ( X t ) = µ t = E (φ t X 0 ) = 0

t −1

t −1

φ 2t

1 − φ 2t 2

σ2

2

V ( X t ) = V φ t X 0 + ∑ φ j ε t − j = V (φ t X 0 ) + V ∑ φ j ε t − j =

σ

+

σ

=

2

1−φ 2

1−φ 2

j =0

j =0

1−φ

la varianza de la suma es la suma de las varianzas porque la COV [X 0 , (ε 1 , ε 2 ,K)] = 0 .

Calculemos ahora las Covarianzas: COV ( X t , X t + k ) .

t −1

X t = φ t X 0 + ∑φ jε t− j

j =0

X t +k = φ t +k X 0 +

t + k −1

∑φ

j =0

j

ε t +k − j

2t

t −1

σ2

σ2

σ2

k

k

k

2 1−φ

2

2j

2t + k

+ φ σ ∑φ = φ

+φ σ

=φ

E ( X t X t +k ) = φ

1−φ 2

1−φ 2

1−φ 2

1−φ 2

j =0

Como puede verse, ninguno de los momentos depende de t, por lo que el proceso es

estacionario1.

El punto de partida es importante, pero como vimos, no es preciso que comience en -∞,

basta con que lo haga en t = 0, con X 0 en la solución estacionaria pero en ambos casos

2t + k

se requiere que φ < 1 .

4. Si φ = 1 y X 0 ≡ 0 . E ( X t ) = µ t = 0; V ( X t ) = tσ 2 ; COV ( X t ; X s ) = min(t , s )σ 2 .

Este caso es, como puede apreciarse, no estacionario, y se conoce como Camino

Aleatorio. El tipo de no estacionariedad que propone este modelo es interesante.

Obsérvese que:

X t = X t −1 + ε t

X t −1 = X t − 2 + ε t −1 ⇒ X t = X t − 2 + ε t −1 + ε t ⇒

t −1

X t = X 0 + ∑ε t− j

j =0

el efecto de cualquier suceso que ocurra en el pasado se queda para siempre impactando

la dinámica de la serie. Esta es una diferencia clave con los procesos estacionarios,

donde el impacto de lo ocurrido en el pasado remoto tiende a desaparecer, en la medida

en que φ j se hace más y más pequeño.

El tipo de no estacionariedad que se genera cuando φ > 1 es muy especial, genera

procesos explosivos, en la medida en que lo que sucedió en el pasado se hace cada vez

más importante.

Ejemplo

Simulación en R de un camino aleatorio con deriva (random walk with drift)

1

No se ha dicho nada de la distribución de las variables, por lo que no sabemos si es estrictamente estacionario.

13

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

0

10

20

xd

30

40

50

set.seed(154)

w=rnorm(200,0,1);x=cumsum(w)

wd=w+0.2;xd=cumsum(wd)

plot.ts(xd, ylim=c(-5,55))

0

50

100

150

200

Time

autoc=acf(xd,lag.max=40)

0.4

0.0

0.2

AC F

0.6

0.8

1.0

S e rie s x d

0

10

20

30

40

Lag

Simulación en R de un camino aleatorio (random walk )

set.seed(170540)

w=rnorm(200,0,1);x=cumsum(w)

plot.ts(x)

14

0

-5

x

5

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

0

50

100

150

200

Time

Observaciones

Muchas de las consideraciones serán extensibles al modelo AR(p), con p > 1,

1. Diferencia entre esperanza incondicional y esperanza condicional, E ( X t ) y

E ( X t X t −1 )

Sea el proceso: X t = φX t −1 + ε t

La esperanza incondicional, E ( X t ) = 0

En cambio la esperanza condicional, E ( X t X t −1 ) = φ X t −1

donde X t −1 está dado, es un dato y será en general diferente de cero.

2.En el curso, en general supondremos que T representa los números enteros, por lo

que supondremos que el proceso comenzó en -∞.

3. X t está correlacionado con ε t , ε t −1 , ε t −2 ,K , (el pasado ) pero no con ε t +1 , ε t + 2 ,K ,(el

futuro).

∞

Ello resulta evidente en la formulación del proceso como X t = ∑ φ j ε t − j .

La COV (X t , ε t − j ) = φ σ para j > 0 , pero COV (X t , ε t + j ) = 0 .

j

j =0

2

4.El proceso AR(1) es estacionario si φ < 1 y ocurre:

iii-

El proceso comienza en t = −∞ .

El proceso comienza en t = 0 en la solución estacionaria

15

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Función de autocovarianzas de un AR(1)

Si sabemos que X t ∼ AR (1) es estacionario, entonces

X t = φ X t −1 + ε t

E ( X t ) = E (φX t −1 + ε t ) ⇒ µ = φµ ⇒ µ = 0.

Multiplicando por X t a ambos lados de la definición del proceso, y tomamos esperanza

tenemos:

E ( X t X t ) = φE ( X t X t −1 ) + E ( X t ε t )

γ 0 = φγ 1 + σ 2

Multiplicando X t por X t −1 a ambos lados y tomamos esperanza tenemos:

E ( X t −1 X t ) = φE ( X t −1 X t −1 ) + E ( X t −1ε t )

γ1 = φ γ 0 + 0 = φ γ 0

Si ahora multiplicamos X t por X t −k con k > 1, y tomamos esperanza, tendremos:

γ k = φ γ k −1 ⇒

γ 0 = φγ1 +σ 2

γ1 = φγ 0

γ k = φ γ k −1

En general, γ k = φ k γ 0 ∴ ρ k = φ k

Este método de cálculo para la función de autocovarianza es válido si el proceso es

estacionario.

La expresión de la función de autocorrelación de un proceso AR(1) es igual a las

potencias del perámetro φ y decrece geométricamente hacia cero. Si el parámetro es

positivo, la dependencia lineal del presente de los valores pasados es siempre

positiva. Si el parámetro es negativo, la dependencia es positiva para los rezagos

pares y negativa para los impares.

•

Hasta ahora hemos trabajado con X t ∼ AR (1) con media 0. El proceso se generaliza

fácilmente para media ≠ 0. Podemos pensar en X t con E ( X t ) = µ ≠ 0 . Definamos

entonces X t* = X t − µ .

Este nuevo proceso es tal que:

X t − µ = φ ( X t −1 − µ ) + ε t , de donde X t = φ X t −1 + µ (1 − φ ) + ε t

•

Obsérvese que en la definición del proceso aparecerá una constante, pero esa

constante no es la media del proceso, µ , sino que está multiplicada por (1 − φ ) .

16

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Existen 2 posibles formas para la función de autocorrelación de un AR(1)

Ejemplo:

Usando R para simular un AR(1)

1. φ = 0.8

0

-4

-2

a r1 .s i m

2

4

ar1.sim<-(arima.sim(list(order=c(1,0,0),ar=0.8),n=200))

plot(ar1.sim)

0

50

100

150

200

Tim e

Función de autocorrelación de la serie simulada

autoc<-acf(ar1.sim,lag.max=20)

ACF

0 .0

0 .2

0 .4

0 .6

0 .8

1 .0

S e r ie s a r 1 .s im

0

5

10

15

20

Lag

autoc

Autocorrelations of series 'ar1.sim', by lag

0

1.000

11

0.092

1

0.776

12

0.048

2

0.625

13

0.020

3

0.501

14

0.006

4

0.376

15

0.001

5

0.279

16

0.009

6

0.217

17

0.022

7

8

9

0.200 0.184 0.132

18

19

20

0.022 -0.014 -0.005

10

0.095

17

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

2 φ = -0.8

1

0

-3

-2

-1

a r1 .s i m

2

3

ar1.sim<-(arima.sim(list(order=c(1,0,0),ar=-0.8),n=200))

plot(ar1.sim)

0

5 0

1 0 0

1 5 0

2 0 0

T im e

autoc<-acf(ar1.sim,lag.max=20)

a r 1 .s im

-0 .5

0 .0

ACF

0 .5

1 .0

S e r ie s

0

5

10

15

20

Lag

autoc

Autocorrelations of series 'ar1.sim', by lag

0

1

1.000 -0.753

11

12

-0.032 0.003

2

3

0.578 -0.392

13

14

0.027 -0.056

4

5

0.281 -0.203

15

16

0.044 -0.082

6

7

0.164 -0.088

17

18

0.053 -0.034

8

9

0.071 -0.066

19

20

0.018 -0.004

10

0.038

Verifique usando el paquete R que, para valores de φ pequeños (en un proceso AR(1)),

la caída a 0 es rápida.

18

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Otra forma de verificar si un proceso AR(1) es estacionario es verificando el signo de la

raíz de la siguiente ecuación característica (1 − φ L ) = 0 . El proceso es estacionario si la

raíz es > 1 en valor absoluto.

1

(1 − φ L) = 0 ⇒ L =

φ

Esta condición es equivalente a φ < 1 .

Proceso autorregresivo de segundo orden, AR(2)

Muchos de los resultados obtenidos hasta aquí pueden generalizarse a procesos de

mayor orden, pero hay una serie de temas que no aparecen en un proceso AR(1) y que

ahora analizaremos el proceso AR(2).

X t = φ 1 X t −1 + φ 2 X t − 2 + ε t , donde ε t es un proceso ruido blanco.

Como vimos nos interesa particularmente establecer las condiciones de estacionariedad

del proceso.

Si φ1 = φ 2 = 0, obviamente el proceso es estacionario, pues Xt = εt

Reescribamos el proceso como una ecuación en diferencias:

(1 − φ1 L − φ 2 L2 ) X t = ε t ó lo que es lo mismo

φ ( L) X t = ε t ⇒ Ecuación en diferencias

Es una ecuación en diferencias no homogénea2. La solución se halla sumando a la

solución de la homogénea, una solución particular.

Tomando X t − n = 0; X t − ( n +1) = 0; tendremos una solución particular de la forma

n −1

X t = ∑ψ j ε t − j 3.

j =0

2

Al igual que el resto de las ecuaciones matemáticas, las ecuaciones en diferencias admiten una solución para la

variable incógnita, Xt. La solución a la ecuación en diferencias será generalmente otra función, no un único valor.

Esta solución nos informará acerca de cómo se forman los valores de Xt a través del tiempo, de la variable tiempo y

del componente aleatorio, εt .

El procedimiento general de ecuaciones en diferencias parte de la descomposición de la solución completa en dos

partes, la solución homogénea y la solución particular. La ecuación homogénea considera únicamente los valores de

Xt y su pasado, y como todo sistema homogéneo admite la solución trivial o bien un conjunto infinito de soluciones a

partir de dos constantes arbitrarias. La solución particular atiende a la parte formada por el término independiente, si

existe y la perturbación aleatoria εt .El procedimiento de resolución comprenderá cuatro etapas: identificar la

ecuación homogénea y encontrar las n soluciones posibles, encontrar la solución particular, formar la solución

completa como suma de la homogénea y la particular y finalmente eliminar las constantes arbitrarias imponiendo

condiciones iniciales.

3

Se obtiene esta expresión, realizando sustituciones recursivas en

por ejemplo

X t −1 por ( φ1 X t − 2 + φ 2 X t − 3 + ε t −1 )

y

X t = φ 1 X t −1 + φ 2 X t − 2 + ε t , sustituyendo

X t − 2 por ( φ 1 X t − 3 + φ 2 X t − 4 + ε t − 2 )

hasta

19

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Para encontrar la solución de la ecuación homogénea de (1 − φ1 L − φ 2 L2 ) X t = 0 es

preciso resolver la ecuación característica: (1 − φ1 L − φ 2 L2 ) = 0 , sean m1 y m2 las raíces

de (1 − φ1 L − φ 2 L2 ) = 0 ; c1 y c 2 constantes a determinar de acuerdo a ciertas

condiciones iniciales (en este caso, por donde pasa X t en 2 momentos X0 y X1).

Al resolver la ecuación característica las posibles soluciones a la ecuación homogénea

son:

1. dos raíces reales y distintas ( m1 ≠ m2 ), 2RR≠: X t = c1 (1 / m1 ) + c 2 (1 / m 2 )

t

2. dos raíces reales e iguales ( m1 = m2 = m ): X t = ( c1 + c 2 t )(1 / m )

t

3. dos raíces complejas conjugadas ( m1 ≠ m2 ): X t = c1 (1 / m1 ) + c 2 (1 / m 2 )

t

t

t

La solución de la ecuación en diferencias no homogénea es la suma de la particular y la

homogénea:

n −1

X t = c1 (1 / m1 ) t + c 2 (1 / m 2 ) t + ∑ψ j ε t − j para los casos 1 y 3 y

j =0

n −1

X t = (c1 + c 2 t )(1 / m ) + ∑ψ j ε t − j en el caso 2.

t

j =0

Pero para que podamos decir que el proceso es estacionario, la solución no deberá

depender de las constantes c1 y c 2 , ya que éstas a su vez dependen de las condiciones

iniciales vinculadas a momentos específicos del pasado. Si ello ocurriera, la idea de

estacionariedad se vería comprometida. Para que el proceso sea estacionario, es preciso

que la solución sea independiente de las condiciones iniciales.

En el caso de 2RR≠, m1 ≠ m2 .

Si al tiempo [ t − n ] y [ t − (n + 1) ] cuento con ciertas condiciones iniciales, es decir,

conozco dos valores del proceso, X t −n y X t −(n +1) , tenemos:

X t −n

1

= c1

m

1

X t − n −1

t −n

1

= c1

m1

1

+ c 2

m2

t − n −1

t −n

1

+ c 2

m2

t − n −1

Inicio del Proceso

Nuevamente es preciso discutir diferentes situaciones:

1. El proceso comenzó en t = 0 .

2. El proceso comenzó en t = −∞ (n = ∞ ) .

llegar a

X t − n y X t − ( n +1)

que se asumieron como 0. Desaparecen así las x’s del lado derecho, quedando una suma

sólo en ε’s rezagados.

20

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

3. El proceso comenzó en t = 0 , pero con X t −n y X t −n −1 v.a. en la solución

estacionaria.

Veamos el caso 2. Aquí es preciso que m1 y m2 sean ambos mayores que 1 en valor

absoluto, de manera que al ser elevados a la n = ∞ , c1 y c 2 se hagan 0, y de este modo

se independiza la solución de las condiciones “iniciales” X t −n y X t −n −1 .

0

0

647

48 647

48 ∞

∞

t

La solución queda: X t = c1 (1 / m1 ) + c 2 (1 / m 2 ) t + ∑ψ j ε t − j = ∑ψ j ε t − j , y de esta

j =0

j =0

forma X t se independiza del pasado infinito.

Ejercicio: demostrar que si el proceso comenzó en t = 0 el proceso no es estacionario, y

que si comenzó en t = 0 con X t −n y X t −n −1 variables aleatorias en la solución

estacionaria, el proceso es estacionario, exactamente igual que en el caso AR(1).

Representación del proceso como una suma de innovaciones

Determinación de los ψ k

Trabajaremos de ahora en más suponiendo que el proceso comenzó en el pasado

remoto, en t = −∞ . Por lo tanto, el proceso AR(2), como acabamos de demostrar,

puede escribirse como:

∞

∞

k =0

k =0

X t = ∑ψ k ε t −k = ∑ψ k Lk ε t =ψ ( L)ε t

Por otra parte, en la definición del proceso escribimos:

1

φ ( L) X t = ε t , de donde X t =

εt .

φ ( L)

Igualando los coeficientes de ε t , tenemos:

1

ψ ( L)ε t =

ε ⇒ψ ( L)φ ( L) = 1

φ ( L) t

(ψ 0 + ψ 1 L + ψ 2 L2 +ψ 3L3 + ...)(1 − φ1 L − φ 2 L2 ) = 1

ψ0 =1

ψ 1 −ψ 0φ1 = 0 ⇒ ψ 1 = φ1

ψ 2 −ψ 1φ1 −ψ 0φ 2 = 0; y en general

ψ k −ψ k −1φ1 −ψ k −2φ 2 = 0 ∀k ≥ 2

(1 − φ L − φ L )ψ

2

1

2

k

=0

Esta es la misma ecuación en diferencias que define al proceso AR(2). Además

conocemos condiciones iniciales: ψ 0 = 1 y ψ 1 = φ1 .

21

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Para qué trabajar con los ψ k ? En ocasiones es más fácil trabajar con el proceso

∞

planteado en la forma X t = ∑ψ k ε t −k , por ejemplo para calcular Esperanzas, Varianzas

k =0

y Covarianzas.

Las soluciones posibles a 1 − φ1 L − φ 2 L2 = 0 son las mismas que mencionáramos

precedentemente, ya que la ecuación característica es la misma:

a) 2 Raíces Reales distintas:

ψ t = c1 (1 / m1 )t + c 2 (1 / m2 )t ; ψ 0 = 1, ψ 1 = φ1

ψ 0 = c1 + c 2 = 1

c1 c 2

+

= φ1

m1 m 2

m1 y m2 a su vez son función de φ1 y de φ 2 por lo cual c1 y c 2 también lo serán.

Una vez determinados c1 y c 2 se reemplazan en la fórmula para calcular ψ t

quedando así determinado ψ t para todo t.

b) 2 Raíces Reales iguales:

ψ t = (c1 + c 2 t )(1 / m )t

ψ 0 = c1 = 1

ψ1 =

c1 + c 2

= φ1

m

Idem al caso anterior, se determinan c1 y c 2 y se reemplazan en la fórmula para

calcular ψ t .

c) 2 Raíces Complejas y Conjugadas:

ψ1 =

Siendo i = − 1 , las raíces de la ecuación característica serán de la forma

m = a ± bi = re ± iθ = r (cos(θ ) ± isen(θ ) ) = re ± iθ

r = a ± bi = a 2 + b 2

cos(θ ) =

θ:

sen(θ ) =

a

r

b

r

−π ≤θ ≤ π

Observación:

La igualdad entre la forma trigonométrica y exponencial r (cos(θ ) ± isen(θ ) ) = re ± iθ

Proviene de los siguientes desarrollos de cos θ y de i sen θ en el punto θ = 0 :

θ2 θ4 θ6

cosθ = 1 −

+

−

+ .......

2! 4! 6!

3

5

7

iθ

iθ

iθ

isenθ = iθ −

+

−

+ .......

3!

5!

7!

22

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

θ 2 iθ 3 θ 4

cosθ + isenθ = 1 + iθ −

−

+

+ ......... = e iθ

2!

3!

4!

A estas representaciones se les denomina forma cartesiana, trigonométrica y

exponencial.

La solución general tiene la misma estructura que se mostró antes:

t

t

t

1

1

1

ψ t = c1 e − iθ t + c 2 e iθt = [(c 2 + c1 )cos (θ t ) + i (c 2 − c1 )sen (θ t )]

r

r

r

c1 y c 2 serán también complejos conjugados:

con c1 + c2 =A y c2 – c1 = B

A = C cos (δ)

B = C sen (δ)

y es equivalente a escribir:

ψ t = C (1 / r ) t [sen (θ × t − δ )]

t

1

domina la tendencia. Si r > 1, tiende a 0 al tender t a ∞. Si r < 1, tiende a ∞ al

r

tender t a ∞.

t

t

1

1

El parámetro define la amplitud de la representación C . Para que la

r

r

secuencia representada por Yt sea convergente, será necesario que r > 1 en valor

absoluto.

El parámetro θ representa la frecuencia angular y define el número de ciclos por

unidad de tiempo, la inversa del período. La frecuencia se mide en radianes.

El parámetro δ representa la fase, la situación del ciclo en cada momento del tiempo,

define la ordenada en el origen t = 0.

ψ 0 = c1 + c 2 = 1

1

ψ 1 = [(c 2 + c1 ) cos θ + i (c 2 − c1 ) sen θ ] = φ 1

r

Como c1 y c 2 son complejos conjugados, los ψ t son siempre reales.

Aunque esta expresión es algo compleja de obtener, permite establecer con sencillez

los patrones de evolución temporal del proceso, ya que lo que obtuvimos es una

función trigonométrica sencilla de representar, con claros patrones periódicos.

Cuando las raíces son reales, la convergencia a 0 es exponencial. Cuando las raíces son

complejas, la convergencia a 0 es oscilante.

23

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Ejemplo: AR(2)

1- (1 − 0,75L + 0,125L2 )X t = ε t

2- (1 − 0,8 L + 0,6 L2 )X t = ε t

−1

m2

n −t

1

c1

1

1 c1

m1

m1n −t X t −n

+ ∑ψ k ε t −k ; y =

entonces:

X t = t

t

1 X t −n −1

c 2 m2 − m1 − m1

m1 m2 c 2 k =0

n −t

m2n −t

m2

n −1

m2 m1

− 1 1

1

1

n − n X t −n +

n + n X t −n −1 + ∑ψ k ε t −k

X t =

k =0

m2 − m1 m1 m2

m2 − m1 m1 m2

n −1

En este caso particular, m1 = 2 y m2 = 4 .

n −1

1 4

2

1 −1 1

X t = n − n X t −n + n + n X t −n −1 + ∑ψ k ε t −k

22

4

22

4

k =0

Como las raíces son mayores que 1, a medida que crece n el pasado va perdiendo

importancia, y el proceso depende cada vez menos de condiciones iniciales.

Si hacemos n = 1 :

X t = 0,75 X t −1 − 0,125 X t − 2 + ε t

En el segundo ejemplo las raíces serán complejas:

0,8 ± − 1,76 2

1 − 0,8 z + 0,6 z 2 = 0 ⇒ z = a ± bi =

= ± 1,10554 i . Podemos expresar

1,2

3

esto de diferentes formas más o menos convenientes. Una forma que permite visualizar

el comportamiento tanto de la FAC como de los ψ k es hacer que aparezca el módulo

del complejo: r.

r = a 2 + b 2 = 1,291

cosθ = 0,5164 ⇒θ = 0,3273π

a ± bi = r (cosθ ± i sen θ ) = re ± θi = 1,291e ± 0,3273πi

la fórmula que deriváramos para ψ k era:

k

k

1

1

1

ψ k = c1 e − i θ k + c 2 e i θ k =

r

r

r

ψk

1

=

1,291

k

[(c 2

k

[(c 2 + c1 ) cos (θ k ) + i (c 2 − c1 ) sen (θ k )]

+ c 1 ) cos (0,3273 π k ) + i (c 2 − c 1 ) sen (0,3273 π k )]

calculando c1 y c 2 (tarea) obtenemos:

k

ψk

1

=

[cos (0,3273 π k ) − i 0,603 sen (0,3273 π k )]

1,291

La expresión del segundo paréntesis oscilará acotada, por lo que (como ya sabemos) la

convergencia estará determinada sólo por la expresión en el primer paréntesis.

En este caso, 1 = 0,7746 < 1 , y por tanto los ψj irán a 0 a medida que k crezca. La

1,291

evolución será precisamente la mostrada en el gráfico de ψj presentado anteriormente.

24

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Ejemplo en R

0

-4

-2

ar2

2

4

1. Raíces complejas

set.seed(5)

ar2=arima.sim(list(order=c(2,0,0),ar=c(0.8,-0.6)),n=150)

plot.ts(ar2,axes=F);box();axis(2)

axis(1,seq(0,150,25))

abline(v=seq(0,150,10),lty="dotted")

0

25

50

75

100

125

150

Time

Grafico la Función de autocorrelación

-0.5

0.0

acf

0.5

1.0

acf=ARMAacf(ar=c(0.8,-0.6),ma=0,50)

plot(acf,type="h",xlab="lag")

abline(h=0)

0

10

20

30

40

50

lag

25

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Cálculo de los primeros 50 ψ

ARMAtoMA(ar=c(0.8,-0.6),ma=0,50)

[1]

[6]

[11]

[16]

[21]

[26]

[31]

[36]

[41]

[46]

8.000000e-01

1.997440e-01

-1.593131e-02

-1.922306e-02

-3.214780e-03

7.499849e-04

4.237378e-04

3.985274e-05

-2.371677e-05

-8.593650e-06

4.000000e-02 -4.480000e-01 -3.824000e-01 -3.712000e-02

1.820672e-01 2.580736e-02 -8.859443e-02 -8.635996e-02

3.907093e-02 4.081553e-02 9.209866e-03 -1.712142e-02

-5.105593e-03 7.449361e-03 9.022845e-03 2.748659e-03

-4.221019e-03 -1.447947e-03 1.374254e-03 1.968171e-03

-5.809148e-04 -9.147228e-04 -3.832294e-04 2.422502e-04

1.936401e-04 -9.933059e-05 -1.956485e-04 -9.692047e-05

9.003448e-05 4.811594e-05 -1.552794e-05 -4.129191e-05

5.801733e-06 1.887145e-05 1.161612e-05 -2.029974e-06

-5.656935e-06 6.306415e-07 3.898674e-06 2.740555e-06

Gráfico de los primeros 50 ψ

0.6

0.4

0.2

0.0

-0.2

-0.4

ARMAtoMA(ar = c(0.8, -0.6), ma = 0, 50)

0.8

plot(ARMAtoMA(ar=c(0.8,-0.6),ma=0,50),type="l")

abline(h=0)

0

10

20

30

40

50

Index

2. Raíces complejas

set.seed(5)

ar2=arima.sim(list(order=c(2,0,0),ar=c(1.5,-0.75)),n=150)

plot.ts(ar2,axes=F);box();axis(2)

axis(1,seq(0,150,25))

abline(v=seq(0,150,10),lty="dotted")

26

0

-4

-2

ar2

2

4

6

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

0

25

50

75

100

125

150

Time

Grafico la Función de autocorrelación

-0.4

-0.2

0.0

0.2

acf

0.4

0.6

0.8

1.0

acf=ARMAacf(ar=c(1.5,-0.75),ma=0,50)

plot(acf,type="h",xlab="lag")

abline(h=0)

0

10

20

30

40

50

lag

Cálculo de los primeros 50 ψ

ARMAtoMA(ar=c(1.5,-0.75),ma=0,50)

Gráfico de los primeros 50 ψ

plot(ARMAtoMA(ar=c(1.5,-0.75),ma=0,50),type="l")

27

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

1.0

0.5

0.0

-0.5

ARMAtoMA(ar = c(1.5, -0.75), ma = 0, 50)

1.5

abline(h=0)

0

10

20

30

40

50

Index

3. Raíces reales y distintas

0.0

0.2

0.4

acf

0.6

0.8

1.0

set.seed(25)

ar2=arima.sim(list(order=c(2,0,0),ar=c(0.75,-0.125)),n=150)

plot.ts(ar2,axes=F);box();axis(2)

axis(1,seq(0,150,25))

abline(v=seq(0,150,10),lty="dotted")

acf=ARMAacf(ar=c(0.75,-0.125),ma=0,50)

plot(acf,type="h",xlab="lag")

abline(h=0)

0

10

20

30

40

50

lag

Cálculo de los primeros 50 ψ

ARMAtoMA(ar=c(0.75,-0.125),ma=0,50)

28

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

Gráfico de los primeros 50 ψ

0.6

0.4

0.2

0.0

ARMAtoMA(ar = c(0.75, -0.125), ma = 0, 50)

plot(ARMAtoMA(ar=c(0.75,-0.125),ma=0,50),type="l")

abline(h=0)

0

10

20

30

40

50

Index

Observación 1: Los ψ k se irán a 0 en forma sinusoidal (raíces complejas) o lo harán

como combinación lineal de términos exponenciales.

Observación 2: Condición de estacionariedad

Para que X t sea una serie estacionaria, necesitamos que los momentos no dependan de

t.

∞

∞

k =0

k =0

X t = ∑ψ k ε t −k ; E ( X t ) = 0; V ( X t ) = σ 2 ∑ψ k2 , ambos momentos son independientes de

t. Además la V ( X t ) debe ser finita. Entonces habrá que exigir que

∞

∑ψ

k =0

2

k

<∞.

∞

1

1

< ∞ ⇒ ∑ψ k2 < ∞ y además ψk ≤ c1 k + c 2 k

k =0

k =0

m1

m2

para el caso de 2 raíces reales y distintas, etc.

∞

∞

∞

COV ( X t X t + s ) = E ∑ψ k ε t −k ∑ψ i ε t + s −i = σ 2 {ψ 0ψ s + ψ 1ψ s +1 + ... } = σ 2 ∑ψ kψ k + s = γ s

i =0

k =0

k =0

no depende de t y además es finita.

Estas son las condiciones que deben cumplir la esperanza, varianza y autocovarianzas

∞

Se puede demostrar que si

∑ψ

k

para que un proceso sea estacionario.

29

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

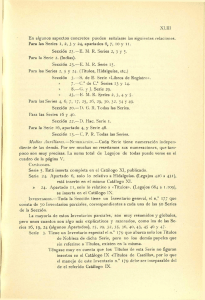

Observación 3: Condición de estacionariedad sobre φ1 y φ 2

Para que las raíces sean mayores que 1 en módulo,

− φ 1 ± φ1 + 4φ 2

2φ 2

> 1 , debe

φ 2 + φ1 < 1

cumplirse que: φ 2 − φ 1 < 1

φ <1

2

Y esto se puede graficar:

φ2

2

φ2-φ1=1

1

φ2+φ1=1

0

-3

-2

-1

Raíces0Complejas1

2

φ1

3

-1

-2

4φ2+φ12=1

Para que las raíces sean complejas, φ12 + 4φ 2 < 0 . Además las desigualdades son

estrictas, el borde no entra.

Cálculo de los γ k

Los γ k por definición se calculan como la Covarianza entre X t y X t −k . Pero si

sabemos que el proceso AR(2) es estacionario, una forma más simple es:

X t = φ 1 X t −1 + φ 2 X t − 2 + ε t

(i ) E ( X t ) = µ = φ 1 µ + φ 2 µ ⇒ µ = 0

Multiplicamos ahora el proceso por X t , y tomamos esperanza a ambos lados de la

igualdad:

E ( X t X t ) = φ 1 E ( X t −1 X t ) + φ 2 E ( X t − 2 X t ) + E (ε t X t )

γ 0 = φ 1γ 1 + φ 2 γ 2 + σ 2

multiplicando el proceso por X t −1 y tomando esperanza,

γ 1 = φ1γ 0 + φ 2 γ 1 + 0

multiplicando el proceso por X t −2 y tomando esperanza,

γ 2 = φ 1γ 1 + φ 2 γ 0

y en general,

30

Notas del Curso de Series Temporales I. Licenciatura de estadística. Facultad de

Ciencias Económicas y Administración

γ k = φ1γ k −1 + φ 2 γ k − 2 ∀k > 1 ,

es decir, γ k satisface la misma ecuación en diferencias que el proceso X t :

(1 − φ L − φ L )γ

= 0 ∀k > 1 . Las que serán diferentes serán las condiciones iniciales,

las cuales obtendremos a partir de γ 0 , γ 1 y γ 2 .

2

1

1

− φ1

−φ

2

2

− φ1

1

k

− φ 2 γ 0 σ 2

− φ 1 γ 1 = 0

1 γ 2 0

− φ1

Si dividimos en la definición de la ecuación diferencial por γ 0

(1 − φ L − φ L )ρ

tenemos:

= 0 ∀k > 1

A través de los dos ejemplos, tenemos dos modelos para mostrar autocorrelación. Uno

donde los gammas tienden a 0 en forma oscilante, que es el caso de raíces complejas, y

otro donde la evolución hacia cero será una combinación lineal de dos exponenciales.

2

1

2

k

31