Frecuencias - Ruben Jose Rodriguez

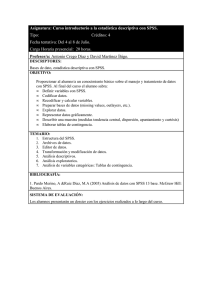

Anuncio