ESTIMACIÓN DEL RIESGO DE LIQUIDEZ UTILIZANDO TEORÍA DE

Anuncio

ESTIMACIÓN DEL RIESGO DE LIQUIDEZ UTILIZANDO

TEORÍA DE LA MEDIDA “FUZZY”.

María Teresa Casparri1 – Sebastián Alberto Rey2 – Javier Ignacio García Fronti3

UNIVERSIDAD DE BUENOS AIRES

FACULTAD DE CIENCIAS ECONÓMICAS

CENTRO DE INVESTIGACIÓN EN MÉTODOS CUANTITATIVOS APLICADOS A LA

ECONOMÍA Y LA GESTIÓN

Agradecimientos: El presente trabajo se encuentra dentro del programa de investigación

UBACyT E031 “Modelo para el Análisis y Calificación de Riesgos en el Mercado Argentino” y

UBACyT E404 “Calificación y evaluación del riesgo financiero en entidades bancarias privadas

argentinas” desarrollados en el Centro de Investigación en Métodos Cuantitativos Aplicados a la

Economía y la Gestión, perteneciente a la Facultad de Ciencias Económicas de la Universidad

de Buenos Aires.

Javier García Fronti agradece el apoyo financiero del Programa de investigación “Moral Hazard

and Financial Institutions” (ESRC Grant Nº R000239216). Universidad de Warwick. Reino

Unido.

1

casparri@econ.uba.ar

2

rey@econ.uba.ar

3

fronti@econ.uba.ar

Resumen

En el área de análisis del riesgo de la cartera de inversiones, el presente trabajo desarrolla y

aplica un modelo de Value-at-Risk [Jorion, “Value at Risk”, 2001. New York] que contempla no

solo el riesgo de variación de precios, sino también posibles problemas de liquidez en el

momento de ejercicio. Dado que la liquidez del mercado en un horizonte futuro es incierta, se

utiliza la Teoría de la Medida “Fuzzy” [Wang y Klir, “Fuzzy Measure Theory”, 1992. New York].

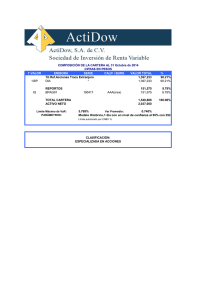

Se aplica la metodología tradicional y la del presente trabajo a una cartera compuesta por

acciones de la empresa Repsol-YPF, comparando los resultados arrojados por ambos

procedimientos.

Abstract

This paper develops and applies a Value at Risk model [Jorion, “Value at Risk”, 2001. New York]

that takes into account not only the market risk, it considers potential liquidity problems at the

exercise moment too. Due to the uncertanty about the liquidity market in a future horizont, the

Fuzzy Measure Theory [Wang y Klir, “Fuzzy Measure Theory”, 1992. New York] is used. The

clasic methodology and this one are applied to a portfolio compunded by Repsol-YPF stocks,

comparing the results of both proceedings.

c4

G2

1. Introducción.

Uno de los temas de mayor relevancia en el tratamiento de los riesgos asociados a las

inversiones mantenidas por las entidades financieras, es el de la determinación del capital a

inmovilizar para sustentar su solvencia y liquidez, en el momento en el que dicha entidad deba

honrar sus compromisos. Para que este capital sea el adecuado es fundamental realizar un

análisis del riesgo de la cartera de inversiones de la entidad en cuestión.

Una cartera compuesta por activos financieros tiene un riesgo de mercado determinado,

el cual está directamente relacionado con su exposición a las fluctuaciones de los precios de los

activos que la componen. Para tomar una decisión, con el objetivo de hacer frente a este tipo de

riegos, es necesario contar con alguna clase de medida, capaz de cuantificar las potenciales

pérdidas derivadas de dicha exposición.

El Value-at-Risk 4 clásico es una medida que cuantifica el riesgo de mercado de una

inversión. Éste mide la pérdida máxima probable que la misma puede sufrir durante un período

de tiempo y bajo un nivel de significatividad determinado. De esto puede concluirse que dicha

medida cuantifica al riesgo de mercado en forma pura o aislada y, por lo tanto, no tiene en

cuenta ciertas consideraciones. Si se utiliza exclusivamente al Value-at-Risk, para determinar

una cuantía de capital a inmovilizar por una entidad financiera, a los efectos de hacer frente a

sus compromisos con un determinado grado de confianza, no se estarían teniendo en cuenta

las consecuencias de la liquidación total o parcial de la cartera, en el momento en que los

compromisos de la entidad deban ser honrados. La consideración de las consecuencias

mencionadas es vital, debido a que la cantidad de activos a colocar, en un determinado

momento del tiempo, puede tener una influencia decisiva sobre el precio al cual la transacción

tendrá lugar. Esto se dará en mayor o menor medida, en relación con la capacidad que tenga el

mercado de absorber los bienes a liquidar por parte de la entidad. En los casos en los que el

mercado tenga alguna deficiencia en cuanto a esta capacidad, la entidad tendrá problemas de

liquidez para afrontar sus compromisos.

El principal inconveniente que surge, al tratar con la capacidad de absorción de activos

por parte del mercado en un momento futuro, es el grado de incertidumbre al que está sujeta la

misma en el momento de la valuación. El objetivo del presente trabajo es el de presentar un

modelo que tenga en cuenta, conjuntamente, tanto el riesgo de mercado de la cartera, como el

riesgo de liquidez de la entidad en cuestión, para poder determinar cuál es el capital que se

debe inmovilizar, a los efectos de hacer frente a sus compromisos en las situaciones en las que

estos problemas se hagan presentes.

Existen dos herramientas fundamentales para el desarrollo del presente trabajo: La

Teoría de la Medida Fuzzy y la Teoría de los Valores Extremos. Ambas se enunciarán a

continuación, de forma esquemática.

4

Puede encontrarse un análisis más extenso de este tema en Jorion, “Value at Risk”, 2001. New York

1.2. Teoría de la Medida “Fuzzy”.

La teoría de Medida Fuzzy5 es una generalización de la teoría de la Medida Clásica. En

ésta, se suprime el supuesto de aditividad y se lo reemplaza por dos supuestos más débiles:

monotonicidad y semicontinuidad.

En el caso en el que se conozca con certeza la función de distribución de

probabilidades, se dice que se está frente a situaciones de riesgo. En caso contrario, el riesgo

de transforma en incertidumbre. Para esto, se define un conjunto de medidas:

1 − g λ (v ) =

FV ( v ).(1 + λ )

,

1 + λ . FV ( v )

donde λ ∈ [ 0 , ∞ ) es un indicador de incertidumbre. Dado un λ , existe una relación biunívoca

entre una medida y cada función de distribución de probabilidad. Asociado a cada valor de λ ,

existe otro valor λ * = − 1 /(1 + λ ) (con λ * ∈ [ − 1, 0 ) ) tal que se define un conjunto de

funciones de distribución de probabilidades:

Γ ( F , λ ) = {P :1 − g λ * ( v ) ≤ FV ( v ) ≤ 1 − g λ ( v )}

Lo importante, es que este conjunto acota los valores de las posibles distribuciones

frente a los casos de incertidumbre y propone intervalos de probabilidad.

Cabe aclarar que, frente a situaciones de riesgo puro, el conjunto anteriormente

mencionado queda definido únicamente, por la función distribución de probabilidades conocida.

De esta forma, queda evidenciado que la Teoría de probabilidades clásica es un caso particular

de esta teoría.

1.3. Teoría de los Valores Extremos

Mediante la Teoría de Valores Extremos, se intenta modelar la cola de una

distribución de una variable aleatoria X. Esta Teoría6 determina una distribución de excesos, por

encima de un valor llamado umbral. Dicha distribución está expresada según:

Fu ( y ) = P ( X − u ≤ y / X > u ) .

Uno de los resultados más importantes de esta teoría es un teorema que

enuncia: la distribución del conjunto de valores en exceso del umbral puede ser aproximada por

una función de Pareto, en tanto que el umbral tienda a infinito. La distribución de Pareto tiene la

forma:

5

Para un desarrollo profundo de la Teoría de la Medida “Fuzzy” ver Wang y Klir, “Fuzzy Measure Theory”, 1992.

New York

6

Para una visión más profunda acerca de la Teoría de los Valores Extremos ver Embrechts, Kluppelberg, Micosch

“Modelling Extremal Events for Insurance and Finance”, 1997, Berlin

ξ .( x - u)

Gξ ,σ ( x ) = 1- 1 +

σ

− 1/ ξ

Existe un problema en la elección del umbral debido a que, según lo mencionado, para

que la convergencia tenga lugar, éste debe tender a infinito, de tal forma que la distribución de

los excesos tienda en a una distribución de Pareto. El inconveniente radica en que si se elige un

umbral muy elevado, es posible que los datos para realizar la estimación de los parámetros

sean escasos. De esto se desprende, que existe un trade-off entre el cumplimiento de las

condiciones para la convergencia y el tamaño de la muestra para realizar la estimación. Es

difícil encontrar el equilibrio, y no existe un método objetivo para la determinación de dicho

valor.

2. Estimación del riesgo de liquidez. Aplicación a una cartera compuesta por acciones de

Repsol-YPF.

El objetivo principal, de aquí en adelante, es el de incluir el riesgo de liquidez al que está

sujeto una entidad financiera. Para ello, se describirá paso a paso la metodología utilizada,

comenzando por un análisis clásico e introduciendo conceptos que hagan que éste se

aproxime, de una forma más apropiada, a la realidad de los mercados financieros. A los fines

prácticos de la descripción del procedimiento, cada paso estará acompañado por su aplicación,

a un caso proveniente del mercado financiero argentino. Para ello, se considera una cartera

compuesta por una determinada cantidad de un activo financiero. Obviamente, la misma está

sujeta, durante un período de exposición determinado, a un riesgo de fluctuación del precio del

activo que la compone. En adición, existe un riesgo relacionado con la liquidación de los activos

que componen la inversión. En función de este último riesgo, la entidad enfrentará,

eventualmente, problemas de liquidez.

De esta forma, se analiza una cartera compuesta por una inversión en la acción “RepsolYPF”, activo cotizado en el mercado financiero argentino. La cantidad de unidades monetarias

de dicha colocación, en principio, se considerará unitaria, pero luego se observarán las

consecuencias de su incremento. Esto no es trivial, debido a que dicho incremento afecta, en

función de las circunstancias, a la cantidad de activos a liquidar, teniendo esta última una

influencia determinante en la capacidad de absorción del mercado y en el precio al cual la

transacción tendrá lugar.

A los fines de la aplicación, se considera que el período de exposición para la cartera

analizada, es de un día. Esto significa que, una vez transcurrido dicho plazo, la entidad planea

cancelar parte de sus compromisos con terceros.

En la primera sección del presente apartado, se desarrolla el análisis y descripción de

los datos utilizados. Luego, en la segunda y tercera sección se realizan, respectivamente,

ajustamientos paramétricos bajo distribución Normal y bajo una distribución derivada de la

Teoría de los Valores Extremos (distribución de Pareto). En cuarto lugar, se determina el Valueat-Risk clásico para la inversión considerada y, por último, se amplía el análisis mediante la

utilización de la Teoría de la Medida “Fuzzy”, incluyendo el riesgo de liquidez de la entidad

considerada.

2.1. Descripción y análisis de la serie utilizada.

En esta sección, se presenta el punto de partida de la estimación a realizar. Este punto

de partida se concentra en el análisis de la serie del precio de la acción considerada,

{S t } (t =1, 2,..., n ) . La serie de datos a utilizar constituye una muestra que posee n

elementos. Para el caso analizado, se tienen en cuenta las cotizaciones al cierre de la acción

“Repsol-YPF”, durante un plazo que va desde el 8 de Junio de 2001 hasta el 9 de Junio de

2003. De esta manera, la muestra está compuesta por 497 datos, los cuales pueden observarse

en el gráfico 2.1.

Repsol YPF

30

25

20

15

10

5

08/06/2003

08/05/2003

08/04/2003

08/03/2003

08/02/2003

08/01/2003

08/12/2002

08/11/2002

08/10/2002

08/09/2002

08/08/2002

08/07/2002

08/06/2002

08/05/2002

08/04/2002

08/03/2002

08/02/2002

08/01/2002

08/12/2001

08/11/2001

08/10/2001

08/09/2001

08/08/2001

08/07/2001

08/06/2001

0

Gráfico 2.1. Serie de cotizaciones diarias al cierre de Repsol-YPF.

Desde 08/06/2001 hasta 09/06/2003.

En un principio, se encuentra la etapa del procesamiento de los datos, de manera que

puedan adaptarse al objetivo del análisis. Debido a que este objetivo es cuantificar una

potencial pérdida, se transforma la serie de las cotizaciones en una serie de pérdidas relativas

(o rendimientos negativos), {L t } , sufridas en la finalización de cada período de exposición.

Vale la pena realizar dos aclaraciones, en cuanto a esta nueva serie generada. En

principio, podrá observarse que determinados componentes de la misma tomarán valores

negativos. Dichos valores deben ser interpretados como ganancias (rendimientos positivos). Por

otro lado, la sucesión de cada componente de esta nueva serie es representativa de pérdidas

(ganancias) parciales. El hecho de que no sean consideradas como pérdidas totales, se debe a

que al ser calculadas con los precios del mercado generados por la serie original, no tienen en

cuenta el precio real al cual se habría negociado la cartera, en el caso en el que hubiese sido

realmente liquidada. Esto es muy importante, y brinda una pauta de los errores que pueden

cometerse al utilizar exclusivamente un análisis del riesgo de mercado de la inversión.

Las pérdidas relativas quedan definidas como:

L

t

= L im −

∆t→ 0

S

t+∆t

S

−S

t

t

S t+∆t

= − L im ln

S t

∆t→ 0

,

donde se considera que ∆ t , es la proporción que representa el plazo de exposición sobre el

total de un año. Al utilizar las propiedades que aporta el límite de la función de pérdida relativa,

se está asumiendo que dicha proporción, ∆ t , tiende a cero. En el caso analizado, debido a que

el período de exposición es diario y en un año existen aproximadamente 250 días hábiles,

entonces ∆ t =

1

= 0, 004 .

250

Repsol-YPF

Pérdidas Relativas

0,15

0,1

0,05

0

-0,05

-0,1

-0,15

-0,2

Gráfico 2.2. Serie de pérdidas relativas diarias de Repsol-YPF.

Desde 08/06/2001 hasta 09/06/2003.

La serie de las pérdidas relativas sufridas, en el intervalo analizado, por la acción

“Repsol-YPF” puede observarse en el Gráfico 2.2.

Una vez transformada la serie original en una serie más apropiada para el presente

análisis, se busca obtener, basándose en ésta, una función de distribución para la variable

pérdidas relativas, teniendo en cuenta que la transformación de la serie original implica que el

tamaño de la nueva muestra, sea de n − 1 elementos. En el caso analizado, la muestra queda

constituida por 496 elementos. De esta forma, como primera aproximación, se calcula la función

de distribución empírica de la variable L t . Para su determinación, se ordenan los datos de la

serie {L

t

} de forma ascendente. Se asigna un supraíndice a cada elemento de la muestra, de

manera tal que pueda identificarse su nuevo ordenamiento: L

i

t

z

>L

j

tw

⇔ i > j , con

j , i = 1, 2,..., n − 1 y j ≠ i . A partir de aquí, para evitar confusiones, se omitirá el subíndice que

representa el orden de la serie original.

De esta forma, se establece una función que asigna un valor de probabilidad acumulada a cada

elemento de la nueva muestra. Esta función queda definida como:

Fn −1 (L

i

)=

i

n −1

( i = 1,

2 , ..., n − 1

).

Debido a que la variable a analizar está definida en un espacio muestral más amplio que

la variable sujeta a la muestra, se construye una función de distribución empírica ampliada, que

incluye todo el espacio muestral relevante. Para su construcción, se asume que la densidad es

uniforme entre dos elementos definidos por la muestra. Así, la función de distribución empírica

ampliada, queda expresada de la siguiente manera:

F

*

n −1

(L )

( L − L M IN )

1

( n − 1 ) . ( L − L M IN )

L − Li )

(

1

=

. i +

( Li + 1 − Li )

n − 1

1

si L

M IN

≤ L < L1

(c o n

s i Li ≤ L < Li + 1

i = 1, 2 , ... n − 2 )

,

s i L = Ln − 1

Donde, respectivamente, L MIN y Ln −1 son el mínimo y máximo valor que la variable

puede tomar.

2.2. Ajuste paramétrico mediante el uso de la distribución Normal.

En la sección anterior, se ha obtenido una función de distribución empírica determinada

por los datos analizados. Para alcanzar una comodidad analítica, acerca del comportamiento de

la distribución de la variable L , el siguiente paso es encontrar una función de distribución

paramétrica que se ajuste de la mejor forma posible a ésta. Cabe destacar que al representar

fenómenos fácticos mediante el uso de funciones de distribución analíticas, existe una serie de

errores que pueden cometerse. Muchos de estos errores están relacionados con la utilización

de una familia de distribución paramétrica que no es adecuada para explicar el comportamiento

de la variable en cuestión. Por lo tanto, es de vital importancia prestar cautelosa atención a la

selección de una función que garantice un razonable ajuste, de manera que los posibles errores

que puedan cometerse queden reducidos al máximo.

Desde un punto de vista clásico, el criterio de selección de la función de distribución se realiza

en base a tres supuestos acerca del comportamiento de los mercados financieros. El primer

supuesto se basa en que las sucesivas variaciones de los precios son estocásticamente

independientes unas de otras. En segundo lugar, se asume que las variables del proceso que

rige la variación del precio de un activo se generan sólo cuando se produce una modificación en

el conjunto de información, y que la incorporación de nueva información en dicho conjunto es

continua. Por último, que la distribución de las variables del proceso se mantiene constante a lo

largo del tiempo.

Aceptando que las variaciones en el precio de un activo constituye la suma de una gran

cantidad de variables aleatorias independientes (las reacciones de los operadores frente a la

incorporación de nueva información), y recurriendo al Teorema Central de Límite, la función de

distribución de la variable L tiende a una función de distribución Normal definida por:

N o rm al

F L (x

x

)= ∫

−∞

donde − ∞ < x < ∞ .

1

.e

2 .π .σ

−

1 y−µ

.

2 σ

2

dy ,

Asumiendo una función de esta forma, se realiza la estimación de los parámetros µ y

σ . Para dicha estimación, se utiliza el método de Máxima Verosimilitud, encontrando los

valores de los parámetros que hacen mínima a la función:

N o rm al

l ( µ ,σ

2

L

) = − n 2− 1 . ln ( 2 . π ) −

n −1

. ln (σ

2

n −1

2

) − 2 .1σ . ∑ ( L

2

i

−µ

i =1

)

2

.

Los parámetros estimados se observan en el Cuadro 2.1. y el ajuste de la distribución

Normal, bajo esos parámetros, respecto de la distribución Empírica, se observa en el Gráfico

2.3.

µ

σ

-0,00041368

0,02704855

Cuadro 2.1. Parámetros estimados para la función de distribución Normal.

F (L)

1

0,9

0,8

0,7

0,6

0,5

0,4

0,3

0,2

0,1

0

L

D istribución Em pírica

D istribución N orm al

Gráfico 2.3. Ajuste de la distribución Normal respecto de la distribución Empírica.

2.3. Contrastación del supuesto de normalidad con la realidad del mercado.

Existe un inconveniente en cuanto la utilización de la distribución normal y es que, en la

realidad, las series financieras presentan características que divergen de los resultados

obtenidos bajo esta hipótesis. La realidad del mercado muestra, entre otras cosas, que los

valores alejados de la media acumulan mayor probabilidad que lo que acumula la distribución

Normal, es decir, estos valores tienen una mayor probabilidad de ocurrencia de la que les

asigna dicha distribución. Este hecho se ve agravado en las series financieras provenientes de

mercados financieros emergentes, donde el papel que juegan los riesgos extremos es mucho

mayor. Este fenómeno puede verse reflejado, en relación a la acción analizada, mediante la

observación de un gráfico como el QQ-Plot (el Gráfico 2.4) en el que se contrastan los

percentiles de un ajuste paramétrico (distribución Normal) con los percentiles de la función de

distribución empírica. Dicho gráfico está determinado por los pares ordenados

{L

i

;

N orm a l

(

F L− 1 Fn − 1 ( L

i

) ) } (con

i = 1, 2 , ..., n − 1 ). En el caso en el que la función de

distribución paramétrica se ajustara de forma adecuada a la función empírica, el gráfico estaría

determinado por una recta de 45º grados. Puede observarse la forma de “S” de la curva, propia

de las series financieras, reflejando las dificultades que representa el uso de la distribución

Normal para la explicación de estos fenómenos.

F -1[F n-1(L i)]

0,1

0,08

0,06

0,04

0,02

0

-0,15

-0,1

-0,05

0

0,05

0,1

0,15

-0,02

-0,04

-0,06

-0,08

-0,1

Li

Gráfico 2.4. QQ-Plot. Contraste entre los percentiles de un ajuste Normal

con los de una función de distribución empírica.

2.3. Ajuste paramétrico mediante de la Teoría de los Valores Extremos.

Debido a las imprecisiones que la utilización de la distribución Normal representa, es

imperante la necesidad de una búsqueda alternativa que permita obtener un mejor resultado,

minimizando así, los errores que puedan cometerse al tomar decisiones sobre la base de un

análisis alejado de la realidad. Por todo esto, se encuentra una alternativa en el uso de la Teoría

de los Valores Extremos. Unos de los principales resultados de esta Teoría se ve condensado

en el Teorema enunciado en la introducción del trabajo. De esta forma, se debe determinar el

umbral u a partir del cual, los excesos de los valores extremos se ajustan a una distribución de

Pareto. Dicho umbral se identifica mediante técnicas derivadas de esta Teoría. Para el caso

analizado, el umbral seleccionado es 0,01.

De esta manera, se estiman, por Máxima Verosimilitud, los parámetros de la función de

distribución de Pareto. Los mismos son aquellos que hacen que la función:

E .V .T .

l ( ξ ,σ

L

) = − ( n − 1 ). ln (ξ ) +

( n − 1 ).

σ 1 + ξ n −1 ξ . L i − σ

1

. ln −

.∑

ξ

ξ

ξ ξ i =1

sea mínima. Los parámetros resultantes de la aplicación del método utilizado pueden verse en

el Cuadro 2.2, y el ajuste proporcionado por éstos, se observa en el Gráfico 2.5.

σ

ξ

0,01880347

1,1465E-07

Cuadro 2.2. Parámetros estimados para la función de Pareto.

1

0,9

0,8

0,7

0,6

0,5

0,4

0,3

0,2

0,1

0,12

0,11

0,1

0,11

0,1

0,09

0,09

0,08

0,07

0,07

0,06

0,06

0,05

0,05

0,04

0,03

0,03

0,02

0,02

0,01

0

0,01

0

Distribución Empírica

Distribución de Pareto

Gráfico 2.5. Ajuste de la distribución de Pareto respecto de la distribución Empírica.

Excesos respecto del umbral.

2.4. Cálculo del Value-at-Risk clásico.

Una vez obtenidos los ajustes mediante ambas distribuciones, se procede al cálculo del

Value-at-Risk de la cartera analizada. Como ya se ha mencionado, el Value-at-Risk (VaR) mide

la pérdida parcial máxima probable a la que está sujeta la cartera durante un período de

exposición y bajo un nivel de significatividad. Por lo tanto, éste se determina de la siguiente

forma: P r [ L ≤ V a R ] = α ,donde α es el grado de significatividad del VaR.

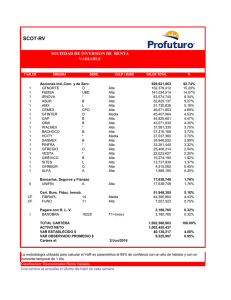

Para el caso de la cartera analizada, en el Gráfico 2.6, pueden verse las diferencias

entre

V a R (calculado bajo distribución Normal) y E V T V a R (calculado bajo la Teoría de

los Valores Extremos) para distintos valores de α . El Cuadro 2.3 resume los valores más

significativos de dicho análisis.

N o rm a l

En el Gráfico, puede verse que ambos Value-at-Risk se asemejan para altos valores de

α . Esto se debe a que el supuesto de normalidad, proporciona una buena aproximación de la

distribución de la variable L para los valores cercanos a la media. En contraste, puede

apreciarse la divergencia entre los Value-at-Risk calculados para valores de α más pequeños.

Este hecho refleja la subestimación del riesgo de mercado de la cartera proporcionada por el

ajuste, bajo la hipótesis de normalidad.

α

EVT

0,05

0,04

0,03

0,02

0,01

Cuadro 2.3.

N o rm a l

VaR

0,042410233

0,046606107

0,052015529

0,059639682

0,072673258

VaR y

EVT

N o rm a l

VaR

0,044077218

0,046939823

0,05045903

0,055137208

0,062510628

V a R para distintos valores de α .

0,14

0,12

0,1

0,08

0,06

0,04

0,02

0

0,05 0,05 0,04 0,04 0,04 0,04 0,03 0,03 0,03 0,02 0,02 0,02 0,01 0,01 0,01

0

0

VaR (EVT)

VaR (Normal)

Gráfico 2.6.

N o rm a l

VaR y

EVT

V a R para distintos valores de α .

2.5. Cálculo de Value-at-Risk considerando riesgo de liquidez.

Hasta aquí se ha realizado un análisis de los riesgos de una cartera, sin tener en cuenta

las consecuencias que implica la liquidación de la misma. La inclusión de la liquidación en el

análisis es muy importante, debido a que como consecuencia de la misma, una entidad

financiera puede enfrentar problemas de liquidez para afrontar sus compromisos. Cabe

destacar, que debido a que la cartera considerada hasta el momento era una inversión unitaria,

la inclusión del riesgo de liquidez no tenía demasiado sentido. La pregunta ahora es: ¿cómo

ampliar el modelo para que se considere el riesgo de liquidez de la entidad, cuando la cantidad

de activos que componen la cartera es significativa? Debido a que existe incertidumbre respecto

de la capacidad de absorción de los bienes a liquidar por parte del mercado, en el momento de

la potencial liquidación, para contestar la pregunta planteada deben ser tenidas en cuenta

técnicas que permitan modelizar dicha incertidumbre. Por este motivo, se hace uso de la Teoría

de la Medida “Fuzzy”.

De esta manera, se considerará que cada evento ya no tendrá una única probabilidad de

ocurrencia, sino que a cada uno se le asignará un intervalo de probabilidades. Así, al liquidarse

la cartera en cuestión, la realización de cada pérdida determinada, x , estará sujeta a un

conjunto de distribuciones de probabilidades:

Γ ( FL , λ ) =

{P ( x ) :1 −

g λ * ( x ) ≤ F L ( x ) ≤ 1 − g λ ( x )} ,

donde λ ∈ [ 0 , ∞ ) , es un parámetro de incertidumbre, y donde λ * = − 1 /(1 + λ ) (con

λ * ∈ [ − 1, 0 ) ) y:

1 − gλ (x) =

F L ( x ).(1 + λ )

.

1 + λ .F L ( x )

Por todo esto, dado un grado de significatividad, el Value-at-Risk, V a R K / S ,

considerando valuación de riesgos de mercado y de liquidez, para una inversión

0

compuesta por K unidades monetarias, es decir, por K / S 0 unidades del activo, ya

no será un valor determinado sino que estará contenido en el conjunto:

K

.V a R

V ( F L , λ ) = V a R λK =

S 0

S 0

λ

≤ VaR

λ =0

K

S 0

K

.V a R

S 0

=

λ =0

≤ VaR

λ*

K

S 0

=

K

.V a R

S 0

λ*

donde V a R λ * , V a R λ = 0 y V a R λ satisfacen las siguientes ecuaciones:

∞

α =1 − gλ (VaR λ ) =

∫

VaR λ

F ( x).(1 + λ ) ;

d L

1 + λ . FL ( x)

α =1 − gλ (VaR λ * ) =

∞

∫

VaR λ *

F ( x).(1 + λ *) ;

d L

1 + λ *. FL ( x)

α=

∞

∫

VaR

d FL ( x)

λ =0

Todo esto puede verse reflejado en el Gráfico 2.8. Allí, se visualizan los intervalos de

Value-at-Risk, calculados bajo ambas alternativas, con relación a la cantidad de activos que

posee la cartera. Para ello, se asume un valor de λ =1 . El rol que juega el valor de este

parámetro es crucial en los resultados que arrojará la estimación del riesgo de la cartera.

2000

2500

2000

1500

VaR

VaR l*

1500

V aR

V aR l*

1000

VaR l

V aR l

1000

500

500

0

0

0

93 186 279 372 465 558 651 744 837 930

K/S0

0

107 214 321 428 535 642 749 856 963

K/S0

Gráfico 2.8. Intervalos de Value at Risk.

Distribución Normal (izquierda), distribución derivada de la Teoría de los Valores Extremos

(derecha).

Es destacable el incremento de la amplitud del intervalo del Value-at-Risk, a medida que

aumenta el número de activos que compone la cartera. La razón de este fenómeno radica en el

hecho que, a mayor cantidad de activos a liquidar, mayor incertidumbre existirá en cuanto a

concertar la transacción, al precio que en ese momento esté vigente en el mercado. Es decir,

que la creciente amplitud del intervalo está explicada por la incertidumbre en cuanto a la

capacidad de absorción del mercado, para ese activo, en el momento de finalización del plazo

de exposición.

Una vez determinado el intervalo de Value-at-Risk para una cartera compuesta por una

determinada cantidad del activo, se debe determinar cuál será el valor, dentro del intervalo, que

servirá como sustento para la determinación de la cuantía de capital a inmovilizar. Dada la

incertidumbre acerca de la liquidez de la entidad financiera al momento de honrar sus

compromisos, se propone el mayor valor de VaR (el límite superior del intervalo), de tal forma

que el capital inmovilizado respalde de forma apropiada, la solvencia y liquidez de la entidad en

cuestión.

3. Conclusión.

A lo largo de este trabajo, se ha desarrollado una metodología que considera, en adición

al riesgo de mercado de una inversión, el riesgo de liquidez de una entidad financiera. Estos

riesgos se reflejan en un potencial incumplimiento de las obligaciones asumidas por dicha

entidad. Como se ha observado, la función de distribución a utilizar para representar el riesgo

de mercado de la inversión mantenida, es más apropiada mediante el uso de la Teoría de los

Valores Extremos.

En referencia a la estimación del riesgo de liquidez de la entidad en cuestión, dadas las

condiciones de incertidumbre, puede decirse que la Teoría de la Medida “Fuzzy” representa un

medio a tener en cuenta a la hora de determinar la cantidad de capital a inmovilizar, para

disminuir el impacto de las consecuencias derivadas de este riesgo.

Es muy importante destacar un aspecto que representa un relevante tema de

investigaciones futuras. En el transcurso del trabajo se ha asumido un valor de λ =1 . Deben

buscarse formas de estimación de este parámetro ya que, como se ha mencionado, juega un rol

crucial en los resultados arrojados. De esta manera, una buena estimación permitirá una

eficiente cobertura frente a riesgos de mercado y liquidez.

Bibliografía.

[1] Cherubini and Della Lunga , “Liquidity and credit risk”, 2001. Applied Mathematical Finance 8.

Taylor and Francis Ltd. United Kingdom.

[2] Cherubini , “Fuzzy measures and asset prices: accounting for information ambiguity”, 1997.

Applied Mathematical Finance 4. Chapman and Hall. Millan Italy.

[3] Cherubini and Della Lunga , “Fuzzy Value-at-risk: Acounting for Market Liquidity”, 2001.

Economic Notes byBanca dei Paschi di Siena. Backwell Publishers. Oxford.

[4] Daykin, C.; Pentikäinen, T.; Pesonen, M. “Practical Risk Theory for Actuaries”, 1993.

Chapman and Hall.

[5] Embrechts, Kluppelberg, Micosch “Modelling Extremal Events for Insurance and Finance”,

1997, Berlin.

[6] Hull, J. C. “Options, Futures and Other Derivatives”.2003. Prentice Hall.

[7] Jorion, P. “Value at Risk, 2001. Mc Graw–Hill. New York.

[8] K¨ellezi, E and Gilli, M, “Extreme Value Theory for Tail-Related Risk Measures”, 2000.

Computational Finance 2000 conference.London Business School.

[9] Landro, A.; Gonzáles, M. “El problema de la predicción en el mercado financiero”1997.

Impresos Centro. Buenos Aires.

[10] Younes Bensalah, “Steps in Applying Extreme Value Theory to Finance”. Working Paper.

Document de travail 2000-20

[11] Wang, Z. and Klir, G. “Fuzzy Measure Theory”, 1992. Plenum Press-New

London. New York.

York and