Notas del curso Cadenas de Markov - EMALCA

Anuncio

Notas del curso

Cadenas de Markov: Una introducción

Stella Brassesco

Departamento de Matemáticas, Instituto Venezolano de Investigaciones

Cientı́ficas, Apartado Postal 20632 Caracas 1020–A, Venezuela

sbrasses@ivic.gob.ve

EMALCA– El Salvador

29 de mayo al 9 de Junio de 2011

1

1.

Introducción

Sea {Ω, F, P } un espacio de probabilidad, y denotemos por ω a los elementos de Ω.

Un proceso estocástico es una familia {Xt }t∈T de variables aleatorias indexadas en T , que puede ser un conjunto discreto, por ejemplo {0, 1, 2, · · · },

o continuo, como por ejemplo el intervalo [0, 1] o el conjunto de los números

reales R. Se utilizan como modelos para la evolución del estado de un sistema

cuando la dinámica es de alguna forma aleatoria, o depende de factores que

no se conocen bien. En estos casos se piensa t como el tiempo, y se dice que

X está en el estado a en el tiempo t cuando Xt = a.

Supongamos T = N, y consideremos un proceso {Xi }i∈N . Una trayectoria

de este proceso es la sucesión {Xi (ω)}i∈N , que corresponde a una realización u

observación particular a lo largo del tiempo. Estamos interesados en estudiar

caracterı́sticas de estas trayectorias, tales como

¿ Cuántas veces pasa por un determinado estado antes de un tiempo T

dado?

¿ Cuál es la distribución del máximo del proceso hasta cierto N dado?

¿ Cuánto vale es la esperanza del tiempo que tarda en el proceso en alcanzar

un nivel dado A?

Ejercicio Describa matemáticamente los eventos de las preguntas anteriores,

en términos de un proceso Xn .

2.

El paseo aleatorio

Uno de los procesos más básicos es el paseo aleatorio simple en Z, que

describe la posición de una partı́cula que se mueve en una lı́nea, y en cada

unidad de tiempo da un paso de tamaño 1, o bien a la derecha o bien a la

izquierda, con probabilidad p y 1 − p respectivamente, donde p ∈ (0, 1).

Matemáticamente, Xn se expresa ası́:

Xn = X0 + ξ1 + ξ2 + · · · + ξn

2

(2.1)

donde X0 es la posición inicial, y {ξi }i∈N son variables aleatorias independientes definidas en {Ω, F, P }, y tales que P (ξi = 1) = 1 − P (ξi = −1) = p.

Podemos representar gráficamente los primeros 14 pasos de una trayectoria:

Figura 1: Gráfico de los primeros 14 pasos de un paseo aleatorio simétrico

con posición inicial 2.

En caso de que p = 12 , el paseo se dicesimétrico. Supongamos que X0 = 0.

Podemos calcular EXn = n p − (1 − p) , y V arXn = 4np (1 − p). Más aún,

se puede calcular P (Xn = k), para cada n y k en N. Como cada paso tiene

tamaño 1, es claro que si |k| > n o bien k tiene paridad distinta de la de n,

entonces P (Xn = k) = 0. En los otros casos, Xn = k significa que la partı́cula

da D pasos a la derecha e I pasos a la izquierda, de forma que D − I = k.

Como D + I = n, tenemos que D = n+k

de modo que el evento (Xn = k)

2

n+k

resulta igual al evento (D = 2 ). Pero

n+k

n−k

n+k

n

) = n+k p 2 (1 − p) 2

P (D =

2

2

que corresponde a contar cuantas trayectorias del paseo en [0, n] pueden

dar n+k

pasos a la derecha (y por lo tanto n−k

pasos a la izquierda), y

2

2

n+k

n−k

multiplicarlas por la probabilidad de cada una de ellas, que es p 2 (1−p) 2 .

Hemos demostrado entonces lo siguiente:

Proposición 2.1. Sea Xn un paseo aleatorio en Z, con P (ξi = 1) = p, y

3

X0 = 0. Entonces

n+k

n−k

n

n+k p 2 (1 − p) 2

2

P (Xn = k) =

0

si |k| < n, y si

n y k tienen la misma paridad

en caso contrario

Veamos un ejemplo de aplicación de lo anterior al cálculo de una probabilidad que tiene que ver con la trayectoria completa del paseo hasta un

cierto instante.

Problema 2.2. Supongamos que tenemos un paseo simétrico, con condición

inicial X0 = a > 0, y sea b > a, y n ∈ N ¿ Cuál es la probabilidad de que el

paseo esté en el estado b en el tiempo n, sin haber tocado el 0?

Una interpretación de la situación anterior que es frecuente es la siguiente:

supongamos que un jugador cuya fortuna inicial es a juega un juego justo,

donde si pierde paga 1 y si gana recibe 1, de modo que su fortuna Xn a lo

largo del tiempo describe un paseo simétrico. En este lenguaje, la pregunta

es cuál es la probabilidad de que su fortuna en el tiempo n sea b sin haberse

arruinado antes. Para responderla, observamos

P (Xn = b, Xn−1 6= 0, Xn−2 6= 0 · · · X1 6= 0|X0 = a) =

P (Xn = b|X0 = a) − P (Xn = b, Xj = 0 para algún j ∈ (1, n − 1)|X0 = a)

Ahora bien, usando la proposición anterior, obtenemos

n

P (Xn = b|X0 = a) = P (Xn = b − a|X0 = 0) =

n+b−a

2

2n

Con respecto a la probabilidad de que el paseo llegue a b habiendo visitado

el 0, observamos, como en la siguiente figura, que a cada trayectoria que llega

desde a hasta b tocando el 0 corresponde una trayectoria que llega desde a

al reflejado de b respecto del 0. Como todas las trayectorias hasta n tienen

la misma probabilidad ( 21n ) tenemos que

P (Xn = b, Xj = 0 para algúnj ∈ (1, n − 1)|X0 = a) =

P (Xn = −b|X0 = a) = P (Xn = −b − a|X0 = 0)

4

(2.2)

Figura 2: Trayectoria reflejada en la barrera 0

de modo que finalmente la respuesta al problema es

n

P (Xn = b − a) − P (Xn = −b − a) =

n+b−a

2

2n

n

−

n−b−a

2

2n

La propiedad que nos permitió calcular (2.2) se conoce como principio de

reflexión.

Consideremos ahora un paseo aleatorio Xn . Recordando (2.1) observemos

que, por ejemplo,

P (X4 = 2 | X3 = 1, X2 = 2, X1 = 1, X0 = 0) =

P (X3 + ξ4 = 2 | X3 = 1, X2 = 2, X1 = 1, X0 = 0) = P (X4 = 2 | X3 = 1)

(2.3)

Esta propiedad, extendida a tiempos y estados cualesquiera, se llama

propiedad de Markov.

Ejercicio

1. Considere un paseo aleatorio Xn como en (2.1), con P (ξ1 = 1) = p,

P (ξ1 = −1) = q := (1 − p) y X0 = k ∈ (0, A).

5

Defina uk = P (Xn llegue a 0 antes que aA | X0 = k). (En lenguaje de juego, la probabilidad de que el jugador se arruine antes de

obtener una fortuna A cuando su fortuna inicial es k). Muestre

que, si p 6= q,

(q/p)k − (q/p)A

uk =

1 − (q/p)A

Sug: Verifique que uk satisface la recurrencia uk = p uk+1 + q uk−1

si k ∈ (1, A−1), con las condiciones de contorno u0 = 1 y uA = 0,

y resuelva esta recurrencia.

Calcule vk := P (Xn llegue a A antes que a 0 | X0 = k).

Verifique que uk + vk = 1

Calcule uk y vk en el caso p = 21 .

¿Cuánto vale P Xn ∈ (0, A)∀ n ≥ 0 ?

Suponga p > q. Calcule lı́mA→∞ vk .

3.

Definiciones y propiedades básicas

Definición 3.1. Un proceso Xn a valores en un espacio S satisface la

propiedad de Markov si

P (Xn+1 = j|Xn = i, Xn−1 = in−1 , · · · , X0 = i0 ) = P (Xn+1 = j|Xn = i)

∀n ∈ N, ∀i0 , i1 , · · · in−1 , i, j ∈ S tales que las probabilidades en la igualdad

anterior están definidas.

Un proceso de Markov homogéneo es un proceso de Markov tal que

P (Xn+1 = j|Xn = i) no depende de n.

Una cadena de Markov es un proceso de Markov a tiempo discreto con

espacio de estados S finito o numerable.

***

Consideraremos en lo que sigue cadenas de Markov homogéneas.

***

6

Un análisis como el de (2.3) muestra que el paseo aleatorio es una cadena

de Markov homogénea con espacio de estados Z.

Si Xn es una cadena de Markov homogénea, las probabilidades de transición del estado i al estado j las denotaremos P (i, j) := P (X1 = j|X0 = i).

Se acostumbra acomodarlas en forma matriz

P := {P (i, j)}i,j∈S

Si n es el número de elementos de S, es una matriz de n × n. Si S no es

finito, será una matriz infinita. P se llama matriz de transición asociada a la

cadena de Markov Xn , y es claro que se cumple

X

P (i, j) = 1, y que 0 ≤ P (i, j) ≤ 1 ∀i, j ∈ S

j∈S

Toda matriz con estas propiedades se llama matriz estocástica.

Veremos que esta determina, junto con la condición inicial, la ley de la

cadena {Xn }, y que por otro lado, dadas una condición inicial y una matriz estocástica P, existe una cadena de Markov Xn (es decir, un espacio de

probabilidad {Ω, F, P } donde hay definido un proceso {Xn }n∈N a valores en

S, que satisface la propiedad de Markov), cuya matriz de transición es la P

dada.

Si Xn es una cadena de Markov homogénea en un espacio de estados

S, y ei ∈ S, i = 0, 1, · · · , por la definición de probabilidad condicional y la

propiedad de Markov 3.1 tenemos que, ∀n:

P (Xn = en , Xn−1 = en−1 , Xn−2 = en−2 , · · · , X0 = e0 ) =

P (Xn = en Xn−1 = en−1 , Xn−2 = en−2 , · · · , X0 = e0 )×

P (Xn−1 = en−1 , Xn−2 = en−2 , · · · , X0 = e0 ) =

P (en−1 , en ) P (Xn−1 = en−1 , Xn−2 = en−2 , · · · , X0 = e0 ) = · · ·

n

Y

P (ei , ei−1 ) P (X0 = e0 )

i=1

Observemos que el conjunto de todas las probabilidades como en la primera

lı́nea arriba, para cualesquiera conjuntos de estados, y n ∈ N determina la

distribución de la cadena Xn . Por la última expresión obtenida, tenemos

entonces lo siguiente:

7

Proposición 3.2. La distribución de Xn queda determinada por la matriz

de transición P = {P (i, j)}i,j∈S y la distribución inicial de X0 .

Podemos entonces referirnos a la cadena de Markov con matriz P y condición inicial X0 . Esta condición inicial puede ser una variable aleatoria, o, en

particular, un valor fijo en el espacio S. Supongamos que X0 se distribuye de

manera que P (X0 = i) = µ(i), i ∈ S (lo cual suele denotarse por X0 ∼ µ) En

este caso, escribiremos Pµ cuando se quiera hacer explı́cita la distribución de

la condición inicial:

X

Pµ (Xn = j) =

P (Xn = j|X0 = i)µ(i)

i∈S

Con un ligero abuso de notación, escribimos Pi cuando X0 = i. Análogamente, Eµ y Ei denotarán la esperanza condicional cuando el estado inicial

es µ o i, respectivamente.

De la propiedad de Markov podemos calcular las probabilidades de transición en dos pasos, que denotaremos por P (2) :

P (2) (i, j) := P (X2 = j|X0 = i) =

=

X

X

P (X2 = j, X1 = k|X0 = i)

k∈S

P (X2 = j, X1 = k, X0 = i)/P (X0 = i)

k∈S

=

X

P (X2 = j|X1 = k, X0 = i) P (X1 = k, X0 = i)/P (X0 = i)

k∈S

=

X

P (X2 = j|X1 = k) P (X1 = k|X0 = i) =

X

P (k, j) P (i, k) = P2 (i, j)

k∈S

k∈S

donde P2 (i, j) es la entrada (i, j) de la matriz P elevada al cuadrado. Por

inducción obtenemos facilmente que la probabilidad de transición en n pasos

viene dada por

P (Xn = j|X0 = i) = Pn (i, j),

donde Pn (i, j) es la entrada (i, j) de la n-ésima potencia de la matriz P. A la

matriz Pn se le llama matriz de transición en n pasos. Observe que denotamos

P (n) (i, j) = Pn (i, j).

8

La siguiente proposición muestra como obtener cadenas de Markov por

recurrencia a partir de una

sucesión de variables i.i.d. definidas en un espacio

de probabilidad Ω, F, P . Veremos que, además de resultar de utilidad para

implementar algoritmos de generación con un computador, también engloba

la mayorı́a de los ejemplos a considerar.

Proposición 3.3. Sea {Yn }n≥1 una sucesión de variables aleatorias independientes definidas en cierto espacio Ω, F, P . Sea S un conjunto finito o

numerable, y F : S × R → S una función. Sea X0 una variable aleatoria con

valores en S, independiente de {Yn }n≥1 , y sea Xn definida por recurrencia

ası́:

Xn+1 = F (Xn , Yn+1 )

(3.1)

Entonces Xn es una cadena de Markov homogénea.

Demostración Es claro que la recurrencia planteada genera un proceso a

valores en S. Resta verificar la propiedad de Markov. Tenemos:

P Xn+1 = j|Xn = i, Xn−1 = in−1 , · · · X0 = i0 =

(3.2)

P F (Xn , Yn+1 ) = j|Xn = i, Xn−1 = in−1 , · · · X0 = i0 =

P F (i, Yn+1 ) = j = P F (Xn , Yn+1 ) = j|Xn = i = P Xn+1 = j|Xn = i

Para escribir la tercera igualdad observamos que, iterando la recurrencia,

se concluye que Xn es una función de X0 y de {Yj }nj=1 .

Como P F (i, Yn+1 ) = j no depende de n, tenemos que la cadena de

Markov definida por (3.1) es homogénea.

Antes de ver algunos ejemplos, veamos como se puede aplicar la proposición anterior, mostrando una particular función F y sucesión de variables

aleatorias {Un } tal que Xn+1 = F (Xn , Un+1 ) y de modo que las transiciones

son dadas por P.

Supongamos que S = {1, 2, 3 · · · N }, sean Un i.i.d. uniformes en [0, 1].

Para definir F , definimos una familia de particiones del intervalo [0, 1], como

sigue:

Asociamos con la primera fila de la matriz una partición del intervalo [0, 1]

en N intervalos disjuntos I1,1 , I1,2 , · · · I1,N de longitudes P (1, 1), P (1, 2) · · · P (1, N ).

Análogamente, a la fila j, asociamos una partición del intervalo [0, 1] en N intervalos disjuntos Ij,1 , Ij,2 , · · · Ij,N de tamaños P (j, 1), P (j, 2) · · · P (j, N ). Sea

9

entonces F : S × [0, 1] → S definida por:

X

F (i, x) =

j 1IIi,j (x)

(3.3)

j∈S

Con la receta de la proposición 3.3 tenemos que

Xn+1 = F (Xn , Yn+1 )

(3.4)

es una cadena de Markov, y de (3.2) sigue que

P (Xn+1 = j|Xn = i) = P (F (i, Un+1 ) = j) = P (Un+1 ∈ Ii,j ) = P (i, j)

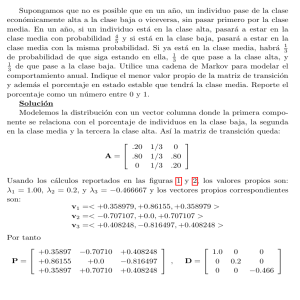

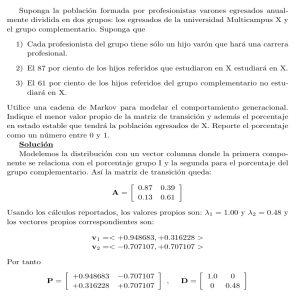

Ejemplo. Consideremos la matriz de transición P dada en la siguiente figura. Un posible conjunto de particiones del intervalo [0, 1] es mostrado a la

derecha. Observe que los intervalos I2,2 , I2,3 I3,1 e I3,4 son vacı́os.

P=

1

8

1

2

1

8

1

4

1

2

0

0

1

2

0

1

5

4

5

0

1

4

1

4

1

4

1

4

I1,1

I1,2

( )[

I2,1

(

(

(

I3,2

I1,3

)[ )[

I2,4

)[

I3,3

)[

I4,1

I1,4

)[

I4,2

)[

I4,3

]

]

]

)[

I4,4

]

Para obtener una realización de la cadena correspondiente en S = {1, 2, 3, 4},

dada la condición inicial X0 , simplemente aplicamos la fórmula (3.4). Por

ejemplo, tomando la primera muestra de uniformes (aproximadas) que aparece

en el listado del Apéndice, en este ejemplo, tomando X0 = 2, obtenemos la

siguiente realización de los primeros 10 pasos: 2, 1, 4, 3, 3, 3, 2, 4, 3, 3, 3.

Comentario 3.4. La función F mostrada arriba no es de ninguna manera

la única posible. Encontraremos más adelante situaciones en que será conveniente escoger otra función F .

10

4.

Algunos ejemplos clásicos

Consideramos primero algunas variaciones del paseo aleatorio.

Paseo aleatorio con barreras

Sean A, B ∈ Z dos valores donde se localiza una barrera. Sea X0 ∈ Z, A <

X0 < B. Xn será entonces la posición de una partı́cula que realiza un paseo

igual que antes, excepto cuando llega a A o a B. En particular tenemos

* Barreras absorbentes Al llegar a A o a B, el paseo queda absorbido por

esos estados, es decir,

p si A < i < B, j = i + 1

q si A < i < B, j = i − 1

P (i, j) = 1 si i = A, j = A

1 si i = B, j = B

0 en todos los otros casos

* Barreras reflejantes Al llegar a A o a B, el paseo es reflejado por esos

estados, es decir,

p si A < i < B, j = i + 1

q si A < i < B, j = i − 1

P (i, j) = 1 si i = A, j = A + 1

1 si i = B, j = B − 1

0 en todos los otros casos

El paseo aleatorio con barreras absorbentes 0 y B suele interpretarse como

la fortuna de un jugador que en cada unidad de tiempo apuesta 1 para

participar en un juego justo, y que se retira o bien porque se arruina ( llega

a 0, o bien alcanza un nivel prefijado B. Por eso se habla de problemas de

ruina para referirse a problemas de llegada a las barreras. En el libro [5] se

puede encontrar un estudio detallado del paseo aleatorio.

Paseo aleatorio simétrico en un grafo Consideremos un grafo conexo

dado, con vértices Vi , 1 = 1, 2, · · · , n y algunas aristas que los unen. El pro11

ceso Xn toma valores en el conjunto de los vértices, y

(

1

si hay una arista entre Vi y Vj

P (Vi , Vj ) = di

0 en todos los otros casos,

donde di es el número de vecinos de i, es decir, el número de vértices conectados por aristas con i.

Este proceso se conoce como modelo para ratones en laberintos.

Modelo de Eherenfest Supongamos que se tienen M bolas numeradas

de 1 a M , que están repartidas en dos recipientes A y B. En cada unidad de

tiempo, se sortea un número al azar entre 1 y M , y la bola con ese número

se cambia de recipiente: si estaba en A se coloca en B, y viceversa. Sea Xn

el número de bolas en el recipiente A.

En este caso, tenemos

P (i, i+1) =

M −i

M

P (i, i−1) =

i

M

y cero en todos los demás casos

Este proceso fue propuesto por P. y T. Eherenfest a comienzos del siglo

XX como un modelo simplificado que pudiera aclarar la aparente contradicción que surgió al tratar de explicar algunos fenómenos fı́sicos (como el comportamiento de un gas en un recipiente cerrado). Por un lado, se esperaba

que el sistema fuese reversible y recurrente, al considerarlo como un sistema

con muchas partı́culas y aplicar las leyes de la fı́sica clásica. Por otro, se

debı́an aplicar las leyes de la termodinámica, que implican convergencia al

equilibrio y decaimiento de la entropı́a. Un análisis detallado de este modelo,

ası́ como de las motivaciones para su formulación puede encontrarse en [7] o

en el trabajo original de los Ehrenfest [4]

Cadenas de nacimiento y muerte Una cadena de nacimiento y muerte

es una cadena Xn con espacio de estados N tal que, para ciertos pi , qi no

negativos, i = 0, 1, 2, · · · ,

P (i, i + 1) = pi

P (i, i − 1) = qi

y cero en todos los demás casos

Xn se puede interpretar como el tamaño de una población donde en cada

unidad de tiempo o bien nace o bien muere un individuo, con probabilidades

pi o qi (que dependen del número i de individuos en ese instante).

12

Castillo de naipes o cadena de nacimiento y desastre El espacio

de estados para este proceso es N, y supongamos dados

α1 , α2 , · · ·

0 < αi < 1.

Las probabilidades de transición son dadas por

P (k, k + 1) = αk ,

P (k, 0) = 1 − αk si k ≥ 1,

P (0, 1) = 1

y cero en los demás casos. En palabras, del estado k el proceso pasa a k + 1

o a 0, con probabilidades αk y 1 − αk , respectivamente. ¿Puede dar una

interpretación para el nombre de este proceso?

Un modelo genético: modelo de Wright–Fisher. Supongamos que

se tiene una población con un número finito fijo 2M de genes, que pueden ser

de tipo a o de tipo A. El tiempo se mide en generaciones, e interesa considerar

el número de genes del tipo A en la n-ésima generación, Xn . Para cada uno de

los 2M genes de la la generación n + 1, se escoge su tipo independientemente

de entre los tipos presentes en la generación n, con probabilidad dada por la

frecuencia relativa de cada tipo, de forma que las probabilidades de transición

son

2M

i j 2M − i 2M −j

P (Xn+1 = j|Xn = i) =

j

2M

2M

En el libro [11] hay varios ejemplos y una motivación para este y otros modelos relacionados con genética de poblaciones, ası́ como una lista de referencias

sobre el tema.

5.

Clasificación de estados y dinámica global

de una cadena de Markov

Una manera de visualizar una cadena de Markov es mediante un grafo

cuyos vértices son los estados de la cadena. Se coloca una flecha del estado i

al estado j si P (i, j) > 0, y no se coloca flecha en los casos en que P (i, j) = 0.

Las probabilidades de transición P (i, j) pueden o no colocarse como etiquetas

sobre las flechas. Por ejemplo, para el paseo aleatorio con 5 estados y barreras

absorbentes, se tiene el siguiente grafo asociado.

13

R

R

R

E3

E4

E5 E1

E2

I

I

I

Aquellas propiedades de la cadena que dependen apenas del grafo sin

etiquetas se dicen topológicas. Veremos algunas de ellas.

Definición 5.1. El estado j de una cadena de Markov Xn se dice accesible

desde el estado i si existe N > 0 tal que P (N ) (i, j) > 0. Si j es accesible

desde i e i es accesible desde j, diremos que i y j se comunican, lo cual se

denota por i ↔ j.

Como P (0) (i, i) = 1, todo estado es accesible desde sı́ mismo. Es fácil ver

que ↔ establece una relación de equivalencia en S, y como tal lo divide en

clases disjuntas que se llaman clases comunicantes.

Definición 5.2. Si sólo hay una clase comunicante, la cadena se dice irreducible.

Definición 5.3. Un conjunto C de estados se dice cerrado si ∀i ∈ S,

X

P (i, j) = 1

j∈C

Ejemplos En el ejemplo del paseo aleatorio con 5 estados y barreras

absorbentes cuyo grafo esta dibujado más arriba, tenemos que {E1 } y {E5 }

constituyen dos clases cerradas, y {E2 , E3 , E4 } constituyen una clase comunicante.

Es fácil ver que en cambio los estados de un paseo aleatorio con barreras reflejantes se comunican todos entre sı́ por lo que esta cadena resulta

irreducible.

Recurrencia y transitoriedad.

Una variable aleatoria importante para el estudio de la dinámica de una

cadena de Markov Xn es el tiempo de llegada al estado i ∈ S,

Ti = ı́nf{n ≥ 1 : Xn = i}

14

Definición 5.4. El estado i se dice recurrente si

Pi (Ti < ∞) = 1

y transitorio si Pi (Ti < ∞) < 1.

Un estado recurrente se dice recurrente positivo si Ei (Ti ) < ∞ y recurrente nulo si Ei (Ti ) = ∞

Proposición 5.5. Sea Xn una cadena de Markov en S, i ∈ S y Ti < ∞

el tiempo de llegada a i. Entonces el proceso {XTi +n }n≥0 es una cadena de

Markov con condición inicial i, independiente de la cadena antes de Ti , XTi ∧n .

Demostración

Claramente XTi +0 = i. Veamos la propiedad de Markov para XTi +n .

P XTi +n+1 = k XTi +n = j, XTi +n−1 = jn−1 , · · · , XTi = i

X P XTi +n+1 = k, XTi +n = j, XTi +n−1 = jn−1 , · · · XTi = i, Ti = r

=

P XTi +n = j, XTi +n−1 = jn−1 , · · · , XTi = i

r≥1

En vista de la propiedad de Markov (observe que Ti = r se puede expresar

en términos de {Xk }k≤r ), el numerador en esta última expresión se puede

escribir como

P Xr+n+1 = k Xr+n = j, Xr+n−1 = jn−1 , · · · XTi = i, Ti = r ×

P XTi +n = j, XTi +n−1 = jn−1 , · · · , Xr = i, Ti = r =

P Xr+n+1 = k Xr+n = j P XTi +n = j, XTi +n−1 = jn−1 , · · · , XTi = i, Ti = r

= P (j, k) P XTi +n = j, XTi +n−1 = jn−1 , · · · , XTi = i, Ti = r ,

y entonces

P XTi +n+1 = k XTi +n = j, XTi +n−1 = jn−1 , · · · , XTi = i = P (j, k)

La verificación de la segunda afirmación sigue de un argumento similar.

Dado i ∈ S, sea r(i) la probabilidad de que el tiempo del primer retorno

al estado i sea finito, y sea N (i) en número de veces que la cadena pasa por

el estado i:

X

N (i) =

1I{Xn =i}

r(i) = Pi Ti < ∞

n≥1

15

Proposición 5.6. Sean Ti y N (i) como arriba. Entonces,

a) Si r(i) < 1 entonces Pi N (i) = ∞ = 0 y E N (i) =

b) Si r(i) = 1 entonces Pi N (i) = ∞ = 1

r(i)

.

1−r(i)

Demostración Con ayuda de la proposición 5.5, no es difı́cil ver que

Pi N (i) = k = r(i)k 1 − r(i)

de modo que si r(i) < 1

X

Pi N (i) = ∞ = 1 −

r(i)k 1 − r(i) = 1 − 1 = 0

y

k≥0

X

E N (i) =

k r(i)k 1 − r(i) =

k≥1

X

d

r(i)

k r(i)k−1 =

r(i) 1 − r(i)

dr(i) k≥1

1 − r(i)

Una forma de verificar recurrencia de un estado es dada por la siguiente

proposición

Proposición 5.7. El estado i es recurrente ⇔

X

P (n) (i, i) = ∞

n≥0

Demostración De la proposición anterior tenemos que el evento N (i) = ∞

tiene probabilidad 0 o 1. Xn es una cadena

con estado inicial i recurrente

⇔ r(i) = 1 ⇔ N (i) = ∞ c.s. ⇔ Ei N (i) = ∞. Pero

X

X

Pi (Xn = i) =

P (n) (i, i)

Ei N (i) =

n≥1

n≥1

También se cumple que todos los estado de una misma clase comunicante

tienen las mismas propiedades de recurrencia. Precisamente

16

Proposición 5.8. Si i ↔ j, entonces o bien ambos estados son recurrentes,

o bien ambos estados son transitorios.

Demostración Sean i, j ∈ S, i ↔ j. Entonces existen M, N tales que

P (M ) (i, j) > 0, P (N ) (j, i) > 0. Para cada k > 0 podemos escribir

P (M +N +k) (i, i) ≥ P (M ) (i, j) P (k) (j, j) P (N ) (j, i)

P (M +N +k) (j, j) ≥ P (N ) (j, i) P (k) (i, i) P (M ) (i, j)

(5.1)

ya que en los lados izquierdos se tienen las probabilidades de retornar al

estado en M + N + k pasos y en la derecha

formas particulares

de hacerlo.

P

P

De estas desigualdades se concluye que n≥0 P (n) (i, i) y n≥0 P (n) (j, j) son o

bien ambas divergentes, o bien ambas convergentes, lo cual por la proposición

5.7 significa ambos estados recurrentes o ambos transitorios.

Dada una cadena de Markov, podemos entonces descomponer el espacio

de estados S = R ∪ T , R el conjunto de los estados recurrentes, y T el de los

estados transitorios. R a su vez puede descomponerse en clases comunicantes

disjuntas y cerradas (según la definición 5.3) R = R1 ∪R2 ∪· · · , y la dinámica

podemos simbolizarla ası́ :

'$ '$ '$

R2

R1

R3

···

&%

&%

&%

I

6

T

Reordenando los estados si es necesario, la matriz de transición luce ası́ :

R1

R2

R3

T

P1

P2

17

O

P3

∗

Si la condición inicial está en alguna de las Ri , entonces la cadena en el

futuro tomará valores solamente en Ri , y podemos considerar la dinámica

restringida a este espacio, con matriz de transición correspondiente siendo el

i-ésimo bloque (Pi en el diagrama anterior). Si el estado inicial es transitorio,

la cadena podrá eventualmente alcanzar R, y llegar a la situación anterior, o

bien quedarse en T para siempre. Esto sólo puede suceder si la cadena tiene

infinitos estados transitorios. (¿Por qué?)

Interesa entonces estudiar la dinámica de cadenas recurrentes e irreducibles.

Ejercicios

1. Muestre que si R es una clase comunicante recurrente, entonces es

cerrada.

2. Encuentre una cadena de Markov que tenga infinitos estados transitorios.

3. Muestre que si i, j son dos estados transitorios, entonces P (n) (i, j) → 0

cuando n → ∞.

4. Considere el paseo simétrico en Z. Diga si es irreducible. Considere el

estado 0. ¿Es recurrente?

5. Considere el paseo asimétrico, y responda las mismas preguntas del

item anterior.

6. Considere la cadena para el modelo genético de la sección 4. Dibuje

el grafo de transiciones correspondiente, y diga cuales son sus clases

comunicantes. ¿ Puede clasificarlas en recurrentes o transitorias?

7. Considere la cadena de Markov del castillo de naipes.

Muestre que todos los estados son recurrentes ⇔

Y

lı́m α1 α2 · · · αn =

αi = 0

n→∞

i≥1

Suponga que todos los estados son recurrentes. Muestre que son

recurrentes nulos ⇔ 1 + α1 α2 + α1 α2 α3 + · · · → ∞

18

6.

Distribución invariante

Definición 6.1. Una distribución de probabilidad µ en S es invariante (o

estacionaria) para una cadena de Markov en S con matriz de transición

P = {P (i, j)} si

X

∀j ∈ S

se cumple que

µ(j) =

µ(i) P (i, j)

(6.1)

i∈S

Observe que µ puede pensarse como un vector µ(i), i ∈ S, cuyas componentes satisfacen

X

µ(i) ≥ 0

y

µ(i) = 1

i∈S

Las ecuaciones (6.1) en notación vectorial, con µ escrito como vector fila

pueden escribirse como

µ = µP

y la definición de distribución invariante es equivalente a decir que µ es un

autovector a izquierda con autovalor 1. Podrı́amos entonces apelar al teorema

de Perron–Frobenius, que garantiza la existencia de un tal autovector, al

menos en el caso de P finita y positiva. (Ver por ejemplo [3]).

Sin embargo, veremos que se puede concluir también la existencia de una

tal distribución, y más aún caracterizarla usando la dinámica de la cadena

de Markov correspondiente a la matriz P.

Una primera propiedad de la distribución invariante es que es en efecto

invariante para la cadena, en el sentido de que si X0 tiene distribución µ,

entonces Xn , tendrá distribución µ para todo n ≥ 0. Veamos

X

Pµ (X2 = j) =

P (x2 = j|X0 = i) µ(i)

i∈S

=

XX

P (X2 = j, X1 = k|X0 = i) µ(i)

i∈S k∈S

=

XX

P (X2 = j|X1 = k, X0 = i) P (X1 = k|X0 = i) µ(i)

i∈S k∈S

=

X

k∈S

P (k, j)

X

P (i, k)µ(i) =

i∈S

X

P (k, j)µ(k) = µ(j)

k∈S

Se ha usado la descomposición del evento inicial según la posición en el primer

paso, la propiedad de Markov y la definición de invariancia. Inductivamente,

19

se obtiene de la misma forma que Pµ (Xn+1 = j) = µ(j). Más aún, para todo

k y conjunto de estados i0 , i1 , · · · ik ,

Pµ (Xn = i0 , Xn+1 = i1 , · · · , Xn+k = ik ) = µ(i0 )P (i0 , i1 )P (i1 , i2 ) · · · P (ik−1 , ik )

no depende de n, y la cadena está en régimen estacionario.

Ejemplo 6.2. Consideremos la cadena con dos estados, cuya matriz de transición es

p

1−p

(6.2)

1−q

q

En este caso, las ecuaciones (6.1) se reducen al sistema de 2 × 2

µ(1) = pµ(1) + (1 − q)µ(2)

µ(2) = (1 − p)µ(1) + qµ(2)

Cuya solución, en caso p 6= 1 o q 6= 1 es

1−q

(1 − p) + (1 − q)

1−p

µ(2) =

(1 − p) + (1 − q)

µ(1) =

En el caso p = q = 1, cualquier distribución de probabilidades µ en S es

invariante.

Ejemplo 6.3. Considere el paseo con barreras absorbentes en

S = {0, 1, 2, 3 · · · , N }

(El grafo para el caso particular N = 4 está dibujado en la sección 5). Definimos δK la distribución que asigna probabilidad 1 al estado K (y por consiguiente, 0 a los otros). Es fácil verificar que δ0 es una distribución invariante,

y también lo son δN y cualquier combinación λδ0 + (1 − λ)δN , λ ∈ [0, 1].

Ejemplo 6.4. Consideremos el paseo aleatorio simétrico simple en Z, y

supongamos que tiene una distribución invariante µ. Esta tiene que satisfacer las ecuaciones: si j ∈ Z

µ(j) =

1

1

µ(j + 1) + µ(j − 1)

2

2

=⇒ µ(j + 1) − µ(j) = µ(j) − µ(j − 1)

20

Como

µ(j + 1) = µ(j + 1) − µ(j) + µ(j) − µ(j − 1) · · · + µ(1) − µ(0) + µ(0)

obtenemos de la recurrencia anterior que

µ(j + 1) = (j + 1) µ(1) − µ(0) + µ(0)

Como µ(j) ∈ [0, 1] ∀j ∈ Z, tiene que ser µ(1) − µ(0) = 0, de modo que

µ(j + 1) = µ(0)

P ∀j, pero entonces no se puede satisfacer la condición de

normalización i∈Z µ(i) = 1, de forma que no existe ninguna distribución

invariante para el paseo simétrico simple en Z.

Ejemplo 6.5. Sea una cadena de nacimiento y muerte con barreras reflejantes en 0 y N , es es decir, S = {0, 1, 2, · · · , N } y probabilidades de transición

P (i, i + 1) = pi , P (i, i − 1) = qi , pi + qi = 1,

0 < pi < 1 si 0 ≤ i ≤ N − 1, p0 = qN = 1

Si π = {πi } es una distribución invariante, por (6.1) tiene que satisfacer

πj = πj−1 pj−1 + πj+1 qj+1 ⇒ πj+1 qj+1 − πj pj = πj qj − πj−1 pj−1

pj

⇒ πj+1 qj+1 − πj pj = π1 q1 − π0 = 0 ⇒ πj+1 = πj

qj+1

Iterando obtenemos finalmente

πj+1 = π0

p1 p2 · · · p j

q1 q2 · · · qj+1

Despejando π0 de la condición de normalización

π0 = 1 +

P

πi = 1, se tiene

1

p1

p1 p2 · · · pN −1 −1

+

+ ··· +

q1 q1 q2

q1 q2 · · · qN

lo que termina el cálculo de π.

Como se ve de los ejemplos anteriores, la distribución invariante puede

o bien no existir en absoluto, o bien no ser única. Veremos ahora una serie

de resultados que nos permitirán establecer condiciones que garantizan la

unicidad y existencia de la misma.

21

Definición 6.6. Un vector no nulo µ(i), i ∈ S, µ(i) ∈ [0, 1] tal que µP = µ

para una matriz estocástica se dirá una medida invariante para P.

Observe que orresponde con una distribución

invariante que no está norP

malizada (es decir, no necesariamente

µi = 1).

El siguiente resultado caracteriza la forma que puede tener una medida

invariante para P en términos de la dinámica de la cadena correspondiente,

y permitirá aclarar el problema de unicidad y existencia de una distribución

invariante.

Teorema 6.7. Sea Xn una cadena de Markov irreducible y recurrente con

matriz de transición P = {P (i, j)}. Sea i0 un estado cualquiera fijo pero

arbitrario, y sea Ti0 el tiempo de retorno a i0 . Sea

X

µi = Ei0

1I{Xn =i} 1I{Ti0 ≥n}

(6.3)

n≥1

Entonces

a) µi ∈ (0, ∞).

b) µi es invariante para P.

Demostración Observamos que si i 6= i0 , µi como definido en (6.3) es la

esperanza del número de visitas a i antes de retornar a i0 , y

µi0 = P Ti0 < ∞ = 1,

ya que i0 es recurrente. Además,

XX

X

1I{Xn =i} 1I{Ti0 ≥n} = Ti0 ⇒

µi = Ei0 Ti0

i∈S n≥1

i∈S

Definimos

hn (i0 , i) = Ei0 1I{Xn =i} 1I{Ti0 ≥n} = Pi0 Xn = i, Xn−1 6= i0 , · · · X2 6= i0

Entonces h1 (i0 , i) = P (i0 , i) y descomponiendo la probabilidad anterior de

acuerdo al penúltimo paso, obtenemos

X

hn (i0 , i) =

hn−1 (i0 , j)P (j, i)

si n > 1

(6.4)

j6=i0

22

Sustituyendo en (6.3),

X

XX

µi =

hn (i0 , i) + h1 (i0 , i) =

hn−1 (i0 , j)P (j, i) + P (i0 , i)

n≥2

=

X

n≥2 j6=i0

P (j, i)µj + P (i0 , i) =

X

P (j, i)µ(j),

j∈S

j6=i0

lo que muestra b).

P Supongamos que µi = 0 para algún i ∈ S. Por la invariancia, sigue que

P (j, i)µj = 0. Como µi0 = 1, entonces P (i0 , i) = 0. Por la invariancia,

j ∈S

también ∀n ≥ 1, µ Pn = µ, y por el mismo razonamiento anterior se concluye

que P (n) (i0 , i) = 0 ∀n ≥ 1, de forma que i0 e i no se comunican. Esto

contradice la irreducibilidad de la cadena, y P

ası́ µi > 0 ∀i ∈ S.

Por la invariancia, también se tiene que j∈S P (j, i0 ) µj = 1. Si µj = ∞

para algún j, tiene que ser P (j, i0 ) = 0. Por el mismo argumento sigue que

P (n) (j, i0 ) = 0 ∀n ≥ 1, lo cual contradice la irreducibilidad de la cadena, y

entonces µi < ∞ ∀i ∈ S, con lo cual se concluye la verificación de a).

Del resultado anterior tenemos entonces la existencia de una medida invariante (que no es necesariamente normalizable a una distribución invariante). Con respecto a la unicidad, tenemos:

Teorema 6.8. La medida invariante de una cadena irreducible y recurrente

es única salvo constantes multiplicativas.

Demostración Sea Xn una cadena de Markov recurrente e irreducible con

espacio de estados S y matriz de transición P, y ν una medida invariante.

De la demostración del resultado anterior, sigue que νi > 0 ∀i. Sea

X

i∈S

Q(j, i) =

νi

P (i, j). Entonces

νj

Q(j, i) =

1 X

νj

νi P (i, j) =

=1

νj i∈S

νj

por lo que Q es una matriz estocástica. Es fácil ver por inducción que

Q(n) (j, i) = ννji P (n) (i, j), ası́ que como P es irreducible, también Q lo es.

P

P

Como n≥1 Q(n) (i, i) = n≥1 P (n) (i, i), por la proposición 5.7, Q es también

recurrente. Sea Yn una cadena de Markov con matriz Q , y sea

gn (j, i) = Pj (Yn = i, Yn−1 6= i · · · Y1 6= i)

23

(en palabras, la probabilidad de que la cadena Yn pase de j a i por primera

vez en el tiempo n). Como Yn es recurrente,

X

gn (j, i) = 1 ∀i, j

n≥1

Por otro lado, haciendo una descomposición según la posición del primer

paso,

X

X

νj

gn+1 (i, i0 ) =

gn (j, i0 )Q(i, j) =

gn (j, i0 ) P (j, i) =⇒

νi

j6=i0

j6=i0

X

νi gn+1 (i, i0 ) =

gn (j, i0 ) νj P (j, i)

(6.5)

j6=i0

Multiplicando por νi0 la fórmula (6.4), observamos que las sucesiones νi gn (i, i0 )

y νi0 hn (i0 , i) satisfacen la misma recurrencia, y además, de las definiciones,

νi g1 (i, i0 ) = νi Q(i, i0 ) = νi0 P (i0 , i) = νi0 h1 (i0 , i), de modo que

∀n ≥ 1, νi0 hn (i0 , i) = νi gn (i, i0 ).

Tomando sumatoria en n,

νi0 µi = νi

X

gn (i, i0 ) = νi ,

n≥1

de modo que ν es un múltiplo de µ como definida en (6.3).

Veamos ahora algunas consecuencias de estos resultados:

Corolario 6.9.

1. Si una cadena de Markov es recurrente e irreducible y un estado es

recurrente positivo, entonces todos lo son.

2. Una cadena de Markov recurrente e irreducible

Pes positiva recurrente

si y sólo si sus medidas invariantes satisfacen

µi < ∞.

3. Una cadena de Markov irreducible es recurrente positiva si existe una

única distribución invariante π. Más aún,

π(j) =

1

Ej Tj

24

∀j ∈ S

Demostración

1. Sea i0 el estado recurrente positivo. Tomándolo como el estado escogido

en la definición (6.3), como vimos

X

µi = Ei0 Ti0 < ∞

(6.6)

Sea otro estado i1 , y la correspondiente medida µ(1) como en (6.3) (con

i1 en vez de i0 .) Por el teorema 6.8, µ(1) es un múltiplo de µ, por lo

P (1)

que tiene que ser Ei1 Ti1 =

µi un múltiplo de Ei0 Ti0 , y por lo

tanto finita.

2. Sigue por el mismo argumento.

3. Basta normalizar como en (6.6) para obtener

π(i0 ) =

1

.

Ei0 Ti0

Como i0 fue arbitrariamente escogido, la fórmula arriba vale para cualquier

estado, y se cumple π(i) = Pµiµi .

Teorema 6.10. Una cadena de Markov irreducible es recurrente positiva si

y sólo si existe una distribución invariante .

Demostración Supongamos

que existe una distribución invariante π, es decir,

P

(n)

π

P

(i, j). Si los estados son transitorios, entonces

∀ n ∈ N, πj =

i∈S j

(n)

P (i, j) → 0 cuando n → ∞ (ver el ejercicio 3) de la sección 5). Pero

entonces πj = 0, lo cual vimos no es posible. Entonces los estados tienen que

ser recurrentes, y se está en las hipótesis del teorema 6.8, por lo que µ (como

definida en (6.3)) es un múltiplo de la π dada, de modo que, como en (6.6),

Ei0 Ti0 < ∞. El recı́proco sigue del corolario anterior.

Corolario 6.11. Una cadena de Markov irreducible con espacio de estados

finito es recurrente positiva.

Demostración

PLos estados tienen que ser recurrentes, y como S es finito,

Ei0 Ti0 =

i∈S µi < ∞, por lo que i0 es recurrente positivo, y por el

corolario 6.9, todos los estados lo son.

25

Ejercicios

1. Considere el modelo de Ehrenfest presentado en la sección 4 con 2N

bolas.

Calcule

EN +J (TN +J )

.

EN (TN )

Verifique que si j N , entonces el cociente anterior es aproxiJ

madamente 1 + NJ .

Suponga que N es muy grande (por ejemplo, N ≈ 1020 ), y sea J =

N

. Si se realiza un intercambio por segundo, calcule EN +J (TN +J ),

103

y exprese el resultado en años. Haga aproximaciones si es necesario.

2. Sea Xn una cadena de Markov en S finito, con probabilidades de transición P (i, j), sea L > 0 un entero. Definimos Yn = (Xn , Xn+1 , · · · Xn+L ),

un proceso a valores en

E = {(i0 , i1 , · · · , iL ) ∈ S L+1 : P (i0 , i1 )P (i1 , i2 ) · · · P (iL+1 , il ) > 0}.

Este proceso se conoce como cadena serpiente de largo L.

Verifique que Yn es una cadena de Markov homogénea, y calcule

sus probabilidades de transición.

Verifique Yn es irreducible si Xn lo es.

Verifique que si Xn tiene distribución invariante, también Yn la

tiene, y muestre cual es.

3. Sea P una matriz estocástica en S. Una distribución de probabilidad ν

en S se dice reversible para P si ∀ i, j ∈ S ,

ν(i) P (i, j) = ν(j) P (j, i)

Verifique que si ν es reversible, entonces es invariante.

Si Xn es un paseo aleatorio simétrico en un grafo conexo que tiene

N vértices numerados de 1 a N , y di es el número de aristas del

vértice i, verifique que la distribución ν(i) = PNdi d es reversible

i=1 i

para esta cadena.

26

Concluya que ν es invariante.

4. Discuta la existencia y unicidad de una distribución invariante en el

caso de la cadena del castillo de naipes. Sug.: Vea el ejercicio 6 de la

sección 5.

5. Discuta existencia y unicidad de una distribución invariante en el caso

de la cadena de nacimiento y muerte del ejemplo 6.5, en el caso N = ∞.

7.

Resultados ergódicos

Sea Xn una cadena de Markov en S, i0 un estado fijo, y recordemos la

definición de µi (6.3), que vimos es una medida invariante para la cadena,

X

µi = Ei0

1I{Xn =i} 1I{Ti0 ≥n} ,

n≥1

Consideramos ν(n) el número de visitas al estado i0 antes de n,

ν(n) =

n

X

1I{Xj =i0 } .

j=1

Denotemos por Xk σ la cadena con distribución inicial σ.

El siguiente resultado relaciona promedios temporales de Xn con el promedio “espacial”(en S), con respecto a la medida µ.

P

Proposición 7.1. Sea f : S → R tal que i∈S |f (i)| µi < ∞, µ y ν como

arriba. Entonces, para toda condición inicial σ,

lı́m

N →∞

N

X

1 X

f (Xk σ ) =

f (i)µ(i)

ν(N ) k=1

i∈S

con probabilidad 1

(7.1)

Demostración Sean τn los sucesivos tiempos de retorno de la cadena al estado

i0 : τ0 = Ti0 , e, inductivamente, τn+1 = ı́nf{K > τn : XK = i0 }, y sean

U` =

τ`+1

X

f (Xn ),

n=τ` +1

27

`≥0

De la proposición 5.5 sigue que {U` } es una secuencia de variables aleatorias

i.i.d. Supongamos f ≥ 0.

E U0 =E

τ0

X

τ0 X

X

f (Xn ) = Ei0

f (i)1I{Xn =i}

n=1

=

X

n=1 i∈S

X

Ti0

f (i) Ei0

X

1I{Xn =i} =

f (i)µi

n=1

i∈S

i∈S

El intercambio en el orden de las sumas está justificado por el teorema de convergencia dominada, y la última igualdad sigue simplemente de la definición

de µ. De la ley fuerte de los grandes números sabemos que, con probabilidad

1,

N

X

1 X

U` →

f (i)µi

cuando N → ∞

N `=0

i∈S

Sustituyendo la definición de U` , tenemos entonces

1

N

X

τN +1

f (Xk ) →

k=τ0 +1

X

f (i)µi

cuando N → ∞

i∈S

Como τν(N ) ≤ N < τν(N )+1 , entonces

Pτν(N )

f (Xk )

≤

ν(N )

k=1

PN

f (Xk )

<

ν(N )

k=1

Pτν(N )+1

f (Xk )

ν(N )

k=1

Por ser la cadena recurrente, ν(N ) → ∞, de forma queP

ambos extremos en

las desigualdades precedentes tienen el mismo lı́mite ( f (i)µi ), y por lo

tanto el término del medio también.

En el caso de que f no sea necesariamente positiva, se puede descomponer

en f = f + − f − , y la demostración

sigue como antes,

que por

P

P observando

−

+

la hipótesis sobre f , tanto i∈S f (i) µi < ∞ como i∈S f (i) µi < ∞ son

finitas.

Como corolario, obtenemos el teorema ergódico para cadenas de Markov:

Teorema 7.2 (Teorema Ergódico). Si Xn es irreducible, recurrente positiva

y su distribución invariante es π, entonces para toda f : S → R tal que

28

P

|f (i)| πi < ∞, se cumple que, con probabilidad 1, para cualquier configuración inicial,

N

X

1 X

lı́m

f (Xk ) =

f (i) πi

N →∞ N

i∈S

k=1

i∈S

P

Demostración Como Xn irreducible y recurrente positiva,

µi < ∞, y

P

N

vale la proposición 7.1 con f = 1, de donde ν(N

→

µ

.

Como

π y µ son

i

)

P

proporcionales, sabemos i∈S |f (i)| µi < ∞, y otra vez por la proposición

7.1,

X

1 X

lı́m

f (Xk ) =

f (i) µi =⇒

N →∞ ν(N )

i∈S

k=1

P

N

X

1 X

i∈S f (i) µi

=

f (i) πi

lı́m

f (Xk ) = P

N →∞ N

µ

i

i∈S

i∈S

k=1

N

Corolario 7.3. Si Xn es una cadena de Markov recurrente positiva con distribución invariante π, L ≥ 1 un entero, g : S L+1 → R una función dada que

satisface

X

g(i0 , i1 , · · · , iL ) πi0 P (i0 , i1 ) · · · P (iL−1 , iL ) < ∞

(i0 ,i1 ,··· ,iL ) ∈S L+1

entonces con probabilidad 1, para cualquier configuración inicial,

N

1 X

lı́m

g(Xk , Xk+1 , · · · Xk+L ) =

N →∞ N

k=1

X

g(i0 , i1 , · · · , iL ) πi0 P (i0 , i1 ) · · · P (iL−1 , iL )

(i0 ,i1 ,i2 ,··· ,iL ) ∈S L+1

Demostración Para demostrarlo, basta considerar la cadena serpiente de largo

L. (Ver Ejercicio 2 de la sección anterior).

29

Un ejemplo

Inspección de una lı́nea de producción

Suponga que se tiene una lı́nea de producción, donde cada objeto manufacturado tiene una probabilidad p de ser defectuoso. Se propone un esquema

de inspección para detectar defectos sin tener que inspeccionarlos todos. El

esquema tiene un modo A, donde cada objeto se inspecciona con probabilidad r < 1, y un modo B, donde todos son inspeccionados. Se pasa de modo

B a modo A cada vez que N objetos sin defecto han sido consecutivamente

detectados (N > 1 es un entero fijado previamente). Se pasa de modo A a

modo B cada vez que se detecta un objeto defectuoso. Sea Xn el proceso

con valores en S = {e0 , e1 , · · · eN }, donde el estado ej , j < N significa que se

está en modo B con j objetos sin defecto consecutivamente observados. El

estado eN significa que el proceso de inspección está en modo A.

La matriz de transición viene dada por

p

1−p

0

0

···

0

0

p

0

1−p

0

···

0

0

p

0

0

1−p

···

0

0

·

·

·

·

·

·

···

p

0

0

0

···

0

1−p

pr

0

0

0

···

0

1 − pr

Es fácil ver que la cadena es irreducible, y como es finita, es recurrente

positiva, ası́ que tiene una distribución invariante π = (π0 , π1 , · · · , πN ). Las

ecuaciones para π son:

π0 = p

N

−1

X

πi + p r π N

i=0

πi+1 = (1 − p)πi

i = 0, 1, · · · , N − 1

πN = (1 − pr)πN + (1 − p)πN −1

Resolviendo en términos de π0 , tenemos

πi = (1 − p)i π0

i = 1, 2, · · · , N − 1

30

πn =

(1 − p)N π0

pr

pr

De la primera ecuación, y usando la normalización, despejamos π0 = r−(1−p)

N (r−1) .

Supongamos que queremos calcular la proporción q de objetos inspeccionados en el largo plazo, y la eficiencia E del esquema de inspección , definida

por

proporción de objetos defectuosos detectados

E=

.

proporción de objetos defectuosos

Tenemos que

N

1 X

q = lı́m

1I{e1 ,e2 ,··· ,eN −1 } Xk + r 1I{eN } Xk

N →∞ N

k=1

Aplicando el Teorema 7.2 con f (i) = 1I{e1 ,e2 ,··· ,eN −1 } (i) + r 1I{eN } (i), tenemos

PN −1

que q = i=1

πi + rπN = 1 + (r − 1)πN .

Análogamente, podemos calcular la proporción de objetos defectuosos no

detectados en el largo plazo, como

p lı́m

N →∞

N

X

(1 − r)1IeN (Xk ) = p (1 − r) πN

k=1

de donde E = 1 − (1 − r)πN

Ejercicio

1. Se desea detectar la presencia en la sangre de una substancia rara, que

aparece con probabilidad muy pequeña ρ 1 en individuos de una

población muy grande. Cada análisis es muy costoso, por lo que se

procede según el siguiente esquema:

A Se toman muestras de r individuos, se mezcla una parte de cada

muestra y se analiza. Si el resultado es negativo, se reporta y se

comienza nuevamente con otros r individuos.

B Si el resultado es positivo, se analizan separadamente las muestras

de los primeros r − 1 individuos, y si todos negativos, se reportan

los resultados.

C Si algun resultado en B es positivo, se analiza la muestra restante

del r-ésimo individuo, se reportan resultados y se comienza nuevamente con otros r individuos.

31

Muestre que el esquema se puede modelar como una cadena de

Markov, indique el espacio de estados y la matriz de transición.

Los costos de los pasos A, B y C son γ, (r − 1)γ y γ respectivamente, y el numero de informes producidos es r. Calcule el

número de informes esperado y el costo esperado una vez alcanzado el equilibrio.

El cociente mencionado en el item anterior mide el rendimiento del

esquema. Tomando en cuenta que ρ 1, discuta como conviene

escoger r de forma de maximizar el rendimiento.

8.

Convergencia al equilibrio y pérdida de memoria

En el caso de Xn una cadena de Markov irreducible y recurrente positiva,

para cada estado e ∈ S, podemos tomar f = 1I{e} en el teorema ergódico, y

si llamamos π la distribución invariante obtenemos

N

1 X

1I{e} Xn → π(e)

N n=1

cuando N → ∞

con probabilidad 1, para toda condición inicial. En particular, si el estado

inicial es i, tomando esperanza,

N

N

1 X

1 X (n)

Pi (Xn = e) =

P (i, e) → π(e)

N k=1

N k=1

En otras palabras, la sucesión P (n) (i, e) converge en promedio (o en media

Cesaro) a π(e) cuando n → ∞ independientemente de la condición inicial

i. Es natural preguntarse si es verdad que P (n) (i, e) → π(e) cuando n →

∞. Con miras a aplicaciones, es también relevante estudiar la velocidad de

convergencia.

Para responder estas preguntas, usaremos el concepto de acoplamiento.

Acoplar uno (o más) procesos estocásticos consiste simplemente en construirlos en un mismo espacio de probabilidad. Esto se hace con la finalidad de

32

poder traducir, por ejemplo, comparaciones entre probabilidades referentes

a ellos en comparaciones entre eventos correspondientes, que puede resultar

conveniente dependiendo de la particular construcción.

Veamos algunos ejemplos de acoplamientos entre cadenas de Markov en

el caso particular en que ambas tienen el mismo espacio de estados S y la

misma matriz de transición P, pero el estado inicial es diferente.

En vista de la construcción de la sección 3, dados dos estados iniciales a

y b, podemos obtener ambas cadenas definidas en el mismo espacio de probabilidad simplemente tomando la familia de variables aleatorias uniformes

en el mismo espacio (Ω, F, P ) en ambos casos. Hay muchas formas de hacer

esto, por ejemplo, dada P, consideremos una función F que genere la cadena

por recurrencia como en (3.4), y procedemos como sigue:

El acoplamiento libre. Consiste en considerar ambas cadenas obtenidas

con la misma familia de uniformes {Un }n≥1 :

X0 = a Xn+1 = F (Xn , Un+1 )

X̃0 = ã X̃n+1 = F (Xn , Un+1 )

El acoplamiento de Doeblin Consiste en considerar, en un mismo

espacio, dos familias independientes de variables aleatorias independientes uniformes, {Un }n≥1 y {Ũn }n≥1 , y ası́ construir las dos cadenas

Xn y X̃n (que resultan independientes), también en el mismo espacio:

X0 = a Xn+1 = F (Xn , Un+1 )

X̃0 = ã X̃n+1 F (Xn , Ũn+1 )

Tiene sentido entonces definir la variable aleatoria “ tiempo de encuentro”

entre los dos procesos,

τ (a,b) = ı́nf{n ≥ 1 : Xn = X̃n }.

Un tercer ejemplo es el siguiente.

Acoplamiento coalescente independiente Consiste en considerar

las cadenas a partir de dos familias de uniformes independientes hasta

el tiempo τ (a,b) , y evolucionando juntas despues de τ (a,b)

Observemos que en el caso del acoplamiento libre y también del coalescente independiente, las dos trayectorias continúan juntas después de τ (a,b) .

Cuando este tiempo es finito, se puede decir que la cadena “pierde memoria”

de su condición inicial. El coeficiente de ergodicidad es una forma de medir

la tendencia de una cadena a “perder la memoria”.

33

Definición 8.1. Dada una matriz de tansición P = P (i, j) en S, se define

el coeficiente de ergodicidad β(P) como

X

β(P) =

ı́nf P (i, j)

j∈S

i∈S

Teorema 8.2. Si P es una matriz de transición en un espacio de estados S,

entonces para todo par de estados a y b en S existe un acoplamiento Xna , Xnb

de las cadenas de Markov correspondientes a P con condiciones iniciales a y

b tal que

n

P sup τ (a,b) > n ≤ 1 − β(P)

a,b∈S

Demostración Presentaremos la demostración en el caso de S finito. La extensión al caso infinito se hace siguiendo el mismo procedimiento.

Supongamos S = {1, 2, 3, · · · , N }. Se realizará un acoplamiento usando

la misma familia de uniformes y una función F convenientemente construida

de modo de colaborar con el encuentro de las trayectorias al usar la fórmula

de recurrencia (3.4). Para definir F ,Sconstruiremos, para cada estado i ∈ S,

una partición del intervalo [0, 1) = j∈S I(i, j) en intervalos disjuntos tales

que λ I(i, j) = P (i, j).

Sean los intervalos J(j), j = 1, 2, · · · , N definidos por

J(1) = 0, `(1) , con `(1) = mı́n P (k, 1)

k∈S

J(j) = `(j − 1), `(j)

con `(j) = `(j − 1) + mı́n P (k, j) si j > 1

Tenemos que

k∈S

S

j∈S

J(j) es una partición de [0, `(N )), con

X

`(N ) =

mı́n P (k, j) = β(P)

j∈S

i∈S

S

˜ j),

Para cada i ∈ S, se va a tomar una partición de [`(N ), 1) = j∈S J(i,

˜ j)) = P (i, j). Basta

de forma que la suma de las longitudes λ(J(j)) + λ(J(i,

definir

˜ 1)

˜ 1) = `(N ) + P (i, 1) − mı́n P (k, 1)

˜ 1) = `(N ), `(i,

J(i,

`(i,

k∈S

˜ j − 1), `(i,

˜ j)

˜ j) = `(i,

J(i,

si j > 1, donde

˜ j) = `(i,

˜ j − 1) + P (i, j) − mı́n P (k, j)

`(i,

k∈S

34

˜ j) satisface las propiedades requeridas,

Es claro que I(i, j) = J(j) ∪ J(i,

esto es, para cada i∈ S, ∪j∈S I(i, j) es una partición en intervalos disjuntos

de [0, 1), y λ I(i, j) = P (i, j). Sea entonces la función

X

j 1II(i,j) (u).

F (i, u) =

j∈S

Observamos que si u ≤ `(N ), entonces para i0 , i1 dos estados cualesquiera de

S,

F (i0 , u) = F (i1 , u)

(a)

(8.1)

(b)

Si se generan recursivamente las cadenas Xn y Xn con condiciones iniciales

a y b respectivamente, usando la misma famila de uniformes i.i.d {Un }{n≥1} ,

y esta función, se tiene:

(a)

(b)

Xn+1 = F Xn(a) , Un+1 ,

Xn+1 = F Xn(b) , Un+1

De (8.1) sigue que si τ̃ = ı́nf{n ≥ 1 : Un < `(N )}, entonces τ (a,b) < τ̃ ,

∀ a, b ∈ S, de donde

P sup τ

(a,b)

n

\

> n ≤ P τ̃ > n ≤ P

a,b∈S

{Ur > `(N )}

r=1

= 1 − `(N ))

n

= 1 − β(P)

n

(8.2)

Veamos algunas importantes consecuencias de este resultado.

Teorema 8.3. Sea P la matriz de transición de una cadena de Markov Xn

recurrente positiva e irreducible, y tal que que β(P) > 0. Sea π su distribución

invariante. Entonces se satisface que

n

sup Pa (Xn = j) − π(j) ≤ 1 − β(P)

a,j

Demostración

Pa (Xn = j) − π(j) = Pa (Xn = j) − Pπ (Xn = j)k

X

=

Pa (Xn = j) − Pk (Xn = j) π(k) (8.3)

k∈S

35

(a)

(k)

Considerando las cadenas Xn y Xn acopladas como en la demostración del

teorema anterior y recordando que una vez que las trayectorias se encuentran

(en τ a,k ), entonces ellas continuan juntas, podemos estimar

|Pa (Xn = j)−Pk (Xn = j)| = |P (Xn(a) = j, Xn(k) 6= j)−P (Xn(k) = j, Xn(a) 6= j)|

≤ máx{P (Xn(a) = j, Xn(k) 6= j) , P (Xn(k) = j, Xn(a) 6= j)} ≤ supk6=a P (τ a,k > n)

Esta última probabilidad se estima como (8.2)

Corolario 8.4. Sea P la matriz de transición de una cadena de Markov

Xn recurrente positiva e irreducible con distribución invariante π, y tal que

β(Pk ) > 0. Entonces, para todo par de estados a, j ∈ S,

N

sup Pa (XN = j) − π(j) ≤ 1 − β(Pk ) k

a,j

Demostración Sea k como en el enunciado. La cadena de Markov {Xkn }n≥0 ,

cuya mariz de transición es Pk tiene la misma distribución invariante π, por

lo que vale el resultado anterior,

n

sup Pa (Xkn = j) − π(j) ≤ 1 − β(Pk )

a,j

Basta renombrar N = kn.

Ahora bien, para que los resultados anteriores garanticen la convergencia al equilibrio, independientemente de la condición inicial, hace falta que

β(P) > 0, o al menos que para algún k, β(Pk ) > 0. Veamos un ejemplo en

el cual esta hipótesis no se satisface, aún en las condiciones en que vale el

teorema ergódico 7.2.

Ejemplo 8.5. Considere el paseo aleatorio en el grafo formado por los 4

vértices de un cuadrado y sus lados, que corresponde con el siguiente grafo

de transición, donde todas las probabilidades son 12 , y hemos numerado los

vértices 1, 2, 3, 4.

36

1 y

9

4 3

s

2

3 Su matriz de transición es:

P=

0

1

2

0

1

2

0

0

0 12

1

0 12 0

2

1

2

0

1

2

1

2

Es fácil ver que esta cadena es irreducible y recurrente positiva, y que

su medida invariante es π = ( 14 , 14 , 14 , 41 ). Claramente, β(P) = 0. También

tenemos

1

0 12 0

2

0 1 0 1

2

2

P2 =

1 0 1 0

2

2

0 12 0 12

Más aún, en este caso particular es fácil obtener todas las potencias de

P: P2n+1 = P, y P2n = P2 , de modo que β(Pk ) = 0 ∀k ∈ N. En particular, por

ejemplo, la sucesión P (n) (1, 1) vale 12 si n es par, y 0 si n es impar, por lo que

claramente no converge cuando n → ∞. (Observe que, como ya sabı́amos del

teorema ergódico, converge a 14 en promedio , o en media Cesaro).

Este fenómeno se llama periodicidad. Precisamente, definimos:

Definición 8.6. Sea P es la matriz de transición de una cadena de Markov

en S, y j ∈ S. Consideremos d el máximo común divisor del conjunto

{n ≥ 1 : Pn (j, j) > 0}, es decir,

d = M CD {n ≥ 1 : Pn (j, j) > 0}

37

Si d > 1, el estado j se dice periódico de perı́odo d. Si d = 1, se dice

aperiódico.

Omitimos la demostración de las siguientes dos proposiciones, que puede

encontrarse por ejemplo en [3].

Proposición 8.7. Si dos estados i, j se comunican, entonces tienen el mismo

perı́odo.

Podemos hablar entonces del perı́odo de una cadena irreducible (o de una

clase comunicante).

Proposición 8.8. Si P es irreducible y tiene perı́odo d, entonces para cada

par de estados i, j, existen m > 0 y N0 tal que P(m+nd) (i, j) > 0 ∀n ≥ N0 .

Observación Si S es finito y la cadena es irreducible y aperiódica, entonces,

en virtud del resultado anterior, tenemos que existe k tal que

P (k) (i, j) > 0 ∀i, j ∈ S

En particular, vale el Teorema 8.3.

Definición 8.9. Una cadena de Markov se dice ergódica si es irreducible,

recurrente positiva y aperiódica.

No es difı́cil a esta altura, demostrar el siguiente resultado, que en el caso

de S finito, es una consecuencia de del teorema 8.3.

Teorema 8.10. Si Xn es una cadena ergódica en S, y π es su distribución

invariante, entonces

P (n) (i, j) → π(j)

cuando n → ∞

Con respecto a las cadenas irreducibles y periódicas de perı́odo d, podemos decir lo siguiente. Supongamos que su matriz de transición es P. De la

proposición 8.8, tenemos que existe una partición de S en clases G0 , G1 , · · · Gd−1

tales que (tomando la convención Gd = G0 ),

X

P (i, j) = 1 ∀i ∈ Gk

j∈Gk+1

(En palabras, la cadena se va moviendo entre estas clases). Si además es

recurrente positiva, es fácil ver que la cadena con matriz Pd restringida a

38

cada una de las clases G` es recurrente positiva, irreducible y aperiódica, por

lo que tiene una distribución invariante Π. Como la esperanza del tiempo de

k)

retorno a un estado k ∈ G` con respecto a la matriz Pd tiene que ser Ek (T

d

(donde esta última esperanza es en relación a la cadena original) es fácil ver

que, si k ∈ G`

(

d

si i ∈ G`

lı́m P (nd) (i, k) = Ej (Tk )

n→∞

0

si no

Ejercicios

1. Considere el paseo simétrico en el grafo formado por un pentágono y

sus lados. ¿ Es periódico? Encuentre n tal que P (n) (i, j) > 0 para todo

par de estados i, j.

2. Considere la cadena correspondiente a la matriz P dada en la sección

3, y diga si es periódica.

3. Sean P, β y τ a,b como en el teorema 8.2. Deduzca de este resultado una

cota para la esperanza E(τ a,b ).

9.

Algunos algoritmos de simulación

Uno de las aplicaciones actuales más difundidas de las cadenas de Markov

es en los conocidos como métodos de Monte Carlo por Cadenas de Markov

(MCMC por sus siglas en inglés). Son métodos para simular una muestra

de una distribución π definida en un espacio de estados finito S. Consisten

en simular una cadena de Markov ergódica (recuerde la definición 8.9) en S

cuya distribución invariante es precisamente la π dada, y dejarla evolucionar

“hasta alcanzar el equilibrio”. En vista de los resultados de la sección anterior,

se obtiene una realización (aproximada) de π. En este contexto la distribución

π se denomina blanco, o target, en inglés.

Veamos un par de formas de conseguir una cadena ergódica con distribución invariante π dada en un espacio finito S = 1, 2, · · · , N .

39

1-. Sean las siguientes probabilidades de transición :

1

π(j)

N − 1 (π(j) + π(i))

X

P (i, i) = 1 −

P (i, j)

P (i, j) =

si i 6= j

j6=i

2-. Sean las probabilidades de transición P̃ (i, j) dadas ası́

1 π(j)

P̃ (i, j) =

1I{π(i)≤π(j)} +

1I{π(i)>π(j)}

N −1

π(i)

X

P̃ (i, i) = 1 −

P̃ (i, j)

si i 6= j

j6=i

Es muy fácil verificar que las cadenas correspondientes a estas probabilidades

de transición tienen

las propiedades requeridas. En efecto, si i 6= j, entonces

P

P (i, j) > 0, y j6=i P (i, j) < 1, por lo que P (i, i) > 0 también. Pero entonces

la cadena es irreducible y aperiódica. Como S es finito, también es recurrente

positiva. Para mostrar que π es invariante para la cadena, basta verificar

que es reversible (como definido en el Ejercicio de la sección 6), lo cual es

inmediato de la definición.

9.1.

El algoritmo de Propp y Wilson

Este algoritmo fue propuesto por J. Propp y D. Wilson en 1996 en [10]

para obtener una muestra de una medida π en un espacio finito, y tiene la

ventaja de que (cuando converge) genera una muestra exacta de la distribución blanco. Tiene además un mecanismo de parada automático,por lo que no

requiere cálculos de velocidad de convergencia. Es un mecanismo de muestreo

“ desde el pasado”. Una discusión de esta propuesta incluyendo ejemplos y

generalizaciones, puede encontrarse en [8] y las referencias allı́ citadas.

Sea entonces el espacio S = {1, 2, 3, · · · , N }, donde está definida una

medida π de la cual se desea obtener una muestra. Sea Xn una cadena de

Markov reversible y ergódica tal que π sea su distribución invariante. (Por

ejemplo, una de las presentadas al comienzo de esta sección). Sea F una función que genera por recurrencia a Xn , a partir de una muestra de uniformes

{Un } i.i.d. (Por ejemplo, la considerada en (3.3)). El algoritmo consiste en

considerar un acoplamiento de N cadenas, cada una comenzando en un estado diferente de S, desde tiempos en el pasado, mirar el estado de cada una de

40

ellas en el tiempo 0, e ir suficientemente hacia atrás hasta que coincidan en el

tiempo 0. Por la forma en que se usan las variables uniformes, el valor X0 estará distribuido según π. Concretamente, sea una sucesión creciente de tiempos (N1 , N2 , N3 · · · ), por ejemplo Nk = 2k . Los negativos de estos números

serán los tiempos de partida en el pasado de las cadenas, −N1 , −N2 , N3 , · · · .

Supongamos (por conveniencia en la notación) que las variables uniformes

están indexadas en −N : {U−n }n≥0 El algoritmo funcion ası́

1. Tómese m = 1.

2. Para cada j ∈ S, simúlese una cadena de Markov comenzando en j en

el tiempo −Nm , usando una función F y las v.a. uniformes

U−Nm +1 , U−Nm +2 , · · · , U−1 , U0

3. Si todas las cadenas están en el mismo estado k en el tiempo 0, el

algoritmo se detiene, con salida k. En caso contrario, se pasa a 4.

4. Tómese m + 1 y comiéncese nuevamente en el paso 2.

Es importante (y desde el punto de vista práctico, complicado) que parte de

las v. a. uniformes son reutilizadas cuando se retrocede en el tiempo.

Tenemos el siguiente resultado:

Teorema 9.1. Supongamos que el algoritmo descrito arriba, en las condiciones consideradas para la cadena de Markov correspondiente, termina con

probabilidad 1, y sea Y su salida. Entonces Y se distribuye según π, es decir,

para j ∈ S,

P Y = j = π(j)

Demostración Basta demostrar que, dado ε > 0,

|P Y = j − π(j)| < ε

(9.1)

Ya que el algoritmo termina con probabilidad 1, existe M tal que

(j,−NM )

sup |P (X0

k,j∈S

(j,−N

)

(k,−N

(k,−NM )

6= X0

)

)| < ε

M

M

donde X0

y X0

es la posición en el tiempo 0 de las cadenas

(acopladas según indica el algoritmo) que en tiempo −NM comienzan en j

41

(π,−N

)

M

y k, respectivamente. Sea ahora Xn

una cadena que en tiempo −NM

(π,−NM )

esta distribuida según π. Como π es invariante, entonces X0

∼ π. Pero

entonces

(j,−NM )

(π,−NM )

6= X0

) < ε,

P (X0

y procediendo como en (8.3), sigue (9.1)

Ejercicios

1. Verifique que las probabilidades de transición P̃ (i, j) del ejemplo 2-.

dan lugar a una cadena ergódica con distribución invariante π.

2. Considere la distribución π = ( 16 , 26 , 36 ) en S = {1, 2, 3}.

Escriba una matriz de transición cuya cadena tiene distribución

invariante π.

Implemente el algoritmo de Propp y Wilson para generar una

muestra de π.

Apéndice

El siguiente es un conjunto de 4 muestras de tamaño 10 de variables

uniformes en el intervalo [0, 1]:

0,4186

0,5028

0,6979

0,6602

0,8462

0,7095

0,3784

0,3420

0,5252

0,4289

0,8600

0,2897

0,2026

0,3046

0,8537

0,3412

0,6721

0,1897

0,5936

0,5341

0,8381

0,1934

0,4966

0,7271

0,0196

0,6822

0,8998

0,3093

0,6813

0,3028

0,8216

0,8385

0,3795

0,5417

0,6449

0,5681

0,8318

0,1509

0,8180

0,3704

Fórmula de Stirling

√

1 n! = nn e−n 2πn 1 + Ø( )

n

Una demostración de esta fórmula se encuentra en [5], por ejemplo. Más

detalles en [1].

42

Referencias

[1] Stella Brassesco and Miguel A Méndez. The asymptotic expansion

of n! and the Lagrange inversion formula. The Ramanujan Journal,

24(2):219–234, 2011.

[2] Leo Breiman. Probability and stochastic processes with a view toward

applications. Houghton Mifflin Company, 1969.

[3] Pierre Brémaud. Markov chains, Gibbs fields, Monte Carlo simulations

and queues. Springer, 1998.

[4] P Eherenfest and T Ehrenfest. The Conceptual Foundations of the Statistical Approach in Mechanics. Dover Publications, 1990.

[5] William Feller. Introduction to Probability theory and its applications.

John Wiley and sons Inc., 1968.

[6] Pablo A Ferrari and Antonio Galves. Construction of stochastic processes, coupling and regeneration. XIII Escuela Venezolana de Matemática,

2000.

[7] Antonio Galves, Arnaldo C.R. Nogueira, and Maria Eulália Vares. Introducão aos sistemas Markovianos de particulas. 5o Simpósio Nacional

de Probabilidade e Estatistica, 1982.

[8] Olle Häggstrom. Finite Markov chains and algorithmic applictions.

Cambridge university press, 2002.

[9] Torgny Lindvall. Lectures on the coupling method. Dover publications

Inc., 2002.

[10] J. Propp and D. Wilson. Exact sampling with coupled Markov chains

and applications to statistical mechanics. Random Strutures and Algorithms, 9(1& 2):223–252, 1996.

[11] Henry C Tuckwell. Elementary applications of probability theory. Chapman and Hall, second edition, 1995.

43