3.- DISTRIBUCIONES.

Anuncio

1

3.- DISTRIBUCIONES.

1

1.-Variable aleatoria

Tenemos un experimento aleatorio, estudiado en el tema anterior, llamamos:

E= espacio muestral

S= conjunto de sucesos

p= probabilidad asociada a cada suceso, es decir:

p: S ))))))))> [0,1]

a la terna (E,S,p) le llamamos espacio probabilístico.

Definición: Llamamos variable aleatoria o variable estocástica X a un aplicación

X: E))))))))>R

es decir, a toda función que asocia a cada elemento del espacio muestral E un número real. De

forma sencilla: es el valor númerico que 'de alguna manera' se asigna a un suceso.

El conjunto imagen de la aplicación se llama recorrido de la variable. Suele confundirse

variable aleatoria con recorrido.

Ejemplos:

1) Tomamos como experimento el lanzar tres monedas al aire. ¿Cúal es su espacio muestral?

Definimos la variable aleatoria X, consistente en contar el número de caras que salen en cada

tirada.

X:E))))))))>R

X toma los posibles valores {0,1,2,3}, caras posibles que pueden salir

2) Tomamos como experimento las notas de un examen redondeadas a calificaciones enteras. (Ejemplo

realizado en el tema 7). ¿Cúal es su espacio muestral?

Definimos la variable aleatoria X en contar el número de alumnos con cada calificación

Toma los ejemplos del tema 7 y establece la variable.

3) Mismo experimento del ejemplo anterior, pero tomando las calificaciones en intervalos [0,2).....[8,10].

Definimos la variable aleatoria X en contar el número de alumnos con cada calificación

4) Consideramos el experimento aleatorio que consiste en elegir un alumno del Instituto. Espacio muestral

(E) son todos los alumnos.

Definimos la variable aleatoria X como medir la estatura de un individuo.

5) Experimento: piezas electricas construidas por una fabrica.

Variable aletoria X="tiempo de funcionamiento de una pieza electrica, medida en años".

6)Experimento: Tornillos fabricados por una empresa.

Variable aleatoria X=" Medir la longitud (en cm.) de los tornillos construidos".

7) Experimento: nacimientos en un hospital.

Variable aleatoria X="Contar el número de ellos que son niñas".

IV: Distribuciones

8) Consideramos el experimento de elegir un enfermo en la Residencia. Enuncia variables aleatorias que

se te ocurran.

9) Realizamos un juego con el dado de la siguiente manera:

si sale 1 ó 2 se cobra 3 ($$).

si sale 4,5,6 se cobra 1

si sale 3 se paga 5

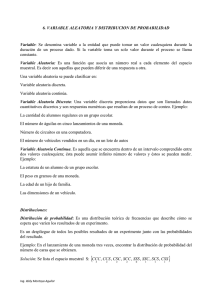

Definición:

Decimos que una variable aleatoria es discreta cuando solo puede tomar un número

finito o infinito numerable de valores.

Decimos que una variable aleatoria es continua, cuando puede tomar, al menos

teoricamente, todos los valores posibles dentro de un intervalo de la recta real.

Ejemplo: clasifica todos los ejemplos anteriores.

Consideramos X:E))))))))>R una v.a. y x,R. Se utiliza las siguientes notaciones:

[X=x] = {e,E / X(e)=x}

[X#x] = {e,E / X(e)#x}

[X$x] = {e,E / X(e)$x}

estos son subconjuntos de E, y por lo tanto,

sucesos.

Ejemplos:

1) Continua del ejemplo 9 anterior.

[X=-5]={3}

[X=3]={1,2}

[X=1]={4,5,6}

[X=0'5]=0

2) Tomamos como experimento el lanzar tres monedas al aire. ¿Cúal es su espacio muestral?

Definimos la variable aleatoria X, consistente en contar el número de caras que salen en cada

tirada.

X:E))))))))>R

X toma los posibles valores {0,1,2,3}, caras posibles que pueden salir.

[X=2]={ (c,c,+) (c,+,c) (+,c,c)}

[X#1]={ (+,+,+) (c,+,+) (+,c,+) (+,+,c)}

IV: Distribuciones

2.-Variable aleatoria discreta

Sea el espacio probabilistico (E,S,p)

E= espacio muestral

S= conjunto de sucesos

p= probabilidad asociada a cada suceso, es decir:

p: S ))))))))> [0,1]

Definición: Llamamos variable aleatoria discreta X a un aplicación

X: E))))))))>R

y que toma valores en un número finito de números o un número infinito numerable.

(Infinito numerable: se puede establecer una aplicación biyectiva entre el conjunto y N.)

Ejemplos: Son ejemplos los citados en la pagina 225 con los números 1,2,3,7,9

Vamos a estudiar el ejemplo siguiente en el apartado de variable aleatoria discreta.

Experimento: lanzar dos dados

Variable aleatoria X="Sumar los números que están en las caras superiores de los dados".

E={1,2,3,4,5,6} x {1,2,3,4,5,6}

Im (X)={2,3,4,5,6,7,8,9,10,11,12}

Resultados posibles de la suma.

Utilizamos las notaciones:

[X=5] = { (1,4) (4,1) (2,3) (3,2)}

[x#3] = [X=2]+[X=3]= { (1,1) (1,2) (2,1) }

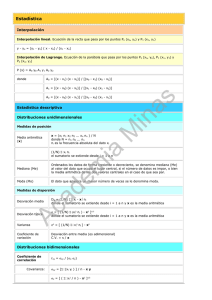

2.1.-Función masa de probabilidad

Definición:

Llamamos función de probabilidad de una variable aleatoria X a la aplicación que asocia a cada

valor xi de la variable su probabilidad pi

Im (X) ))))))))> R

xi ~)))))))> p(xi) = p[X=xi] = pi

también se llama función masa de probabilidad de la variable X.

La representamos esquematicamente mediante tablas:

X

x1

x2

....

xn

p(X)

p1

p2

....

pn

bien en este sentido, bien en el sentido vertical

(como hicimos en el tema 7).

Graficamente se representarán por un

diagrama de barras, como se ve a la

derecha.

IV: Distribuciones

Ejemplo:

1) Con el ejemplo de lanzar 2 dados y sumar los resultados, la función de probabilidad será la siguinte:

X

2

1

p(X) ))

36

3

4

5

6

7

8

9

10

11

12

2

))

36

3

)))

36

4

)))

36

5

)))

36

6

)))

36

5

)))

36

4

)))

36

3

)))

36

2

)))

36

1

)))

36

Lanzar 2 dados

Probabilidad

0.2

0.15

0.1

0.05

0

2

3

4

5

6

7

8

Suma

9

10

2) Función de probabilidad del ejemplo 9, del juego con dados:

si sale 1 ó 2 se cobra 3 ($$).

si sale 4,5,6 se cobra 1

si sale 3 se paga 5

la función la podemos representar en tabla

X

-5

1

3

p(X)

1/6

1/2

1/3

o como una función sobre esos puntos.

Propiedades:

A) pi $ 0 para todo i=1,2,...,n

en efecto, los números pi son todos positivos por ser probabilidades de sucesos.

B) p1 + p2 + ... + pn = 1

en efecto, ya que se trata de la probabilidad del suceso seguro.

IV: Distribuciones

11

12

2.2.-Función de distribución de una v.a. discreta

Vamos a asociarle a una v.a. discreta una función real de varible real que se lama su función de distribución.

Es una generalización del concepto de distribución de frecuencias relativas acumuladas.

Sea X una aleatoria discreta y sea p una probabilidad definida en E.

Definición:

La función F: R)))))))>R definida por F(x)=p[X#x] (se lee probabilidad de que X tome un valor # x)

se denomina función de distribución de la varible aleatoria X. Es decir, para cada x la

función vale la suma acumulada de las probabilidades de todos los casos anteriores a

x. También se llama función de distribución acumulativa.

+)Q

*0

si x < x1

*p(x1)

si x1 # x < x2

F(x) = *p(x1)+p(x2)

si x2 # x < x3

*.......................

....................

*p(x1)+p(x2)+....+p(xn)

si xn-1 # x < xn-2

*1

si x $ xn

.)Q

Aclaraciones:

1) Al ser F(x) igual a una probabilidad, entonces 0#F(x)#1

2) X es el simbolo que representa a una variable aleatoria discreta.

3) x es un valor cualquiera de R.

4) Si x1 , x2 ,....,xn son menores que x:

E

F(x)=p[X#xn]=p[(X=x1)U(X=x2)U....U(X=xn)] = p[X=x1]+p[X=x2]+...+p[X=xn]=

p(xi)

Ejemplo:

1) Sigamos con el mismo ejemplo de lanzar 2 dados, su función de distribución será la siguiente:

X

F(X)

2

3

4

5

6

7

8

9

10

11

12

1

)))

36

3

)))

36

6

)))

36

10

)))

36

15

)))

36

21

)))

36

26

)))

36

30

)))

36

33

)))

36

35

)))

36

36

)))

36

donde F(x) representa el valor acumulado. La gráfica de

la función, escalonada como todas las funciones de

distribución de v.a.

IV: Distribuciones

Algunos ejemplos de cálculo:

F(1)=p[X#1]=0

F(4)=p[X#4]= p[x=2] + p[X=3] + p[X=4] = 1/36+2/36+3/36= 6/36=1/6.

F(3'4)=p[X#3'4]=3/36

F(13)=p[X#13]=1

p[1<x<3]=F(3)-F(1)=1/36-0=1/36

2) Ejemplo del lanzamiento de un dado (pag. 226)

La Función de Distribución vendrá dada por la función:

+)Q

*0

si x < -5

*1/6 si -5 # x < 1

F(x) = *4/6

si 1 # x < 3

*1

si 3 # x

.)Q

y su gráfica

IV: Distribuciones

3.-Variable aleatoria continua.

Sea el espacio probabilistico (E,S,p)

E= espacio muestral

S= conjunto de sucesos

p= probabilidad asociada a cada suceso, es decir:

p: S ))))))))> [0,1]

Definición: Llamamos variable aleatoria continua X a un aplicación

X: E))))))))>R

que puede tomar tomar al menos teoricamente, todos los valores posibles dentro de un intervalo

de la recta real.

Ejemplos: Son ejemplos los citados en la pagina 225 con los números 4) 5) 6).

Otros ejemplos:

a) E=Almejas extraidas de la rias gallegas

Variable aleatoria X="medir el tamaño de las conchas"

b) E=Niños recien nacidos en el materno.

Variable aleatoria X="pesarlos"

Son otros ejemplos: la estatura, pesos, temperaturas, y en la práctica, las variables discretas si toman

muchos valores.

Los conceptos siguientes, función de densidad y función de distribución nacen de la

generalización a términos probabilisticos, de los conceptos de frecuencia relativa, histogramas,

etc., vistos en el primer tema. Recuerde el alumno, el concepto de probabilidad , como límite de

las frecuencias realtivas.

3.1.-Función de densidad

Definición:

Se dice que f:[a,b] ))))))))> R es una

función de densidad de la variable aleatoria

continua X, si se verifica:

a) f(x)$0, para todo x,[a,b]

b) f es integrable en todo el intervalo [a,b] y:

!b

"a

* f(x) dx = 1

Ejemplo:

+Q

1) Dada la función

*x/2 si 0#x#2

f(x)=*

ver que es f. de densidad

*0 en otro caso

.Q

IV: Distribuciones

3.2.-Función de distribución

Definición:

La función F:R ))))))))>R es una función de

distribución de la variable aleatoria continua X,

si se verifica que F(x)=p[X#x].

Es decir:

+)Q

*0

si x<a

*

* !x

F(x)=* * f(t) dt si a#x#b

* "a

*

*1

si x>b

*

.)Q

Nota: Podría decirse que la función de distribución mide, para cada real " la cantidad de

probabilidad que hay antes de dicho número real".

Ejemplos:

1) Función de distribución asociada a la función de densidad del ejemplo 1 del apartado anterior.

+Q

*x/2 si 0#x#2

f. densidad----> f(x)=*

*0 en otro caso

.Q

integrando la función x/2, obtenemos la f. de

distribución.

+Q

*0 si x<0

f. DISTRIBUCION F(x)=*x²/4 si 0#x<2

*1 si x$2

.Q

IV: Distribuciones

2) Una v.a. continua toma valores en el intervalo [0,1] y tiene una función de densidad dada por

f:[0,1]))))))))>R

f(t)=kAt

Se pide:

a) Calcular el valor de k para que f sea una f. de densidad.

b) Calcular la función de distribución.

!1

a) Por ser una función de densidad:

"0

* kAt dt = 1

!

1

+

,1

* kAt dt = kA*t²/2* = kA1/2 = 1

"

.

-0

==> k=2

0

luego la función buscada es: f(t)=2At.

b) La función de distribución será

!

x

+ ,x

F(x) = * 2At dt = *t²* = x².

"

. -0

0

resultando como función de distribución:

+)Q

*0

si x<0

*

F(x)=* x²

si 0#x#1

*

*1

si x>1

.)Q

Propiedades:

1.-La función de distribución F es creciente, es decir:

x1 < x2 ==> F(x1) # F(x2)

2.-Como consecuencia de la anterior:

x2

!

"

p[x1<X#x2] = F(x2) - F(x1) = * f(t)Adt

x1

gráficamente significa que la probabilidad de que X tome valores comprendidos entre x1 y x2

está dada por el área que encierra f con el eje OX entre las ordenadas x1 y x2.

3.-Para una v.a. continua, la probabilidad en un punto es cero, o bien, la probabilidad de que

la variable X tome un determinado valor x, es igual a 0.

p[X=x]=0

IV: Distribuciones

4.-La derivada de la función de distribución es la función de densidad, en el dominio de

derivabilidad:

F'(x) = f(x)

Ejemplo: Seguimos con la v.a. continua que tiene por función de densidad:

f: [0,1]))))))))>R f(t)=2t.

¿cúanto vale p [-1#X#3/4?

!

3/4

p [-1#X#3/4] =

9

p [0#X#3/4] = * 2tAdt = ))

"

16

0

4.-Características de una variable aleatoria

Debemos pensar en variables aleatorias como una abstracción de las variables

estadísticas. Por otro lado las probabilidades podemos verlas como límites de las frecuencias

relativas. En este apartado vamos a estudiar las medidas básicas estudiadas en Estadística

Descriptiva (media y desviación típica), generalizadas para variables aleatorias.

4.1.-Variable aleatoria discreta

Sea X una variable aleatoria discreta

Definición:

Se llama media, esperanza matemática o valor esperado de la variable discreta X, y se

representa por : o E[X] a la expresión:

n

:=

1

E x Ap

i

i

Recuerde el alumno que pi equivale a un límite de f.relativas.

Ejemplo:

1) Seguimos con el juego de lanzar el dado

si sale 1 ó 2 se cobra 3 ($$).

si sale 4,5,6 se cobra 1

si sale 3 se paga 5

con la función de probabilidad:

X

-5

1

3

p(X)

1/6

1/2

1/3

su media será:

:=-5A1/6 + 1A1/2 + 3A1/3= -5/6+1/2+1=4/6

Intuitivamente si x describe las ganancias y pérdidas en un juego, la esperanza indica: si es 0 que el juego es equitativo,

si es + se trata de un juego favorable y si es - de un juego desfavorable.

Definición:

Se llama varianza de la variable aleatoria discreta X, y se designa por F² o V[X] a la

expresión:

IV: Distribuciones

n

F²=

E (x - : )² A p

i

i

1

Definición:

Se llama desviación típica de la variable aleatoria discreta X, y se designa por F o D[X]

a la raiz cruadrada postiva de la varianza.

Ejemplo: (sacado del libro: El hombre anumérico de Jhon Allen Paulos)

Supongamos una pequeña compañia de seguros, en la que supone que:

1 de cada 10.000 polizas terminará en una reclamación de 200.000 dolares.

1 de cada mil, terminará en reclamación de 50.000 dolares.

1 de cada cincuenta, en una reclamación de 2.000 dolares.

el resto no dará lugar a reclamación, es decir, 0 dolares.

A la compañia le gustaría conocer cúal es gasto esperado para cada poliza, o dicho de otra manera,

cual es el gasto medio de una poliza.

Antes de hacer la solución debes plantear el problema de modo exacto, es decir, espacio muestral, variable

aleatoria, función de probabilidad.

El resultado es la media o esperanza matemática o valor esperado:

:= (200.000A1/10.000) + (50.000A1/1000) + (2.000A1/50) + (0A9.789/10.000)=110 dolares.

4.2.-Variable aleatoria continua

Sea X una variable aleatoria continua cuyo recorrido es el intervalo [a,b] y f(x) la función de

densidad de dicha variable.

Definición:

Se llama media, esperanza matemática o valor esperado de la variable continua X, y se

representa por : o E[X] al valor de la integral:

!b

: = * xAf(x) dx

"a

Definición:

Se llama varianza de la variable continua X, y se representa por F o V[X] al valor de la

integral:

!b

F²= * (x-:)²Af(x) dx

"a

Definición:

Se llama desviación típica de la variable aleatoria continua X, y se designa por F o D[X]

a la raiz cruadrada postiva de la varianza.

Ejemplo: Seguimos con la v.a. continua que tiene por función de densidad:

IV: Distribuciones

f: [0,1]))))))))>R f(t)=2t.

realizando los cálculos correspondientes obtenemos:

!1

media:

: = * xA2x dx = 2/3

"0

!1

varianza:

F²= * (x-2/3)²A2x dx = 1/18

"0

desviación típica:

IV: Distribuciones

F = 0'235

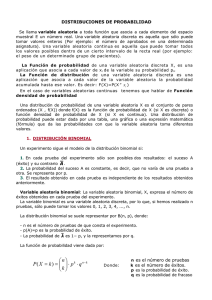

5.-Distribución binomial

Vamos a estudiar el ejemplo más conocido de variable aleatoria discreta. Vamos a

estudiar ejemplos en las que solamente hay dos resultados posibles.

Se llama experimento de Bernouilli de n pruebas al experimento aleatorio que consiste

en realizar 'n' pruebas que verifican las siguientes condiciones:

a) En cada prueba son posibles solamente dos sucesos incompatibles, que llamaremos

A y B.

b) El resultado de cada prueba es independiente de los resultados de las anteriores.

c) La probabilidad p(A) de que ocurra A no varia de una prueba a otra. Evidentemente

tambien la probabilidad p(B).

d) Si p(A)=p y p(B)=q es p+q=1

Ejemplos: son ejemplos de este experimento.

El lanzamiento de una moneda al aire 10 veces (n veces).

Los descendientes de una determinada pareja.

Una máquina produce tornillos y tiene una probabilidad de 0,001 de fabricar alguno defectuoso.

Este es un experimiento de Bernouilli, pues:

a) Una pieza puede resultar defectuosa (suceso A) o no (B).

b) El tornillo puede ser defectuoso en su fabricación independientemente de como hayan

sido fabricados los anteriores.

c) La probabilidad de obtener un tornillo defectuoso es p(A)=0,001.

Los sucesos posibles en un experimento de Bernouilli son W={A,B}. Como A y B son

sucesos incompatibles:

_

p(A) = p y p(B) = p(A) = q = 1-p

El espacio muestral E después de n pruebas será:

E = WxWx.....xW = W6

El número de elementos del espacio muestral es el número de elemento de E (Card (E)) y será:

Card (E) = VRn,2 = 26

Definimos la variable aleatoria X:E))))))))>R que asocia a cada suceso el número de

ves que ocurre A en dicho suceso.

Esta variable aleatoria es discreta pues alcanza los valores 0,1,2,...,n

Una variable aleatoria en estas condiciones se dice que es una variable aleatoria

binomial o variable de Bernouilli.

La función de probabilidad de X es la función definida:

Im (X) ))))))))>R

x~))))))))> p(x) = p[X=x]

veamos que vale esta probilidad.

IV: Distribuciones

Realizamos el experimento n veces y deseamos saber la probabilidad de obtener x éxitos

en las n pruebas (con x#n).

p(A)=p

p(B)=q

Consideramos uno de los casos que se obtienen x éxitos, y por lo tanto, n-x fracasos,

agrupandoles el suceso será:

x éxitos

n-x fracasos

AA............ABB..........B

como son sucesos independientes se verifica:

p(A1A1....1A1B1B1....1B) = p(A)Ap(A)A...Ap(A)Ap(B)Ap(B)A...p(B)= pxAqn-x

este es solo caso de los sucesos de E. ¿Cúantos sucesos hay en E en las mismas condicones del

anterior, es decir, x éxitos y n-x fracasos?

El número de casos son las distintas maneras de colocar los x éxitos en los n lugares.

x 'aes'

A

A

A

))) ))) ))) ))) ..................... ))) )))

n lugares

son, por tanto, x veces el suceso A en 'n' lugares, es decir, las combinaciones de n elementos

tomados de x en x:

siendo estos últimos los sucesos distintos con x exitos y cada uno con la probabilidad pxAqn-x

en total tendremos:

En definitiva la función de probabilidad de X viene dada por:

{0,1,2,....n} ))))))))> R

x ~)))))))))))> p (x)

el nombre de binomial es debido a que la expresión corresponde con un término del desarrollo

del binomio de Newton.

Esta función así definida cumple las condiciones de la función probabilidad.

Las medidas características en un experimento de Bernoulli de n pruebas se demuestra

IV: Distribuciones

que vienen dadas por las expresiones siguientes:

: = np

Media:

Varianza:

F²= npq

F =%npq

___

Desviación típica:

Ejemplo: ¿Cúal es la probabilidad de que una famila con seis hijos tenga dos hijos varones, suponiendo

que las probabilidades de que nazca varón o hembra son iguales?

Sea A el suceso consistente en que nazca un varón ...... p(A)=1/2

Sea B el suceso consistente en que nazca una hembra..... p(B)=1/2.

Este es un experimento de Bernouilli pues:

a) Solo son posibles 2 sucesos e incompatibles entre si.

b) El que nazca hembra o varón no depende del anterior nacimiento.

c) La probabilidad de que sea varón es siempre la misma.

Siendo E el espacio muestral formado por todas las combinaciones de varón y hembras que puede haber

en 6 hijos. La variable aleatoria será:

X: E ))))))))>R

e~)))))))>X(e)=número de hijos varones.

donde por notación [X=2] representa el suceso en el que 2 de los seis hijos son varones. La función de

probabilidad es la siguiente:

{0,1,2,....6} ))))))))> R

x ~)))))))))))> p (x)

nos están pidiendo la probabilidad de tener 2 hijos varones, será por lo tanto:

Sobre el mismo experimiento, calculemos la media de hijos varones y la desviación típica:

: = np = 6A1/2 = 3

F = % npq = %6A0'5A0'5 = %6/2

____

________

_

Sea X una variable aleatoria binomial que toma valores en el conjunto 0,1,2,...,n

Definición:

Se llama función de distribución binomial o función de distribución de la variable

IV: Distribuciones

aleatoria binomial X, representamos por F, a la aplicación de R en R que asocia a cada

número real x la probabilidad de que la variable X tome valores menores e iguales que

x.

F: R))))))))>R

x~))))))> F(x)=p[X#x]

donde *x* representa la parte entera de x, es decir, el mayor entero menor o igual que x.

Ejemplo:

¿Cual es la probabilidad de que una famila de 6 hijos tenga como máximo cuatro varones?

Todos estos valores se pueden calcular con las tablas que se encuentran al final del tema.

Aplicaciones de la distribución binomial: la distribución binomial tiene un gran campo de

aplicación en experimentos reales, vacunas, fabricación de componentes, etc. El alumno lo

comprobará en los ejercicios.

Notación : es frecuente designar a la distribución binomial como B(n,p).

6.-Distribución normal

Vamos a estudiar una distribución de variable aleatoria continua de gran importancia, llamada

distribución normal o de Gauss.

Esta distribución se acomoda a gran cantidad de fenómenos reales: biológicos, físicos, técnicos,

sociológicos, etc. En ellos vemos que los histogramas de frecuencias adoppta una forma que se

repite.

Ejemplo:

la distribución por tallas de una población

la distribución por pesos de una población.

No todos los fenómenos siguen este comportamiento, por ejemplo la distribución de las riquezas ( como

facilmente puede comprobarse).

Definición:

Se dice que una varible aleatoria continua X tiene un distribución normal de media :

y desviación típica F, designaremos por N(:,F), si se cumplen las siguientes

condiciones:

a) La variable recorre todo R.

b) La función de densidad de X es:

IV: Distribuciones

los valores : y F se llaman parametros de la distribución normal.

Sin demostración admitimos que esta función es función de densidad, llamada función

de Gauss, verificando las condiciones de función de densidad.

Vamos a representar graficamente la función de Gauss, para ello se hacen los cálculos normales

en la representación de funciones:

1.-Dominios de definición y derivabilidad

Está definida en toda la recta real

2.-Simetrías

La función es simétrica respecto de la recta x=:, ya que se verifica:

f(:+h)=f(:+h)

3.-Cortes con los ejes

Eje X: no hay cortes, ya que la función exponencial no es nunca 0.

Eje Y: haciendo x=0, se obtiene:

4.-Máximos y mínimos

Haciendo los cálculos correspondientes obtenomos que f tiene maximo en:

5.-Puntos de inflexión

Haciendo los cálculos correspondientes obtendremos como puntos de inflexión:

x=:-F

x=:-F

6.-Asíntotas

Verticales no tiene, ya que el dominio es toda la recta real

Horizontales: haciendo el limite x))>4 obtenemos 0, y por lo tanto, asintota horizontal

en y=0, es decir, el eje de las X.

En definitiva, la representación gráfica de la función queda:

IV: Distribuciones

El eje representado es el de simetría. Los

puntos trazados con linea discontinua son

los p. de inflexión. El 'extremo de arriba' es

el máximo calculado antes.

El área encerrada bajo la curva, por ser una

función de densidad es 1:

!+4

"-4

* f(x) dx=1

El alumno puede tomar un intervalo [a,b],

despreciando lo que queda a izquierda y a derecha

como cero.

por su forma esta función se le denomina

campana de Gauss

La función de distribución de una varible aleatoria X con distribución N(:,F), tendiendo

en cuenta la definción de función de distribución será:

Graficamente representa el área comprendida entre -4 y x bajo la curva f(x), y por lo tanto, #1.

Por definición de la distribución las medidas características son:

media=:

varianza=F²

desviación típica=F

La función de densidad de una variable

normal depende de : y de F, y para cada

valor distinto de una u otra tendremos

funciones distintas y gráficas distintas.

A la derecha tienes un ejemplo de

gráfica de una distribución normal de

desviación típica pequeña y ,por tanto, con

el pico o extremo más alto.

Representa una distribución

concentrada entorno a la media, donde

predominan los valores centrales.

IV: Distribuciones

A la derecha tienes un ejemplo de

gráfica de una distribución normal de

desviación típica grande y ,por tanto, con el

pico o extremo más bajo.

Representa una distribución

dispersa respecto a la media, donde los

valores centrales pierden representatividad.

En definitiva, cuanto mayor sea la

desviación típica mayor es la dispersión y ,

por tanto, la gráfica de la función es más

alargada y menos alta (el máximo alcanza

un valor más pequeño). Por contra si la d. típica es menor, disminuye la dispersión y la gráfica

será mas puntiaguda y más concentrada.

De todas las distribuciones N(:,F) tiene especial interés la N(0,1) llamada ley normal standar

o curva normal tipificada. En este caso tendremos:

IV: Distribuciones

7.-Manejo de tablas de la normal

7.1.-Variable tipificada N(0,1)

Para el cálculo de la distribución normal en el caso de una varible N(0,1) tenemos unas

tablas que nos dan los valores (Al final del tema). Si observas la tabla verás que solamente viene

dada para los valores $0 y el valor que indica es el de la función de distribución, es decir,

F(x)=p[X#x] los que tiene la probabilidad menor o igual que x.

Para el cálculo de cualquier otro valor no directamente expresado en las tablas deben

seguirse los siguientes principios generales:

a) La curva que representa la función de densidad es simétrica.

b) El área encerrada bajo la función de densidad es 1.

Ejemplo: Sea X una variable N(0,1)

a) Calcular F(1,95)

Viene directamente en las tablas:

F(1,95)=p[X#1,95] = 0,9744

b) Calcular p[0,5#X#1,5]

Es el área comprendida entre 0,5 y 1,5 de manera que la probabilidad pedida:

p[0,5#X#1,5] = F(1,5) - F(0,5) = 0,9332 - 0,6915 =0,2417

c) Calcular p[X#-0,55]

La tabla solamente nos trae los valores positivos. Para calcular la negativa nos basaremos en que

f es simétrica respecto del eje Y.

El área encerrada por p[X#-0,55] es igual al área encerrada en el intervalo [0'55 , +4] y esta es

igual al area total que encierra f(x) menos el area del intervalo [-4,-0'55]. Por tanto:

p[X#-0'55]=p[X$0'55]=1-p[X#0'55]=1-0'7088=0'2912

O sea si x<0 se hace F(x)=1-F(-x)

7.2.-Tipificación de una variable

La curva normal tipificada dispone de unas tablas para el cálculo de los valores de la

función de distribución. No podemos hacer tantas tablas como posibles distribuciones hay.

Haremos un camino inverso, dada una variable X que sigue una distribución N(:,F)

transformarla en una distribución normal tipificada. Esta transformación es conocida como

tipificación de una variable. Los pasos consitirán en:

a) Centrar o hacer media nula, lo conseguiremos restando a cada variable la media :.

b) Reducir o hacer que la desviación típica sea 1, lo haremos dividendo cada varible por F.

Haciendo estos dos pasos a la vez, obtendremos:

X-:

Z=)))))

F

Sea X con una distribución N(:,F) y F:R))))))))>R su función de distribución. Llamamos F1

a la función de distribución normal de la variable tipificada:

IV: Distribuciones

X-:

F(x)= F1 (Z)= F1 ())))))

F

en efecto

Se verifica la siguiente igualdad entre sucesos:

+)

*X-:

[X#x] =*))))

* F

.)

#

),

*

))))) *

F

*

)-

x-:

entonces:

+)

*X-:

F(x)=p[X#x] =p *))))

* F

.)

#

),

+)

),

*

* X-: *

X-:

))))) * = p *Z# ))))) * = F1 ()))))

F

*

*

F

*

F

).Q

)-

x-:

Este resultado nos permite conectar áreas que encierra una curva normal cualquiera con áreas

dterminadas por la curva normal tipificada. Por tanto, mediante una única tabla de la normal,

podemos calcular cualquier probabilidad de una normal N(:,F)

Se verifica:

p[x1#X#x2] =p

+)

*x1-:

*))))

* F

.)

Ejemplo: Sea X,N(3,2), es decir, :=3 y

a) Calcular p[X#2]

+)

*

p[X#2] =p *Z

*

.)

b) Calcular p[1#X#4]

#

),

x2-: *

# Z # )))) *

F *

F=2

)-

),

*

)))) * = p [Z#-0'5] = 1-p[Z#0'5] = 1-0'6915 = 0'3085

2

*

)-

2-3

+)

*1-3

p[1#X#4] =p *))))# Z

* 2

.)

#

),

*

))))) * = p[-1#Z#0'5] = F1(0'5) - F1(-1)=

2

*

)-

4-3

= F1(0'5) -(1- F1(1)) = F1(0'5) + F1(1) -1 =0'6915+0'8413-1=0'5328

La media de los pesos de los habitantes de una población es 65 kg y la desviación típica 6 kgr.

Sabiendo que los pesos se distribuyen normalmente, calcular la probabilidad de que un

individuo pese:

a) A lo sumo 65 kgr

b) Entre 60 y 75 kgr

c) 75 o más de 75 kgr.

Sea X la v.a. que denota el peso de un individuo. Sera una distribución N (65,6)

a)

IV: Distribuciones

+)

),

*

p[X#65] =p *Z

*

.)

65-65*

# )))) * = p [Z#0] = 0'5

6

*

)-

b)

+)

*60-65

p[60#X#75] =p *)))))# Z

* 6

.)

),

75-65 *

# ))))) * = p[-0'83#Z#1'66] = F1(1'66) - F1(-0'83)=0'7484

6

*

)-

c)

+)

*

p[X$75] =p *Z

*

.)

),

75-65*

$ ))))

6

* = p [Z$1'66] = 1-p[Z#1'66] = 0'0485

*

)-

7.3.-Intervalos de centro media

: y desviación típica F

La desviación típica nos señala lo dispersos que están los datos del centro o media. Cabe

pensar si podemos saber algún dato más trabajando con los intervalos de centro :.

¿Qué porcentaje de individuos del espacio muestral están en el entorno de centro : y

radio F?. Es decir:

E(:,F)=(:-F,:+F)

por ser una v.a. continua la probabilidad en un punto es cero y por tanto:

p[:-F<X<:+F] = p[:-F#X#:+F]

tipificando la variable y aplicando conceptos de cálculo obtenemos:

+)

*:-F-:

p[:-F#X#:+F]=p *))))))# Z

* F

.)

),

:-F-: *

# ))))) * = p[-1#Z#1]=F1(1)-(1- F1(1)) =

F *

-

=2AF1(1) - 1 = 2A0'8413 - 1 = 0'6826

Analogamente se pueden calcular en los intervalos: (:-2F,:+2F) y (:-3F,:+3F)

INTERVALO

IV: Distribuciones

PORCENTAJE

(:-F,:+F)

68'26 %

(:-2F,:+2F)

95'4 %

(:-3F,:+3F)

99'7 %

8.-Aproximación de la binomial a la normal

La importancia de la distribución normal no se termina en que sirva de modelo para

muchos modelos de la vida real. Tambien sirve para aproximar distribuciones estadísticas.

Repaso el ejercicio hecho en el tema 7 de calificaciones en la manera de resolver 2 (calificaciones

aproximadas en intervalos de longitud 2).

Veamo el ejercicio siguiente:

Ejemplo:

El porcentaje de españoles con estudios medios es del 35 %. Escogemos 8 personas al azar.

a) probabilidad de encontrar 1,2,...,8 con estudios. Escribe la tabla que define la tabla de

probabilidad y la gráfica.

b) calcular la probabilidad de que entre 3 y 5 personas tengan estudios medios.

Es un claro ejemplo de experimento de Bernouilli (escribe claramente los motivos).

a) Las probabilidades vienen dadas en las tablas para:

p=0'35 n=8

número

probabipersonas

dad

======== =======

0

3,19

1

13,73

2

25,87

3

27,86

4

18,75

5

8,08

6

2,17

7

0,33

8

0,02

: = np = 2'8

F = % npq = 1'3490

____

Si observas la gráfica verás 'que recuerda a la normal'

b) la probabilidad entre 3 y 5 personas viene dada por:

p[3#X#5]=p[X=3]+p[X=4]+p[X=5]=0,2786+0,1875+0,0808=0,5469

¿Qué ocurre cuando aumentamos 'n'?

-Los cálculos se complican:

no es suficiente la tabla de trabajo en la que llegamos hasta n=8. Puede trabajarse

con tablas de n=10, pero es dificil encontrar alguna mayor. La alternativa es

pasar a cálculos con ordenador (la calculadora se quedará pequeña muy pronto).

-La gráfica cada vez recuerda más a una normal.

observa la gráfica siguiente, y como se parece más a la normal.

IV: Distribuciones

número

probabipersonas

dad

======== ========

0 0,568800

1 3,675328

2 10,88462

3 19,53651

4 23,66923

5 20,39195

6 12,81033

7 5,912460

8 1,989770

9 0,476184

10 0,076922

11 0,007530

12 0,000337

media

4,2

d.tip. 1,652271

Pues bien cuando n--->4 la distribución binomial se acerca cada vez más a la

distribución normal. Con ello nos permitirá trabajar con la distribución considerandola como

normal y los cálculos (previa tipificación son más sencillos).

¿Cómo tomamos la distribución normal, y a partir de que número de pruebas 'n' de la

distribución binomial se puede considerar como aceptable los cálculos que se obtengan con la

normal?.

Dada la distribución binomial de 'n' experimentos y con una probabiliad 'p' es necesario

previamente calcular la media (:) y la desviación típica (F), y aproximamos la

d.binomial B por la d. normal N(:,F)

d. binomial ))))))))> d. normal

B (n,p) ))))))))> N(:,F)

Se considera una buena aproximación cuando:

nAp$5 y nAq$5

Tambien, es otra forma de decir lo mismo, si n$30 y 0.1<p<0.9

es decir, cuanto mayor sea 'n'.

En la práctica dada una binomial B(n,p) , la normal del tipo N(np,%nqp) será una buena

aproximación si se cumple np$5 y nq$5.

En el supuesto anterior los cáculos de B(n,p) puede sustituirse por cáculos con la

normal, respetando los convenios: (Se llama Correción de Yates).

p(B=k) = p(k - 0.5 < N < k+0.5)

p(B<k) = p(N< k+0.5)

p(h < B < k) = p( h - 0.5 < N < k + 0.5)

IV: Distribuciones

Ejemplo: en los ejemplos de antes (con n=8 y n=12) vemos que no cumple la condición para que la

aproximación en los cálculos sean buenos. Realizamos, no obstante, la aproximación y veamos como

quedan los cálculos.

Es decir, el ejercicio tendría una última parte:

c) Calcular la probabilidad de entre 8 personas tomadas al azar, entre 3 y 5 tengan estudios

medios, con aproximación previa a la normal (p=0'35).

Recordemos los resultados del ejercicio realizado en pagina 247

: = np = 2'8

____

F = % npq = 1'3490

p[3#X#5]=0,5469

Aproximemos a la normal: N(2'8,1'35), realizando los cálculos pertinentes:

p[2'5#X#5'5] =p [-0'22# Z # 2 ] = 0'9772-0'4129 = 0'5643

hay diferencia con el valor real obtenido, debido a que está lejos de ser representativa la muestra tomada

(n=8) así como el producto nAp=2'8.

NOTA SOBRE LOS TEST DE NORMALIDAD :

Si se dispone de una serie de datos, obtenidos empíricamente cabe cuestionarse si se ajustaran o no a una

distribución normal. A menudo ocurre que el polígono de frecuencias de una variable estadística X recuerda la forma

de una distribución normal. En tal caso puede pensarse en calcular una distribución normal que se aproxime a la

distribución estudiada.

Generalmente el método seguido para resolver el problema consiste en tomar : y F respectivamente iguales a la

media y la desviación observadas en el estudio.

La sustitución de X por una normal N se llama ajuste.

Para comprobar si el ajuste es bueno existen diversos métodos: prueba de "68-95-99", la simetría (Pearson), el método

de la curtosis, etc.

Veamos brevemente algunos de estos métodos:

Método "68-95-99": Consiste simplemente en comprobar si en los intervalos [: - F , : + F] ,[ :+2F , :+ 2F ] , [ :3F , :+3F] se encuentra respectivamente el 68% , el 95% y el 99% (aprox. ) de los valores de la variable X.

Si el resultado se juzga positivo se acepta la hipótesis de que la variable X se comporta normalmente. Si no

es así , se rechaza.

Metodo de la Asimetría: En general cuando se habla de simetría o asimetría se hace con respecto a la media.

Existen varios tipos de coeficientes que ofrecen una mediad de la asimetría de una distribución. Uno de

ellos es el coeficiente de asimetría de Pearson:

Ap = 3 ( : - Mediana ) / F

Si Ap = 0 distribución simétrica.

Si Ap > 0 distribución asimétrica a derecha ( asimetría positiva.)

Si Ap < 0 distribución asimétrica a izquierda ( asimetría negativa).

Una distribución de fecuencias se dice que tiene una asimetría aceptable como normal si Ap toma valores

entre -0.3 y 0.3.

IV: Distribuciones