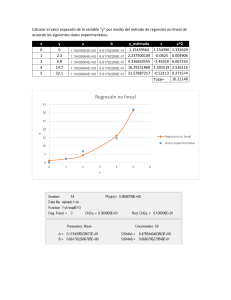

UNIVERSIDAD NACIONAL DE SAN ANTONIO ABAD DEL CUSCO Ingeniería informática y de sistemas Tema: Más allá de la linealidad Docente : M,Sc. Lauro Enciso Rodas Integrantes : - Gibaja Huayhua Juan Carlos 090215 - Gallegos Cjuiro Luis Alberto 184199 - Huaman Quispe Jemy Sandro 194519 - Lima Esperilla Katerine Candy 200334 - Lope Torres Marisol 171938 Semestre: 2021-1 MÁS ALLÁ DE LA LINEALIDAD El modelo lineal es relativamente fácil de interpretar y operar el y tiene ventajas sobre otros enfoques. Sin embargo, la regresión lineal puede tener limitaciones significativas. Hay otros métodos. Por ejemplo: Regresión Polinomial Funciones Escalonadas Splines Regresión Local Modelos Aditivos Regresión polinomial 7.1 Regresión polinomial La forma estándar de extender la regression lineal a entornos entre la relación de los predictors y si la respuesta no es lineal, se actualize el modelo lineal estándar: 𝑦𝑖 = 𝛽0 + 𝛽1 𝑥𝑖 + 𝜀𝑖 , Con una función polynomial: 𝑦𝑖 = 𝛽0 + 𝛽, 𝑥𝑖 + 𝛽2 𝑥𝑖2 + 𝛽3 𝑥i3 + ⋯ + 𝛽𝑑 𝑥id +𝜀𝑖 , …(7.1) dónde “𝜀𝑖 ” es el término de error. Este enfoque es conocido como regresión polynomial. Para grandes regresiones, una regresion polinomial nos permite producir una curva no lineal. Si vemos los coeficientes de la ecuación, podemos usar el metodo de minimos cuadrados por que solo es un modelo lineal con predictores 𝑥𝑖 , 𝑥𝑖2 , 𝑥i3 , … + 𝑥id . Entonces la curva puede volverse demasiado flexible y así tomar formas extrañas. Los datos de salario de la izquierda(en miles de dólares) es un polinomio de 4to grado en la función de la edad, está siendo ajustada por mínimos cuadrados. La curva representa un intervalo de confianza del 95%. En la derecha modelamos el salario de un evento >250 usando regression logística, nuevamente obtenemos un polinomio de 4to grado. La probabilidad que supere los 250 mil dólares se muestra en azul con intervalo de confianza del 95%. En la figura de la izquierda, este es un modelo de regresión lineal como cualquier otro, los coeficientes individuales no son de particular interés. En cambio, miramos toda la función ajustada a través de una cuadrítica de 62 valores para edades de 18 a 80 en para comprender la realción entre edad y salario. Veamos cómo surgen. Supongamos que hemos calculado el ajuste a u valor particular de edad, 𝑥0 : 𝑓መ 𝑥0 = 𝛽መ0 + 𝛽መ1 𝑥0 + 𝛽መ2 𝑋02 + 𝛽መ3 𝑋03 + 𝛽መ4 𝑋04 …(7.2) Cuál es la varianza del ajuste, es decir, Var𝑓መ 𝑥0 ? Mínimos cuadrados devuelve la varianza estimaciones para cada uno de los coeficientes ajustados. Así como las varianzas entre pares de estimaciones de coeficientes. El error estándar puntual estimado de 𝑓መ 𝑥0 es la raíz cuadrada de está varianza. Este cálculo se repite. En cada punto de referencia 𝑥0 , y graficamos la curva ajustada. La regresión logística puede predecir esta respuesta binaria usando funciones polinomiales de edad como predictores. E otras palabras, nos ajustamos al modelo. 𝑃𝑟 𝑦𝑖 > 250|𝑥𝑖 = …(7.3) ⅇ𝑥𝑝(𝛽0 + 𝛽, 𝑥𝑖 + 𝛽2 𝑥𝑖2 + 𝛽3 𝑥i3 + ⋯ + 𝛽𝑑 𝑥id ) 1 + ⅇ𝑥𝑝(𝛽0 + 𝛽, 𝑥𝑖 + 𝛽2 𝑥𝑖2 + 𝛽3 𝑥i3 + ⋯ + 𝛽𝑑 𝑥id ) Funciones de pasos 7.2 Funciones de pasos Usar funciones polinomiales de las entidades como predictores en un modelo lineal impone una estructura global sobre la función no lineal de X. Sin embargo, podemos usar funciones escalonadas para evitar una estructura tan global. Aquí la función de paso dividimos el rango de X en contenedores y ajustamos una constante diferente en cada 𝐶1, 𝐶2,⋯, 𝐶𝑘 contenedor. Tenemos los puntos de corte en el rango de X y luego construir K+1 funciones. Con mayor detalle, creamos puntos de corte 𝐶1, 𝐶2,⋯, 𝐶𝑘 en el rango de X, categórico y luego construir K + 1 nuevas variables 𝐶0, (X) = I(X<𝐶1, ), 𝐶1, (X) = I(𝐶1, ≤ X<𝐶2, ), 𝐶2, (X) = I(𝐶2, ≤ X<𝐶3, ), : (7.4) 𝐶K−1, (X) = I(𝐶𝐾−1 ≤ X<𝐶K, ), 𝐶K, (X) = I(𝐶𝐾 ≤ X), dónde I(·) es un función indicadora, que devuelve un 1 si la condición es verdadera, 0 si no lo es. Por ejemplo, I(𝐶𝐾 ≤ X) es igual a 1 si I(𝐶𝐾 ≤ X). Los datos de salario de la izquierda la curva sólida muestra el valor ajustado de una regresión de mínimos cuadrados del salario (en miles de dólares) usando funciones escalonadas de edad. Las curvas de puntos indican un intervalo de confianza estimado del 95%. Derecha: Modelamos el salario del evento binario > 250 usando regresión logística, nuevamente usando el paso funciones de la edad. La probabilidad posterior ajustada de que el salario supere los $ 250 mil mostrado, junto con un intervalo de confianza estimado del 95%. Aviso que para cualquier valor de X, 𝐶0, (X)+ 𝐶1, (X) + ... + 𝐶K, (X) = 1, ya que X debe estar exactamente en uno de los intervalos K + 1. Luego usamos mínimos cuadrados para ajustar un modelo lineal utilizando 𝐶1, (X), 𝐶2, (X), ..., 𝐶K, (X) como predictores: 𝑦𝑖 = 𝛽0 + 𝛽1 𝐶1 𝑥𝑖 + 𝛽2𝐶2 𝑥𝑖 + ⋯ + 𝛽K 𝐶K 𝑥𝑖 + 𝜀𝑖 , …(7.5) Para un valor dado de X, como máximo uno de 𝐶1, 𝐶2,⋯, 𝐶𝑘 puede ser distinto de cero.Note que cuando X<𝐶1, ,todos los predictores son 0, entonces 𝛽0 puede ser interpretado como el valor medio de Y para X<𝐶1, .En comparación, predice una respuesta de 𝛽0+𝛽jpara 𝐶j ≤ X <𝐶j+1 , entonces 𝛽jrepresenta el promedio aumento en la respuesta para X en 𝐶j ≤ X <𝐶j+1 en relación con X<𝐶1 . Un ejemplo de ajuste de funciones escalonadas a los datos de salario de la Figura 7.1 es que se muestra en el panel de la izquierda de la Figura 7.2. También ajustamos la regresión logística modelo. 𝑃𝑟 𝑦𝑖 > 250|𝑥𝑖 = …(7.6) ⅇ𝑥𝑝(𝛽0 + 𝛽1 𝐶1 (𝑥𝑖 ) + ⋯ + 𝛽𝐾 𝐶K (𝑥i)) 1 + ⅇ𝑥𝑝(𝛽0 + 𝛽1 𝐶1 (𝑥𝑖 ) + ⋯ + 𝛽𝐾 𝐶K (𝑥i )) Funciones básicas 7.3 Funciones básicas Los modelos de regresión polinomial y constante por partes son, casos especiales de función de base. La idea es tener funciones o transformaciones que se pueden aplicar a una variable X: 𝑏1, (X)+ 𝑏2, (X) + ... + 𝑏K, (X) . En lugar de ajustar un modelo lineal en X, nos ajustamos al Modelo. 𝑦𝑖 = 𝛽0 + 𝛽1 𝑏1 𝑥𝑖 + 𝛽2 𝑏2 𝑥𝑖 + ⋯ + 𝛽K𝑏K 𝑥𝑖 + 𝜀𝑖 , …(7.7) Tenga en cuenta que las funciones de base 𝑏1, . , 𝑏2, (. ) , ... , 𝑏K, (. ) son fijos y conocidos. (En otras palabras, elegimos las funciones con anticipación). Para polinomios regresión, las j funciones base son 𝑏𝐽 𝑋𝐼 = 𝑥𝑖 , y para constante por partes funciones son 𝑏j, 𝑋𝐼 =I(𝐶𝑗 ≤ 𝑋𝑖 <𝐶J+1, ). Podemos pensar en (7.7) como un modelo lineal estándar con predictores 𝑏1 (𝑋i, )+ 𝑏2 (𝑋i, ) + ... + 𝑏𝐾 (𝑋i, ) Por tanto, podemos usar mínimos cuadrados para estimar los coeficientes de regresión desconocidos en (7.7) Es importante destacar que esto significa que todas las herramientas de inferencia para modelos lineales que se analizan en el Capítulo 3, como los errores estándar para las estimaciones de coeficientes y los estadísticos F para la significancia general del modelo, están disponibles en esta configuración. Hasta ahora hemos considerado el uso de funciones polinomiales y funciones constantes por partes para nuestras funciones base; sin embargo, son posibles muchas alternativas. Por ejemplo, podemos usar wavelets o series de Fourier para construir funciones de base. En la siguiente sección, investigamos una opción muy común para una función base:splines de regresión. Regresión de Splines 7.4 Regresión de Splines Se trata de una extensión de la regresión polinómica y de las funciones de paso que consigue una mayor flexibilidad. Consiste en dividir el rango del predictor X en K subintervalos. 7.4.1 Polinomios por partes En lugar de ajustar un polinomio de alto grado en todo el rango de X, regresión polinomial por partes implica ajustar polinomios de bajo grado separados sobre diferentes regiones de X. Por ejemplo, un polinomio cúbico por partes funciona ajustando un modelo de regresión cúbica de la forma 𝑦𝑖=𝛽0+𝛽1 𝑥𝑖+ 𝛽2 𝑥𝑖2+𝛽3 𝑥𝑖3 +𝜀𝑖 (7.8) donde los coeficientes 𝛽0, 𝛽1, 𝛽2, y 𝛽3 difieren en diferentes partes de la gama de X. Los puntos donde cambian los coeficientes se llaman nudos. Por ejemplo, un cúbico a trozos sin nudos es solo un polinomio cúbico estándar, como en (7.1) con D = 3. Un polinomio cúbico a trozos con un solo nudo en un punto C toma la forma 𝑦𝑖 2 3 𝛽01 +𝛽11 𝑥𝑖+ 𝛽21 𝑥𝑖 +𝛽31 𝑥𝑖 +𝜀𝑖 𝛽02 +𝛽12 𝑥𝑖+ 𝛽22 𝑥𝑖2+𝛽32 𝑥𝑖3 +𝜀𝑖 si 𝑥𝑖< C; si 𝑥𝑖 ≥ 𝐶; En otras palabras, ajustamos dos funciones polinomiales diferentes a los datos, una en el subconjunto de las observaciones con 𝑥𝑖 < C, y uno en el subconjunto de las observaciones con 𝑥𝑖 ≥ C. La primera función polinomial tiene coeficientes 𝛽01 , 𝛽11 , 𝛽21, 𝛽31, y el segundo tiene coeficientes 𝛽02, 𝛽12 , 𝛽22, 𝛽32 . Cada una de estas funciones polinomiales se puede ajustar usando mínimos cuadrados aplicados a funciones simples del predictor original. El uso de más nudos conduce a un polinomio por partes más flexible. En general, si colocamos K diferentes nudos en toda la gama de X, entonces terminaremos encajando K + 1 polinomios cúbicos diferentes. Tenga en cuenta que no es necesario utilizar un polinomio cúbico. Por ejemplo, podemos ajustar funciones lineales por partes. De hecho, nuestras funciones constantes a trozos de la sección 7.2 son polinomios a trozos de grado 0. 7.4.2 Restricciones y splines El panel superior izquierdo de la Figura 7.3 parece incorrecto porque la curva ajustada es demasiado flexible. Para solucionar este problema, podemos ajustar un polinomio a trozos bajo la restricción que la curva ajustada debe ser continua. Figura 7.3. Varios polinomios por partes se ajustan a un subconjunto de la Sueldo datos, con un nudo en edad = 50. Arriba a la izquierda: Los polinomios cúbicos no están restringidos. Parte superior derecha: Los polinomios cúbicos están restringidos a ser continuos en edad = 50.Abajo a la izquierda: Los polinomios cúbicos están obligados a ser continuos y a tener una primera y una segunda derivadas continuas. Abajo a la derecha: Se muestra una spline lineal, que está limitada a ser continua En otras palabras, no puede haber un salto cuando edad = 50. La gráfica superior derecha de la Figura 7.3 muestra el ajuste resultante. Esto se ve mejor que el gráfico superior izquierdo, pero la combinación en forma de V parece antinatural. En el gráfico inferior izquierdo, hemos agregado dos restricciones adicionales: ahora tanto la primera como la segunda derivados de los polinomios por partes son continuos en edad = 50. En otras palabras, estamos requiriendo que el polinomio por partes no solo sea continuo cuando edad = 50, pero también muy liso. Cada restricción que imponemos a los polinomios cúbicos a trozos libera efectivamente un grado de libertad, al reducir la complejidad del ajuste polinomial a trozos resultante Entonces, en la gráfica superior izquierda, estamos usando ocho grados de libertad, pero en la gráfica inferior izquierda impusimos tres restricciones (continuidad de la primera derivada y continuidad de la segunda derivada) y así nos quedamos con cinco grados de libertad. La curva en la parte inferior izquierda la trama se llama interpolación cúbica. En general, una spline cúbica con K nudos utiliza un total de 4 + K grados de libertad. En la Figura 7.3, el gráfico inferior derecho es un spline lineal, que es continuo en edad = 50. Por lo tanto, se obtiene una spline lineal ajustando una línea en cada región del espacio predictor definido por los nodos, lo que requiere continuidad en cada nudo. 7.4.3 La representación de la base de splines Una spline cúbica con K los nudos se pueden modelar como 𝑦𝑖=𝛽0 +𝛽1𝑏1 𝑥𝑖+ 𝛽2 𝑏2 𝑥𝑖 + … + 𝛽𝑘+3 𝑏𝑘+3 (𝑥𝑖 )+𝜀𝑖 (7.9) para una elección adecuada de las funciones básicas 𝑏1 , 𝑏2 ,. . . , 𝑏𝑘+3. . El modelo (7.9) se puede ajustar usando mínimos cuadrados. Así como había varias formas de representar polinomios, también hay muchas formas equivalentes de representar splines cúbicos usando diferentes opciones de funciones base en (7.9) La forma más directa de representar una spline cúbica usando (7.9) es comenzar con una base para un polinomio cúbico, es decir, x, 𝑥2 , 𝑥3 − y luego agrega uno base de potencia truncada función por nudo. Una función de base de potencia truncada se define como H(x, ξ)=(𝑥 − ξ)3 = (𝑥 − ξ)3 if x> ξ 0 otherwise (7.10) dónde ξ es el nudo. Se puede demostrar que agregando un término de la forma 𝛽4 h(x, ξ) al modelo (7.8) para un polinomio cúbico conducirá a una discontinuidad solo en la tercera derivada en ξ; la función permanecerá continua, con primera y segunda derivadas continuas, en cada uno de los nudos. En otras palabras, para ajustar una spline cúbica a un conjunto de datos con K nudos, realizamos regresión de mínimos cuadrados con una intersección y 3+K predictores, de la forma 𝑥1 , 𝑥2 , 𝑥3 , h(X, ξ1 ), h(X, ξ2 ),. . . , h(X, ξ𝑘 ), dónde ξ1 ,. . . , ξ𝑘 son los nudos. Esto equivale a estimar un total de K + 4 coeficientes de regresión; por esta razón, ajustando un spline cúbico con K usos de nudos K+4 grados de libertad. Desafortunadamente, las splines pueden tener una gran variación en el rango externo de los predictores, es decir, cuando X adquiere un valor muy pequeño o muy grande. Como también podemos ver que esta restricción adicional significa que los splines naturales generalmente producen estimaciones más estables en los límites La figura 7.4 muestra un ajuste al Sueldo datos con tres nudos. Vemos que las bandas de confianza en la región límite parecen bastante salvajes. A spline natural es una spline de regresión con adicional restricciones de límite. 7.4.4 Elección del número y ubicación de los nudos Cuando colocamos una spline, ¿dónde debemos colocar los nudos? La spline de regresión es más flexible en regiones que contienen muchos nodos, porque en esas regiones los coeficientes polinomiales pueden cambiar rápidamente. Por lo tanto, una opción es colocar más nudos en lugares donde creemos que la función puede variar más rápidamente y colocar menos nudos donde parece más estable. Si bien esta opción puede funcionar bien, en la práctica es común colocar los nudos de manera uniforme Esto se concretó solicitando cuatro grados de libertad. El argumento por el cual cuatro grados de libertad conducen a tres nudos interiores es algo técnico. ¿Cuántos nudos deberíamos usar o, equivalentemente, cuántos grados de libertad debería contener nuestra spline? Una opción es probar diferentes números de nudos y ver cuál produce la mejor curva. Un enfoque algo más objetivo es usar la validación cruzada. Con este método, eliminamos una parte de los datos (digamos, el 10%), ajustamos una spline con un cierto número de nudos a los datos restantes y luego use la spline para hacer predicciones para la parte retenida. La figura 7.6 muestra errores cuadráticos medios con validación cruzada de diez veces para splines con varios grados de libertad ajustados a la Sueldo datos. El panel de la izquierda corresponde a una spline natural y el panel de la derecha a una spline cúbica. Los dos métodos producen resultados casi idénticos, con una clara evidencia de que un ajuste de un grado (una regresión lineal) no es adecuado. Ambas curvas se aplanan rápidamente y parece que tres grados de libertad para el spline natural y cuatro grados de libertad para el spline cúbico son bastante adecuados. 7.4.5 Comparación con la regresión polinomial Las splines de regresión a menudo dan resultados superiores a la regresión polinomial. Esto se debe a que, a diferencia de los polinomios, que deben usar un alto grado (exponente en el término monomial más alto), para producir ajustes flexibles, las ranuras introducen flexibilidad aumentando el número de nudos pero manteniendo el grado fijo. Generalmente, este enfoque produce estimaciones más estables. Las estrías también nos permiten colocar más nudos y, por lo tanto, flexibilidad, sobre las regiones donde la función F parece estar cambiando rápidamente, y hay menos nudos donde F parece más estable. La figura 7.7 compara una spline cúbica natural con 15 grados de libertad con un polinomio de grado 15 en el Sueldo conjunto de datos. La flexibilidad adicional en el polinomio produce resultados no deseados en los límites, mientras que el spline cúbico natural todavía proporciona un ajuste razonable a los datos. 7.5 Suavizado de Splines Descripción General Al ajustar una curva suave a un conjunto de datos, lo que realmente queremos hacer es encontrar alguna función, digamos g (x), que se ajuste bien a los datos observados. Queremos que 𝑅𝑆𝑆 = n i=1 yi − g x 2 sea pequeño. 𝑔 es suave (suavizado de spline) si minimiza: 𝑛 𝑖=1 𝑦𝑖 − 𝑔 𝑥𝑖 2 + 𝜆∫ 𝑔′′ 𝑡 2 𝑑𝑡 7.11 Descripción General La ecuación 7.11 toma la formulación "Pérdida + Penalización" 𝑛 𝑖=1 𝜆∫ 𝑔′′ 𝑦𝑖 − 𝑔 𝑥𝑖 2 es una función de pérdida 𝑡 2 𝑑𝑡 un término de penalización La primera derivada 𝑔′(𝑡) mide la pendiente de una función en 𝑡, y la segunda derivada corresponde a la cantidad en que cambia la pendiente(rugosidad). 𝜆∫ 𝑔′′ 𝑡 2 𝑑𝑡 anima a 𝑔 a ser suave. λ controla la compensación de sesgo-varianza del spline de suavizado. Descripción General La función 𝑔(𝑋) que minimiza (7.11): Es un polinomio cúbico a trozos con nudos en los valores únicos de 𝑋1, . . . , 𝑋𝑛 y derivadas primera y segunda continuas en cada nudo. Es lineal en la región fuera de los nudos extremos. Es una versión de tal spline cúbico natural, donde el valor del parámetro de ajuste 𝜆 en (7.11) controla el nivel de contracción. Elección del parámetro de suavizado 𝜆 El parámetro de ajuste 𝜆 controla la rugosidad de la ranura de suavizado y, por lo tanto, también los grados efectivos de libertad. Es posible demostrar que como λ aumenta de 0 a ∞ , los grados efectivos de libertad, que escribimos 𝑑𝑓𝜆, disminuir de n a 2. 𝑑𝑓𝜆 es una medida de la flexibilidad de la spline de suavizado: cuanto más alta es, más flexible . La definición de grados de libertad efectivos es algo técnica. Elección del parámetro de suavizado 𝜆 𝑔ො es la solución a (7.11) para una elección particular de 𝜆 𝑔ො es un 𝑛-vector que contiene los valores ajustados de la spline de suavizado en los puntos de entrenamiento 𝑋1, . . . , 𝑋n. que el vector de valores ajustados al aplicar unaLa ecuación 7.12 indicaspline de suavizado a los datos se puede escribir como una matriz 𝑆𝜆 de 𝑛 × 𝑛 Multiplicado por el vector de respuesta. Los grados efectivos de libertad se definen como 𝑑𝑓𝜆 = σ𝑛𝑖=1 𝑆𝜆 𝑖𝑖 (7.13) la suma de los elementos diagonales de la matriz 𝑆𝜆 . Elección del parámetro de suavizado 𝜆 Tenemos que elegir el valor de 𝜆 Una posible solución a este problema sea la validación cruzada. El error de validación cruzada “sin dejar fuera” (LOOCV) se puede calcular de manera muy eficiente para suavizar splines, esencialmente con el mismo costo que calcular un solo encajar, utilizando la siguiente fórmula: 𝑛 −𝑖 𝑦𝑖 − 𝑔ො𝜆 𝑅𝑆𝑆𝑐𝑣 𝜆 = 𝑖=1 2 𝑥𝑖 𝑛 = 𝑖=1 𝑦𝑖 −𝑔ො 𝜆 𝑥𝑖 2 1− 𝑆𝜆 𝑖𝑖 Elección del parámetro de suavizado 𝜆 −𝑖 La notación 𝑔ො𝜆 𝑥𝑖 indica el valor ajustado para este spline de suavizado evaluado en 𝑋𝑖 . A diferencia de,𝑔ො𝜆 𝑥𝑖 indica que la función de suavizado de spline se ajusta a todas las observaciones de entrenamiento que se evalúa en 𝑥𝑖 . Esta notable fórmula dice que podemos calcular cada una de estos ajustes únicos usando solo 𝑔ො𝜆 ,que es el ajuste original a todos de los datos. La figura 7.8 muestra los resultados de ajustar un spline de suavizado al Sueldo datos. La curva roja indica el ajuste obtenido al especificar previamente que nos gustaría un spline suavizado con 16 grados de libertad efectivos (arbitraria). La curva azul es la spline de suavizado obtenida cuando 𝜆 se elige mediante LOOCV (El error de validación cruzada sin dejar fuera); en este caso, el valor de 𝜆 resultados elegidos en 6.8 grados de libertad efectivos (calculados usando (7.13)). Regresión Local 7.6 Regresión Local La Regresión local es un enfoque para ajustar funciones no lineal flexible, ajustando una función lineal en 𝑥0 , Ponderada sólo por observaciones de entrenamiento cercanas. La idea de regresión local se puede generalizar de muchas formas diferentes. En un entorno con múltiples funciones una muy útil general. La generalización implica ajustar un modelo de regresión lineal múltiple que es global en algunas variables, pero local en otras, como el tiempo. Tal coeficiente variable Figura 7.9. Regresión local ilustrada en algunos datos simulados, donde la curva azul representa 𝑓(𝑥) a partir de la cual se generaron los datos, y la curva naranja claro corresponde a la estimación de regresión local 𝑓(𝑥). Los puntos de color naranja son locales al punto de destino 𝑥0 , representado por la línea vertical naranja. La forma de campana amarilla superpuesta en el gráfico indica los pesos asignados a cada punto, disminuyendo a cero con la distancia desde el punto objetivo. El ajuste 𝑓 𝑥0 a 𝑥0 se obtiene ajustando una regresión lineal ponderada(segmento de línea naranja) y utilizando el valor ajustado en X0 (punto sólido naranja) como estimación 𝑓 𝑥0 . Algoritmo 7.1. Regresión local en X= 𝑥0 𝑘 1.- Reúna la fracción 𝑠 = de puntos de entrenamiento cuyo 𝑥𝑖 𝑛 están más cerca de 𝑥0 . 2.- Asignar un peso Ki0 =K(xi, x0) a cada punto de esta vecindad, de modo que el punto más alejado de x0 tiene peso cero y el más cercano obtienen un peso más Alto. 3.- Ajuste un regresión de mínimos cuadrados ponderados de el 𝑦𝑖 sobre el 𝑋𝑖 utilizándolos pesos antes mencionados, encontrando 𝛽0 y 𝛽1 que minimizan 𝑛 𝑖=1 𝑘𝐼0 𝑦𝑖 − 𝐵0 − 𝐵1𝑥𝑖 2 …(7.14) 4. El valor ajustado en 𝑋0 es dado por 𝐹 𝑥0 = 𝛽0 + 𝛽1 𝑥0 Las opciones para la regresión local son: la elección de los pesos (K); si se ajusta una regresión lineal, constante o cuadrática; y la elección del span (s = k/n). El intervalo controla la flexibilidad del spline. Cuanto más pequeño sea el intervalo, más ondulado será el ajuste, cuanto más grande sea el intervalo, más lineal será (el intervalo por defecto). Modelo Aditivos Generalizados 7.7 Modelo Aditivos Generalizados Los modelos aditivos generalizados (GAM) proporcionan un marco general para ampliar un modelo lineal estándar permitiendo funciones no lineales de cada una de las variables mientras se mantiene la aditividad. Los modelos aditivos generalizados (GAM) proporcionan un marco general para extender un modelo lineal estándar al permitir funciones no lineales de cada una de las variables, mientras se mantiene la aditividad. Al igual que los modelos lineales, los GAM se pueden aplicar con una respuesta cuantitativa en la Sección 7.7.1 y luego con una respuesta cualitativa en la Sección 7.7.2. Figura 7.10. Ajustes lineales locales al Sueldo datos. El intervalo especifica la fracción de los datos utilizados para calcular el ajuste en cada punto de destino. 7.7.1 GAM para problemas de regresión Una forma natural de extender el modelo de regresión lineal múltiple 𝑦𝑖 = 𝛽0 + 𝛽1 𝑥𝑖1 + 𝛽2 𝑥𝑖2 + ⋯ + 𝛽𝑃 𝑥𝑖𝑃 + 𝜀𝑖 Para permitir relaciones no lineales entre cada característica y la respuesta es reemplazar cada componente lineal 𝛽𝑗 𝑥𝑖𝑗 con una función no lineal (suave) 𝑓𝑗 𝑥𝑖𝑗 . Luego escribiríamos el modelo como: 𝑝 .𝑦𝑖 = 𝛽0 + 𝑗=1 𝑓𝑗 𝑥𝑖𝑗 + 𝜀𝑖 𝑦𝑖 = 𝛽0 + 𝑓1 𝑥𝑖1 + 𝑓2 𝑥𝑖2 + ⋯ + 𝑓𝑃 𝑥𝑖𝑃 + 𝜀𝑖 … (𝟕. 𝟏𝟓) Este es un ejemplo de GAM. Se llama modelo aditivo porque calcula un 𝑓𝑗 separado para cada 𝑥 , y luego suma todas sus contribuciones. En las secciones 7.1–7.6, discutimos muchos métodos para ajustar funciones a una sola variable. La belleza de los GAM es que podemos usar estos métodos como bloques de construcción para ajustar un modelo aditivo. De hecho, para la mayoría de los métodos que hemos visto hasta ahora en este capítulo, esto se puede hacer de manera bastante trivial. Tome, por ejemplo, splines naturales y considere la tarea de ajustar el modelo sueldo = 𝛽0 + 𝑓1 (año) + 𝑓2 (la edad) + 𝑓3 (educación) + ε …(7,16) Figura 7.12. Los detalles son como en la anterior figura 7.11, pero ahora 𝑓1 y 𝑓2 se suavizan splines con cuatro y cinco grados de libertad, respectivamente. Actualializamos repetidamente el ajuste para cada predictor a su vez, manteniendo los demás fijos. La belleza de este enfoque es que cada vez que actualizamos una función, simplemente aplicamos el método de ajuste para esa variable a un residual parcial. Las funciones ajustadas en las Figuras 7.11 y 7.12 son bastante similares. En la mayoría de las situaciones, las diferencias en los GAM obtenidos mediante suavizado de splines frente a splines naturales son pequeñas. No tenemos que usar splines como bloques de construcción para GAM: también podemos usar regresión local, regresión polinomial o cualquier combinación de los enfoques vistos anteriormente en este capítulo para crear un GAM. Pros y contras de los GAM Ventajas: Los GAM permiten ajustar una función no lineal (𝑓𝑗 ) a cada variable (𝑥𝑗 ), por lo que podemos modelar automáticamente las relaciones no lineales que la regresión lineal estándar pasaría por alto. Los ajustes no lineales pueden potencialmente hacer predicciones más precisas para la respuesta (Y) La suavidad de la función (𝑓𝑗 ) para (𝑥𝑗 ) se puede resumir a través de los grados de libertad. Limitación: • La principal limitación de los GAM es que el modelo está restringido a ser aditivo. Pueden perderse interacciones importantes. Pero podemos añadir manualmente términos de interacción como hicimos con la regresión lineal. 7.7.2 GAM para problemas de clasificación Los GAM también se pueden utilizar en situaciones en las que Y es cualitativo. Para simplificar, aquí asumimos que Y toma valores cero o uno, y sea p (X) = 𝑃𝑟 (Y = 1 | X) la probabilidad condicional (dados los predictores) de que la respuesta sea igual a uno. Recuerde el modelo de regresión logística (4.6): log 𝑝 𝑥 1−𝑝 𝑥 = 𝛽0 + 𝛽1 𝑥1 + 𝛽2 𝑥2 + ⋯ + 𝛽𝑝 𝑥𝑝 … (7.17) Esta logit es el registro de las probabilidades de P(Y = 1| X) versus P(Y = 0| X), que (7.17) representa como una función lineal de los predictores. Una forma natural de extender (7.17) para permitir relaciones no lineales es usar el modelo log 𝑝 𝑥 1−𝑝 𝑥 = 𝛽0 + 𝑓𝑥1 + 𝑓2 𝑥2 + ⋯ + 𝑓𝑝 𝑥𝑝 … (7.18) La ecuación 7.18 es una GAM de regresión logística. Tiene todos los mismos pros y contras que se discutieron en la sección anterior para las respuestas cuantitativas. Encajamos un GAM al Sueldo datos para predecir la probabilidad de que el ingreso de un individuo exceda los $ 250,000 por año. El GAM que encajamos toma la forma: log 𝑝𝑋 1−𝑝 𝑋 = 𝛽0 + 𝛽1 × Año + 𝑓2 (ⅇdad) + 𝑓3 (𝐞𝐝𝐮𝐜𝐚𝐜𝐢ó𝐧) Dónde p(X) = Pr (sueldo > 250|año, la edad, educación). …(7.19) Figura 7.13. Para el Sueldo datos, la regresión logística GAM dada en (7.19) se ajusta a la respuesta binaria (salario> 250). Cada gráfico muestra la función ajustada y los errores estándar puntuales. La primera función es lineal en año, la segunda función es una spline de suavizado con cinco grados de libertad en la edad, y la tercera una función de paso para educación. Hay errores estándar muy amplios para el primer nivel.<HS de educación. Una vez más, 𝑓2 se ajusta Utilizando un spline de suavizado con cinco grados de libertad, y 𝑓3 se ajusta como una función escalonada, creando variables ficticias para cada uno de los niveles de educación. El ajuste resultante se muestra en la Figura 7.13. El último panel parece sospechoso, con intervalos de confianza muy amplios para el nivel <HS. De hecho, no hay ninguno para esa categoría: ninguna persona con menos de una educación secundaria gana más de $250.000 por año. Por lo tanto, ajustamos el GAM, excluyendo a las personas con menos de una educación secundaria. El modelo resultante se muestra en la Figura 7.14. Como en las figuras 7.11 y 7.12, Los tres paneles tienen la misma escala vertical. Esto nos permite evaluar visualmente las contribuciones relativas de cada una de las variables.