Tasa de Fallo y Variables Aleatorias sin Memoria

Anuncio

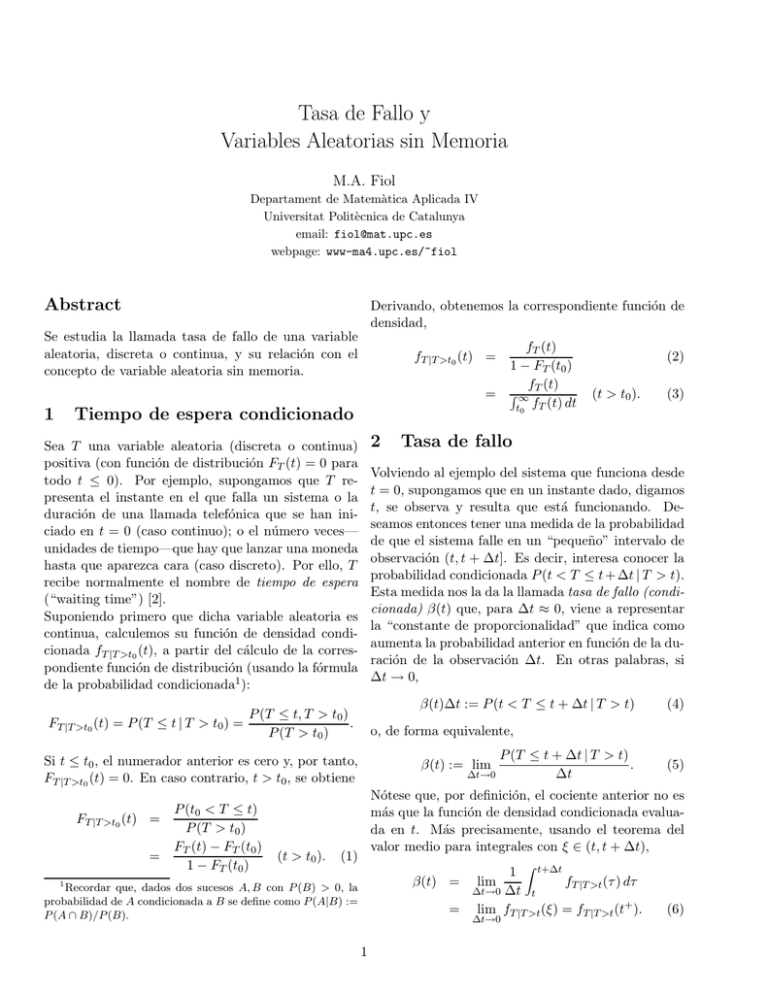

Tasa de Fallo y Variables Aleatorias sin Memoria M.A. Fiol Departament de Matemàtica Aplicada IV Universitat Politècnica de Catalunya email: fiol@mat.upc.es webpage: www-ma4.upc.es/~fiol Abstract Derivando, obtenemos la correspondiente función de densidad, Se estudia la llamada tasa de fallo de una variable aleatoria, discreta o continua, y su relación con el concepto de variable aleatoria sin memoria. fT |T >t0 (t) = = 1 Tiempo de espera condicionado 2 Sea T una variable aleatoria (discreta o continua) positiva (con función de distribución FT (t) = 0 para todo t ≤ 0). Por ejemplo, supongamos que T representa el instante en el que falla un sistema o la duración de una llamada telefónica que se han iniciado en t = 0 (caso continuo); o el número veces— unidades de tiempo—que hay que lanzar una moneda hasta que aparezca cara (caso discreto). Por ello, T recibe normalmente el nombre de tiempo de espera (“waiting time”) [2]. Suponiendo primero que dicha variable aleatoria es continua, calculemos su función de densidad condicionada fT |T >t0 (t), a partir del cálculo de la correspondiente función de distribución (usando la fórmula de la probabilidad condicionada1 ): = (t > t0 ). (t > t0 ). (3) Tasa de fallo β(t)∆t := P (t < T ≤ t + ∆t | T > t) (4) o, de forma equivalente, P (T ≤ t + ∆t | T > t) . ∆t→0 ∆t Si t ≤ t0 , el numerador anterior es cero y, por tanto, FT |T >t0 (t) = 0. En caso contrario, t > t0 , se obtiene FT |T >t0 (t) = (2) Volviendo al ejemplo del sistema que funciona desde t = 0, supongamos que en un instante dado, digamos t, se observa y resulta que está funcionando. Deseamos entonces tener una medida de la probabilidad de que el sistema falle en un “pequeño” intervalo de observación (t, t + ∆t]. Es decir, interesa conocer la probabilidad condicionada P (t < T ≤ t + ∆t | T > t). Esta medida nos la da la llamada tasa de fallo (condicionada) β(t) que, para ∆t ≈ 0, viene a representar la “constante de proporcionalidad” que indica como aumenta la probabilidad anterior en función de la duración de la observación ∆t. En otras palabras, si ∆t → 0, P (T ≤ t, T > t0 ) . FT |T >t0 (t) = P (T ≤ t | T > t0 ) = P (T > t0 ) P (t0 < T ≤ t) P (T > t0 ) FT (t) − FT (t0 ) 1 − FT (t0 ) fT (t) 1 − FT (t0 ) f (t) ∞ T t0 fT (t) dt β(t) := lim (5) Nótese que, por definición, el cociente anterior no es más que la función de densidad condicionada evaluada en t. Más precisamente, usando el teorema del valor medio para integrales con ξ ∈ (t, t + ∆t), (1) t+∆t 1 fT |T >t (τ ) dτ ∆t→0 ∆t t = lim fT |T >t (ξ) = fT |T >t (t+ ). β(t) = 1 Recordar que, dados dos sucesos A, B con P (B) > 0, la probabilidad de A condicionada a B se define como P (A|B) := P (A ∩ B)/P (B). lim ∆t→0 1 (6) parámetro λ. Recı́procamente, si T es exponencial con parámetro λ, (8) permite inferir que la tasa de fallo es constante β(t) = λ. Además, para dicha variable aleatoria, (1) y (3) permiten calcular sus funciones de distribución y de densidad condicionadas que resultan ser: Sin embargo, hay que hacer notar que, aunque β(t) represente una “probabilidad por unidad de la variable”, no se trata de una función de probabilidad, como se verá a continuación. Para deducir como están relacionadas β(t) y la función fT (t) (sin condicionar), podemos desarrollar (5) o, a la vista de (6), usar directamente (2) y (3): β(t) = = FT (t) 1 − FT (t) f (t) ∞ T . t fT (τ ) dτ e−λt0 − e−λt e−λt0 = 1 − e−λ(t−t0 ) FT |T >t0 (t) = (7) (8) fT |T >t0 (t) = λe Integrando ambos miembros de (7) entre 0 y t, obte- Es decir, nemos t 0 de donde β(τ ) dτ = − ln[1 − FT (t)], 1 − FT (t) = e− t 0 (9) β(τ ) dτ t 0 β(τ ) dτ fT (t) = FT (t) = β(t)e− , t 0 (10) β(τ ) dτ . (11) A partir de la igualdad (9), notar que, cuando t → ∞, FT (∞) = 1 y, por tanto, ∞ 0 (t > t0 ), (t > t0 ). FT |T >t0 (t) = FT (t − t0 ), (14) fT |T >t0 (t) = fT (t − t0 ). (15) Por tanto, la funciones de distribución y densidad condicionadas resultar ser las correspondientes funciones originales desplazadas un valor t0 . Por ello, se dice que la variable aleatoria exponencial no tiene memoria. (La misma conclusión puede inferirse a partir del hecho de que la probabilidad P (t < T ≤ t + dt|T > t)—o, equivalentemente, la tasa de fallo β(t)—no depende de t). Recı́procamente, se demuestra que si una variable aleatoria T continua no negativa tiene una función de distribución que cumple (14) para todo t0 ≥ 0, entonces T es exponencial. En efecto, a partir de (6) y (15) deducimos que, para todo t = t0 > 0, la tasa de fallo de T es constante: y, por tanto, las funciones de distribución y de densidad de T para t > 0 son, respectivamente, FT (t) = 1 − e− −λ(t−t0 ) β(τ ) dτ → ∞, lo que indica que β(t) no es una función de densidad, como comentábamos anteriormente. Recı́procamente, a partir de una función β(t) no neβ(t) = fT |T >t (t) = fT (0+ ), gativa cuya integral cumpla lo anterior, podemos considerar la variable aleatoria T con funciones de distribución y de densidad dadas por en (10) y (11), y, por tanto, T es exponencial de parámetro λ := fT (0+ ). respectivamente [1]. Como resumen de esta sección, hemos demostrado el siguiente resultado: 3 Variable aleatoria exponencial Proposicion 3.1 Sea T una variable aleatoria conUn caso especialmente interesante es cuando la tasa tinua y positiva. Entences las siguientes afirmaciones de fallo es constante, digamos β(t) = λ; valor que son equivalentes: debe ser obviamente positivo λ > 0. En este caso, (10) y (11) dan (a) T tiene tasa de fallo constante β(t) = λ. −λt (t > 0), (12) FT (t) = 1 − e −λt (t > 0). (13) (b) T es exponencial de parámetro λ. f (t) = λe T (c) T no tiene memoria: fT |T >τ (t) = fT (t − τ ) para todo τ ≥ 0. que corresponden a las funciones de distribución y de densidad de una variable aleatoria exponencial de 2 4 Variable aleatoria geométrica Desarrollemos ahora el punto (c): De manera análoga al caso continuo (Sección 3), Conceptos y resultados similares a los anteriores se pueden obtener para una variable aleatoria disPT |T >k0 (k) = P (T ≤ k | T ≥ k0 ) creta positiva, que sólo toma valores en los múltiplos P (T ≤ k, T ≥ k0 ) = de una unidad de tiempo; por ejemplo, para t = P (T ≥ k0 ) 1, 2, 3, . . .. Nos limitaremos aquı́ al caso más interesante de “ausencia de memoria”. Ası́, inspirándonos donde, si k < k0 , el numerador anterior es cero y en los resultados de la proposición anterior, sea T PT |T ≥k0 (k) = 0, mientras que, si k ≥ k0 , obtenemos una variable aleatoria discreta, con función de proq k−1 P (T = k) babilidad PT (k) no nula en k = 1, 2, 3, . . . y “tasa de = ∞ PT |T ≥k0 (k) = fallo” constante. Es decir, para una cierta constante P (T ≥ k0 ) p κ=k0 q κ−1 λ ∈ (0, 1), se cumple: q k−1 = q k−k0 p = k0 −1 )/(1 − q) (q (a) P (T = k|X > k − 1) = P (T = k|T ≥ k) = λ. = PT (k − k0 ). Nos interesa entonces hallar (b) El valor de PT (1) y la función de probabilidad Por tanto, al igual que con la exponencial, decimos que la variable aleatoria geométrica no tiene memoPT (k) para k ≥ 1. ria. (c) La función de probabilidad condicionada PT |T >k0 (k) en función de PT (k). 5 De la distribución geométrica a Con respecto al punto (b), tenemos primero que, para la exponencial y viceversa k = 1, la condición (a) da PT (1) = P (T = 1|T ≥ 1) = λ. Por otra parte, para k > 1, La variable aleatoria exponencial puede razonarse a partir de una variable aleatoria geométrica mediante P (T = k) λ = P (T = k|T ≥ k) = el siguiente proceso al lı́mite. Sea T una variable P (T ≥ k) aleatoria geométrica con p := λ∆t, donde λ es una P (T = k) cierta constante positiva y ∆t representa una canti= 1 − P (T ≤ k − 1) dad muy pequea, ∆t → 0. Supongamos también que T toma valores en k∆t, k = 1, 2, 3, . . . con probabide donde se obtiene la ecuación de recurrencia lidad PT (k) = λ 1 − k−1 PT (κ) PT (k∆t) = pq k−1 = λ∆t(1 − λ∆t)k κ=0 (k ≥ 1). que, considerada para los valores k y k − 1, conduce Para obtener valores no triviales, debemos suponer también que k → ∞ de manera que k∆t tiende a a la igualdad una cantidad finita, digamos t. Entonces, PT (k) + λ k−1 PT (κ) = λ = PT (k − 1) + λ κ=0 k−2 PT (κ), λt 1 PT (k∆t) → fT (t) := λ lim 1 − k→∞ ∆t k −λt = λe κ=0 Simplificando y aplicando primera igualdad obtenida, recurrentemente la que corresponde a la función de densidad de una variable aleatoria exponencial. Siguiendo el camino inverso, podemos obtener una variable aleatoria geométrica X a partir de una exponencial T de parámetro λ, considerando la función de probabilidad PT (k) = (1 − λ)PT (k − 1) = (1 − λ)2 PT (k − 2) = · · · = (1 − λ)k−1 PT (1) = (1 − λ)k−1 λ k (k > 0). Por tanto, T es una variable aleatoria geométrica con parámetros p := λ y q := 1 − λ. PX (k) := P (k − 1 < T ≤ k), 3 k = 1, 2, . . . cuyo cálculo, usando (12), da Inspirándonos en el caso continuo, “sumamos por partes”2 con PX (k) = FT (k) − FT (k − 1) ∆u = k n − (k − 1)n n n = − ν=1 ν (−1)ν k n−ν , u = kn, = e−λ(k−1) − e−λk = e−λ(k−1) (1 − e−λ ). ∆v(k) = q k−1 p k = −q + q k−1 , Por tanto, tal como preveı́amos, X es una variable aleatoria geométrica con p := 1 − e−λ y q := e−λ . v(k) = −q k ; se obtiene la recurrencia 6 Momentos S(n) = Por definición, el momento mn;X de orden n ≥ 1 de una variable aleatoria exponencial X se calcula mediante la integral ∞ n I(n) := E(X ) = n x λe 0 −λx dx. Integrando por partes con du = nxn−1 v = −e−λx ∞ −xn e−λx = n I(n − 1) λ 0 ∞ n (−1) ∞ n ν ν=1 = k n−ν q k−1 k=0 1 p +n 0 xn−1 e−λx dx S(3) = (n ≥ 1). Por tanto, la media, varianza y desviación tı́pica de X son ahora: m1;X n! = I(n) = n . λ = E(X) = 1 , λ 2 σX = m2;X − m21;X = σX = 1 . λ σX 1 = E(X) = , p q = m2;X − m21;X = 2 , p √ q . = p 2 2 σX En el caso discreto la suma por partes se basa en la siguiente igualdad (similar a la fórmula de la derivada de un producto) 1 , λ2 ∆uv(k) := u(k)v(k) − u(k − 1)v(k − 1) = u(k)v(k) − u(k)v(k − 1) + u(k)v(k − 1) − u(k − 1)v(k − 1) En el caso discreto, con X una variable aleatoria = u(k)∆v(k) + v(k − 1)∆u(k) geométrica con parámetros p, q, se obtienen resultados análogos. Ası́, siguiendo la analogı́a con el caso de donde, cuando sumamos entre los valores k = a y k = b, se continuo, podemos hallar primero una fórmula de re- obtiene b b currencia para la suma (momento mn de orden n) b S(n) := E(X n ) = ∞ u(k)∆v(k) = [u(k)v(k)]a−1 − a k n pq k−1 k=1 4 n n S(n − 1) − S(n − 2) + · · · ± 1 . 1 2 1 , p 1 2 q+1 1 [2S(2) − 1] = −1 = , p p p p2 q 2 + 4q + 1 1 [3S(2) − 3S(1) + 1] = · · · = . p p3 En particular, la media, varianza y desviación tı́pica de X resultan ser: m1;X − ν = S(2) = Por tanto, como I(0) = 1, resulta que mn;X 0 n 1 n (−1)ν+1 S(n − ν) p ν=1 ν S(1) = se obtiene la recurrencia ∞ Por ejemplo, a partir de S(0) = 1, obtenemos u = xn , dv = λe−λx dx, I(n) = −k q n k v(k − 1)∆u(k). a Alternativamente, podemos llegar también al mismo resultado mediante un simple desarrollo de la suma inicial: ∞ S(n) = (k + 1 − 1)n pq k−1 k=0 ∞ = k=0 n = pq k−1 n ν=0 (−1)ν ∞ n ν ν=0 n n 1 = q (k + 1)n−ν pq k−1 k=0 ∞ n 1 (−1)ν q ν=0 ν = n (−1)ν (k + 1)n−ν ν (−1)ν ν=0 (k + 1)n−ν pq k k=0 n S(n − ν) ν de donde S(n) 1 − 1 q = S(n) = −p q n n 1 (−1)ν S(n − ν) q ν=1 ν que conduce a la misma recurrencia obtenida en (16). Esto sugiere que, en el caso continuo, una manipulación similar debe conducir a la recurrencia (16). En efecto, se puede comprueba que ∞ I(n) = lim →0 0 = ··· = (x + − )n λe−λx dx n I(n − 1). λ References [1] A. Papoulis, Probability, Random Variables and Stochastic Processes (2nd edition), McGrawHill, New York, 1984. [2] G.R. Grimmet and D.R. Stirzaker, Probability and Random Processes, Oxford Univ. Press, New York, 1982. 5