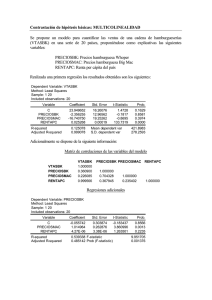

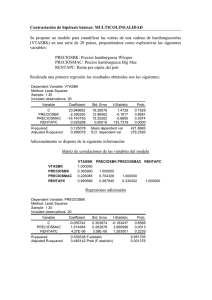

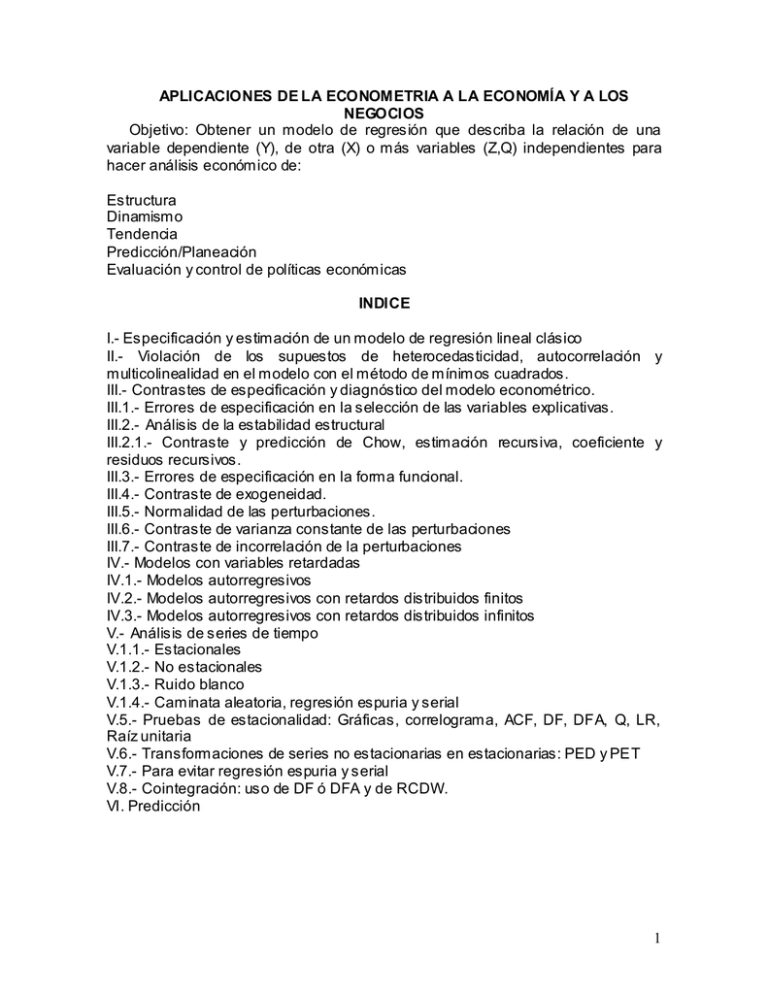

1 APLICACIONES DE LA ECONOMETRIA A LA ECONOMÍA Y A

Anuncio