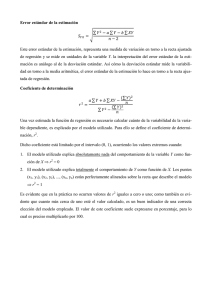

[TEMA 8] Análisis de Regresión Lineal Simple y Múltiple

Anuncio

![[TEMA 8] Análisis de Regresión Lineal Simple y Múltiple](http://s2.studylib.es/store/data/007495966_1-f0347b24d6f6f71d85170b6965462453-768x994.png)