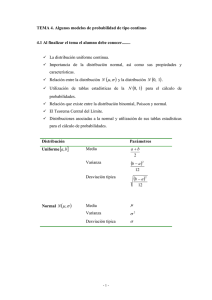

Fórmulas de Distribuciones de Probabilidad Discretas y Continuas

Anuncio

Distribución discreta uniforme

Teorema: Si X es una variable aleatoria con distribución

discreta uniforme, entonces:

∑ki=1 xi

𝜇x = 𝐸(𝑥) =

k

𝑘

2

∑

(𝑥

𝑖− 𝜇𝑥 )

𝑖=1

𝜎𝑥2 = 𝑉𝑎𝑟(𝑥) =

𝑘

V.A. asume cada uno de sus valores con la misma

probabilidad.

𝛿x (x: k) la V.A. es x, mientras que k es un parámetro del

cual depende la distribución, o simplemente 𝛿x (x)

Ensayo de Bernoulli

Teorema: Si X es una variable aleatoria con distribución

de Bernoulli, entonces:

p, x = 1 (Exito)

f(x) = {q, x = 0 (fracaso)

0,

en otro caso

Proceso de Bernoulli

1) El experimento sólo puede tener

dos posibles resultados, ambos

mutuamente excluyentes

(éxito/fracaso).

2) Las pruebas en las que se

obtienen los sucesos anteriores

(éxito/fracaso) son independientes.

3) Las probabilidades de éxito

fracaso son constantes

Distribución Binomial

Distribución de Pascal o Binomial Negativa

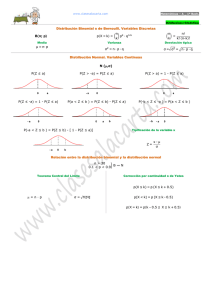

Distribución Normal

𝑃(𝑋 = 𝑛) = NCn 𝑝𝑛 𝑞 𝑁−𝑛

𝑆 𝑛

𝑆 𝑁−𝑛

= NCn (𝜆 − ) (𝜆 − )

𝑁

𝑁

n

( ) px (1 − p)n−x , x = 0,1,2, . . . , h

fx (x, n, p) = { x

0,

En otro caso

𝜇x = n𝑝

𝜎x2 = npq

f(x) = px (1 − p)1−x

𝜇 = 𝐸(𝑥) = 𝑝

𝜎x2 = Var(x) = p1

n−1 k

P(x = k) = (

) p (1 − p)n−k

k−1

Para n=k, k+1, k+2

𝑓𝑋(𝑥) =

x representa el número de ensayos requeridos para obtener k

ocurrencias de éxito.

Teorema: Si X es una variable aleatoria con distribución

de Pascal con parámetros r y p, entonces:

𝜇x =

r

p

𝜎x2 =

rq

p2

1

√2𝜋 𝜎

℮

(𝑥−𝜇)2

−

2𝜎2

−∞ < 𝑥 < ∞ para toda x

Donde μ y σ son constantes tales

que, -<μ<, entonces X tiene una

distribución normal con parámetros,

media μ y varianza σ, lo cual se

denota por:

𝑋~𝑁(𝜇, 𝜎2)

Distribución Hipergeométrica

𝑓𝑋(𝑥)

(𝑥𝑟 )(𝑁−𝑟

)

𝑛−𝑥

; 𝑥 = 0,1,2, . . . , 𝑛 𝑐𝑜𝑛 𝑥 ≤ 𝑟, 𝑛 − 𝑥 ≤ 𝑁 − 𝑟

𝑁

= { ( )

𝑛

0,

𝑒𝑛 𝑜𝑡𝑟𝑜 𝑐𝑎𝑠𝑜

Teorema: Si X es una variable aleatoria con distribución

hipergeométrica con parámetros N,n y r, entonces:

r

𝜇x = 𝐸(𝑥) = 𝑛 ( )

n

𝐸(𝑋) = 𝑛𝑝

Distribución de Poisson

𝑆 𝑛

𝑆 𝑁−𝑛

𝑃(𝑋 = 𝑛) = NCn 𝑝𝑛 𝑞 𝑁−𝑛 = NCn (𝜆 − ) (𝜆 − )

𝑁 𝑛

𝑁

𝜆

Considerando que N→

𝑃(𝑥 = 𝑛) = ℮−𝜆 ;

𝑛!

𝑛 = 0,1,2,3, …

𝜆𝑥

𝑃(𝑥) ℮−𝜆 ; 𝑥 = 0,1,2,3, …

𝑥!

ocurrencias

𝜆 = np =

= promedio de resultados

tiempo

𝜇𝑋 = 𝐸(𝑋) = 𝜆

𝜎𝑋2 = 𝑉𝑎𝑟(𝑋) = 𝜆

Si S=1

Distribución Geométrica

qx−1 p, x = 1,2,3, . . . , n

fx (x) = {

0,

en otro cado

Teorema: Si X es una variable

aleatoria con distribución

geométrica con parámetros en p,

entonces:

P(x = n) = (1 − p)n−1 p = qn−1 p

1

p

(1

−

p)

𝜎x2 =

p2

𝜇x = E(x) =

𝑟

𝑟 𝑁−𝑛

𝜎𝑋2 = 𝑉𝑎𝑟(𝑥) = 𝑛 ( ) (1 − ) (

)

𝑁

𝑁 𝑁−1

𝑁−𝑛

𝑉𝑎𝑟(𝑋) = 𝑛𝑝𝑞 (

)

𝑁−1

Distribucion Exponencial

𝜆℮−𝜆𝑡 ;

𝑡>0

𝑓T (𝑡) = {

0;

𝑜𝑡𝑟𝑜 𝑐𝑎𝑠𝑜

Se denota 𝑇~𝐸𝑥𝑝𝑜𝑛𝑒𝑛𝑐𝑖𝑎𝑙 (𝜆) 𝑜 𝑇~𝑒𝑥𝑝 ()

Teorema: Sea T una variable aleatoria con distribución

exponencial y parámetro λ, entonces:

1

1

𝜇𝑇 = 𝐸(𝑇) =

𝜎𝑇2 = 𝑉𝑎𝑟(𝑇) = 2

𝜆

𝜆

Distribución Continua-Uniforme

Distribución Normal Estandar

1

𝑓𝑋(𝑥) = {𝑏 − 𝑎 ; 𝑎 ≤ 𝑥 ≤ 𝑏

0; 𝑜𝑡𝑟𝑜 𝑐𝑎𝑠𝑜

𝑥 − 𝜇𝑥

Donde 𝑋~𝑁(𝜇𝑋, 𝜎𝑋2 )

𝜎𝑥

Para calcular la probabilidad de que

la variable aleatoria x tome un valor

dentro del intervalo [x1, x2] se debe

evaluar la siguiente integral

definida:

𝑃(𝑥1 ≤ 𝑋 ≤ 𝑥2)

entonces X tiene una distribución continua uniforme

con parámetros a y b.

Se denota como 𝑋~ 𝑈𝑛𝑖𝑓𝑜𝑟𝑚𝑒 (𝑎, 𝑏)

(𝑏 − 𝑎)2

𝑎+𝑏

𝜇x =

𝜎𝑋2 =

2

12

𝑧=

𝑥2

= ∫

𝑥1

1

√2𝜋 𝜎

℮

(𝑋−𝜇)2

−

2𝜎 2

𝑑𝑥,

Aproximación normal de las probabilidades

Binomiales

Teorema: Si X es una V.A. de distribución binomial

con parámetros µx = np y σx2 = npq, entonces la

forma límite de la distribución es:

𝑋 − 𝑛𝑝

𝑍=

√𝑛𝑝𝑞

𝑐𝑢𝑎𝑛𝑑𝑜 𝒏 → ∞, 𝑒𝑠 𝑙𝑎 𝑑𝑖𝑠𝑡𝑟𝑖𝑏𝑢𝑐𝑖𝑜𝑛 𝑛𝑜𝑟𝑚𝑎𝑙 𝑒𝑠𝑡𝑎𝑛𝑑𝑎𝑟

𝒁 ≈ 𝑵(𝟎, 𝟏).

En general, la aproximación es adecuada cuando

se cumple:

n > 10

np > 5

nq > 5

Definición: Si una variable aleatoria X con

distribución binomial se desea calcular la

probabilidad de que este entre x1 y x2, el ajuste

por continuidad está dado por:

𝑃(𝑥1 ≤ 𝑋 ≤ 𝑥2) =

(𝑥1 − 𝑑) − 𝜇

(𝑥2 + 𝑑) − 𝜇

𝑃(

≤𝑍≤

)

𝜎

𝜎